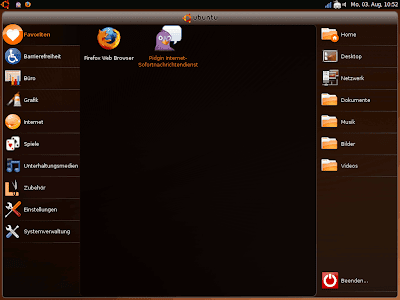

Auf dem Laptop, mit dessen Tastatur gerade dieser Satz geschrieben wird, passte keine meiner üblicherweise gewählten Oberflächen so richtig gut. Also wurde der eigentlich für Netbooks gedachte Ubuntu Netbook Remix (UNR) installiert.

IceWM ist zwar komplett mit Tastatur steuerbar, davon abgesehen aber nicht wirklich auf Laptops mit ihren etwas wackeligeren Touchpads (statt der treffgenauen Maus) angepasst. Es sollte schon eher was mit durchgängiger GUI sein, ohne Terminalnutzung, aber besser doch kein GNOME, da auch diese Desktopumgebung mir nicht gut zu passen schien. Wie ist diese andere Oberfläche überhaupt für Laptops angepasst?

Anpassungen

Einige der Änderungen sind einfache Anpassungen an die Gegebenheiten von Netbooks.

Große Menüs

Passend für Laptops sind die großen Menüs, also das Vollbildmenü mit großen Icons. Je größer das Ziel desto einfacher ist es zu treffen, daher vereinfachen die großen Icons den Start der Programme. Ebenfalls bei Laptops nützlich: Ein Klick reicht aus und startet das Programm sofort, der Doppelklick entfällt.

Ein Panel

Das Panel am oberen Rand beinhaltet den Großteil der übrigen Anpassungen.

Statt der zusätzlichen Leiste unten für laufende Programme beinhaltet das Panel oben links kleine Icons der laufenden Programme. Rechts laufen kleine Helferprogramme, Netzwerkmanager und Uhr, wie man es gewohnt ist.

Maximiert

Programme starten grundsätzlich maximiert, Pidgin ist hier eine Ausnahme. Es entfällt so etwas die Fensterverwaltung, also das Platzieren von Fenstern nebeneinander.

Brüche

Andere Eigenschaften des UNR brechen doch deutlich mit den sonst üblichen Standards von Linux-Desktopoberflächen.

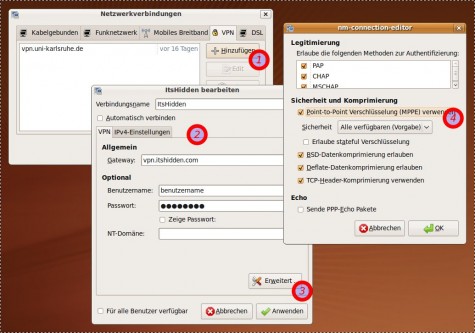

Integrierte Titelleiste

Die Titelleiste des Programms wird in das Panel integriert. Das kann man oben schon erkennen, aber deutlicher wird es auf diesem Bild:

Das erinnert an Apples Mac OS, nicht aber an GNOME. Es spart sicher Platz ein, führt aber wie das Maximierungsverhalten dazu, dass wie bei einem Smartphone zwischen den Anwendungen hin- und hergewechselt wird.

Keine Virtuellen Desktops

Dieses Wechseln wäre alternativ auch durch die gezielte Verwendung von virtuellen Desktops möglich gewesen. Während im normalen Ubuntu immerhin noch zwei solcher Arbeitsflächen bereitstehen, findet sich beim UNR genau eine, also keine. Das Konzept wird schlichtweg nicht genutzt.

Fazit

Der UNR bewegt sich auf dem schmalen Grad zwischen Platzersparnis und einfacher Benutzung mit Touchpad/Touchscreen durch größere und einfachere Bedienelemente. Der Konflikt wird bei der Fensterverwaltung deutlich: Da zwischen den maximierten Fenstern immer gewechselt wird wäre ein einfaches Fensterwechseln praktisch, mit der Maus ist dies aber durch die kleinen Icons nicht unbedingt einfach - hier "muss" auf die Tastatur zurückgegriffen werden. Der Verzicht auf virtuelle Desktops schadet sicher nicht der Anpassungsfähigkeit von Windowsnutzern, macht aber das ernsthafte Arbeiten mit dieser Oberfläche, z.B. zum Programmieren, nicht gerade einfacher. Dafür ist sie aber scheinbar auch nicht gedacht, sowenig wie Netbooks dafür nunmal geeignet sind. Für Laptops jedoch könnte man sich ein wenig von der Platzersparnis wegbewegen, und sei es durch größere Icons im Panel.

Falls jemand den Remix getestet hat: Blieb er der Standarddesktop, obwohl mehr gemacht wurde als zu surfen?

Heute findet der 10.

Heute findet der 10.