10. Dezember 2009

9. Dezember 2009

Google Wave in Thunderbird 3 einbinden ¶

Mozilla hat endlich die Version 3 des Thunderbird Mailclients freigegeben, mit im neuen Funktionsumfang sind die Content-Tabs, über diese kann man Google Wave in Thunderbird 3 einbinden.

Google Wave möchte gerne die Zukunft der elektronischen Kommunikation darstellen, was liegt da näher als Wave Seite an Seite mit der klassischen E-Mail Kommunikation zu nutzen.

Die Einbindung von Wave in Thunderbird ist sehr einfach und schnell gemacht. Hierzu öffnet man die Error Console und fügt den folgenden Aufruf ungekürzt in der Code Zeile ein.

Components.classes['@mozilla.org/appshell/window-mediator;1'].getService(Components.interfaces.nsIWindowMediator).getMostRecentWindow("mail:3pane").document.getElementById("tabmail").openTab("contentTab", {contentPage: "https://wave.google.com/wave/?nouacheck"});

Zwar erkennt Google Thunderbird nicht als validierten User Agent an, die Abfrage wird daher mit dem “nouacheck” umgangen, Wave öffnet sich damit aber reibungslos als Content Tab. Nach Beenden und Neustart von Thunderbird werden die Content Tabs natürlich wieder geöffnet und man hat Zugriff auf seine E-Mails und Waves.

Das Hercules EC-800 und Xubuntu ¶

Seit ein paar Tagen bin ich jetzt schon stolzer Besitzer des Hercules EC-800 mit einem 500 MHz schnellen Prozessor von AMD und 512 MB Ram. Als Betriebssystem habe ich Xubuntu 9.10 installiert. Warum Xubuntu? Weil ich an der Installation anderer Linux-Betriebssysteme einfach gescheitert bin. Das vorinstallierte Mandriva wollte ich nicht. Ursprünglich hatte ich vor, Sidux zu installieren. Aber es gelang mir einfach nicht, ein bootfähiges Image auf einen USB-Stick zu ziehen, weder mit dem Tool der Sidux Live-CD noch mit anderen Anleitungen. Dann wollte ich Debian Squeeze installieren. Das Booten vom Stick hat auch geklappt, aber bei der Installation war auf dem Bildschirm nichts zu erkennen. Das Bild war ineinander verschoben und einfach nur auf Enter zu drücken, hat auch nicht zum Erfolg geführt.

1. Installtion vom USB-Stick

Xubuntu stellte mich allerdings auch vor ein Problem: Da ich die Festplatte komplett verschlüsseln will, brauche ich die Alternate- und nicht die Live-Version der Installations-CD auf dem USB-Stick. Der USB-Startmedien-Ersteller, auch USB-Creator genannt, kann wohl nur Live-Distributionen auf den USB-Stick kopieren. Zumindest bin ich auch bei der Benutzung dieses Tools gescheitert. Eine bootfähige Live-CD zu kopieren, war kein Problem, eine bootfähige Alternate-CD aber schon. Deshalb habe ich den Stick im Terminal vorbereitet, was ein bisschen komplizierter ist. Bedingung ist ein mindestens 2 GB großer USB-Stick, aber es geht auch, wenn man zwei USB-Sticks hat, die nur 1 GB groß sind. Die Anleitung dazu gibt es in Tobis Blog, nach der ich auch meinen USB-Stick erstellt habe.

Neben einem USB-Stick der mit FAT32 formatiert ist, benötigt man noch einen Computer, auf dem ein Gnu/Linux läuft, den Bootloader lilo, syslinux als Bootloader für FAT-formatierte Datenträger und eine ISO-Datei der Alternate-CD. Der Stick darf nicht ins System eingehängt sein und vermutlich muss man ihn noch bootbar machen:

sudo umount /dev/sdb1 sudo mkfs.vfat -F 32 /dev/sdb1 sudo fdisk /dev/sdb

Das Verzeichnis heißt bei mir /dev/sdb, was aber nicht bei jedem der Fall sein muss. Es kann auch /dev/sdc oder ganz anders heißen. Der erste Befehl hängt den Stick aus, der zweite formatiert ihn mit dem Dateisystem FAT32, der dritte startet das Partitionierungsprogramm Fdisk. Mit p lässt man sich die Partionen auf dem Stick anzeigen. Wenn unter Boot ein Sternchen steht, dann ist der Stick schon bootfähig. Wenn nicht, muss man a und anschließend 1 drücken und mit w die Änderungen speichern. Mit q verlässt man Fdisk.

sudo lilo -M /dev/sdb sudo syslinux /dev/sdb1

Dann setzt man den MBR des USB-Sticks neu und installiert den Bootloader syslinux.

cd ~/Desktop wget http://ftp.tu-chemnitz.de/pub/linux/xubuntu/releases/9.10/release/xubuntu-9.10-alternate-i386.iso sudo mount -t iso9660 xubuntu-9.10-alternate-i386.iso /mnt -o loop sudo mkdir /media/usb sudo mount -t vfat /dev/sdb1 /media/usb

Nachdem man auf dem Desktop gewechselt ist, lädt man die Alternate-ISO von Xubuntu herunter und hängt es unter /mnt ein. Der USB-Stick wird unter das neu angelegte Verzeichnis /media/usb eingehängt. Jedes andere Verzeichnis tut es aber auch.

cd /mnt sudo cp -R . /media/usb

Wenn man in das Verzeichnis /mnt gewechselt ist, kopiert man alle Dateien und Ordner auf den USB-Stick. Dabei kann man folgende Fehlermeldungen erstmal ignorieren,

cp: Erzeugen der symbolischen Verknüpfung „/media/usb/./dists/stable“ nicht möglich: Operation not permitted cp: Erzeugen der symbolischen Verknüpfung „/media/usb/./dists/unstable“ nicht möglich: Operation not permitted cp: Erzeugen der symbolischen Verknüpfung „/media/usb/./install/netboot/pxelinux.0“ nicht möglich: Operation not permitted cp: Erzeugen der symbolischen Verknüpfung „/media/usb/./install/netboot/pxelinux.cfg“ nicht möglich: Operation not permitted cp: Erzeugen der symbolischen Verknüpfung „/media/usb/./ubuntu“ nicht möglich: Operation not permitted

weil man sie nachträglich rüber kopiert:

sudo cp -R dists/karmic /media/usb/dists/stable sudo cp -R dists/karmic /media/usb/dists/unstable sudo cp install/netboot/ubuntu-installer/i386/pxelinux.0 /media/usb/install/netboot/pxelinux.0 sudo cp -R install/netboot/ubuntu-installer/i386/pxelinux.cfg /media/usb/install/netboot/pxelinux.cfg sudo rm -rf /media/usb/isolinux sudo cp -R isolinux/* /media/usb sudo mv /media/usb/isolinux.cfg /media/usb/syslinux.cfg

Anschließend kopiert man noch die ISO-Datei auf den Stick und hängt ihn aus:

sudo cp ~/Desktop/xubuntu-9.10-alternate-i386.iso /media/usb/ sudo umount /media/usb

Damit das Hercules EC-800 vom USB-Stick bootet, muss man die Bootreihenfolge im Bios umstellen. Dann kann man das Netbook neu starten und Xubuntu mit einem verschlüsseltem LVM installieren. Nach dem ersten Start fällt auf, dass das untere Panel von XFCE nicht angezeigt wird, weil die Bildschirmauflösung bei 800×600 liegt, statt der 800×480, die das Glare-Display benötigt. Das lässt sich aber beheben. Mehr dazu im nächsten Teil.

Ubuntu & Super Talent 64Gb SSD ¶

Vor kurzem hatte ich über die Anschaffung einer SSD und den Betrieb selbiger unter Ubuntu Karmic nachgedacht – und aus einer Laune heraus wurde die Solid State Disc auch wirklich angeschafft: Eine Super Talent 64GB. Und bisher läuft sie eigentlich ganz gut unter Ubuntu Karmic:

Geschwindigkeit unter Ubuntu Karmic

Die Karmic-Installation war relativ zügig beendet, das Home-Verzeichnis wurde diesmal verschlüsselt und die Komplettverschlüsselung mit LVM diesmal nicht angewendet um den Geschwindigkeitsvorteil einer SSD nicht komplett durch Verschlüsselung zunichte zu machen. Die derzeitigen Geschwindigkeiten:

cywhale@ummon:~$ sudo hdparm -tT /dev/sda /dev/sda: Timing cached reads: 1258 MB in 2.00 seconds = 629.50 MB/sec Timing buffered disk reads: 240 MB in 3.01 seconds = 79.69 MB/sec

cywhale@ummon:~$ sudo hdparm -t --direct /dev/sda /dev/sda: Timing O_DIRECT disk reads: 358 MB in 3.01 seconds = 118.83 MB/sec

Die SSD:

Modell: Super Talent STT_FTM64GX25H Firmware: 1819

Nunja, die absolute Stille der SSD ist sehr, sehr angenehm, die Geschwindigkeit bei Disc-Zugriffen in Ordnung, einen Nachteil gegenüber der alten Festplatte mit LVM/Komplettverschlüsselung ist gefühlt etwas höher, aber nur etwas.

Werde mich weiter umsehen ob man Ubuntu da noch etwas optimieren kann, mehr als SATA1-Geschwindigkeiten sind aber beim Samsung NC10 nicht drin, auch lassen sich IDE/AHCI-Modi im Bios leider nicht ändern (=IDE).

TRIM unter Ubuntu – wiper.sh

Sehr erfreulich war auch dass mein von blindem Aktivismus (kein Backup) geleiteter Trim-Versuch scheinbar

problemlos funktioniert hat: HDPARM 9.27 installiert, wiper-2.5 heruntergeladen und mit sudo ./wiper.sh /

das TRIMmen gestartet (SSD -> hier 1 Partition + Swap). Gebracht hat es allerdings nach ca. 2 Wochen Benutzung der SSD

noch nichts da auch erst ca. 5GB des freien Speicherplatzes belegt sind…

Weitere Optimierungen

Um unnötige Schreibzugriffe auf die SSD zu reduzieren habe ich mir sagen lassen man solle

- Die SSD-Partitionen in /etc/fstab mit dem Attribut “noatime” mounten

- Den Firefox-Cache in eine Ramdisk auslagern

- /tmp in eine Ramdisk auslagern

- /var/tmp in eine Ramdisk auslagern

- /var/log in eine Ramdisk auslagern

- /var/log/apt in eine Ramdisk auslagern

- /var/cache/apt/archives/ in eine Ramdisk auslagern

Wie sieht das bei Euch aus – wer benutzt ebenfalls SSD(s), wer hat noch weitere Tips und/oder Tricks bei der Hand?

Ubuntu & Super Talent 64Gb SSD ¶

Vor kurzem hatte ich über die Anschaffung einer SSD und den Betrieb selbiger unter Ubuntu Karmic nachgedacht – und aus einer Laune heraus wurde die Solid State Disc auch wirklich angeschafft: Eine Super Talent 64GB. Und bisher läuft sie eigentlich ganz gut unter Ubuntu Karmic:

Geschwindigkeit unter Ubuntu Karmic

Die Karmic-Installation war relativ zügig beendet, das Home-Verzeichnis wurde diesmal verschlüsselt und die Komplettverschlüsselung mit LVM diesmal nicht angewendet um den Geschwindigkeitsvorteil einer SSD nicht komplett durch Verschlüsselung zunichte zu machen. Die derzeitigen Geschwindigkeiten:

cywhale@ummon:~$ sudo hdparm -tT /dev/sda /dev/sda: Timing cached reads: 1258 MB in 2.00 seconds = 629.50 MB/sec Timing buffered disk reads: 240 MB in 3.01 seconds = 79.69 MB/sec

cywhale@ummon:~$ sudo hdparm -t --direct /dev/sda /dev/sda: Timing O_DIRECT disk reads: 358 MB in 3.01 seconds = 118.83 MB/sec

Die SSD:

Modell: Super Talent STT_FTM64GX25H Firmware: 1819

Nunja, die absolute Stille der SSD ist sehr, sehr angenehm, die Geschwindigkeit bei Disc-Zugriffen in Ordnung, einen Nachteil gegenüber der alten Festplatte mit LVM/Komplettverschlüsselung ist gefühlt etwas höher, aber nur etwas.

Werde mich weiter umsehen ob man Ubuntu da noch etwas optimieren kann, mehr als SATA1-Geschwindigkeiten sind aber beim Samsung NC10 nicht drin, auch lassen sich IDE/AHCI-Modi im Bios leider nicht ändern (=IDE).

TRIM unter Ubuntu – wiper.sh

Sehr erfreulich war auch dass mein von blindem Aktivismus (kein Backup) geleiteter Trim-Versuch scheinbar

problemlos funktioniert hat: HDPARM 9.27 installiert, wiper-2.5 heruntergeladen und mit sudo ./wiper.sh /

das TRIMmen gestartet (SSD -> hier 1 Partition + Swap). Gebracht hat es allerdings nach ca. 2 Wochen Benutzung der SSD

noch nichts da auch erst ca. 5GB des freien Speicherplatzes belegt sind…

Weitere Optimierungen

Um unnötige Schreibzugriffe auf die SSD zu reduzieren habe ich mir sagen lassen man solle

- Die SSD-Partitionen in /etc/fstab mit dem Attribut “noatime” mounten

- Den Firefox-Cache in eine Ramdisk auslagern

- /tmp in eine Ramdisk auslagern

- /var/tmp in eine Ramdisk auslagern

- /var/log in eine Ramdisk auslagern

- /var/log/apt in eine Ramdisk auslagern

- /var/cache/apt/archives/ in eine Ramdisk auslagern

Wie sieht das bei Euch aus – wer benutzt ebenfalls SSD(s), wer hat noch weitere Tips und/oder Tricks bei der Hand?

Ubuntu & Super Talent 64Gb SSD ¶

Vor kurzem hatte ich über die Anschaffung einer SSD und den Betrieb selbiger unter Ubuntu Karmic nachgedacht – und aus einer Laune heraus wurde die Solid State Disc auch wirklich angeschafft: Eine Super Talent 64GB. Und bisher läuft sie eigentlich ganz gut unter Ubuntu Karmic:

Geschwindigkeit unter Ubuntu Karmic

Die Karmic-Installation war relativ zügig beendet, das Home-Verzeichnis wurde diesmal verschlüsselt und die Komplettverschlüsselung mit LVM diesmal nicht angewendet um den Geschwindigkeitsvorteil einer SSD nicht komplett durch Verschlüsselung zunichte zu machen. Die derzeitigen Geschwindigkeiten:

cywhale@ummon:~$ sudo hdparm -tT /dev/sda /dev/sda: Timing cached reads: 1258 MB in 2.00 seconds = 629.50 MB/sec Timing buffered disk reads: 240 MB in 3.01 seconds = 79.69 MB/sec

cywhale@ummon:~$ sudo hdparm -t --direct /dev/sda /dev/sda: Timing O_DIRECT disk reads: 358 MB in 3.01 seconds = 118.83 MB/sec

Die SSD:

Modell: Super Talent STT_FTM64GX25H Firmware: 1819

Nunja, die absolute Stille der SSD ist sehr, sehr angenehm, die Geschwindigkeit bei Disc-Zugriffen in Ordnung, einen Nachteil gegenüber der alten Festplatte mit LVM/Komplettverschlüsselung ist gefühlt etwas höher, aber nur etwas.

Werde mich weiter umsehen ob man Ubuntu da noch etwas optimieren kann, mehr als SATA1-Geschwindigkeiten sind aber beim Samsung NC10 nicht drin, auch lassen sich IDE/AHCI-Modi im Bios leider nicht ändern (=IDE).

TRIM unter Ubuntu – wiper.sh

Sehr erfreulich war auch dass mein von blindem Aktivismus (kein Backup) geleiteter Trim-Versuch scheinbar

problemlos funktioniert hat: HDPARM 9.27 installiert, wiper-2.5 heruntergeladen und mit sudo ./wiper.sh /

das TRIMmen gestartet (SSD -> hier 1 Partition + Swap). Gebracht hat es allerdings nach ca. 2 Wochen Benutzung der SSD

noch nichts da auch erst ca. 5GB des freien Speicherplatzes belegt sind…

Weitere Optimierungen

Um unnötige Schreibzugriffe auf die SSD zu reduzieren habe ich mir sagen lassen man solle

- Die SSD-Partitionen in /etc/fstab mit dem Attribut “noatime” mounten

- Den Firefox-Cache in eine Ramdisk auslagern

- /tmp in eine Ramdisk auslagern

- /var/tmp in eine Ramdisk auslagern

- /var/log in eine Ramdisk auslagern

- /var/log/apt in eine Ramdisk auslagern

- /var/cache/apt/archives/ in eine Ramdisk auslagern

Wie sieht das bei Euch aus – wer benutzt ebenfalls SSD(s), wer hat noch weitere Tips und/oder Tricks bei der Hand?

Communtu jetzt auch in Englisch ¶

Communtu ist nun auch in englischer Sprache verfügbar. Beim LinuxTag 2009 in Berlin haben wir die englische Version angekündigt und nun ist sie fertiggestellt. Nun steht einer komfortablen Nachinstallation und einer einfacheren Neuinstallation, durch das Anlegen eines Bündels mit der aktuell installierten Software, auch auf Englisch nichts mehr im Wege!

Hierbei musste das gesamte Repository umziehen, da nun die Debianpaketnamen und -beschreibungen auf Englisch umgestellt wurden.

Auf der Communtu-Seite steht ein Skript zu Verfügung, dass alle installierten Communtu-Pakete auf die englisch-namigen Pakete umstellt. Wenngleich auch die Pakete mit deutschen Namen noch verfügbar sind, werden sie jedoch nicht mehr aktualisiert. Wir empfehlen deshalb, das Skript auszuführen, falls ihr schon mal mit Communtu etwas installiert habt.

Die englische Version ist unter http://en.communtu.org zu erreichen.

MyBookWorld Backup JBOD ¶

Das NAS MyBookWolrd kann im Modus RAID-0, RAID-1 oder JBOD betrieben werden. Im Artikel MyBookWolrd Backup wurden im Modus RAID-1 zusätzlich die Daten mit rsync dupliziert. Leider verbraucht das MyBookWorld NAS viel Speicher im RAID-1-Modus für die zusätzliche Sicherung (2 TB / 2 (Spiegelung) / 2 (rsync) = 500 GB). Wieso die Spiegelung, wenn schon nach jeder Synchronisation durch rsync eine Sicherung vorhanden ist? Hier eine Idee …

Offline Notizen :: Backup JBOD

… und die Umsetzung.

Western Digital WDH2NC20000E My Book World Edition II 2TB NAS externe Festplatte, Firmware-Version 01.01.14

Modus JBOD

JBOD (Just a Bunch of Disks) – Im JBOD-Modus werden zwei Laufwerke als

zwei separate Datenträger bereitgestellt. Dies ist der einzige Modus für

My Book World Edition II, bei dem es zwei Datenvolumes gibt.

Wenn eines der beiden Laufwerke in einem JBOD-Datenträger ausfällt, sind nur die Daten auf diesem Laufwerk verloren.

Startkonfiguration RAID 1 (Gespiegelt) > Endekonfiguration JBOD (2 Datenträger) = Benutzerdatenstatus: Gelöscht

Im erweiterten Modus unter “Speichergerät / Datenträger & RAID-Verwaltung / RAID verwalten” RAID Konfiguration JBOD auswählen.

NetworkStorageManager :: RAID Verwaltung

Freigaben

Die Freigabe zur Sicherung und für die Daten auf separate Volumes einrichten!

Im NetworkStorageManager unter Ordnerfreigaben eine Freigabe “Trash” auf dem Quelllaufwerk (DataVolume) anlegen.

Für die Sicherung die Freigabe Snapshot auf dem zweiten Laufwerk (ExtendVolume) mit lesendem Zugriff erzeugen.

rsync

Der erste Test und das mit nur einem Befehl. :-)

Die Quelle und das Ziel auf separate Volumes angeben!

$ rsync -ab --delete --backup-dir=/DataVolume/Trash/ --exclude=Trash/ --exclude=_torrent_/ --exclude=jewab/ /DataVolume/ /ExtendVolume/Snapshot/ --- -------- ------------------------------- ------------------------------------------------------ ------------ ----------------------- | | | | | | | | | | | Zielverzeichnis | | | | | | | | | Quellverzeichnis | | | | | | | Auszuschliessende Verzeichnisse relativ zur Quelle (insb. Trash/) | | | | | Sicherungsverzeichnis für gelöschte oder veränderte Dateien | | | existierende Dateien im Zielverzeichnis löschen | Option Archiv und Backup

Als Skript …

#!/bin/sh killall rsync rsync -ab --delete --backup-dir=/DataVolume/Trash/ --exclude=Trash/ --exclude=_torrent_/ --exclude=jewab/ /DataVolume/ /ExtendVolume/Snapshot/

Sonstiges

Siehe MyBookWorld Backup für den SSH-Zugang, crond und cronjob.

Backup

Die im rsync-Skript eingetragene Verzeichnisse werden einmal pro Tag gesichert. Gelöschte oder geänderte Dateien (schon gesicherter) landen nach der nächsten Duplizierung in der Freigabe “Trash” und können endgültig gelöscht oder zurück kopiert werden. Einziger Nachteil … die Daten sind erst nach der nächsten Synchronisierung gesichert …

Ein Backup ist immer nur so gut wie der Restore!

… danke Nachbar. :)

Teeworlds | Mehrere Server betreiben unter Linux ¶

Die 4 Teeworldsserver die auf zwetschge.org laufen, stellten ihre Dienste ehrilchgesagt in einem ziemlichen WirrWarr aus Binaries und Configfiles. Nach Neuorganisition, der technical Overview hier:

Dateistruktur:

Ausgabe mit tree -L 3 in /home/teeworlds/:

http://zwetschge.org/paste/4

Configfiles:

Individuell für jeden Server

http://zwetschge.org/paste/3

Startskript:

Nach Reboot automatisch ausgeführt

http://zwetschge.org/paste/2

Syntax: binary -f configfile >> ausgabe_logfile &(& = als hintergrundprozess)

Sollte jemand auch mal mehrere Teeworldsserver nebeneinander betreiben und den Überblick behalten wollen ![]()

Das Sicherheitskonzept von Linux verbessern ¶

Mit ein bisschen mehr Zeit möchte ich die Geschichte rund um die Meldung Malware in .deb Paket von gnome-look.org noch einmal Revue passieren lassen. Was war passiert? Ein unbekannter Freund hat auf der beliebten Webseite gnome-look.org einen vermeintlichen Bildschirmschoner als .deb-Paket hochgeladen. Hat man sich dieses Paket heruntergeladen und installiert, so wurden zwei Skripte aus dem Internet geladen und nach /usr/bin/ kopiert, sowie ein Eintrag in /etc/profile.d/ erzeugt. Damit wurden die Skripte automatisch beim beim Einloggen ausgeführt. Einen Screensaver bekam man danach nicht, stattdessen führten die Skripte eine simple DOS-Attacke auf eine Spiele-Community aus.

OMG!!!11EinsElf! Malware für Linux!

Mit etwas Ruhe betrachtet liegt (sitzt) das Problem dort begraben, wo langjährige Linux-Anwender es schon immer vermutet haben. Vor dem Rechner, im Abstand von ca. 50cm. Ich meine dies nicht bösartig, doch Computer sind hoch-komplexe Systeme, die viele Anwender nicht durchblicken können.

Gerade die sorglose Installation von Software aus unbekannten Quellen bricht jedem Sicherheitskonzept das Genick. Da helfen keine Personal Firewalls oder Virenscanner. Es wäre ein Leichtes ein Programm per Social-Engineering zu verteilen und es dann Daten löschen zu lassen. Dabei wäre das Betriebssystem völlig egal. Ob Windows XP, Windows 7, Mac OS X, Linux oder BSD. Egal, wird ein Programm vom Anwender ausgeführt, dann kann das Programm alles machen, was im im Kontext der Rechte des ausführenden Benutzers liegt.

Das klappt wie man im aktuellen Fall sehen kann nicht lange, dazu sind die soziale Netze der Linux-Anwender zu eng genüpft. Kaum war der Missbrauch des Pakets bekannt geworden, war es von gnome-look.org gelöscht, die Information zum Löschen der Skripte verbreitet und die herunterzuladenden Skripte auf dem Server gelöscht. Doch eine begrenzte Anzahl an “Opfern” wird es dabei immer geben. In diesem Fall war der angerichtete Schaden minimal, doch es wäre auch andere Szenarien denkbar.

Wie kann man die Situation verbessern?

Der Hebel muss an der richtige Stelle angesetzt werden. Ein von Grund auf solide aufgebautes System braucht keinen Virenscanner oder eine Überwachung von Verzeichnissen auf Änderungen. In meinen Augen müsste man bei der Installation von Paketen aus unbekannten Quellen beginnen, den hier muss der Anwender selber die Spreu vom Weizen trennen. Dies wird ihm derzeit jedoch nicht gerade leicht gemacht.

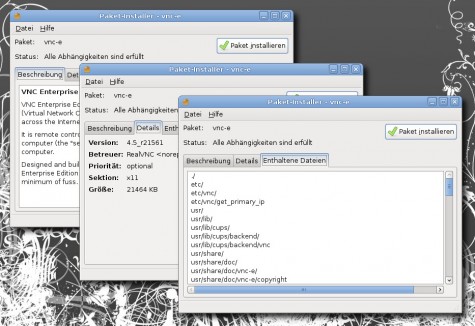

Als Beispiel zeige ich die Installation eines .deb Paketes von RealVNC. Der Anwender sieht nur eine beliebig gestalbare Beschreibung, Details des Paketerstellers die dieser völlig frei angeben kann und welche Datei wohin kopiert wird. Was über preinst- oder postinst-Routinen während der Installation gemacht wird ist nicht erkennbar. Eine Garantie, dass die Angaben zum Ersteller stimmen, gibt es nicht. Was könnte man besser machen?

Offizielle Zertifizierungsstellen

Es muss eindeutig erkennbar sein, von wem ein Paket stammt. Die Identifizierung darf nicht nur über ein selbst ausfüllbares Textfeld bei der Erstellung des .deb Paketes geschehen. Das Paket muss mit verifizierten Schlüsseln signiert werden. Falls der Schlüssel nicht eindeutig einer Person oder Organisation zugeordnet werden kann, dann muss die Paketverwaltung, ähnlich wie Firefox bei selbst erstellten Zertifikaten, deutlich vor dem Paket warnen.

Dafür bräuchte es Zertifizierungsstellen, die ähnlich zu CACert und Co. arbeiten. Trägt ein Paket nicht ein Zertifikat solch einer Stelle, dann muss der Anwender deutlich vor der Installation gewarnt werden. Das verhindert zwar weiterhin nicht die Installation schädlicher Pakete, doch es wird dem Anwender eine Möglichkeit an die Hand gegeben zu erkennen von wem ein Paket wirklich stammt. Allerdings kann ich jetzt schon die Aufschreie vieler Entwickler hören, die sich ihrer “Freiheit” und ihrem Recht auf Anonymität beraubt fühlen.

Bessere Erklärung des Installationsvorganges

Die Aufzählung der bei der Installatation kopierten Dateien und ausgeführten Aktionen müsste erklärt werden. Der Anwender muss verstehen können, dass beim Kopieren von Dateien nach /etc/profile.d/ quasi ein Autostart beim Einloggen ausgeführt wird. Oder dass beim Kopieren von Dateien nach /etc/init.d/ Dienste eingerichtet werden. D.h. es müsste erklärt werden warum welche Dateien wohin kopiert werden.

So bekommen auch schlechter informierte Anwender die Chance missbräuchliche Pakete aufzudecken. Denn warum sollte etwas bei der Installation eines “neuen” coolen Texteditors Dienste und Cron-Jobs eingerichtet werden. Dies würde die Erstellung von Paketen deutlich aufwändiger machen, doch letztendlich wäre dies ein wichtiger Schritt hin zum “aufgeklärten” Benutzer. Denn wie schon am Anfang erklärt, die wichtigste Sicherheitsmaßnahme ist ein Benutzer, der nicht alles installiert, was ihm unter die Nase kommt.

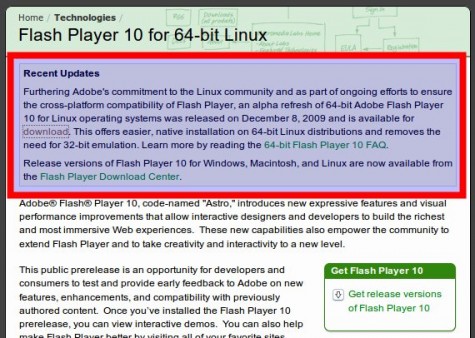

[UPDATE] Neuer Flash-Player von Adobe für 64-bit Linuxe! ¶

Ein halbes Jahr war es ziemlich leise um das 64-bit Flash-Plugin von Adobe. Doch nun tut sich wieder etwas. Auf der Homepage des 64-bit Flash-Players von Adobe ist seit kurzem dieser Text zu lesen…

Furthering Adobe’s commitment to the Linux community and as part of ongoing efforts to ensure the cross-platform compatibility of Flash Player, an alpha refresh of 64-bit Adobe Flash Player 10 for Linux operating systems was released on December 8, 2009 and is available for download.

Offensichtlich plant Adobe eine neuere Version des Flash-Players für 64-bit Linux herauszugeben und hat die Ankündigung etwas zu früh aktiviert.

Denn auf der Downloadseite wird immer noch die Version 10.0.32.18 angeboten, die bereits im Juli 2009 veröffentlicht wurde. Freuen wir uns also mal auf den 8. Dezember. Vielleicht sind dann die Klickprobleme und die schwache Performance Geschichte. Hardwarebeschleunigung (Stichwort VDPAU) wäre auch was nettes

[UPDATE] In der Tat ist die neue Version erschienen. Sie trägt die Nummer 10.0.42.34, ein Changelog gibt es wohl nicht. [/UPDATE]

Linux Festplatten Diagnose ¶

Ich hatte die letzten Tage ein wenig Probleme mit einer meiner Platten deshalb habe ich mich mal auf die Suche nach Analysemöglichkeiten gemacht.

Wie ja allgemein bekannt ist besitzen Festplatten die S.M.A.R.T (Self-Monitoring, Analysis and Reporting Technology) funktion. Bedeutet so viel wie: Selbstüberwachungs- und Analysesystem. Durch die S.M.A.R.T funktion können wir also die Festplatte vorsorglich analysieren und Fehler frühzeitig erkennen und so Datenverlust vermeiden.

Um die S.M.A.R.T-funktion nutzen zu können brauchen wir ein Programm wie Smartmontools. Ist Smartmontools installiert müsst ihr noch wissen wie die Festplatte im System bezeichnet ist, um dies herauszufinden könnt ihr einfach mal

sudo fdisk -l

in die Konsole tippen. So habt ihr schonmal einen gute Anhaltspunkt.

Wollt ihr jetzt die Festplatte Überprüfen braucht ihr folgende Befehle. Bei SATA Platten:

sudo smartctl -a -d ata /dev/euerlaufwerk

Sollte die Fehlermeldung auftauchen das S.M.A.R.T deaktiviert ist, tippt ihr folgendes ein:

sudo smartctl -a -d ata -s on /dev/euerlaufwerk

Bei IDE Platten:

sudo smartctl -i /dev/euerlaufwerk

Jetzt sollte eine Tabelle mit verschiedenen Werten auftauchen. Aus diesen könnt ihr auf den Zustand der Platte schließen. Deshalb sind hier die wichtigsten Spalten erläutert:

ID ist einfach die Nummer des Wertes der Gerade ausgelegt wird. ATTRIBUTE_NAME ist der Name des Werts der ausgelesen wird VALUE zeigt uns den aktuellen Wert an (meist das Maximus). WORST zeigt uns den bisher schlechtesten Wert an. TRESH (kommt von TRESHOLD=Schwellenwert) zeigt uns den Wert an wo es kritisch wird. Soweit sollte man es nicht kommen lassen und lieber vorher die Platte tauschen ![]() .

.

Ähnliche Artikel:

Paketversionen fixieren ¶

Es mag verschiedene Gründe haben, sich fest für eine Version einer Software zu entscheiden. Über den Debian Paketmanager ist es auch möglich, den automatischen Upgradewellen Regeln zu setzen.

Erst gestern berichtet Benni von bejonet vom Release des neuen Thunderbird 3.0, ehemals "Shredder". Er empfiehlt für die Installation das PPA (Personal Package Archive) ubuntu-mozilla-daily. Doch das liefert nicht nur den neuen Thunderbird, sondern auch einen frischen Firefox und Xulrunner jeweils in Daily-Versionen. Je nach Tageslaune der Entwickler mag also ein Build einmal funktionieren, einmal nicht.

Wer nun also immernoch Interesse am aktuellen Donnervogel hat, der hat zwei Möglichkeiten.

- Paket manuell aus der Paketquelle herunterladen und

- Aktuelle Paketversionen in Ubuntu fixieren.

#!/bin/sh echo $@ hold | dpkg --set-selections/usr/local/bin/apt-unhold

#!/bin/sh echo $@ install | dpkg --set-selectionsDiese müssen jeweils mit Root-Rechten (bzw. sudo) an die angegebenen Orte gelegt werden. Im Anschluss benötigen sie noch das executable-Flag (chmod +x) und können dann wie folgt verwendet werden.

# apt-hold firefox-3.5soll z.B. sicherstellen, dass das Paket Firefox 3.5 in seiner Version konstant bestehen bleibt. Dies verhindert jedoch ggf. auch Sicherheitsupdates aus den Originalquellen, weshalb man das Ganze auch wieder rückgängig machen kann.

# apt-unhold firefox-3.5Sicher ist das kein optimales Anwendungsbild, um das teilweise Update aus PPAs zu verhindern, es ist jedoch eine Möglichkeit, die man m. E. kennen sollte. Andere Anwendungsfälle sieht man beispielsweise, wenn man aktiv Programmentwicklungen verfolgt, und auf dessen stabile Funktionalität angewiesen ist, sich aber bei Updates erst einmal Zeit lassen möchte. Oder wenn bereits Bugs für eine neuere Version, als die die man installiert hat, bekannt sind und man diese um jeden Preis meiden möchte.

Manuell xorg.conf generieren lassen ¶

Seit einiger Zeit gibt es unter Xorg eine einfache Möglichkeit, sich manuell eine xorg.conf generieren zu lassen. Dies ist z. B. dann nützlich, wenn bei der Installation die Grafikkarte, der Bildschirm etc. nicht richtig erkannt wurde.

Um sich von Xorg eine xorg.conf generieren zu lassen, gibt man folgenden Befehl als root ein:

Xorg -configure

Die neue xorg.conf kann man anschließend auch testen:

Xorg -config xorg.conf.new

Wenn jetzt eine graue Rastergrafik und der Mauszeiger erscheint, wurde alles korrekt erkannt und man kann mittels

cp /root/xorg.conf.new /etc/X11/xorg.conf

die neue xorg.conf noch an die richtige Stelle verschieben.

Ubuntu Karmic auf dem EEE PC 1101HA ¶

Da wir mittlerweile zu Dritt in der Familie sind, die an einem Rechner arbeiten wollen und dabei mobil sein möchten, musste ich wohl oder übel einen weiteren, kleinen Rechner anschaffen. So kurz vor Weihnachten mutiert das Übel eher zu einem Wohl. Insofern musste ich mich kaum überwinden, einzukaufen. Ich mag die EEEPC sehr gerne und so habe ich auch diesmal wieder ein solches Teil beschafft. Ein 1101HA ist es jetzt. Dieses Gerät, das leicht grösser als andere EEE-Rechner ist (11.4 Zoll) und daher eine etwas bessere Tastatur bieten, wird mit Windows XP ausgeliefert. Wer gerne mit Windows arbeitet, dürfte damit nicht schlecht bedient werden. Der Bildschirm bietet eine Auflösung von 1366 mal 768 Pixeln und ist damit schon recht komfortabel für ein Netbook. Für manche dürfte die Hardware schon nicht mehr als Netbook durchgehen. Für mich spielt es weniger eine Rolle. Klein und handlich ist es noch immer.

Da ich lieber mit Linux arbeite, liess ich das Windows gleich zu Beginn sterben und gab ihm nicht einmal eine Chance, wenigstens das erste Mal zu booten. Ich steckte einen USB-Stick und bootete von diesem, um Karmic Koala als Live-Version zu starten. Allerdings muss man wissen, dass im Moment – und auch mit dem 2.6.31-16-generic Kernel – Ubuntu nicht ohne Nachbessern auf dem 1101HA läuft. Das ist zwar für EEEPC ungewöhnlich, scheint aber hier tatsächlich zuzutreffen, Auch die UNR-Version unterstützt nicht die volle Hardware. Nach dem Start der Live-Version von Ubuntu 9.10 stellte ich dann fest, dass sämtliche Hardware erkannt und einsatzfähig war, ausser der X-Server lieferte eine Auflösung von 1042 mal 612 Pixeln (oder so ähnlich) und forcierte das Ganze in einer 13 zu 9 Darstellung. Das sieht dann ziemlich eigenartig aus. Ansonsten funktionierte alles, auch WLAN, Kamera, Sound und der Flash-Card-Leser. Also installierte ich Ubuntu fix auf die Platte und hoffte, dass mit dem neuen 16er-Kernel dann das Problem behoben wäre.

Da ich lieber mit Linux arbeite, liess ich das Windows gleich zu Beginn sterben und gab ihm nicht einmal eine Chance, wenigstens das erste Mal zu booten. Ich steckte einen USB-Stick und bootete von diesem, um Karmic Koala als Live-Version zu starten. Allerdings muss man wissen, dass im Moment – und auch mit dem 2.6.31-16-generic Kernel – Ubuntu nicht ohne Nachbessern auf dem 1101HA läuft. Das ist zwar für EEEPC ungewöhnlich, scheint aber hier tatsächlich zuzutreffen, Auch die UNR-Version unterstützt nicht die volle Hardware. Nach dem Start der Live-Version von Ubuntu 9.10 stellte ich dann fest, dass sämtliche Hardware erkannt und einsatzfähig war, ausser der X-Server lieferte eine Auflösung von 1042 mal 612 Pixeln (oder so ähnlich) und forcierte das Ganze in einer 13 zu 9 Darstellung. Das sieht dann ziemlich eigenartig aus. Ansonsten funktionierte alles, auch WLAN, Kamera, Sound und der Flash-Card-Leser. Also installierte ich Ubuntu fix auf die Platte und hoffte, dass mit dem neuen 16er-Kernel dann das Problem behoben wäre.

Das traf dann aber leider nicht zu. Ein Lösungsansatz fand ich dann im Forum von ubuntuusers.de. Dort wird über den poulsbo-driver diskutiert, der vor allem das Problem mit der Auflösung beheben soll. Das Skript, welches auf der 6. Seite angeboten wird, half dann auch sogleich. Wichtig ist, dass dieses Skript auf einer sauberen Installation ausgeführt wird, möglichst gleich nach der Grundinstallation:

wget http://gma500re.altervista.org/scripts/poulsbo.sh && sh ./poulsbo.sh

Damit brachte ich die Auflösung richtig zustande. Diese Lösung wird auch hier direkt bei ubuntu.com propagiert. Allerdings scheint bei mir der poulsbo-driver-3d nicht zu greifen, denn ich kann keine Desktop-Effekte aktivieren. Das ist aber auf einem Netbook nicht weiter schlimm. Was mich eher stört, ist dass die Grafik zeitweise etwas träge arbeitet. Vielleicht komme ich noch zu einer besseren Lösung.

Aber ansonsten ist das Teil unter Ubuntu ganz in Ordnung. Im Moment nutze ich noch ein GB flüchtigen Speicher. Der Zweier-Riegel, den ich mit dem Gerät zusammen bestellt habe, ist noch nicht da. Damit wird das Gerät dann auch noch etwas flüssiger arbeiten.

Ähnliche Artikel

- 26. Februar 2009 -- Ubuntu 8.10 auf eee pc 1000H (9)

- 1. Juli 2009 -- Start der dritten Produktion (2)

- 18. Mai 2009 -- Karmic Koala in der ersten Alpha-Version (2)

- 21. März 2009 -- Der Tasmanische Teufel und das Windows [Podcast] (10)

- 16. Dezember 2008 -- ssh -X Resourcen anzapfen (6)

Malware in .deb Paket von gnome-look.org ¶

Zur späten Stunde mache ich es sehr kurz. Auf gnome-look.org ist ein Eintrag mit einem .deb-Paket für einen vermeintlichen Bildschirmschoner aufgetaucht, der anstatt einem Bildschirmschoner eine kleine Routine für eine simple DOS-Attacke enthält. Ich gehe morgen im Laufe des Tages genauer darauf ein. Ihr könnt mittels…

$ ps aux | grep ping user 28835 0.4 0.0 1940 800 pts/2 S+ 03:05 0:00 ping -s 65507 www.mmowned.com

…überprüfen ob Ihr Euch das Ding installiert habt. Falls dieser Ping auftaucht, dann könnt Ihr via…

$ sudo rm -f /usr/bin/Auto.bash /usr/bin/run.bash /etc/profile.d/gnome.sh index.php run.bash && sudo dpkg -r app5552

alles rückgängig machen. Das Paket wurde von gnome-look.org entfernt. Es wurden auch keine Sicherheitslücken ausgenutzt. Betroffen sind nur Leute, die sich dieses Paket selber auf den Rechner geholt haben. Später mehr…

Android Entwicklung unter Ubuntu/Kubuntu ¶

Dann geht es in den Ordner tools des SDKs und dort wird dann

./android update sdkausgeführt. Sollte das fehlschlagen hilft es die Datei ~/.android/androidtool.cfg zu erstellen und dort folgendes hineinzuschreiben

sdkman.force.http=trueDanach sollte der Updatevorgang erneut angestoßen werden.

Beim ersten Start erscheint ein Begrüßungsbildschirm den man schließen kann. Danach sollte man unter Help -> Install new Software die Android Development Tools installieren. Dazu wird in dem sich öffnenden Dialog die URL http://dl-ssl.google.com/android/eclipse/ eingegeben und durch einen Druck auf den Add Site... Button hinzugefügt. Dann klicken wir die Checkboxen für Android Development Tools und Android DDMS an und betätigen dann die Installation mit dem Install... Button. Mittels eines Assistenten wird man nun durch die Installation geleitet. Nachdem die Installation beendet ist empfiehlt Eclipse einen Neustart der Umgebung. Diesem sollte Wunsch sollte man Folge leisten.

Sollte bei der Installation ein Fehler auftreten welcher in etwa so aussieht:

Cannot complete the install because one or more required items could not be found.sollte die Seite http://download.eclipse.org/releases/galileo/ hinzugefügt werden und bei Work With --All Available Sites-- stehen. Wenn das eingestellt ist, kann die Installation ein weiteres Mal in Angriff genommen werden.

Software being installed: Android Development Tools 0.9.4.v200910220141-17704 (com.android.ide.eclipse.adt.feature.group 0.9.4.v200910220141-17704)

Missing requirement: Android Development Tools 0.9.4.v200910220141-17704 (com.android.ide.eclipse.adt.feature.group 0.9.4.v200910220141-17704) requires 'org.eclipse.gef 0.0.0' but it could not be found

Nun benötigt Eclipse die Information wo das Android SDK sich auf der Festplatte befindet. Dazu geht man auf Window -> Preferences -> Android. Dort wählt man den Pfad des Android SDKs aus und bestätigt den Dialog mit OK.

Die grundlegende Konfigurationsarbeit ist damit geleistet. Nun kann mit dem ersten Projekt begonnen werden. Dazu gehen wir auf File -> New -> Project und wählen dort das Android Project aus und klicken dann auf Next. In dem darauffolgenden Dialog geben wir dem Projekt einen Namen z.B. Hello World. Im Feld Package Name geben wir den Namen des Package an z.B. net.seeseekey.hello_world und bei Activity name z.B. hello_world und bei Application name z.B. Hello World und bestätigen das ganze mit dem Finish Button.

Danach wird automatisch das Grundgerüst für eine Android Applikation erzeugt. Sollte es beim Erzeugen der Anwendung der Fehler

Project 'RuntimeAndroid' is missing required source folder 'gen'auftreten so hilft es die R.java Datei zu löschen. Sie wird danach automatisch neu erzeugt. Auch ein Cleanen des Projektes wirkt manchmal Wunder

The project cannot be built until build errors are resolved

Wenn wir nun auf den grünen Play Knopf (Run) in der Symbolleiste klicken so startet Eclipse das Programm im Android Emulator. Beim ersten Start sollte allerdings ein Dialog erscheinen welcher einem anbietet ein virtuelles Gerät für den Emulator anzulegen. Nachdem dies geschehen ist, wird das Hello World Programm im Emulator geladen und ausgeführt. Und schon ist das erste Hello World Programm geschrieben

8. Dezember 2009

[update] Thunderbird 3.0 veröffentlicht ¶

Endlich ist der Final Release des E-Mail Verwaltungsprogramms erschienen. Vor wenigen Minuten gab Mozilla den Startschuss zum „tabbed browsing“. Das deutsche Paket kann man von der Downloadseite herunterladen, anschließend führt man folgende Schritte aus:

Endlich ist der Final Release des E-Mail Verwaltungsprogramms erschienen. Vor wenigen Minuten gab Mozilla den Startschuss zum „tabbed browsing“. Das deutsche Paket kann man von der Downloadseite herunterladen, anschließend führt man folgende Schritte aus:

- Das Archiv entpacken

- Den entstandenen thunderbird-Ordner nach /opt verschieben

sudo mv thunderbird /opt

- Einen symbolischen Link legen, um Thunderbird über einen gescheiten Befehl öffnen zu können:

sudo ln -s /opt/thunderbird/thunderbird /usr/bin/thunderbird-3

Danach ist das Programm über den Befehl

thunderbird-3

erreichbar. Wer es aus der Daily von Mozilla installiert hat, sollte mindestens die Fremdquelle wieder aus den Paketquellen nehmen!

Lange hat es gedauert, am Ende ging es aber doch ganz schnell: Mozilla veröffentlichte gerade den neuen Donnervogel. Während es zwischen den verschiedenen Alpha- und Betareleases relativ große Zeitabstände gab, beschleunigte Mozilla jetzt gegen Ende die Entwicklung und gab ohne große Ankündigung 14 Tage nach dem ersten Rleasekandidaten die neue Version frei.

Über die Neuerungen haben wir schon gesprochen. Auf jeden Fall ist Mozilla einer der Vorreiter im wirklich praktischen „tabbed mailing“, das meines Wissens noch kein großer Client vorher konnte (mal sehen, wann Microsoft nachzieht ![]() )

)

Auf jeden Fall danke ich den Entwicklern bei Mozilla für wieder ein Topprogramm aus ihrer Schmiede!

*) Achtung: Nach der Installaton von Thunderbird 3 solltet ihr die Fremdquelle wieder deaktiveren. Sie enthält nicht nur Paketen für Thunderbird, sondern auch für Firefox, was bedeutet, dass Updates auch für den Browser über diese Quelle kommen.

Artikel teilen:

Baustellenwarnung ¶

Besucher welche ausschließlich das openSUSE-Theme hier auf Karl-Tux-Stadt nutzen müssen derzeit mt kleineren Einschränkungen rechnen. Grund sind Umbaumaßnahmen sprich Karl-Tux-Stadt bekommt dann endlich mal ein neues Gesicht. Sehr Neu wird es nicht sein, nur die gräßlich extremen Farben verschwinden und vor allem die kleinen Fehler, die in den alten Themes überall versteckt sind verschwinden. Von daher ist eben mit kleineren Einschränkungen zu rechnen, das Theme bleibt aber dennoch meist benutzbar oder ihr weicht derweile auf eine andere “Distribution” um. Mal sehen wenn ich dann fertig bin aber ich gebe Bescheid;)

Der November im Kernelrückblick & Linux 2.6.32 ¶

Bedingt durch den (noch andauernden) Umzug des DSL-Anschlusses und der damit einhergehenden Netzlosigkeit ist es hier im Blog in letzter Zeit ruhiger, die beiden letzten Kernel-Vorabversionen 2.6.32-rc7 und -rc8 konnten nicht gebührend beleuchtet werden. Der Kernel 2.6.32 selbst wurde nach Fertigstellung des Kernel-Rückblicks, aber vor dessen Veröffentlichung freigegeben, womit letzterer, was die Aktualität betrifft, leider etwas hinterherhinkt. Der Kernel-Rückblick ist, neben vielen anderen interessanten Themen, in der aktuellen Ausgabe von freiesMagazin enthalten.

Die Entwicklung des Kernel 2.6.32 schreitet weiter voran, diesen Monat mussten die Entwickler jedoch einige größere Fehler finden und beseitigen. So wurde die Veröffentlichung des -rc6 [1] durch einen Fehler in Ext4 verzögert, der zu Datenverlusten nach unsauberem Abschalten des Systems führte. Der Auslöser lag in einer erst kürzlich aktivierten Checksummen-Prüfung des Journals, die nun erst einmal wieder abgestellt wurde, bis die genauen Hintergründe geklärt sind. Außerdem in der sechsten Vorabversion enthalten: ein Patch für eine im Oktober bekannt gewordene Lücke [2], die es ermöglicht, am lokalen System SuperUser-Rechte zu erlangen und die alle bisherigen Kernel-Version der Reihe 2.6 betreffen soll (CVE-2009-3547 [3]).

Auch -rc7 [4] wurde einige Tage zurückgehalten, um ein ernstes Problem beim Aufwecken des System

nach dem Bereitschaftsmodus beheben zu können. Die Ursache war hier ein einfaches Treiber-Problem, das jedoch nicht so leicht aufzuspüren war. Eine weitere Sicherheitslücke (CVE-2009-4021 [5]) betrifft die Infrastruktur für FUSE (Filesystem in Userspace); sie gestattet das Erlangen von SuperUser-Rechten und wurde nun ebenfalls geschlossen.

Kurz vor Thanksgiving gab es dann noch die Vorabversion Nummer 8 [6], die dann bereits deutlich weniger Änderungen gegenüber dem Vorgänger aufwies. Getreu dem Motto, dass zwei Ziffern hinter dem „-rc“ nicht gut sind, stellte Torvalds dann auch die baldige Freigabe des stabilen Kernels 2.6.32 in Aussicht.

Unterdessen beklagte sich der Entwickler des NetworkManagers, Dan Williams, über die Qualität der WLAN-Treiber aus dem staging-Zweig des Kernels [7]. In diesem Zweig werden Treiber abgelegt, die in künftige Kernelversionen einfließen sollen, sich jedoch noch in Entwicklung befinden. Nach Auskunft von Williams ist jedoch bei vielen der darin untergebrachten WLAN-Treiber die Funktion zum Scannen nach SSIDs (Service Set Identifiers), wodurch in der Nähe befindliche Drahtlosnetzwerke erkannt werden können, ausgeschaltet oder erst gar nicht implementiert. Bereits vor zwei Jahren habe er einen Patch bereitgestellt, der die Suche nach SSIDs aktivieren sollte, dieser sei jedoch von den Herstellern nicht eingepflegt worden. Er schlägt nun vor, Treiber, die auf dem älteren Netzwerk-Stack ieee80211 basieren, fallen zu lassen und sich nur noch auf die auf mac80211 aufbauenden Treiber zu konzentrieren. Dadurch hätten manche Anwender zwar eine gewisse Zeit lang keine Unterstützung für ihre WLAN-Hardware, dafür würden anschließend weitere Funktionen, die zum Beispiel dem Energiesparen dienlich sind, besser unterstützt werden.

Quellen:

[1] http://lkml.org/lkml/2009/11/3/377

[2] http://www.linux-magazin.de/NEWS/Luecke-im-Linux-Kernel-erlaubt-Rechteau...

[3] http://web.nvd.nist.gov/view/vuln/detail?vulnId=CVE-2009-3547

[4] http://lkml.org/lkml/2009/11/12/409

[5] http://web.nvd.nist.gov/view/vuln/detail?vulnId=CVE-2009-4021

[6] http://lkml.org/lkml/2009/11/19/395

[7] http://www.linux-magazin.de/NEWS/Kernel-Kritik-an-WLAN-Code-im-Staging-B...

Der Kernel 2.6.33 für Ubuntu im Mainline-Kernel-Archiv:

Das Ubuntu-Kernel-Team stellt ein Archiv mit dem Mainline-Kernel zur Verfügung, der ohne die spezifischen Anpassungen der regulären Ubuntu-Versionen erstellt wird.

Achtung! Die Installation des nicht angepassten Kernels kann die Systemstabilität beeinträchtigen!

Die Pakete 2 und 3 müssen nur installiert werden, wenn Anwendungen vorhanden sind, die die Headerdateien benötigen um z.B. Kernelmodule zu kompilieren. Die Pakete sollten dann in der jeweils aufgeführten Reihenfolge installiert werden. Die Kernel-Quellen werden nicht benötigt.

Architektur i386 (32 Bit):

- linux-image-2.6.32-020632-generic_2.6.32-020632_i386.deb

- linux-headers-2.6.32-020632_2.6.32-020632_all.deb

- linux-headers-2.6.32-020632-generic_2.6.32-020632_i386.deb

Architektur amd64 (64 Bit):

- linux-image-2.6.32-020632-generic_2.6.32-020632_amd64.deb

- linux-headers-2.6.32-020632_2.6.32-020632_all.deb

- linux-headers-2.6.32-020632-generic_2.6.32-020632_amd64.deb

Kernel-Quellen:

- Aus dem Ubuntu-Mainstream-Kernel-Archiv (installierbar): linux-source-2.6.32_2.6.32-020632_all.deb

- Direkt von Kernel.org: gzip (ca. 78 MB) / Bzip2 (ca. 61 MB)

MoreWordsPease 0.3 has been released! ¶

Simple Groupware: Gemeinsame Sache im Netz ¶

Sehr gerne arbeite ich mit phprojekt, aber jene OpenSource-Lösung leidet zur Zeit etwas. Die lang erwartete Version 6 kommt nicht aus den Löchern. Bisweilen nutze ich noch immer phprojekt, aber schaue mich hin und wieder gerne etwas um und erkunde, was es nebst den üblichen Verdächtigen wie OpenGoo, Zarafa, OpenXchange und dergleichen noch zu entdecken gibt. Dabei bin ich auf die Simple Groupware gestossen, einer Software, die unter GPL lizenziert und im Funktionsumfang in etwa ähnlich wie phprojekt ist. Es stehen etwa 60 Module zur Verfügung, die die Groupware zu einer breiten Anwendung aufpimpen können.

Aktuell gibt es die Version 0.5.41, die Features und Module sind hier im Detail beschrieben. Zur Installation steht ein Installer zur Verfügung. Ich habe aber das Dateiarchiv heruntergeladen, um es hernach auf dem Server meiner Wahl einzusetzen. Simple Groupware läuft mit PHP und MySQL und ist sehr einfach zu installieren. Solange keine Probleme auftauchen, ist die Software mit ein paar wenigen Klicks einsatzbereit. Die Dokumentation dazu ist ebenfalls ausgereift und vollständig. Während der Installation kann schön verfolgt werden, was die Installationsroutine gerade tut.

Aktuell gibt es die Version 0.5.41, die Features und Module sind hier im Detail beschrieben. Zur Installation steht ein Installer zur Verfügung. Ich habe aber das Dateiarchiv heruntergeladen, um es hernach auf dem Server meiner Wahl einzusetzen. Simple Groupware läuft mit PHP und MySQL und ist sehr einfach zu installieren. Solange keine Probleme auftauchen, ist die Software mit ein paar wenigen Klicks einsatzbereit. Die Dokumentation dazu ist ebenfalls ausgereift und vollständig. Während der Installation kann schön verfolgt werden, was die Installationsroutine gerade tut.

Nach dem Hochladen der Dateien aus dem Archiv (oder nach dem Entpacken des Archivs auf dem Server) wird die Installation sogleich mit dem Browser begonnen. Die dazu benötigte URL zeigt direkt in das Root-Verzeichnis der Installation. Dort wird zunächst die Sprache ausgewählt. Danach folgt die Abfrage zur Datenbank-Anbindung, dem Administrator-Login sowie die Bestätigung der Lizenz.

Anschliessend dauert es ein paar Sekunden, bis die Groupware installiert ist. Der Fortschritt ist dazu jeweils im Browser zu sehen. Danach ist die Software bereit und es wird sogleich mit einem anonymen Benutzer auf die Groupware zugegriffen. Das ist denn auch die erste Einstellung, welche ich geändert habe, so dass keine anonymen Zugriffe mehr möglich sind. Ausserdem erzwinge ich eine sichere Verbindung via SSL. Und es sollte – wie eigentlich überall – mit dem Administrator nicht produktiv mit der Software gearbeitet werden. Dazu kann ein eigener Benutzer erstellt werden, das ist deutlich sinnreicher.

Einige der Module stehen global und individuell pro Benutzer in doppelter Weise zur Verfügung. So können zum Beispiel Lesezeichen für alle Benutzer erfasst werden und jeder Benutzer kennt seine eigenen, privaten Lesezeichen. Um auf die öffentlichen Module zugreifen zu können, muss der Administrator den entsprechenden Benutzern die nötigen Rechte zuweisen. Ebenso eröffnet der Administrator die Projekte, die dann den Benutzern zugewiesen werden.

Viele der Module werden über den Menüpunkt Einhängepunkt konfiguriert. So auch beispielsweise das Einbinden eines externen POP3 oder IMAP-Konto. Das funktioniert soweit ganz gut. So kann sich jeder Benutzer die einzelnen Module selbst zurechtlegen.

Die Synchronisationsmöglichkeiten und Offline-Ordner scheinen recht ausgereift zu sein, auch der Im- und Export. Diese Bereiche habe ich aber nicht im Detail angesehen, da ich sie nicht brauche. Dafür ist die Tabellenkalkulation ganz gut und ebenso die GraphViz-Einbindung. Damit lässt sich eine ganze Menge anstellen, immer aus der Sicht eines Online-Büros, das halt noch nicht alle Feinheiten einer lokal installierten Office-Suite kennt. Aber auch die Kalendereinbindung klappt ganz gut. Ich habe einen Test mit iCal gemacht und das funktionierte auf Anhieb. Auch der Datei-Upload funktioniert, ohne dass zunächst Rechte am Ordner verändert werden müssen. Das hat die Installation bereits erledigt. Die Foto-Gallerie ist in Ordnung, obschon ich eine solche Funktion bei einer Groupware dieser Gattung nicht unbedingt erwarte. Sie funktioniert und es ist möglich, die Bilder in der privaten Galerie mit andern Benutzern zu teilen.

Weiter bietet Simple Groupware eine Passwort-Ablage an. Die würde ich aber nicht einsetzen. Passwörter gehören aus meiner Sicht nicht unverschlüsselt auf einen Server, auch wenn in der Datenbank nur die Meta-Daten dazu sichtbar sind. Ich setze KeePassX ein und nutze es ausschliesslich lokal. Daneben ist ein Wiki verfügbar; es handelt sich um ein PmWiki, das hier eingebunden wird.

Mit dem Administrator lassen sich Ressourcen wie Zimmer oder Orte, Benutzer und Gruppen eröffnen. Ausserdem koordiniert der Administrator, wer welche Module innerhalb welcher Projekte mit welchen Rechten nutzen darf. Weiter pflegt der Administrator oder ein berechtigter Benutzer das interne Helpdesk und unterstützt die Benutzer bei der Bewältigung ihrer alltäglichen Sörgeli mit Simple Groupware.

Diese Lösung gefällt mir ganz gut; sie weicht nicht stark von phprojekt ab, bietet aber einge andere Lösungsansätze. Wie bei jeder Software muss man sich aber zunächst darin einarbeiten, bevor sie nutzbringend eingesetzt werden kann. Simple Groupware eignet sich sowohl für kleine Projekte mit wenigen Mitarbeitern als auch für grössere Arbeiten mit vielen Nutzern und natürlich auch für viele kleinere Vorhaben, die alle auf der einen Installation liegen.

Ähnliche Artikel

- 29. November 2009 -- Kurze URLs nutzen (10)

- 20. November 2008 -- Projektverwaltung online (4)

- 9. Januar 2008 -- SSL auf Apache einrichten (0)

- 8. November 2009 -- Upgrade auf RoundCube 0.3.1 (0)

- 26. November 2008 -- Tiny Tiny RSS überzeugt noch nicht ganz (7)

7. Dezember 2009

AptUrl aktiv einsetzen! ¶

Klein und fein, unauffällig Installationen aus dem Browser, dem Messenger und anderen Programmen heraus tätigen. Open-Source ist eben cool!

Bereits seit Ubuntu Gutsy befindet sich AptUrl in den Ubuntu Paketquellen, seit einigen Versionen ist es auch in der Standardinstallation vorhanden. Nun sollten wir auch aktiv davon Gebrauch machen und dem Leser diese nutzbringende Funktionalität bieten. Über einen simplen Klick lässt sich z.B. das praktische und vielumworbene GNOME Do installieren:

Bereits seit Ubuntu Gutsy befindet sich AptUrl in den Ubuntu Paketquellen, seit einigen Versionen ist es auch in der Standardinstallation vorhanden. Nun sollten wir auch aktiv davon Gebrauch machen und dem Leser diese nutzbringende Funktionalität bieten. Über einen simplen Klick lässt sich z.B. das praktische und vielumworbene GNOME Do installieren:

apt://gnome-doDabei ist die Syntax recht simpel und eingänglich, die Funktionalität sicher und komfortabel. Weitere Abwandlungen der Syntax gefällig?

apt://gnome-do?section=universefür die Aktivierung der Universe-Paketquellen und der Installation von GNOME Do oder

apt://gnome-do,gnome-do-plugins,cairo-dockfür unsere grafikverwöhnten Ubunteros und einer Ansammlung mehrerer zu installierender Pakete. Also: Wer ist dabei? P.S.: Bedauerlicherweise scheint AptUrl nicht in den Debian-Paketquellen vorhanden zu sein, es dürfte sich jedoch recht einfach gemäß folgender Anleitung samt dem Ubuntu-Paket nachrüsten lassen. Ich habe das jedoch nicht prüfen können. Weiterführende Links:

- apturl im Ubuntuusers-Wiki

SheevaPlug: Kurztest ¶

Endlich ist er da, mein SheevaPlug! Nachfolgenden möchte ich einen kleinen Überblick über mein neues Gadget geben, ich hoffe es wird hierzu in Zukunft noch öfters mal den ein oder anderen Artikel geben!

Verpackung

Die Verpackung macht einen durchweg guten Eindruck. Klar, bei so einem kleinen Gerät ist nicht viel Verpackung dran: Da werden sich unsere Greenpeace Jungs also mal freuen!

Hardware

Dies Hardware misst gerade mal 11 x 7 x 5 Zentimeter, das wäre daher mein bis dato kleinster Rechenknecht der mehr kann als ein Taschenrechner. Folgendes liegt in der Packung als Zubehör:

- SheevaPlug

- Dokumentations-CD (sind auch Flashimages drauf wenn man was kaputtgemacht hat!)

- Mini-USB Kabel

- 2 Meter Ethernet Kabel

- EU-Steckeraufsatz

- EU-Anschlusskabel (wer es einfach so wohin legen will)

Auch hierzu habe ich mal ein paar Bilder gemacht:

Software

Auf dem SheevaPlug läuft standardmäßig die ARM Variante von Ubuntu Jaunty Jackalope (Beta), welche meiner Meinung nach eher schlecht als recht installiert ist. Zum einen hat man bei jedem Bootvorgang Fehlermeldungen und auf der anderen Seite ist es natürlich keine LTS Variante!

Da es sich um Standard-ARM Hardware handelt kann man auch Debian oder eine andere Linux Distribution installieren. Man sollte nur beachten einen Kernel mit Version 2.6.30 oder höher zu verwenden!

Ich hab das lieblose Ubuntu welches auf dem Gerät ist (wirft viele Fehler beim booten, kein Support für Kernelmodule) gleich durch ein Debian ersetzt, dazu wird es hier aber demnächst noch einen Artikel geben.

Performance

Hier noch ein kleiner Überblick über die Leistungsfähigkeit der Hardware, natürlich wie immer mit dem eingebauten Benchmark von 7-zip: Die CPU hat also die Leistungsfähigkeit von ca. 2 Flepos, welcher aber auch nur einen 500 MHz AMD Geode hat. Klar sind die Werte kein Vergleich zu einem Intel Core 2 Duo, weshalb ich hier auf einen Vergleich verzichte.

Die CPU hat also die Leistungsfähigkeit von ca. 2 Flepos, welcher aber auch nur einen 500 MHz AMD Geode hat. Klar sind die Werte kein Vergleich zu einem Intel Core 2 Duo, weshalb ich hier auf einen Vergleich verzichte.

Fazit

Der SheevaPlug ist ein schönes Stück Hardware zu einem sehr angenehmen preis (~100€), durch die gute Hardware kann man es locker als Nachfolger vom NSLU2 sehen. Der Stromverbrauch von weniger als 5 Watt unter Volllast (ohne USB Devices) ist auch mehr als OK.

Auf viele weitere Details (z.B. auch der Zugriff über die miniUSB Schnittstelle) werde ich demnächst noch eingehen.

SheevaPlug: Kurztest ¶

Endlich ist er da, mein SheevaPlug! Nachfolgenden möchte ich einen kleinen Überblick über mein neues Gadget geben, ich hoffe es wird hierzu in Zukunft noch öfters mal den ein oder anderen Artikel geben!

Verpackung

Die Verpackung macht einen durchweg guten Eindruck. Klar, bei so einem kleinen Gerät ist nicht viel Verpackung dran: Da werden sich unsere Greenpeace Jungs also mal freuen!

Hardware

Dies Hardware misst gerade mal 11 x 7 x 5 Zentimeter, das wäre daher mein bis dato kleinster Rechenknecht der mehr kann als ein Taschenrechner. Folgendes liegt in der Packung als Zubehör:

- SheevaPlug

- Dokumentations-CD (sind auch Flashimages drauf wenn man was kaputtgemacht hat!)

- Mini-USB Kabel

- 2 Meter Ethernet Kabel

- EU-Steckeraufsatz

- EU-Anschlusskabel (wer es einfach so wohin legen will)

Auch hierzu habe ich mal ein paar Bilder gemacht:

Software

Auf dem SheevaPlug läuft standardmäßig die ARM Variante von Ubuntu Jaunty Jackalope (Beta), welche meiner Meinung nach eher schlecht als recht installiert ist. Zum einen hat man bei jedem Bootvorgang Fehlermeldungen und auf der anderen Seite ist es natürlich keine LTS Variante!

Da es sich um Standard-ARM Hardware handelt kann man auch Debian oder eine andere Linux Distribution installieren. Man sollte nur beachten einen Kernel mit Version 2.6.30 oder höher zu verwenden!

Ich hab das lieblose Ubuntu welches auf dem Gerät ist (wirft viele Fehler beim booten, kein Support für Kernelmodule) gleich durch ein Debian ersetzt, dazu wird es hier aber demnächst noch einen Artikel geben.

Performance

Hier noch ein kleiner Überblick über die Leistungsfähigkeit der Hardware, natürlich wie immer mit dem eingebauten Benchmark von 7-zip: Die CPU hat also die Leistungsfähigkeit von ca. 2 Flepos, welcher aber auch nur einen 500 MHz AMD Geode hat. Klar sind die Werte kein Vergleich zu einem Intel Core 2 Duo, weshalb ich hier auf einen Vergleich verzichte.

Die CPU hat also die Leistungsfähigkeit von ca. 2 Flepos, welcher aber auch nur einen 500 MHz AMD Geode hat. Klar sind die Werte kein Vergleich zu einem Intel Core 2 Duo, weshalb ich hier auf einen Vergleich verzichte.

Fazit

Der SheevaPlug ist ein schönes Stück Hardware zu einem sehr angenehmen preis (~100€), durch die gute Hardware kann man es locker als Nachfolger vom NSLU2 sehen. Der Stromverbrauch von weniger als 5 Watt unter Volllast (ohne USB Devices) ist auch mehr als OK.

Auf viele weitere Details (z.B. auch der Zugriff über die miniUSB Schnittstelle) werde ich demnächst noch eingehen.