Nicht einmal ganz mehr ein Monat, dann startet der 16. LinuxTag. Vom 09. - 12. Juni versammelt sich wieder die Open Source Community auf dem Messegelände unter dem Funkturm in Berlin. Wie im vergangenen Jahr hab ich auch einmal wieder ein paar Freikarten zu vergeben. Also wer eine möchte, einfach mir eine Mail schicken mit dem Namen und Vornamen. Es gilt wer zuerst kommt, der mahlt zuerst, solange bis sie alle sind.

Nicht einmal ganz mehr ein Monat, dann startet der 16. LinuxTag. Vom 09. - 12. Juni versammelt sich wieder die Open Source Community auf dem Messegelände unter dem Funkturm in Berlin. Wie im vergangenen Jahr hab ich auch einmal wieder ein paar Freikarten zu vergeben. Also wer eine möchte, einfach mir eine Mail schicken mit dem Namen und Vornamen. Es gilt wer zuerst kommt, der mahlt zuerst, solange bis sie alle sind.

16. Mai 2010

Covergloobus – gespielter Song am Desktop ¶

Einige von euch kennen bestimmt das Programm “Screenlets” und das dazugehörige “Now-Playing-Screenlet”, über das ich schonmal hier in meinem Blog berichtet habe. Heute hab ich eine sehr gute Alternative gefunden. Mit Covergloobus kann man sich den aktuell gespielten Titel inklusive Cover am Desktop anzeigen lassen und den Mediaplayer außerdem noch sehr gut steuern (Wiedergabe pausieren, Titel bewerten, Titel vorwärts und Titel zurück). Das alles kann das Screenlet aber auch, doch Covergloobus hat noch mehr auf Lager. Auf Wunsch werden auch noch die Lyrics zum Titel agezeigt. Mit an Board sind auch sehr viele Skins. Hübsch und braucht auch nur 172kb im Speicher ;)

Installation:

1. sudo add-apt-repository ppa:gloobus-dev/covergloobus

2. sudo apt-get update && sudo apt-get install covergloobus

Das könnte dir auch gefallen:

- Kings of Leon – Use Somebody

- Singstar für PC – Ultra Star Deluxe kostenlos

- Audacity 1.3.7 – kostenloses Aufnahmeprogramm

Copyright © 2010 Dont copy without permission of www.pablo-bloggt.de (Digital Fingerprint: de5b9a1940bbb4ee5a332103e8c6711c)

© Pablo for Pablos Blog, 2010. |

Permalink |

Kommentar schreiben |

Add to

del.icio.us

Post tags: Covergloobus, Mediaplayer

Mal schnell was übersetzen… ¶

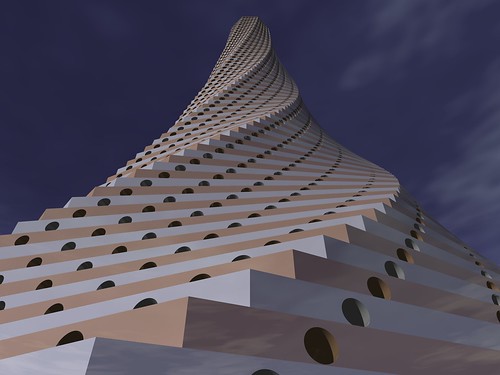

by fdecomite

by fdecomite

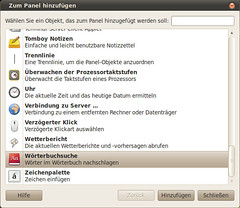

Die meisten Leuten mit nicht gerade perfekten Kenntnissen in Fremdsprachen kennen das Problem: Man stolpert beim Lesen über ein unbekanntes Wort und muß dieses nachschlagen. Nun könnte man dict.leo.org / dict.cc / * bemühen, per Firefox Plugin übersetzen, ganz stupide das Wort + ” deutsch” in Google tippen oder oldschool -mäßig in einem richtigen Wörterbuch suchen. Die genannten Möglichkeiten haben jedoch Nachteile, entweder ist es sehr langsam oder man muß für die Suche online sein :(.

Nach kurzer Recherche fand ich heraus, dass es erschreckend viele Lexika unter Linux gibt. Die Wörterbücher Seite im Wiki von ubuntuusers.de ist da ein guter Einstieg. Unterm Strich habe ich auch nichts anderes gemacht, als 2 verschiedene Tools, die im Wiki beschrieben sind miteinander zu kombinieren. Zum einen verwende ich ein ein Wörterbuch Modul von freedict, den dict Dämom und als “Frontend” das Gnome Wörterbuch (sollte per default installiert sein). Sehr schön am Gnome Wörterbuch ist die Möglichkeit es zum Panel hinzuzufügen:

Benötigt werden folgende Pakete – mir reicht Deutsch-Englisch, Englisch-Deutsch:

dictd dict-freedict-eng-deu dict-freedict-deu-eng dict-de-en

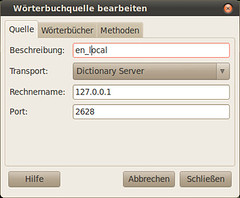

Wenn alles mit dem Tool Deiner Wahl installiert ist und der Dienst läuft, muß das Wörterbuch konfiguriert werden. Dazu wird eine neue Quelle angelegt die sich mit dem localhost verbindet:

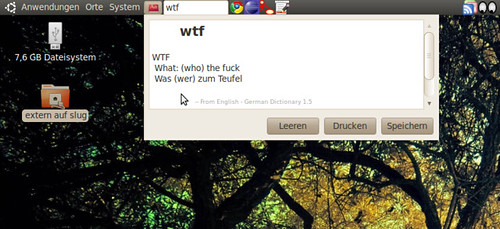

Das wars schon. Noch ein Bild von der Geschichte in Aktion:

Sehr schön :). Wenn zu einem späteren Zeitpunkt weitere Wörterbücher installiert werden, sollte man den Daemon einmal durchstarten. Fin.

Google Mail perfekt in Ubuntu Lucid integrieren ¶

Webmail-Dienste sind mittlerweile für viele Anwender eine ernste Alternative zu E-Mail-Programmen wie Thunderbird, Evolution und Co. geworden. Doch bei der Integration in den Desktop hakt es konzeptionell bedingt leider ordentlich. Keine Nachricht erscheint beim Eintreffen einer Mail auf dem Desktop, klickt man im Browser auf einem mailto-Link, dann startet der brachliegende Mail-Client und das neue Messaging Menu von Ubuntu Lucid bleibt natürlich auch ungenutzt. Doch für Ubuntu Lucid und Google Mail könnt Ihr diese Problematik praktisch vollständig lösen.

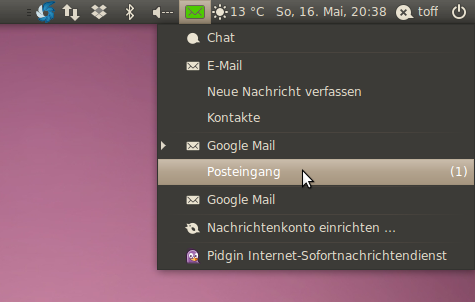

Zuerst möchte ich euren Blick auf gm-notify (oder auch auf Launchpad) lenken. Das kleine Programm integriert Google Mail in das neue Messaging Menu von Ubuntu Lucid. Dadurch werden euch eingehende Mails via Popup und “grünem” Mail-Icon angekündigt und ihr könnt Google Mail über einen Klick in das Menü starten. Ausserdem seht Ihr die Anzahl der ungelesenen Mails im Menü.

Das Programm hat es noch nicht in die offiziellen Paketquellen von Ubuntu geschafft, doch es gibt eine PPA-Paketquelle für Ubuntu Lucid, über die Ihr das Programm leicht installieren könnt.

$ sudo add-apt-repository ppa:gm-notify-maintainers/ppa $ sudo apt-get update && sudo apt-get install gm-notify

Nach der Installation findet Ihr die Einstellungen zu gm-notify unter “System -> Einstellungen -> GMail Notifier Konfiguration”, ein “richtiges” Programmfenster hat die Anwendung nicht, sie bohrt ja nur das Messaging Menu auf. Tragt hier euren Google Mail Account ein und vergesst nicht unter “Erweitert” die Option “Start automatically on logon” zu aktivieren, erst dann startet gm-notify automatisch. Leider ist es (noch) nicht möglich mehrere Accounts anzulegen, doch zumindest gibt es schon einen Bug-Report für diese fehlende Funktionalität.

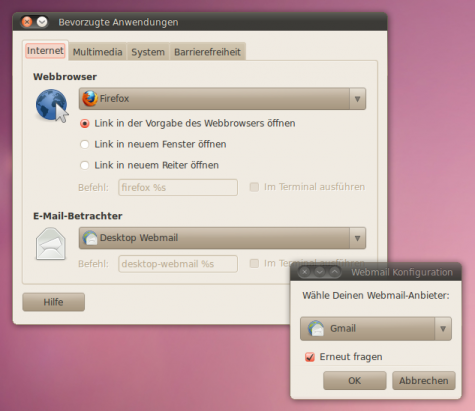

Als nächsten geht es um die Integration von mailto-Links in die Desktopumgebung. Das kleine Programm desktop-webmail (Es hat nichtmal eine Homepage) installiert so genannte Handler für mailto-Links für die Webmail-Dienste Google Mail, Hotmail, Yahoo und Zoho. Das Programm stammt aus dem Hause Canonical und wurde extra für Ubuntu Lucid geschrieben, Ihr findet es daher in den Quellen von Ubuntu. Über…

$ sudo apt-get install desktop-webmail

…installiert Ihr es. Stellt nach der Installation unter “System -> Einstellungen -> Bevorzugte Anwendungen -> E-Mail-Betrachter” auf “Desktop Webmail” um und wählt unter “System -> Einstellungen -> Desktop-Webmail” euren bevorzugten Mail-Anbieter aus. Danach sollten mailto-Links direkt in euren Browser inklusive dem Webmailer starten und auch gleich die Felder passend ausgefüllt werden.

Wacom Bamboo Pen Treiber unter Ubuntu 10.04 installieren ¶

Das neue Wacom Bamboo Pen unter Ubuntu 10.04 zum laufen bringen

Das neue Wacom Bamboo Pen unter Ubuntu 10.04 zum laufen bringen

Dieser Artikel beschreibt die Installation der Software der Bamboo “Pen-” oder “Pen and Touch-” (CTL-460) Grafiktablets von Wacom , welche unter Ubuntu 10.04 nicht out of the box laufen.

Installation

Als erstes wird ein Terminal geöffnet, da dieses für die gesamte Installation genutzt wird.

Es müssen neuere Kernel-Module installiert werden. Dazu wird in das Terminal folgender Code eingegeben:

sudo apt-get install build-essential libx11-dev libxi-dev x11proto-input-dev xserver-xorg-dev tk8.4-dev tcl8.4-dev libncurses5-dev

Nun wird der aktuellste Linux Wacom Treiber heruntergeladen (Momentan 0.8.6-2)

wget http://downloads.sourceforge.net/project/linuxwacom/linuxwacom/0.8.6-2/linuxwacom-0.8.6-2.tar.bz2?use_mirror=surfnet

Nach dem der Treiber heruntergeladen wurde, muss in das Verzeichnis gewechselt werden, indem das Paket “linuxwacom-0.8.6-2.tar.bz2″ gespeichert wurde.

Nach dem Wechsel in das Verzeichnis muss das Paket entpackt werden.

tar -xf inuxwacom-0.8.6-2.tar.bz2

In das entpackte Verzeichnis wechseln.

cd linuxwacom-0.8.6-2

Die Treiber müssen nun konfiguriert und ausgeführt werden. Dazu werden folgende Befehlszeilen nacheinander in das Terminal eingegeben.

./configure --enable-wacom

cd src/2.6.30/ # I know this is the wrong version, but it's the highest available and it works

make

sudo cp wacom.ko /lib/modules/`uname -r`/kernel/drivers/input/tablet/

sudo rmmod wacom

sudo modprobe wacom

Die Installation ist abgeschlossen und das Tablett kann nun an das System angeschlossen werden. Desweiteren können noch in die etc/modules der Module-Name eingetragen werden, damit der Kernel-Treiber des Tabletts beim Start automatisch geladen wird.

Media-Center mit Ubuntu ¶

Schon lange habe ich versucht ein Media-Center zu bauen. Meine Fotos, Musik und Videos stapelten sich immer mehr und so richtig präsentieren und geniessen konnte ich die Medien nur am PC. Als dann beim Discounter ein Fernseher mit 80cm Bilddiagonale günstig zu erwerben war, wurde mein Media-Center geboren.

Desktop Ubuntu 10.04 Netbook (minimal)

Voraussetzung: Die Voraussetzungen für mein Media-Center waren eher einfach. Ich wollte über das Internet Fernsehen, meine Videos im FLV Format anschauen und meine Bildersammlung vom zentralen Server anschauen können. Die Videos waren absichtlich im FLV Format gespeichert um Platz zu sparen. Auch das Streaming von den Webseiten war im FLV Format kein Problem.

Ausstattung

- LCD Fernseher mit 80cm Diagonale

- Ausus eee-Box

- Ubuntu Netbook 10.04

- Browser Chromium und xbmc Media-Center

Am Anfang stand natürlich die Installation der Hardware im Vordergrund. Ich entschied mich für das Schlafzimmer, da Fernsehen im Liegen viel angenehmer ist. In unserer Schlafkammer hat es leider keinen Kabelanschlusss und so musste ich wohl oder übel via Internet auf die Sender kommen. Das macht aber nichts, denn mit der heutigen Bandbreite ist es möglich über das Internet in die Ferne zu schauen. Ich habe viele Fernseh-Plattformen angeschaut und habe mich dann für die Frau von Fred Feuerstein entschieden. Wilmaa ist für mich die schnellste und qualitativ die beste Plattform für Internet-Fernsehen. Der Zusammenbau der Hardware hat eine Weile gedauert zumal ich den Fernseher an die Wand “nageln” musste, die eee-Box richtig platzieren und natürlich noch ein Internet-Kabel ziehen musste. Als die Hardware dann stand, konnte ich mich um die Software kümmern.

Software: Ich habe mich für Ubuntu 10.04 Netbook entschieden, da diese Version ziemlich gut mit der eee-Box zusammenarbeitet und eigentlich keine Probleme macht. Der Desktop ist auch gut aufgebaut da ich mein zukünftiges Media-Center auch vom Bett aus bediene. Ich habe den Desktop dann minimalistisch konfiguriert und somit dem Media-Center angepasst. Als Auflösung habe ich dann 848×480 gewählt. Diese Auflösung ist ideal für die Bedienung mit einer Maus und die Bildqualität der Fernsehsendungen ist wunderbar. Etwas Probleme machte noch der Browser. Mit dem Feuerfuchs gabs immer wieder mal Probleme mit der Geschwindigkeit. Auch war es nicht so einfach den Feuerfuchs zum Betrieb mit dem Vollbildschirm zu bringen. Als beste Lösung ergab sich dann hier der Chromium Browser. Er ist momentan der schnellste und einfachste Browser. Für den Vollbildschirm genügt der Start-Parameter –kiosk. Der erste Schritt war vollbracht, das Media-Center mit Wilmaa läuft wunderbar.

Das Media-Center: Als nächsten Schritt tastete ich mich mit verschiedenen Media-Center Software vor. Als bestes System ist mir xbmc ins Auge gestochen. Es lässt sich leicht bedienen und funktionierte immer. Die Software lässt sich leicht installieren und entsprechend konfigurieren.

xbmc mit der Benutzeroberfläche

Das xbmc ist auf eine einfache und klare Bedienung ausgerichtet. Die Konfiguration des System lässt sich sehr einfach anpassen. So kann man sehr einfach die Resourcen seiner Medien angeben. Auch das aktuelle und zukünftige Wetter kann man sich anzeigen lassen. Fazit: Mit Ubuntu 10.04 und xbmc lässt sich ein einfaches und schnelles Media-Center realisieren.

Hier noch einige Screenshots, weil sie so schön sind..

Ähnliche Artikel

Man stelle sich vor... ¶

Man stelle sich vor… ¶

Man stelle sich vor ein Publisher beschließt 4 (bzw. 5) seiner Spiele in einem Bundle zu verkaufen, dessen Preis der Spieler selbst festlegen darf. Nun sagt der Publisher wenn wir die eine Million Dollar Marke überschreiten, stellen wir diese vier Spiele unter eine Open Source Lizenz und veröffentlichen sie. Unwahrscheinlich? Ganz und gar nicht. Genau dies hat der Publisher Wolfire nämlich gemacht. Wer mehr darüber lesen möchte sollte diese Seite einfach mal besuchen ![]()

15. Mai 2010

KDE and the Masters of the Universe ¶

Ich habe beim Surfen mal wieder einen neuen Podcast gefunden, wie soll es sein relativ jung, die erste Episode ist gerade erst veröffentlicht. Der Podcast von Guillermo Amaral heißt “KDE and the Masters of the Universe” und wird sich ausschliesslich um Themen rund um das KDE Projekt und die KDE Software Compilation drehen. Geplant sind vor allem Interviews mit KDE Entwicklern. Die erste Episode enthält ein Interview mit Aaron Seigo. Ich bin schon gespannt, wie es da weiter geht.

Manchmal hätt’ ich gerne iTunes ¶

Ja, wirklich, und zwar dann, wenn es um die automatische Synchronisation von Podcasts, Videos und Musik geht und ich gerade schlechte Laune habe, weil ich mir den Nachmittag mit Suchen und Probieren um die Ohren gehauen habe. Werfen wir also mal kurz einen Blick in das iTunes Lager:

Sobald ich mein iPhone an iTunes anstecke, werden neue Podcasts auf das Gerät kopiert, auf dem Gerät oder auf dem Laptop gehörte Podcasts werden vom Gerät gelöscht, auf dem Laptop oder iPhone zum Teil gehörte Podcasts werden mit ihrer Abspielposition synchronisiert, auf dem Gerät gehörte Podcasts werden im iTunes als gehört markiert und so weiter und so fort. Außerdem wird die gesamte Musik- und Videosammlung gesynct, oder halt nur Teile davon, je nachdem wie man es vorher im iTunes eingestellt hat. Total komfortabel also: einstecken, warten, abziehen und auf dem neusten Stand sein – ohne Interaktion.

Unter Linux ist mir bis dato kein Weg bekannt, mein iPhone oder meinen iPod (oder irgendeinen anderen Mp3 Player, wobei das nur geraten ist) genauso bequem zu verwalten. Klar kann ich Musik, Videos und Podcasts auf das Gerät spielen, aber halt alles per Hand und manuell. Einzig gpodder hat einen Sync-Modus, welcher allerdings durch einen Bug in libgpod momentan für iPhone Benutzer unbrauchbar ist, und auch nicht automatisch synct.

Sicherlich ist iTunes nicht das Maß aller Dinge, aber leider noch sehr vieler…

Ein Script nach RESUME ausführen ¶

Mein Hörspielserver ist nur dann an, wenn ich ihn brauche. Sobald keine Musik mehr spielt, fährt die Kiste in Suspend to RAM (STR). Per Wake-On-Lan wecke ich sie bei Bedarf wieder auf. Leider ist es so, dass nach einem Resume ices2 nicht mehr läuft. Ich benötige also ein Script, welches nach einem Suspend icecast2 und ices2 wieder startet. Da ich das Startscript für icecast2 in /etc/init.d/icecast2 so angepasst habe, dass ices2 immer mitgestartet wird, genügt bei mir nach dem Resume ein

Ein Script nach RESUME ausführen ¶

Mein Hörspielserver ist nur dann an, wenn ich ihn brauche. Sobald keine Musik mehr spielt, fährt die Kiste in Suspend to RAM (STR).

Per Wake-On-Lan wecke ich sie bei Bedarf wieder auf.

Leider ist es so, dass nach einem Resume ices2 nicht mehr läuft. Ich benötige also ein Script, welches nach einem Suspend icecast2 und ices2 wieder startet. Da ich das Startscript für icecast2 in /etc/init.d/icecast2 so angepasst habe, dass ices2 immer mitgestartet wird, genügt bei mir nach dem Resume ein

sudo /etc/init.d/icecast2 restart

Der passende Ort für derlei Scripte ist /etc/pm/sleep.d/. Alle Scripte, die hier drin liegen, werden in alphabetischer Reihenfolge mit root-Rechten ausgeführt. Das Scriptkonstrukt ist dabei folgendes:

#!/bin/bash case "$1" in hibernate|suspend) AKTIONEN, DIE VOR DEM SUSPEND AUSGEFÜHRT WERDEN ;; thaw|resume) AKTIONEN, DIE NACH DEM RESUME AUSGEFÜHRT WERDEN ;; *) ;; esac exit $?

Für meinen Hörspielserver erstelle ich also ein ausführbares Script namens “99_restart_icecast2.sh“:

sudo touch /etc/pm/sleep.d/99_restart_icecast2.sh sudo chmod+x /etc/pm/sleep.d/99_restart_icecast2.sh sudo nano /etc/pm/sleep.d/99_restart_icecast2.sh

#!/bin/bash case "$1" in thaw|resume) /etc/init.d/icecast2 restart 2>/dev/null ;; *) ;; esac exit $?

Super Sache, jetzt funktioniert wieder alles wie gewünscht.

Keysigning-Party am LinuxTag in Berlin ¶

In knapp einem Monat beginnt in Berlin eine der wohl wichtigsten Veranstaltungen im Bereich Linux und OpenSource. Der LinuxTag, welcher dem Namen nach zu urteilen nicht nur ein Tag dauert, sondern sich vom 9. bis 12. Juni 2010 erstreckt und in der Messe beim Funkturm zu Berlin stattfindet. Bisher war es mir aus geschäftlichen Gründen nie möglich, an dieser Veranstaltung vor Ort zu sein. Dieses Jahr wird es klappen und ich darf am Stand und an weiteren Orten innerhalb der Messe für RadioTux mitwirken.

Am LinuxTag sind die “führenden Läden” aus unserer Zunft als Aussteller und Aktivisten vor Ort, es gibt ein reichhaltiges Programm und natürlich auch wieder die Möglichkeit, LPI-Prüfungen und andere Zertifizierungen abzulegen. Es wird auch wieder eine Linux-Nacht geben und die Veranstaltung wird an den Abenden durch diverse Partys und Feste gesäumt. Besonders freut mich, dass wir bei RadioTux pro Tag je einen Themenschwerpunkt bilden; der Samstag fällt auf Ubuntu. Unser Bürgermeister läuft auf voller Kraft voraus und stellt die Termine für Interviews und Programmpunkte zusammen. Ich komme in einem späteren Artikel darauf zurück.

Eingebettet in diese Veranstaltung – besser könnte es wohl gar nicht passen – erblickt eine Keysigning-Party das Licht der Messe. Karlheinz Geyer, den ich von der Keysigning-Party zu Zürich kenne, wirkt als Zeremonienmeister und bringt die Menschen in Berlin zusammen, die ihren GPG-Schlüssel gegenseitig unterschreiben wollen. Die Keysigning-Party in Berlin startet am Freitag, den 11. Juni um 14:00 Uhr und wird wohl gegen die zwei Stunden andauern. Auf der Wiki-Seite sind die nötigen Informationen zur Anmeldung und Mitwirkungen vorhanden, bis zum 6. Juni 2010 um Mitternacht kann man sich online zur Party anmelden.

Eingebettet in diese Veranstaltung – besser könnte es wohl gar nicht passen – erblickt eine Keysigning-Party das Licht der Messe. Karlheinz Geyer, den ich von der Keysigning-Party zu Zürich kenne, wirkt als Zeremonienmeister und bringt die Menschen in Berlin zusammen, die ihren GPG-Schlüssel gegenseitig unterschreiben wollen. Die Keysigning-Party in Berlin startet am Freitag, den 11. Juni um 14:00 Uhr und wird wohl gegen die zwei Stunden andauern. Auf der Wiki-Seite sind die nötigen Informationen zur Anmeldung und Mitwirkungen vorhanden, bis zum 6. Juni 2010 um Mitternacht kann man sich online zur Party anmelden.

GPG ist die freie Variante von der asynchronen Verschlüsselung PGP und lebt vom gegenseitigen Vertrauen (Web of Trust). Je mehr Menschen einen Schlüssel einer eindeutig bestimmten Person zuweisen, um so vertrauenswürdiger wird jener Schlüssel und damit die Sicherheit, dass der Schlüssel zu jener Person gehört. Diese Sicherheit wird vererbt, so dass das Web des Vertrauens auch wirklich wachsen kann. Die Bestätigung, dass ein Schlüsselpaar zu einer Person gehört, wird mit Ausweispapieren erlangt. Es ist also notwendig, dass die Teilnehmer an der Keysigning-Party einen amtlichen Ausweis auf sich tragen, sonst kann die Bestätigung nicht erfolgen.

Es ist zu erwarten, dass an dieser Veranstaltung auch zertifizierte CAcert-Notare vor Ort sein werden, welche CAcert-Zertifikate beglaubigen können. An dieser Stelle bedeanke ich mich bei Karlheinz für die Organisation und Durchführung!

Ähnliche Artikel

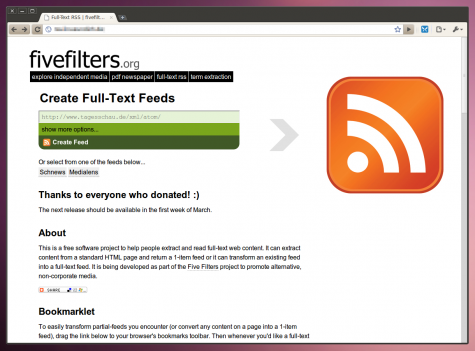

Vollständige RSS-Feeds mit Content-Only ¶

Viele Nachrichten-Seiten oder Blogs bieten News-Feeds im RSS oder Atom-Format an, doch nicht alle liefern einen vollständigen Feed aus. Oft enthält der Feed nur einen Teaser mit den ersten paar Zeilen des Beitrages. Um den kompletten Inhalt des Beitrages zu lesen, muss man seinen News-Reader verlassen und die Seite im Webserver öffnen. Die Logik dahinter: Mehr User auf der Webseite, mehr Klicks auf die Werbung. Für Leute, die sehr viele News-Feeds lesen (müssen), sind solche verstümmelte Feeds leider meist recht nervend, da sie mehr Arbeit kosten.

Content-Only ist ein unter der GPL lizenziertes Projekt, das kastrierte Feeds vervollständigen und wieder als Feed ausliefern kann. Diesen Feed kann man dann mit einem beliebigen RSS-Aggregator wie Liferea, Google Reader und Co. abrufen. Man bedient sich dabei PHP, Readability, SimplePie und FeedWriter. Readability spielt hier den essentiellen Part, da es den Inhalt aus den verlinkten Webseiten extrahiert. Content-Only ist dabei nur ein Part des Five Filters Projekt, schaut euch ruhig mal die restlichen Projekte an.

Five Filters hostet den Dienst auf der Projektseite, dort kann man URLs zu Newsfeeds eintragen und sich auch die Feed-URLs erzeugen lassen. Allerdings enthalten die auf Five Filters generierten Feeds zur Schonung der Ressourcen nur die letzten vier Beiträge. Für Nachrichten-Seiten mit hoher Schlagzahl ist das leider zu wenig. Daher bieten die Macher gegen 10$/Monat an die Feeds auf die letzten zehn Beiträge aufzubohren.

Alternativ – und das ist die interessante Option – kann man Content-Only auf seinem eigenen Webspace hosten. Für den eigenen Gebrauch braucht Content-Only nicht viele Ressourcen. Man benötigt weniger als 1MB Webspace und PHP 5.2, eine Datenbank kommt nicht zum Einsatz. Den Quellcode bekommt Ihr via Bazaar von launchpad.net heruntergeladen. Auf einem Ubuntu-System bspw. via.

$ sudo apt-get install bzr $ bzr branch lp:~keyvan-k1m/fivefilters/content-only

Danach muss man den Inhalt des Verzeichnisses content-only nur noch auf seinen Webspace hochladen. Optional kann man die config-sample.php noch in config.php umbenennen und an die eigenen Bedürfnisse anpassen. Im Feed-Reader sieht dann ein nachträglich komplettierter Feed etwa so aus.

Links sieht man den herkömmlichen Feed, rechts den mittels Content-Only erweiterten. Ich habe zum Spaß ein paar populäre Feeds getestet und konnte durchweg gute Ergebnisse erzielen. Ach ja, das Projekt ist auf der Suche nach Spenden, schaut also mal auf die Homepage.

14. Mai 2010

855GM-Patchdateien für aktuelle Kernel ¶

Gestern sind die beiden Kernelversionen 2.6.32.13 und 2.6.33.4 erschienen. Da mein zurückportierter 855GM-Patch nur mit den Lucid-Kernelversionen “2.6.32-21″ bzw. “2.6.32-22″ funktioniert, habe ich mir mal die Mühe gemacht und den Patch auf die beiden Vanilla-Kernelversionen “portiert” (Reine Copy’n Paste-Aktion) :

fix-i8xx-gtt-cache-coherency-v9-2.6.32.13.patch

fix-i8xx-gtt-cache-coherency-v9-2.6.33.4.patch

Da sich die beiden Patches nur durch Änderungen in der Datei “intel-agp.c” (Die Änderungen im i915-Treiber sind identisch) unterscheiden, sollte sich der Patch für die 32er Kernelversion auch auf eine zukünftige Lucid-Kernelversion anwenden lassen. Wann eine solche Version erscheinen wird, steht aber noch in den Sternen.

Der (Ur-)Verzeichnisdienst NIS / YP ¶

Noch bevor LDAP oder Kerberos sich etablieren konnten, war ein Verzeichnisdienst mit dem Namen YP für Yellow Pages und später NIS für Network Information Service in aller Munde. Es war ein Produkt entwickelt von Sun, wodurch man Logininformationen über mehrere Computer hinweg verteilen konnte.

Auch wenn NIS als älter und unsicherer gilt als LDAP, hat es für mich ein klarer Vorteil: es ändert sich nicht immer komplett!

Wer schon mal ein LDAP auf einem Ubuntu Server 8.04 und 8.10 installiert hat, kann nachvollziehen was ich meine. So und damit genug, ich will hier nicht über LDAP herziehen, sondern NIS vorstellen ![]()

Ich habe mir also mit NIS und NFS innert wenigen Minuten eine zentrale Benutzerverwaltung mit zentralem Homeverzeichnis eingerichtet. Und wie das geht, folgt hier:

Ich habe mit dem NIS Server begonnen und dazu die Pakete für NFS und NIS aus den Paketquellen installiert.

1 | apt-get install nfs-kernel-server nis |

Während der Installation, nachdem man einen Namen für die Domäne eingegeben hat, versucht apt automatisch den NIS Daemon zu starten, was auf Grund mangelnden Einstellungen aber nie funktionieren wird. Also zurück lehnen, und auf den Fehler warten ![]()

Nun beginnt die Konfiguration. In der Datei /etc/default/nis wird die NIS-Installation von Client zum Server umgebogen:

1 2 3 4 | # Are we a NIS server and if so what kind (values: false, slave, master)? NISSERVER=true # Are we a NIS client? NISCLIENT=false |

Dann geben wir in der Datei /etc/exports unser Homeverzeichnis frei:

1 | /home *(rw,async,no_subtree_check) |

Wer es gern sicherer hat, kann den Stern durch einen Computernamen oder eine IP mit Subnet ersetzen, wodurch dann nur der Zugriff von diesen Maschinen aus gestattet ist.

Nun kann man den Daemon neu starten:

1 | /etc/init.d/nis restart |

Und zum Abschluss muss man noch die Maps generieren lassen. Dazu ruft man folgenden Befehl auf:

1 | /usr/lib/yp/ypinit -m |

Nun ist der NIS Server soweit fertig. Es können nun normal User hinzugefügt werden, die bereits bestehenden werden im NIS aufgenommen.

Wichtig jedoch, nach einer Änderung an einem User oder einer Gruppe, also Änderungen, welche die passwd, group, shadow oder gshadow datei verändern, folgender Befehl ausgeführt wird, um die Maps zu erneuern:

1 2 | cd /var/yp/ make |

Nun noch alle benötigten Daemons neu starten:

1 2 3 | /etc/init.d/portmap restart /etc/init.d/nfs-kernel-server restart /etc/init.d/nis restart |

Und zum Schluss die Verwendung des NIS Servers starten:

1 2 | ypbind ypserv |

Ein Aufruf von ypwhich sollte nun den Namen oder die IP des NIS Masterserver und ypdomainname den Namen der NIS Domäne ausgeben.

Nun muss der Client, welcher NIS verwenden soll, noch vorbereitet werden!

Auch hier wird das Paket NIS aus den Paketquellen installiert:

1 | apt-get install nis nfs-common |

Im Gegensatz zu vorher sollte sich hier der NIS Daemon nach Eingabe der selben Domäne erfolgreich starten, da der NIS Server über Broadcast-Pakete gesucht wird.

Trotzdem sollte der NIS Server noch fest in die Datei /etc/yp.conf eingetragen werden:

1 | ypserver nismaster.ch |

Nun müssen noch die passwd, group, shadow und gshadow angepasst werden und jeweils folgenden Zusatz als letzte Zeile haben:

/etc/passwd:

1 | +:::::: |

/etc/group:

2 | +::: |

/etc/shadow:

3 | +:::::::: |

/etc/gshadow:

4 | +::: |

Nachdem der Client nun die Userinformationen vom NIS Server verwenden kann, muss noch das Homeverzeichnis konfiguriert werden.

Dazu wird die Datei /etc/fstab mit folgender Zeile ergänzt:

1 | nismaster.ch:/home /home nfs rsize=8192,wsize=8192,hard,intr 0 0 |

Nun sollte auch hier noch der NIS Daemon neugestartet werden:

1 | /etc/init.d/nis restart |

Wird nun ypwhich und ypdomainname ausgeführt, so sollten deren Ausgaben mit denen vom Server übereinstimmen.

Wenn nun der Client nun gestartet wird, so sollte beim Start zuerst das home-Verzeichnis vom Server gemountet werden und danach eine Verbindung zum NIS Server mit der konfigurieren Domäne hergestellt werden, worauf man sich dann mit jedem auf dem Server zugefügten Benutzer auch auf dem Client einloggen kann.

Über die Balance von Stabilität und Aktualität in Ubuntu ¶

Die Frage, ob stabile, aber ältere oder neuere, aber instabilere Pakete ausgeliefert werden sollen, beantwortet jede Distribution unterschiedlich. Bei Debian Stable kommt die Distribution raus, wenn sie fertig ist, und dann werden nur noch Bugfixes eingespielt, und das jahrelang. Bei Arch Linux hingegen wird auf einen Rolling-Release-Zyklus gesetzt, die Pakete werden ständig auf die jeweils aktuellste Version gehoben.

Ubuntu hingegen hat bisher einen Mittelweg praktiziert: Alle sechs Monate kommt eine neue Version raus, die zugehörigen Paketquellen werden eingefroren und wie bei Debian nur noch mit Bugfixes und Sicherheitsupdates versorgt, neuere Major-Releases der Programme gibt es erst in der nächsten Version. Bisher hat dies meiner Meinung nach recht gut funktioniert, wer tortzdem aktuellere Pakete wollte, der konnte Fremquellen benutzen.

Aber mittlerweile läuft da einiges schief. Beim aktuellen Release (das auch noch eine LTS ist) wurde etwa das Videoschnittprogramm PiTiVi integriert, dass sich immernoch in Entwicklung befindet und einige notwendige Features nicht beherrscht, teilweise noch viele Bugs hat. Hier gäbe es mit OpenShot eine ausgereiftere und stabilere Alternative. Dann wird KMS sowie Nouveau verwendet, ersteres führt bei mir zu einer langsamen Performace bei 3D, nach der Deaktivierung funzt die Performance wieder, dafür funktioniert GDM nicht mehr richtig (Blackscreen). Korrekterweise kommt Kernel 2.6.32 zum Einsatz, dafür werden Treiber und Features aus 2.6.33 zurückportiert. GIMP, ein erprobtes und zuverlässiges Programm, wird einfach entfernt (aus der Standardinstallation). Seit Lucid befindet sich auch Chromium in den Quellen, ein durchaus guter und vernünftiger Browser, leider im Beta-Status, die Version in den Paketquellen wird auch nicht geupdatet.

Jetzt lese ich hier bei OMG! Ubuntu!, dass F-Spot in 10.10 entfernt und stattdessen Shotwell eingesetzt werden soll. Über Shotwell habe ich schon einmal geschrieben, mir persönlich hat die Software gefallen. Allerdings ist die Software in einem noch frühen Stadium, so werden z.B keine PNGs unterstützt und es nicht möglich, Tags in die Metadaten zu schreiben, wodurch ein Wechsel zu einem anderen Programm mehr als schwierig wird. Gegen F-Spot spricht eigentlich nur die langsame Performance, was aber in Lucid bei mir besser geworden ist – könnte eine Nebenwirkung des Grafikkarten-Problems sein.

Ich bin der Meinung, dass man diese Strategie überdenken sollte: Ein Rolling-Release-Zyklus wäre wohl nicht so ideal, da Ubuntu ja halbwegs stabil und für den Endanwender geeignet sein will, und eine Debian-ähnliche Strategie würde die Distribution nicht interessant genug machen. Grundsätzlich finde ich die 6-Monate-Strategie gut, aber dann sollte man auch wirklich stabile Versionen in die Paketquellen legen und innerhalb der Support-Zeitraums aktualisieren, Aber Beta-Versionen in eine LTS zu integrieren und dann 3 Jahre lang diese Beta zu benutzen, ist quatsch. Die Entwickler des Programms werden wohl kaum diese Beta mit Sicherheitsupdates versorgen, wenn es schon eine neue Beta, RC oder vielleicht schon eine Final gibt.

Warum nicht die Backports besser ausnutzen? In die normalen Quellen kommt die jeweils aktuelle finale Version, während in den Backports die neuesten Versionen von beliebten Programmen bereitgehalten werden (so wollen viele Nutzer eine neue Firefox-Version benutzen, aber nicht aufs nächste Release warten). So könnte der Nutzer das Stabilitäts-Aktualitäts-Mischungsverhältnis ein wenig selbst justieren.

Das grml-Monster und seine Zähne ¶

Einer der wohl bekanntesten Rettungsanker nebst Knoppix dürfte wahrscheinlich grml sein. Die Debian-basierende Distribution, welche dereinst auf Knoppix aufsetzte, wurde just vor einigen Tagen in der neuen Version 2010.04 veröffentlicht. Am 22. Oktober 2004 erblickte grml offiziell das Licht der Bits und Bytes. Die erste Version mit der Nummer 0.1 hiess damals OS 04.

grml gibt es als 32- und 64bit-Version, nebenher als Medium oder Small-Edition mit mehr oder weniger Tools und Programmen auf dem Datenträger. Da grml hauptsächlich als Rettungswerkzeug benutzt wird – und man bei der Installation auf die Harddisk gefragt wird, ob man wisse, was man tue – ist das Linux konsequenterweise als Live-CD erhältlich; das ISO lässt sich natürlich auch auf einen USB-Stick “brennen”. Die aktuelle Version trägt den “Übernamen” grml-Monster. Die Liste der vorhandenen Applikation ist recht umfangreich; hier bemerkt man die Vererbung von Debian. Übrigens hiess die Version 2008.11 “Schluchtenscheisser”.

grml ist vor allem für System-Administratoren interessant und eher weniger geeignet, um damit am Rechner zu arbeiten. Das ginge wohl auch, aber die Entwickler, welche allesamt Familiennamen aus unseren Breitengraden tragen, setzen offenbar ganz bewusst auf die Fähigkeiten, ein defektes System zu retten. Ausserdem sei das Linux für Benutzer geeignet, die gerne im Textmodus wirken.

Grml is a bootable live system (Live-CD) based on Debian. Grml includes a collection of GNU/Linux software especially for system administrators and users of texttools. Grml provides automatic hardware detection.

Beim Start vom grml wird zunächst die Hardware durchsucht und sehr oft sauber erkannt. Bereits mit auf der CD (Version Release grml64 2010.04 – Codename Grmlmonster) sind diverse Arbeitsumgebungen wie fluxbox, ion, twm, fvwm-crystal oder wmii vorhanden und können, sofern das Bootmedium die richtigen Konfigurationsdateien enthält, direkt ab dem grml-Startbildschirm gestartet werden. Ich nutzte nach dem Bootvorgang die Taste c, worauf sich dann automatisch das Tastaturlayout für die Schweiz eingerichtet hat.

Es existiert ein deutsches Handbuch zu grml, welches allerdings eher die Meta-Themen behandelt und weniger auf den Betrieb von grml eingeht. Und natürlich bestehen weitere Dokumentationen zu diesem Rettungssystem, in denen in englischer Sprache die relevanten Informationen zum Betrieb von grml zu finden sind. Ausserdem ist ein Wiki (Doku-Wiki) verfügbar, in dem weitere, vertiefende Informationen, aber auch das Bug-Tracking zu finden sind.

Eine weitere, besonders interessante Eigenschaft von grml ist die Verwendung von Zsh. Auf der Bücherliste sind dazu auch einige Fachbücher zu diesem Thema verlinkt. Die Z-Shell oder eben die Zsh ist ist eine Unix-Shell, die sowohl als interaktive Login-Shell, als auch als ein mächtiger Kommandozeileninterpreter für Shellskripte verwendet werden kann. Sie nutzt einen etwas gewöhnungsbedürftigen Syntax, ist aber umso mächtiger. Dazu gibt es eine eigene Wiki-Seite. Es gibt auch unter Ubuntu eine Möglichkeit, die Zsh zu nutzen. Bei Bedarf lässt sich aber unter grml auch eine andere Shell nutzen, so zum Beispiel die Bash.

Ebenso spannend und eher etwas ungewöhnlich, dafür aber sehr praktisch, ist die Werkzeugkiste namens Cdrtools, die mitgeliefert wird. Damit lassen sich diverse Aufgaben rund um das Brennen von CDs und DVDs erledigen. grml ist wohl einer der wenigen Distributionen, die auf einer LiveCD das Tool führt.

Das Logo der aktuellen Version bildet ein Monsterli ab, ein freundliches zwar, aber es besitzt ganz beachtliche Zähne. Und diese sind dann auch spürbar, wenn man es sich weniger gewohnt ist, mit der Z-Shell zu arbeiten. Ganz so einfach ist es nicht, obschon sich die Einarbeitungszeit lohnen dürfte, will man grml als Rettungsanker nutzen. grml ist sicherlich keine Linux-Distribution für Anfänger oder Liebhaber einer grafischen Arbeitsumgebung. Das will sie auch nicht sein, sondern konzentriert sich auf Rettungen und dient GUI-Allergikern als Spielweise oder Arbeitsinstrument.

Mika Prokop schrieb im August 2009 einen recht interessanten und ergiebigen Beitrag zu grml auf der Linux Community. Auf der Projekt-Website von grml sind weitere Medienberichte zu grml aufgelistet, dabei ein eigener Bereich für deutsche Artikel.

grml lässt sich direkt ab der Projekt-Website herunterladen. Falls kein Breitband-Internet zur Verfügung steht, kann eine CD bei der Tuxpost gegen drei Euronen plus Versandkosten bestellt werden.

Ähnliche Artikel

Quassel IRC Menü wieder herstellen ¶

Quassel IRC Menü wieder herstellen ¶

Nach dem Start von Quassel IRC stellte ich fest das die Oberfläche irgendwie anders aussah. Es fehlte die Menüleiste. Doch wie bekommt man diese wieder zu Gesicht? Dies geschieht einfach indem man in der Anwendung Strg + m drückt. Daraufhin erscheint die Leiste wieder und alles sieht wie gewohnt aus.

rt2860 Wlan-Problem mit mixed WPA bei lucid ¶

Vor wenigen Tagen wurde Ubuntu 10.04 Lucid Lynx veröffentlicht. Dort hat sich ein Fehler im Wlan-Treiber für den häufig in Netbooks (z.B. in vielen EEE PCs) eingesetzt Chipsatz rt2860 eingeschlichen.

Will man in ein Wlan verbinden, dass mit WPA mixed verschlüsselt ist (also WPA / WPA2), bricht der Network-Manager relativ schnell ab und verlangt nach einem neuen Passwort.

Das Problem hat bei Launchpad auch schon zu einer langen Diskussion geführt (fast 200 Kommentare).

Dort werden auch ein paar Lösungen beschrieben.

Man kann beispielsweise einen neuen Treiber manuell installieren oder einen (inoffiziellen) gepatchten Kernel verwenden.

Als dritte Möglichkeit kann man einen aktuelleren Mainline-Kernel installieren.

Diese werden vom Ubuntu-Kernel-Team seit einiger Zeit angeboten. Diese enthalten jedoch keine großen ubuntuspezifischen Anpassungen.

Man sollte sich bevor man diese Lösung wählt im Ubuntuusers-Wiki über Mainlinekernel und Fremdpakete / Fremdquellen informieren.

Achtung: Es gibt keinen Support für die Mainline-Kernels; es kann zu Problemen führen; man erhält keine automatischen Updates und muss sich somit selbst darum kümmern!

Daher sollte man also nur zu Mainline-Kernels wechseln, wenn man wirklich weiß was man tut.

Das Installieren eines passenden Mainline-Kernels der dieses WLan-Problem löst ist recht einfach. Man kann sich einen passenden Kernel beispielsweise von http://kernel.ubuntu.com/~kernel-ppa/mainline/v2.6.33.3-lucid/ herunterladen.

Man sollte zu dieser Lösung nur greifen, wenn man sich wirklich mit den Problemen und Gefahren auskennt. Im Zweifelsfall sollte man lieber einige Tage warten bis das Problem per Software-Update (hoffentlich) gelöscht wird.

Bei meinem Netbook funktioniert der passende Mainline-Kernel bis jetzt ohne Probleme. Ob dies mit anderer Hard- und Software genauso problemlos funktioniert weiß ich jedoch nicht.

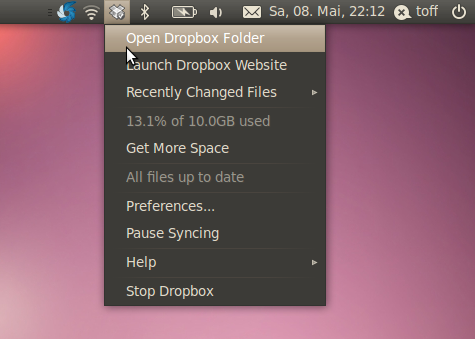

[UPDATE] Dropbox in Grau ¶

Im experimentellen Zweig von Dropbox wurden zwei Neuerungen eingeführt, die Anwender von Ubuntu Lucid 10.04 freuen werden. Zum einen arbeitet Dropbox nun als Indicator Applet und zum Anderen gibt es nun endlich die Möglichkeit das Aussehen des Dropbox-Icons anzupassen. Somit passt sich Dropbox deutlich besser in den Desktop von Lucid ein.

Die Beta könnt ihr aus dem Forum von Dropbox herunterladen. Zur Einfachheit füge ich hier die Links ein…

- Linux 32bit: dropbox-lnx.x86-0.8.55.tar.gz

- Linux 64bit: dropbox-lnx.x86_64-0.8.55.tar.gz

Beendet danach Dropbox über das Menü des Programmes, entpackt das heruntergeladene Archiv direkt in eurem Homeverzeichnis (Nautilus, Rechtsklick auf das Archiv und “Hier entpacken”) und startet dann Dropbox via…

$ nohup ~/.dropbox-dist/dropbox &

…nun sollte Dropbox wieder in eurem Panel erscheinen.

Um nun die Icons anzupassen schaut nach ~/.dropbox-dist/icons. Dort sind die Icons im png-Format hinterlegt. Ich habe zum Spaß die aktuellen Icons in Grau eingefärbt, so passen sie sich gut in Lucid ein. Um euch die Arbeit zu ersparen habe ich “meine” Icons unter dropbox_grau.tar.gz hochgeladen. Ladet euch das Archiv herunter, entpackt die Icons nach ~/.dropbox-dist/icons und startet dann Dropbox wie oben beschrieben neu.

[UPDATE 14.5.]Es gibt eine neue Version des experimentellen Zweigs von Dropbox. Wer die alte experimentelle Version einsetzt, sollte auf jeden Fall Dropbox aktualisieren. In der Linux-Variante wurden eine Reihe von Bugs gefixed, so dass das Indicator-Icon nun zuverlässiger erscheint. Für Faule wieder die direkten Links…

- Linux 32bit: dropbox-lnx.x86-0.8.57.tar.gz

- Linux 64bit: dropbox-lnx.x86_64-0.8.57.tar.gz

Schaut auch mal auf gnome-look.org vorbei, dort sind mittlerweile zahlreiche Icon-Sets für Dropbox eingegangen.[/UPDATE]

13. Mai 2010

T-Shirt-Aktionen sind in! ¶

Nach 3D Supply gibt es nun eine weitere Möglichkeit, kostenlos Werbung zu machen… äh… ein T-Shirt zu bekommen. ![]() Dieses Mal von customgarment.de. Und für ein solches T-Shirt macht man doch gerne etwas Werbung.

Dieses Mal von customgarment.de. Und für ein solches T-Shirt macht man doch gerne etwas Werbung.

Edit: Leider ohne Erfolg und auch der Link zum T-Shirt funktioniert nicht mehr. ![]()

Kleine Helferscripte: smxi ¶

smxi ist eine Scriptsammlung, welche einem das Leben erleichtern kann. Es unterstütz einen z. B. bei der Installation des neusten Grafikkartentreibers, Kernels oder bei der Installation von extra Software. Die derzeit unterstützen Distributionen sind Debian inkl. dessen Derivaten wie Sidux, Mepis etc., nicht aber Ubuntu und neu hinzugekommen ist Archlinux.

Die Installation des Scripts ist ausführlich auf der Homepage beschrieben. Folgende Funktionen werden einem anschließend geboten:

System Upgrades

Kernel Upgrades

Upgrade Warnungen

Automatische (propritäre) Grafikkartentreiberinstallation (mit evtl. benötigten Patches)

Installation von Extrasoftware (z. B. für Server)

Deinstallation von Software

Aufräumen des Systems (Kernel-Deinstallation etc.)

Optimierung des Systems (Mozilla-Einstellungen, etc.)

Und noch einiges durch zusätzliche Scripte

Gerade bei Rollingrelease-Distributionen kommen einem die Funktionen der Scripte entgegen. Es nimmt einem die Gefahr von nicht benutzbaren Systemen ab (Debian Sid) und hiflt einem bei der installation der Grafikkartentreiber nach jedem Xorg-Update. Aber smxi war auch schon Gegenstand eines Streits in der Sidux-Community, BlueLupo hat das in seinem Blog zusammengefasst. Wenn ich mich recht entsinne begann der Streit wegen ungeklärten Lizenzstreitigkeiten.

Man muss sich natürlich im Klaren darüber sein, dass jede installierte Software/jedes Script, das nicht aus den Distributionsrepos installiert wurde, das System gefährdet. Deshalb sollte jeder für sich entscheiden ob er diese/dieses für sich installiert.

Ubuntu Keyserver offline ¶

Immer wieder stelle ich fest, dass der Ubuntu Keyserver keyserver.ubuntu.com entweder offline ist oder bei einer Abfrage in einen Timeout gerät. Falls ein Schlüssel einer fremde Quelle für Software benötigt wird, ist das lästig. Man kann zwar die Software trotzdem installieren, aber es erscheinen dann berechtigte Warnungen. Immerhin bilden die Angaben zu Fremdquellen meiner Meinung nach das grösste Loch in der Sicherheit bei Ubuntu oder bei einer Linux-Distribution. Alternativen zu diesem Keyserver gibt es einige, da die Inhalte offenbar unter den Servern synchron gehalten werden. Gefunden habe ich dazu:

- hkp://keys.nayr.net

- http://keys.gnupg.net

- hkp://subkeys.pgp.net

- hkp://pgp.mit.edu

Kennt Ihr noch weitere solcher Server oder gibt es grundlegend eine andere Möglichkeit, an die Schlüssel zu kommen?