Die neuerliche Gratis-Aktion des Herstellers Softmaker nimmt Pinguinzubehör zum Anlass, das Programm einmal vorzustellen. Die Nürnberger Softwareschmiede hat mit „Softmaker Office“ eine komplette Office-Suite im Angebot, neben dem Schreibprogramm „Textmaker“ ist mit Planmaker noch eine Tabellenkalkulation sowie mit Presentations eine Powerpoint-Alternative enthalten.

Das Besondere ist, dass Softmaker Office sowohl für Windows als auch Linux verfügbar ist. Vorbildlich: die Software steht für Linux wahlweise als Debian/Ubuntu-Paket, als RPM-Datei oder TarGz-Archiv zur Verfügung.

Das Schreibprogramm der Wahl unter Linux ist normalerweise OpenOffice-Writer, ganz einfach aus dem Grund, weil es von nahezu allen Distributionen als Standard für die Textverarbeitung vorinstalliert ist. Nur auf kleineren Distributionen für schwächere Rechner kommt manchmal Abiword als Alternative zum Zuge. Beides sind quelloffene Programme. Mit Textmaker gesellt sich noch eine proprietäre Alternative hinzu. Mancher wird sich daher fragen, welche Gründe es geben kann, sich eine kommerzielle Alternative auf seinem Linuxsystem zur Textverarbeitung zu installieren. Um es gleich zu sagen: es gibt sie.

Das Programm

Doch werfen wir zunächst einen Blick auf das Erscheinungsbild: Der erste Eindruck ist der eines schicken, übersichtlichen Programmes. Textmaker 2008 integriert sich nicht in die gängigen Linux-Desktops, es gibt weder eine Anpassung an KDE noch an GNOME. Das Programm zeigt sich in seinem eigenen, silber-grauen Stil mit seeblauen Menübalken (eine Optik, die den alten KDE-2-Standardstil imitiert), was ausgerechnet unter Ubuntu etwas merkwürdig wirken kann.

Unter Windows übernimmt Textmaker hingegen die Systemfarben. Anpassen kann man unter Linux lediglich die Dialog-Stile. Neben „Linux“, sprich KDE 2, sind auch „Vista“, „XP“ oder „Windows95“ verfügbar.

Auch einen eigenen Dateiauswahl- und Druckdialog bringt Textmaker mit.

Der Dateiauswahldialog

Dafür beherrscht Textmaker echtes MDI (also das Öffnen und Anordnen mehrerer Dokumente in nur einem Programmfenster) – eine Funktion, die es in OpenOffice schon lange nicht mehr gibt.

Mehrere Dokumente in einem Fenster

Kantengeglättete Schriftarten beherrscht Textmaker im Dokumentenbereich, nicht jedoch in der Programmoberfläche selbst. Die Menüzeile und die Symbolleisten sind permanent sichtbar, jedoch übersichtlich mit den wichtigsten Funktionen bestückt und wirken nicht überladen. Die Symbolleisten lassen sich über ihr Kontextmenü bequem nach den eigenen Bedürfnissen anpassen.

Textmaker merkt sich beim Schließen des Programmes den eingestellten Vergrößerungsgrad eines Dokumentes, nicht jedoch die Position des Cursors, wie es etwa OpenOffice beherrscht.

Textmaker merkt sich beim Schließen des Programmes den eingestellten Vergrößerungsgrad eines Dokumentes, nicht jedoch die Position des Cursors, wie es etwa OpenOffice beherrscht.

Die Funktionen

Das DOC-Format spielt unter Linux traditionell keine große Rolle, doch selbst wenn man persönlich ganz darauf verzichtet, lebt man nicht allein im Universum und erhält früher oder später ein Word-Dokument zugeschickt. Hier kann Textmaker seine Stärken zeigen. Softmaker selbst hebt hervor, dass bei Textmaker großer Wert auf DOC-Kompatibilität gelegt wird. Das scheint zu stimmen, mit Word-Dokumenten kann Textmaker bedeutend besser umgehen als die freie Konkurrenz. Während sich das Layout unter OpenOffice gerne mal verschiebt und Dokumente eigentümliche Formatierungen erhalten, bleibt bei Textmaker alles am Platz. Das Bearbeiten von Word-Dokumenten gelingt somit entschieden besser.

Das unter Linux geläufigere ODT-Dokumentenformat, also das Format, in dem auch OpenOffice standardmäßig speichert, beherrscht Textmaker ebenfalls, jedoch nicht im gleichen Maße wie DOC. Die ODT-Unterstützung kann man bestenfalls als rudimenär bezeichnen, mehr als blanker Text geht kaum, beim Importieren von ODT-Dokumenten mit Tabellen oder Graphiken entsteht das reine Chaos – aber immerhin: sie ist vorhanden und mit OpenOffice erstellte Dokumente lassen sich auch in Textmaker betrachten.

Ein typisches Merkmal von Textmaker ist, dass die automatische Silbentrennung stets eingeschaltet ist. Wer sie nicht braucht, muss sie erst über die Absatzeinstellungen (Format, Absatz) deaktivieren.

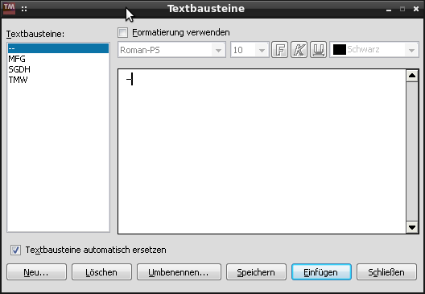

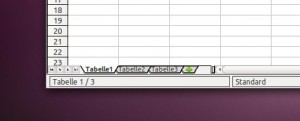

Was Vielschreibern auf den zweiten Blick auffällt, ist das Fehlen des automatischen Umwandelns von Binde- zu Gedankenstrichen. Eine Korrektur dafür im Bereich der Rechtschreibkontrolle gibt es nicht, bei Textmaker muss man den Weg über die „Textbausteine“ gehen. Hier kann man z.B. definieren, dass zwei Bindestriche zusammen einen Gedankenstrich ergeben sollen.

Textbaustein- und Ersetzungsfunktion

Die Möglichkeit, ein Dokument als PDF zu exportieren, ist vorhanden, auch Selbstverständlichkeiten wie Fußnoten und automatische deutsche Anführungszeichen findet man bei Textmaker. Eigene Wörterbücher lassen sich nicht anlegen, im Gegenzug fällt das „Dazulernen“ von Wörtern leichter, da ein Klick im Kontextmenü ausreicht, um es dem Wörterbuch hinzuzufügen (nicht zwei Klicks wie bei OpenOffice, weil noch das Wörterbuch ausgewählt werden muss, in das gespeichert werden soll).

Das eingebaute Wörterbuch zur automatischen Rechtschreibkontrolle macht einen guten Eindruck, patzt aber unübersehbar bei zusammengesetzten Wörtern:

Versuchsaufbau

Temperaturmessung

Ergebniswerte

stromleitend

Monitorauflösung

Solche Wörter kennt Textmaker aus dem Stand nicht. Aber auch konjugierte Wörter (er überwies das Geld) werden bisweilen als fehlerhaft unterkringelt.

Ansonsten bietet Textmaker alle Funktionen, die man sich bei einem Schreibprogramm wünscht; das auf den ersten Blick schlanke Programm entpuppt sich als vollwertige und mächtige Textverarbeitung.

Die Hilfefunktion des Programms ist direkt mit dem PDF-Handbuch verknüpft, das keine Fragen offenlässt.

Die Vorteile

Als Killer-Feature muss die Worddokument-Kompatibilität gesehen werden. Wer darauf angewiesen ist, häufig mit DOC-Dokumenten zu hantieren, dabei aber nicht mit Windows und Word hantieren möchte, findet in Textmaker einen eleganten Weg für die DOC-Dokumentbearbeitung.

Vorteil Nr. 2, wenn man das Arbeiten mit OpenOffice gewöhnt ist, dürfte die Startgeschwindigkeit des Programms sein. Ein Klick – und schon ist das Programm geladen. Im direkten Vergleich zu OpenOffice fühlt sich der Programmstart rasend schnell an, was beim großen Funktionsumfang von Textmaker dann doch verwundert. Im Gegenzug zu schlankeren Alternativen wie Abiword, welches ebenfalls flott startet, muss man dabei aber nicht auf Funktionen verzichten.

Ein geniales Feature Textmakers ist zudem die gleichzeitige Unterstützung der alten und neuen Rechtschreibung. Wer abwechselnd mit beiden Varianten arbeiten muss, braucht nicht ständig umzuschalten: „normale“ Fehler werden rot unterkringelt, Schreibweisen in alter Rechtschreibung blau.

Die Stolperfallen

Doch wo Licht ist, ist auch Schatten. Das größte Manko der Linuxversion von Textmaker dürfte sein, dass sich das Programm trotz seiner gefühlten Leichtigkeit beim Start ausgerechnet beim Schreiben selbst träge anfühlt. Dieser Effekt verstärkt sich, je länger ein Dokument ist. Der Grund dafür ist, dass Textmaker Tastatureingaben mit minimaler Verzögerung umzusetzen scheint. Schnellschreiber können praktisch zusehen, wie die Buchstaben von Geisterhand noch auf den Bildschirm gemalt werden, obwohl sie mit dem Tippen bereits aufgehört haben. Diese – wenn auch nur leichte Verzögerung – stört während des Schreibens erheblich. Der Effekt verstärkt sich dadurch, dass der Cursor oft flackert und beim Schreiben verschwindet. Auch das Navigieren mit dem Cursor könnte flotter sein.

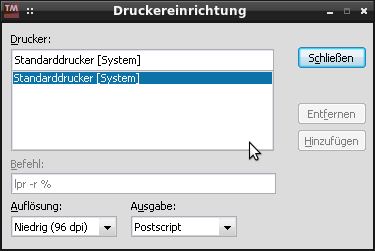

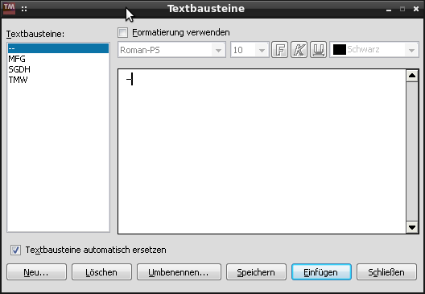

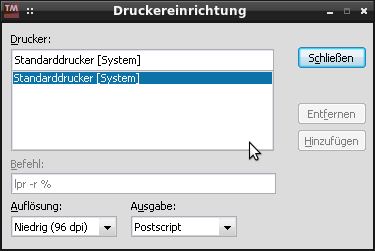

Probleme macht auch das Drucken, denn Textmaker druckt stoisch mit dem Standarddrucker. Wenn mehr als ein Drucker unter Linux eingerichtet ist, kann stets nur der erste über Textmaker ansgesprochen werden. Die Schaltflächen zum Einrichten eines weiteren Gerätes sind ausgegraut.

nicht anwählbar: Druckerverwaltung

Gravierender und erheblich störender jedoch ist, dass Textmaker manchmal den Fokus im Dokument verliert, wenn zwischenzeitlich in anderen Anwendungen gearbeitet wurde. Der Cursor ist dann nicht mehr sichtbar und das geöffnete Dokument reagiert auch nicht mehr auf Eingaben mit der Tastatur. Ein Workaround besteht darin, ein Menü mit der Maus zu öffnen und gleich wieder zu schließen, danach spricht auch der Dokumentenbereich wieder auf Mausklicks an.

Der ODT-Import wie -Export ist im Übrigen nicht ausgereift. Importierte Open-Office-Dokumente erfordern viel Nacharbeit, um sie wieder ansehnlich zu bekommen. Bei einem mit Textmaker geschriebenen und in OpenOffice geöffneten ODT tauchten z.B. plötzlich durchgehende Linien am Textende auf, die auch nach dem erneuten Öffnen in Textmaker erhalten blieben und nicht mehr zu entfernen waren.

mit Textmaker erstelltes ODT in Word geöffnet

Ein Öffnen der Datei in Word war überhaupt nicht möglich.

Fazit

Während Textmaker 2008 unter Windows ein Weg zu einem schnellen Office ist, ohne die Microsoft’schen Mondpreise zahlen zu müssen, sich „Ribbons“ aufzwängen zu lassen oder auf ein schwerfälliges OpenOffice zurückzugreifen, ist es unter Linux neben der besseren Startzeit vor allem ein passabler Weg, überhaupt mit DOC-Dokumenten vernünftig arbeiten zu können. Das Arbeiten mit dem Programm macht trotz kleiner Hindernisse Spaß, da es schnell geladen ist und durchdachte Funktionalität bietet.

Das Sympathische an Textmaker ist, dass es neben dem eigenen TMD-Format eine rudimentäre ODT- und eine großartige DOC-Unterstützung bietet, ansonsten aber nicht zu sehr versucht, Word zu kopieren. Textmaker orientiert sich optisch zwar an den klassischen Symbolleisten, wie man sie auch von Word 2003 noch kennt, macht in der Bedienung aber Vieles besser als Word oder auch OpenOffice.

Wer ein natives Linux-Schreibprogramm sucht, das gut mit DOC zurechtkommt und sich im Bedienumfang mit Word oder OpenOffice-Writer messen kann, sollte einen Blick auf Textmaker werfen. Es ist stabil und tut das, was es tun soll: Textverarbeitung abseits des Kolosses OpenOffice, den minimalistischen Editoren oder gar dem befehlgestützten Schreiben in LaTeX. Der Schreibende kann sich auf’s Schreiben konzentrieren und sein Dokument graphisch gestalten.

Für das längere Schreiben – vor allem im ODT-Format – empfiehlt sich jedoch weiterhin das gewohnte OpenOffice bzw. LibreOffice.

![]() Oder hat evtl. schon jemand einen Weg gefunden die Programme unter 64-bit (fehlerfrei) auszuführen?

Oder hat evtl. schon jemand einen Weg gefunden die Programme unter 64-bit (fehlerfrei) auszuführen?

Textmaker merkt sich beim Schließen des Programmes den eingestellten Vergrößerungsgrad eines Dokumentes, nicht jedoch die Position des Cursors, wie es etwa OpenOffice beherrscht.

Textmaker merkt sich beim Schließen des Programmes den eingestellten Vergrößerungsgrad eines Dokumentes, nicht jedoch die Position des Cursors, wie es etwa OpenOffice beherrscht.