Gnome 3 geht gar nicht – obwohl Viele den neuen Gnome-Desktop toll finden, teilt eine ebenso große Schar an Benutzern diese Einschätzung nicht, vor allem die Gnome-Shell polarisiert. Doch statt immer nur zu jammern, wie furchtbar Gnome 3 doch nun geworden sei, bieten wir diesmal Hilfe zur Selbsthilfe: Wie man auch in Zukunft noch die traditionelle „Gnome-Erfahrung“ bekommt, inklusive Hauptmenü, Symbolen auf dem Desktop und einem flexiblen Panel.

Gnome 3 samt Gnome-Shell hat viele Nutzer kalt erwischt, regelrecht vor den Kopf gestoßen, war Gnome doch in der letzten Dekade vor allem für kontinuierliche Entwicklung bekannt. Wer jedoch jetzt von Gnome 2 auf 3 umsteigt, erlebt sein blaues Wunder. Der bisherige Desktop ist passé, die Gnome-Shell kommt mit neuen Ideen und Konzepten. Die Bedienung hat sich fundamental geändert, der Nutzer bekommt zwar einen geschmeidiger wirkenden Desktop mit modernerem Touch, paradoxerweise gleichzeitig mit eingeschränkterer Funktionalität. Das hat zur Folge, dass Gnome inzwischen innovativer und mutiger wirkt als z.B. KDE, das im direkten Vergleich auf einmal wieder ganz klassisch erscheint. Mittlerweile haben alle gängigen Distributionen auf Gnome 3 umgestellt, der Rest wird in absehbarer Zeit Gnome 2 entfernen.

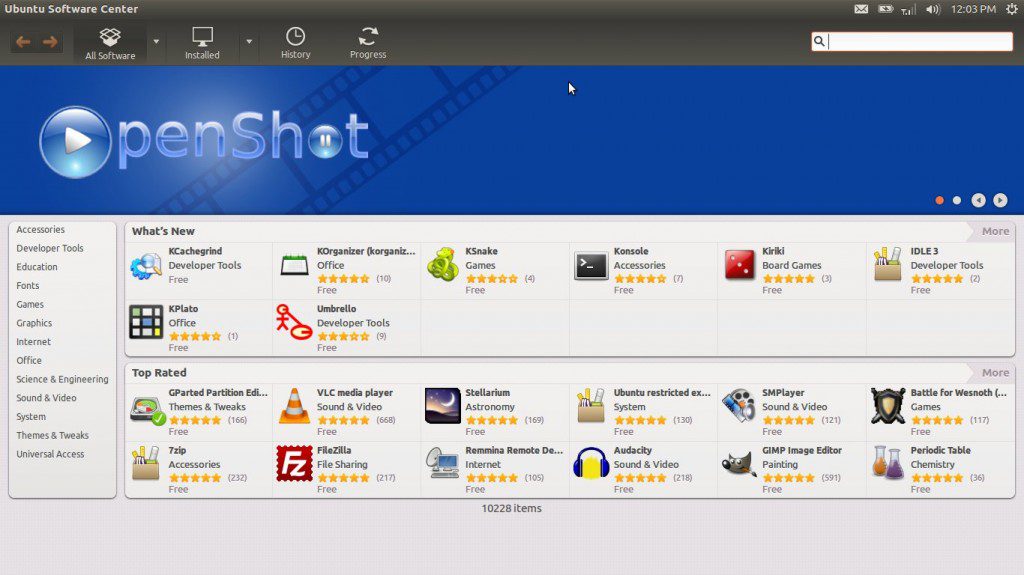

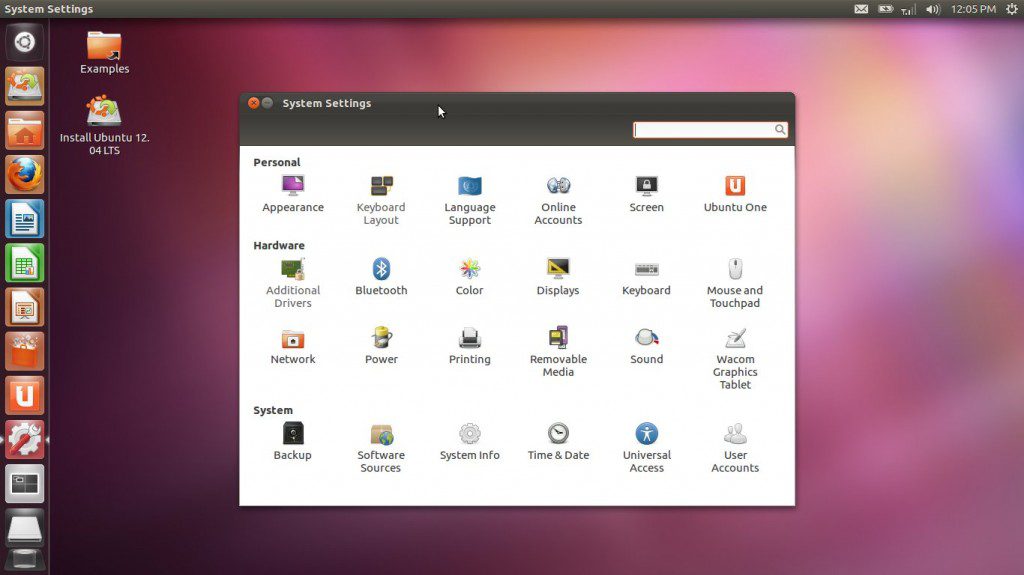

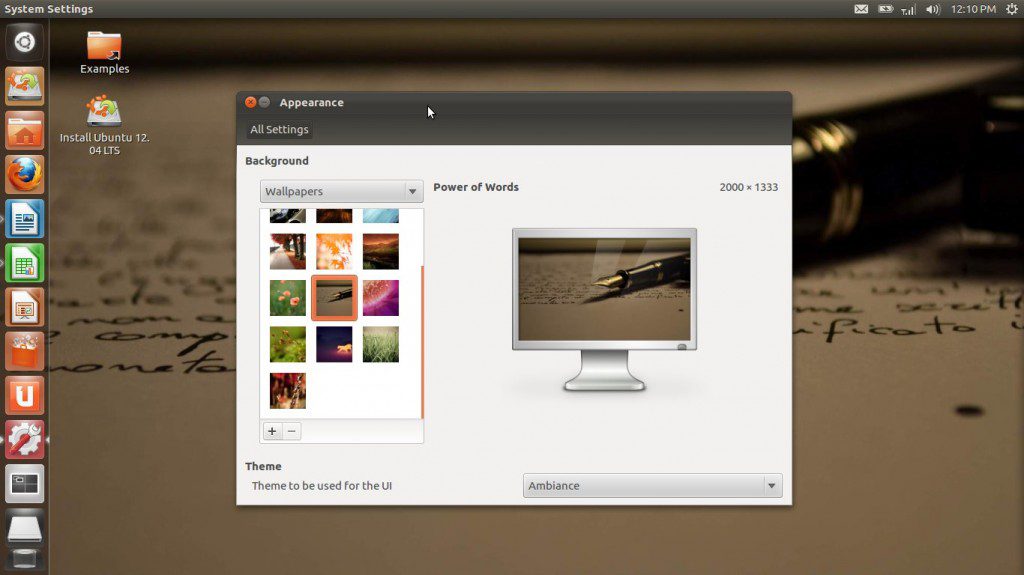

Auch Ubuntu schasste das alte Gnome-Design, wechselte jedoch nicht direkt zu Gnome 3, sondern wagte mit Unity etwas ganz Neues, baut dabei nun aber indirekt auf Gnome 3 auf, so dass sich Gnome 2 auch hier nicht optional weiternutzen lässt. Zu allem Übel sind sich Gnome 3 und Unity in der Umsetzung auch noch sehr ähnlich, so dass Unity ebenfalls keine echte Alternative für die Anhänger des klassischen Desktops darstellt. Zudem handelt es sich bei Unity auch noch um eine Insellösung – abseits von Ubuntu ist Unity derzeit höchstens experimentell zu finden, ein Einzug in andere Distributionen erscheint unwahrscheinlich.

Nichtsdestotrotz gibt es viele Nutzer, die an den alten Paradigmen hängen, ihre Arbeitsabläufe darauf eingestellt haben und keinen Grund sehen, sich davon zu lösen, kurz gesagt, die Gnome 2 perfekt fanden – und von ihrem bisherigen Lieblingsdesktop nun im Regen stehengelassen wurden. Dass es von diesen Anwendern nicht gerade wenig gibt, darauf könnte der Umstand hinweisen, dass es Linux Mint – das vorerst bei Gnome 2 blieb – in den letzten Monaten gelang, Ubuntu zumindest in der Distrowatch-Wertung von Platz 1 zu verdrängen. Diesen Nutzern bleiben nun 3 Möglichkeiten: a) sich an die Gnome-Shell gewöhnen, b) versuchen, die Gnome-Shell wieder in ein Gnome 2 zu verwandeln – oder c) sich Alternativen suchen.

Der Mint-Desktop, hier noch in der Gnome-2-Version

Möglichkeit A ist die schlechteste von allen Optionen, wenn man sich eben gerade nicht umgewöhnen möchte oder am Konzept von Gnome 3 keinen Gefallen gefunden hat. Sicher, lernen kann man alles, und die Gnome-Community setzt „derzeit alles daran, über Erweiterungen die im Urzustand spartanische Desktopumgebung um altbekannte Funktionen zu ergänzen und somit zu Möglichkeit B zu gelangen. Hierbei spielt wiederum Linux Mint eine Vorreiterrolle, indem es Gnome 3 nicht im Originalumfang ausliefert, sondern viele Erweiterungen, die das klassische Aussehen und die traditionellen Elemente annähernd wiederherstellen, vorinstalliert und aktiviert. Es bleibt jedoch die Frage, weshalb man sich einen als umständlich empfundenen Desktop erst zurechtbiegen soll – was meist eben doch nicht zum erhofften Ergebnis führt, oft müssen Kompromisse eingegangen werden – wenn auch Alternativen bereitstehen, die den eigenen Vorstellungen von einem Desktop womöglich eher entsprechen. Schauen wir daher auf Möglichkeit C, die Alternativen.

Gnome 2 & Forks

Natürlich kann man das alte Gnome einfach weiterhin benutzen. Das Weiternutzen von Gnome 2 ist theoretisch noch eine ganze Weile möglich. Debian stable, CentOS und einige andere Distributionen kommen standardmäßig noch mit Gnome 2 im Gepäck. Doch es ist absehbar, dass diese Unterstützung im Laufe der Zeit enden wird. Panel und Nautilus samt Desktop, die beiden Primärkomponenten des alten Gnomes, werden auch darüber hinaus weiterhin verfügbar sein, aber man wird sich selbst um deren Installation kümmern müssen. Eine parallele Nutzung von Gnome 2 und 3 ist jedoch nicht ohne Weiteres möglich, so dass eine Nutzung bei auf Gnome 3 getrimmten Distributionen de facto ausscheidet. Auf den typischen Anwender-Distris wie Suse, Fedora, Ubuntu und vielen weiteren ist Gnome 2 somit bereits endgültig Vergangenheit. Und wer reitet schon gern auf toten Pferden?

Zukunftssicherer erscheint die Fortführung des Gnome-2-Desktops unter dem Namen „Mate“. Hier wird zurzeit versucht, den alten Gnome-Desktop fit für die Zukunft zu machen, so dass er auch neben Gnome 3 betrieben werden und somit leichteren Eingang in die Distributionen finden kann. Im Moment erreicht der Mate-Desktop jedoch noch nicht den vollen Umfang des ehemaligen Gnome 2. Doch Mate ist bereits nutzbar und regulär etwa im Paketumfang von wiederum Linux Mint enthalten.

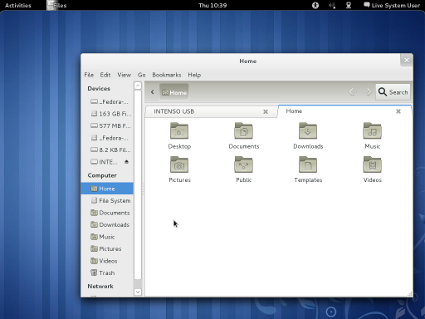

Mate, augenzwinkernd laut Selbstbeschreibung ein „nicht-intuitiver, unattraktiver Desktop für Nutzer, die eine traditionelle Computerdarstellung bevorzugen.“

Einen weiteren Ansatz verfolgt Glasens Blog, das den Fallback-Modus von Gnome 3 als Ausgangsbasis für ein nachempfundenes Gnome 2 nutzt, aus dem im Grunde das klassische Gnome-Panel wiederaufersteht. Welche Zukunftschancen dieses Projekt hat, sofern die Distributionen den Rückfallmodus irgendwann nicht mehr anbieten sollten, steht jedoch auch noch in den Sternen.

KDE

Als Alternative zu Gnome 2 bietet sich natürlich auch KDE an. Eigentlich stets als „Rivale“ von Gnome wahrgenommen, ist es nach dem 4.0-Desaster längst wieder brauchbar geworden und bietet trotz innovativem Design und modernem Antlitz viel klassische Desktopfunktionalität. Statt zu Gnome 3 wäre also auch ein Wechsel zu KDE 4 keine schlechte Idee, wenn man weiterhin in der gewohnten Art arbeiten möchte. Das „Problem“ bei dieser Lösung sind allein die Programme. KDE nur als reinen Desktop zu nutzen und weiterhin mit den bisher gewohnten Gnome-Programmen zu arbeiten, ist zwar möglich, aber wenig sinnvoll. Denn KDE spielt sein Potential nur aus, wenn man sich auch den KDE-Programmen anvertraut. Doch genau dies scheuen viele alte Gnome-Fans, da KDE-Programme eben doch etwas anderes sind als Gnome-Anwendungen. Das „look and feel“ ist ein ganz anderes.

Traditioneller Gnome-2-Desktop bei OpenSUSE …

… und neumodischer Gnome-3-Desktop

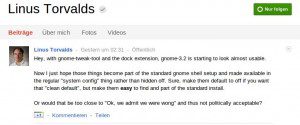

XFCE & LXDE

Hinter diesen beiden Desktops steht nicht so eine große Entwicklergemeinde wie hinter Gnome und KDE, doch sie werden stets als erste Alternative genannt, wenn es gilt, Gnome-2-Funktionalität ohne Gnome zu verwirklichen. Der Grund dafür ist, dass die beiden Desktops wie auch Gnome auf das GTK-Toolkit aufbauen, die Programme „fühlen“ sich also sehr ähnlich an, sehen idealerweise ähnlich aus und lassen sich ähnlich bedienen. Auch Gnome-Programme integrieren sich dadurch fast immer nahtlos in die beiden kleineren Desktops Sowohl XFCE als auch LXDE bleiben dabei dem klassischen Desktopdesign verhaftet, Experimente wie bei der Gnome-Shell oder Unity sind hier nicht zu erwarten. LXDE und XFCE bieten also den Vorteil, die gewohnten Gnome-Programme gegebenenfalls einfach weiternutzen zu können, ohne dabei die klassische Bedienweise des Desktops aufgeben zu müssen. Doch auch für sich genommen bieten beide Umgebungen einen nahezu vollwertigen Gnome-2-Ersatz – mit Desktopfläche, Icons, Umschaltern, Panel, Panel-Applets und allem anderen, was dazu gehört. Das XFCE-Panel ist sogar noch flexibler als das von Gnome 2, ein besonderer Clou ist, dass über ein Plugin die alten Gnome-Applets dort integriert werden können. Der britische Register etwa empfiehlt seinen Lesern XFCE als Gnome-2-Nachfolger, Linux Torvalds hat schon gewechselt. Nur, sich zwischen XFCE und LXDE zu entscheiden, das kann wiederum eine schwierige Angelegenheit werden.

Gnome-Programme & Fenstermanager

LXDE und XFCE können beide das derzeitige GNOME 2 annähernd perfekt nachbilden: jeweils eine Leiste oben und unten, Symbole auf dem Desktop, GTK-Stile – alles kein Problem. Doch an der Kernkomponente, dem Dateimanager Nautilus, der unter Gnome 2 auch für den Desktop an sich verantwortlich war, hapert es dann zum Beispiel. XFCEs Nautilus-Nachbau Thunar bleibt hinter den Fähigkeiten von Nautilus deutlich zurück, wer sich an „Tabs“ gewöhnt hat, kommt mit Thunar nicht mehr zurecht. LXDEs „PCmanFM“ ist wiederum noch etwas wackelig und hat ein paar andere Eigenarten wie z.B. erzwungenes Tab-Browsing.

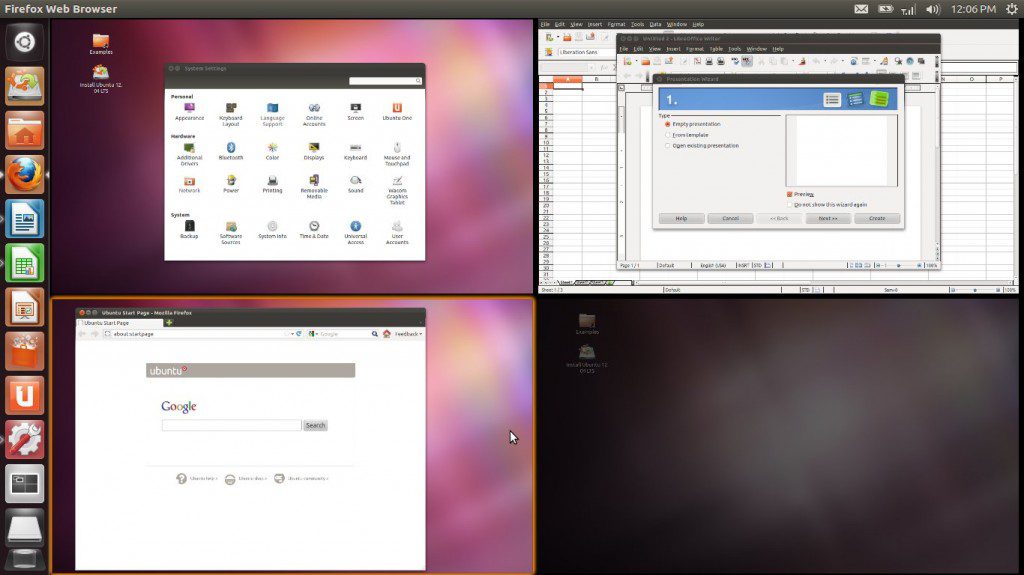

Was also liegt näher, als die gewohnten Gnome-Programme einfach weiterhin zu benutzen, aber nur auf die Gnome-Shell zu verzichten? Man nutzt einfach „Gnome pur“ ohne die Shell, denn die Gnome-Programme an sich laufen selbstverständlich auch ohne diese. Gnome 3 ohne Gnome-Shell ist ohne Weiteres möglich, man braucht dann lediglich einen Ersatz für die Gnome-Shell, also einen Fenstermanager und ein alternatives Panel. Ubuntu macht mit Unity im Grunde nichts anderes. Die Formel lautet also: beliebiger Fenstermanager + eigenes Panel + Nautilus = Gnome-2-ähnlicher Desktop. Damit kommt man dem ehemaligen Gnome 2 in Aussehen und Bedienung am nächsten und muss auch nicht fürchten, dass in Zukunft einfach wieder jemand den Stecker zieht, da man flexibel bleibt.

Als Fenstermanager für einen Gnome-2-Nachbau eignet sich am besten Openbox. Es gibt natürlich auch noch IceWM, Fluxbox und viele andere, doch diese empfehlen sich eher, wenn man auf höhere Geschwindigkeiten oder spezielle Funktionen abzielt. Openbox hingegen ist in der Grundkonfiguration dem unter Gnome 2 verwendeten Fenstermanager „Metacity“ bereits sehr ähnlich, es verhält sich fast identisch, außerdem bringt Openbox praktischerweise auch gleich eine passende Auswahl von Fensterrahmen mit, die man bereits von Gnome 2 kannte. Als Panel bieten sich das handliche „Fbpanel“ oder das Panel von LXDE („lxpanel“) an, da diese auf GTK aufbauen und ähnlich funktionieren wie das alte Gnome-Panel. Sogar die von Gnome 2 bekannte Dreiteilung des Anwendungsmenüs lässt sich bei diesen Panels mit ein wenig Bastelei nachbilden.

Openbox-Fensterrahmen: Clearlooks, Human, Industrial und Mist

Auf diesem Wege kommt man wieder zu seinem präferierten klassischen Gnome. Diese Lösung hat jedoch den Nachteil, dass sie vom Aufwand her noch zeitintensiver ist als das Auf-, Ab- und Umrüsten der Gnome-Shell, da nicht nur Erweiterungen installiert, sondern Fenstermanager, Panel und Einzelprogramme separat konfiguriert und aufeinander abgestimmt werden müssen. Das ist deutlich umständlicher als der Wechsel etwa zu XFCE/LXDE, Lohn für die Mühen ist jedoch ein nahezu perfektes Gnome-2-Feeling. Auch in Zukunft muss man also nicht auf seinen klassischen, gewohnten Desktop mit gewohnter Bedienung verzichten. Unter Linux ist nichts unmöglich – auch kein Gnome ohne Gnome 3.

Dieser Artikel ist Bestandteil der „Not my Desktop“-Reihe.

Bereits erschienen:

• Wird GNOME wieder zum Zwerg?

• Eine Woche Gnome 3: Der uniformierte Desktop

• Strategien zur GNOME-3-Vermeidung

• Gnome-Shell – es wird immer unübersichtlicher