Im Februar hat Ubuntu mit leichter Verzögerung das zweite Point-Release für die jüngste LTS Version 14.04 herausgebracht. Zuverlässig begann in den Foren der üblichen Verdächtigen der kleine Trollsport über den LTS-Status. Ubuntu mag nicht mehr die populärste Distribution sein, auf jeden Fall ist der Hype vorbei – Neuigkeiten scheinen aber noch zuverlässig für Diskussionsstoff zu sorgen.

Supportzyklen sind eine Modeerscheinung. Als Ubuntu aufkam revolutionierte es den Releaseprozess mit seiner strikten Orientierung an einem sechsmonatigen Releasezyklus. Andere Projekte wie Gnome und KDE folgten diesem Weg immer kürzerer und besser geplanten Releasezyklen und schließlich orientierten sich auch immer mehr Distributionen daran. Diese Modeerscheinung ist jedoch vorüber. Während jenseits des Linux-Tellerrandes die Systementwicklung deutlich beschleunigt wurde, orientieren sich immer mehr Linuxdistributionen am LTS-Modell.

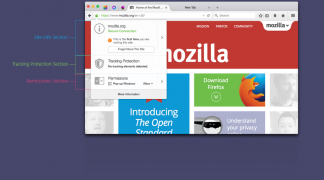

Ubuntu Tux unter Creative Commons BY-NC-SA

Die Beispiele dafür sind zahlreich: Debian testet zur Zeit mit Squeeze einen LTS-Release nach Ablauf der Oldstable-Supportphase und Ubuntu hat alle Zwischenversionen zu Entwicklerversionen deklariert. RHEL und seine Derivate, sowie SUSE Enterprise sind sowieso ungeschlagen – jedenfalls was die Supportdauer betrifft. Jedoch tendieren auch die Communityableger der Enterprise-Distributionen zu längeren Releasezyklen. OpenSUSE veröffentlichte Version 13.2 fast ein Jahr nach 13.1, was der Version 12.3 annähernd zwei Jahre Support ermöglichte. Der Release von Fedora 21 verzögert sich auch permanent, was den Support von Version 20 andauernd verlängert.

Die Gründe für diese Entwicklung sind vielfältig. Bei einigen Projekten ist die Erkenntnis gereift, dass sich in einem sechsmonatigen Releasezyklus substanzielle Neuerungen in einer Distribution nicht hinreichend stabilisieren lassen, bei anderen wie Debian ist es die Forderung der Community nach längeren Supportzeiträumen und selteneren Distributionsupgrades. Natürlich gibt es auch weiterhin Distributionen, die den Versionsjunkies gerecht werden, allen voran Arch Linux, der Trend geht aber in eine andere Richtung.

Alle Distributionen stehen dabei vor demselben Dilemma. Während z.B. Microsoft wirklich nur das Betriebssystem und wenige integrierte Programme mit Fehlerbehebungen und Sicherheitsaktualisierungen versorgen muss, liefern die meisten Linuxdistributionen in ihren Paketquellen ein umfangreiches Programmreservoir aus, das für den gesamten Unterstützungszeitraum gepflegt werden muss. Die beiden großen Enterprise-Distributionen haben darauf mit einer Limitierung des Paketquellenumfangs reagiert. Auf die Spitze hat dies sicherlich SUSE getrieben, als es mit Version 12 auch KDE aus den Paketquellen verbannte. Allerdings ist subjektiv auch bei den Communitydistributionen Fedora und openSUSE die Anzahl der enthaltenen Programme ein wenig zusammen geschmolzen.

Debian mit seiner großen Entwicklergemeinschaft geht einen anderen Weg. Die Paketquellen wachsen nahezu mit jedem Release an. Ubuntu übernimmt diese durch seinen Releaseprozess und friert die Versionsstände ein.

Gerade letzteres hat in letzter Zeit zum Vorwurf geführt, dass Ubuntu unsicher sei. Der Vorwurf kam zuerst in der Trollzone (auch genannt Heise, Golem und Pro-Linux) auf, um dann in seriösere Foren vorzudringen.

Die Lehre von den Paketquellen

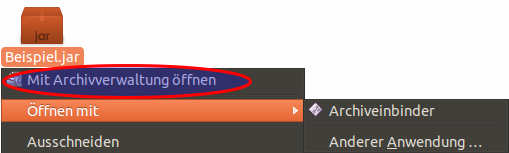

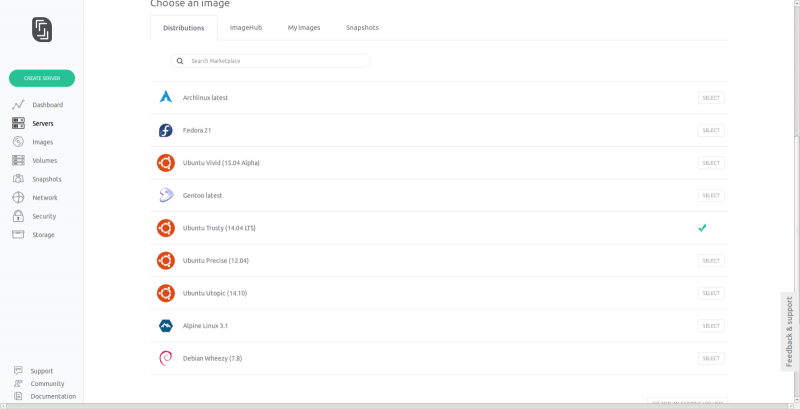

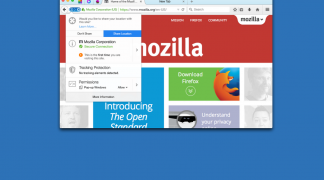

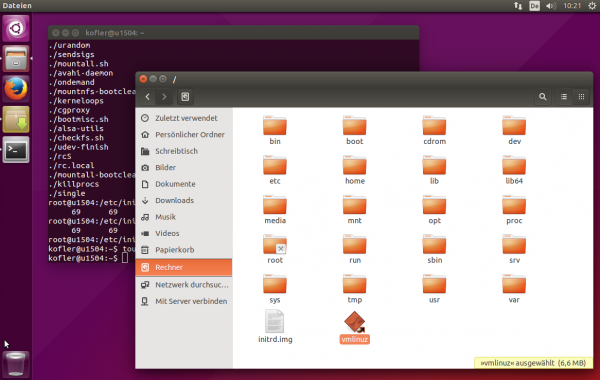

Während andere Distributionen in der Regel nur zwischen frei und unfrei unterscheiden und ihre Paketquellen derart strukturieren, gibt es bei Ubuntu eine Vielzahl von Bereichen.

- Main

- Universe

- Restricted

- Multiverse

- Canonical Partner

- Drittquellen / PPA’s

In Main befinden sich die Pakete, die direkt von Canonical – der Firma hinter Ubuntu – gewartet werden und die quasi zum “Enterprise-Umfang” (vergleichbar mit RHEL und SLES/D) gehören. Die Pakete in Canonical-Partner werden auch – wie der Name schon sagt – von Canonical bzw. ihren Partnern gepflegt, aber nicht offiziell supportet. Alles was sonst aus den Debian-Paketquellen synchronisiert wurde, findet sich in Universe. Aus grauer Vorzeit – als Kubuntu noch ein offiziell von Canonical unterstütztes Derivat war – hat sich der Mythos gehalten, dass in Universe nur die Reste liegen, die keinen Betreuer haben und die Pakete deshalb nicht gepflegt werden.

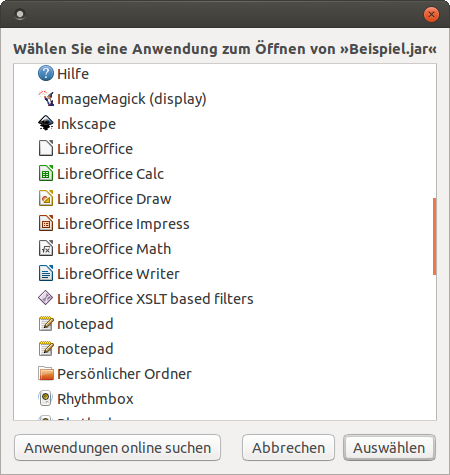

Desktop-Derivate

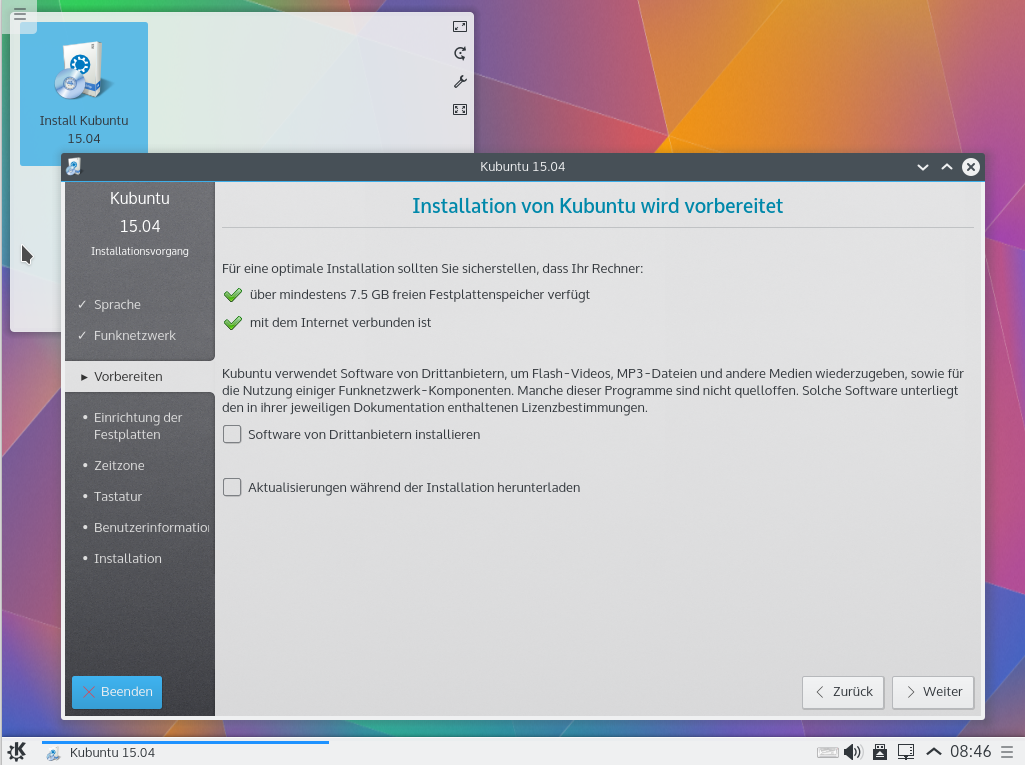

Das entspricht allerdings nicht der gegenwärtigen Faktenlage. Im Releaseprozess einer jeden LTS-Version legt das Ubuntu Technical Board fest welche Derivate einen offiziellen LTS Status erhalten. Hier wird noch mal differenziert in solche, die 5 Jahre unterstützt werden (z. Zt. Ubuntu und Kubuntu) und solche mit 3 Jahren Support. Die Derivate sind zwar lediglich Gemeinschaftsprojekte, allerdings unterscheiden sie sich als solche nicht von z.B. Debian oder openSUSE, die gemeinhin auch nicht als unsicher betrachtet werden.

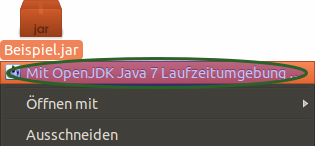

Die einzige zuverlässige Information über den Support von Paketen liefert also die Auskunft folgender Zeile in einem beliebigen Terminalprogramm auf dem betroffenen System:

$ ubuntu-support-status show-all

Auf einer normalen Desktopinstallation dürfte die Zahl der nicht unterstützten Paketen bei 5-10% liegen. In diese Kategorie fallen jedoch auch Pakete die aus PPA’s installiert wurde, sowie Pakete aus dem Partner Verzeichnis, die faktisch durchaus unterstützt werden. Tatsächlich sinkt damit die Quote auf weniger als 2%. Das ist ein durchaus akzeptabler Wert und deutlich ehrlicher als die angebliche 100%-Unterstützung bei Debian. Wer daran zweifelt kann sich die offenen Sicherheitslücken bei z.B. Filezilla in Debian Wheezy ansehen. Wenn man auf einen sehr hohen Anteil nicht unterstützter Programme kommt, sollte man sich allerdings ggf. überlegen auf alternative Programme mit Support umzusteigen.

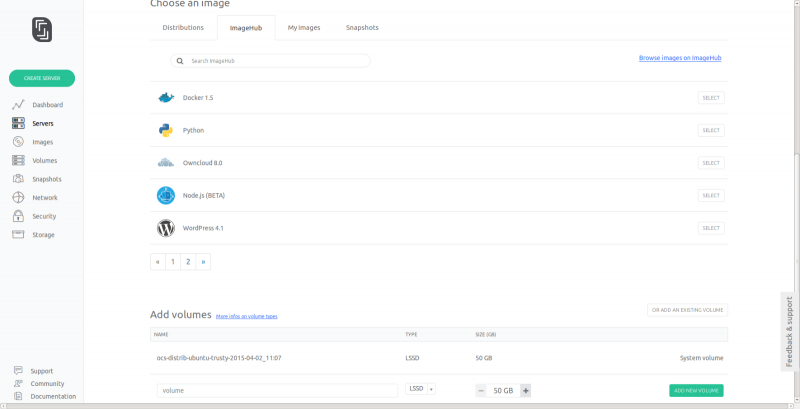

Server

Etwas anders sieht die Lage im Serverbereich aus. Einerseits ist hier das Angriffsrisiko besonders groß und andererseits liefert Ubuntu hier durch den Sychronisationsprozess mit Debian eine ganze Reihe von Programmen aus, die nur leidlich oder gar nicht gewartet werden. Die Spanne reicht hier von Drupal, über ownCloud bis WordPress. Während die meisten Desktopprogramme in einem halben Jahr keine sicherheitskritische Aktualisierung erhalten, sind diese hier an der Tagesordnung.

Das ist zweifelsohne ungünstig, aber von einem Serveradministrator kann erwartet werden, dass er sich mit der eingesetzten Linux-Distribution hinreichend auskennt um ihre Eigenheiten zu verstehen und ggf. die Programme eigenständig zu aktualisieren. Wer dies nicht kann, sollte seinen Server schleunigst abschalten. Hier ist die Verantwortung des Distributors gegenüber dem Nutzer völlig anders gelagert, als beim Privatanwender. Zumal das Problem eh selten akut wird, weil viele Administratoren die betroffene Software direkt von Upstream beziehen (wer will schon 5 Jahre dieselbe WordPress-Version einsetzen?).

Unklare Paketzuordnung

Unabhängig von der Desktop- oder Server-Sparte ist die Auswahl der supporteten und unsupporteten Pakete bzw. die Zuordnung nach main und universe für einen Außenstehenden in vielen Fällen nicht nachvollziehbar. Im Februar lief der 9-Monats-Zyklus ab, wichtige Pakete wie das verbreitete schweizer Taschenmesser für Multimediadateien VLC haben damit ihren Support verloren. Trotzdem finden sich im Changelog Aktualisierungen für Sicherheitslücken. Doch wie lange kann sich der Nutzer darauf verlassen?

VLC wirft ein Schlaglicht auf die interessante Zusammensetzung der unterstützen Pakete in Ubuntu. Neben den Basispaketen wie Kernel, X-Server und Kernbibliotheken des Systems gehören dazu auch Programme wie GIMP, die auf keinem Derivat standardmäßig vorinstalliert sind. Umgekehrt gehören verbreitete Virtualisierungslösungen wie Virtualbox offiziell nicht dazu, die Virtualbox-Scope für Unity hingegen schon. Mit VLC der plattformübergreifende, quasi-standard Multimedia-Player hingegen - wie bereits erwähnt - auch nicht.

Ein weiteres Problem stellen die mit jedem Point-Release auf den Installationsmedien ausgelieferten neuen Kernel und X-Server Versionen dar. Diese haben – anders als die ursprüngliche Version vom April 2014 – eine verkürzte Supportdauer von 9 Monaten. Leider werden sie danach nicht zuverlässig auf die nächste Version aktualisiert bzw. gefährden die Systemstabilität einer LTS-Version. Die Gratwanderung zwischen Unterstützung neuer Hardware und Systemstabilität wurde hier nicht besonders gut gemeistert.

Neue und alte Fehler

Hinzu kommt, dass Trusty in den vergangenen Monaten in einigen Bereichen schon nicht besonders glänzte. So wurde durch fehlerhafte Updates die Dialogintegration von LibreOffice in KDE kaputt (LP #1369673) gefixt, Digikam stürzt aufgrund eines Sqlite-Fehler zuverlässig ab (LP #1317449) und die Xmodmap wurde auch durch ein Update abgeschaltet. Bei Release bestehende gravierende Fehler wie die fehlerhafte Verschlüsselung mittels ecryptfs (Benutzerdaten verschlüsseln in der Installationsroutine) wurde lediglich durch engagierten Einsatz aus der Community behoben. (LP #953875).

Diese Fehler werden ergänzt durch die subjektive Wahrnehmung, dass die Bedeutung der vergangenen LTS-Version beim Ubuntu-Team nach 9 Monaten abnimmt. Die Weichen werden in Richtung 16.04 gestellt. Wichtige Funktionen nun in die STS Versionen eingebracht. Aktualisierungen für Trusty beziehen sich nun überwiegend auf Sicherheitslücken. Reine Fehlerbehebungen oder ein größeres Engagement für die LTS darf man wohl nur noch in seltenen Fällen erwarten.

Fazit

Ubuntus Paketquellenaufteilung in Main und Universe (sowie die anderen Bereiche) ist speziell, macht das System aber nicht per se unsicher - wie von Kritikern oft bemängelt wird. Die Probleme liegen eher in anderen Bereichen, welche die Nutzer aber ebenso betreffen. Ubuntu ist aufgrund der Verbreitung zudem deutlich mehr im Fokus, als so manche Nischendistribution, wo man den Paketbetreuern ebenfalls auf die Finger schauen muss. Ist Ubuntu in seiner Gesamtheit unsicherer als SUSE Enterprise oder RHEL? Möglicherweise ja, allerdings haben diese ein deutlich limitiertes Angebot an Paketen, was zu verstärktem Einsatz von Fremdquellen, wie z.B. EPEL führt. Diese bringen ganz andere Sicherheitsrisiken mit sich und können deshalb auch nicht als Königsweg bezeichnet werden.

Letztlich stehen alle großen Distributionen vor der Frage, wie man bei begrenzter Arbeitskraft ein stetig wachsendes Reservoir an Paketen über viele Jahre warten kann. Zumal Hilfe von Upstream nicht immer zu erwarten ist. Das bisherige LTS und STS System ist aber eher eine mittelmäßige Lösung und wird vermutlich mittelfristig ersetzt werden. Ubuntu Snappy Core, Ubuntu Phone und die allgemeine Entwicklungsrichtung um Docker & Co werfen ihre Schatten voraus.