Ich bin es wieder!  Mich gibt es noch und ich nutze weiterhin mit Begeisterung Ubuntu. Hatte nur viel um die Ohren (Umzug!!), weswegen ich mein Blog sträflich vernachlässigt habe.

Mich gibt es noch und ich nutze weiterhin mit Begeisterung Ubuntu. Hatte nur viel um die Ohren (Umzug!!), weswegen ich mein Blog sträflich vernachlässigt habe.

Ganz kurz als “Auflösung” zum letzten Eintrag. Gekauft habe ich mir von Dell einen neuen Laptop:

Dell XPS 1530 mit Nvidia GeForce 8600M GT, 4 GB RAM, Intel Core 2 Duo CPU T9300 @ 2,5 GHz

Und ENDLICH habe ich darauf Ubuntu 9.10 Karmic Koala installiert. Hier also “kurz” meine Eindrücke. Und wie man das Frontmic zum laufen bekommt.

Ich habe zwar zuerst ein Update von Jaunty auf Karmic vorgenommen, was auch funktioniert hat. Jedoch hat sich alles nicht so “geschmeidig” angefühlt und meine Datenpartition war falsch eingebunden. Ausserdem wollte ich ja GRUB2 haben und /root und /home mit ext4 betreiben. Deswegen habe ich mich für eine Neuinstallation entschieden. Was ich ansich immer gern mache, weil dadurch das System halbjährlich von dem ganzen Mist, den man so probehalber installiert befreit wird.

Also Backup erstellt und dabei diesmal besonders aufgepasst, da ich ja diesmal mein /home auch formatiert habe.

Zur Installation brauch ich nicht viel sagen, lief wie gewohnt schnell und reibungslos. Eigentlich ist ja immer nur an einem einzigen Punkt Konzentration angesagt. Nämlich dann, wenn man Partitionen händisch vergibt und einige davon partitioniert werden sollen, andere aber unangetastet bleiben sollen. Ich habe übrigens wieder die 32-bit-Installation verwendet. Mit Ubuntu werden hier bis zu 4 GB RAM-Arbeitsspeicher erkannt. Vielleicht ja nächstes mal 64-bit… mal sehen.

Nach ungefähr 25 Minuten war die Installation abgeschlossen und mein Ubuntu startete mit einem jungfräulichem Karmic Koala. Ich persönlich kann nicht sagen, dass das starten schneller als mit Jaunty ist. Ich fand es ja da schon ziemlich flott und so ist es auch geblieben. Sieht alles ganz schick aus. Was mir als erstes aufgefallen ist, dass die Schriften anders geglättet sind. Am Anfang fand ich das irgendwie komisch, aber schon nach ungefähr 2 Stunden hab ich mich dran gewöhnt und würde jetzt wahrscheinlich die alte Darstellung komisch finden.

Schon der Anblick des stufigen Verlaufs des Hintergrundbildes sagte mir: jetzt mal gleich den Grafiktreiber installieren. Bequem wie immer habe ich das über Ubuntus Hardware-Treiber-Assistent gemacht und damit den Nvidia Treiber version 185 installiert. Ein Neustart später sah alles wunderbar aus. So richtig geschmeidig und hübsch. Erst nach ner Weile hab ich realisiert, dass ja Compiz jetzt schon per default nach der Installation eines passenden Treibers aktiviert ist. In der Standardeinstellung ist das wirklich sehr hübsch, ohne wabbelige Fenster oder den ganzen Schnickschnack. Einfach ein paar Schatten, geschmeidige Animationen. Gefällt mir!  Wer mehr will kann ja mit einem rechtsklick auf den Desktop, “Hintergrund der Arbeitsfläche ändern” > “Visuelle Effekte” auf “Extra” gehen und bekommt dann wabbelige Fenster. Und wer nochmehr will installiert sich einfach das Paket

Wer mehr will kann ja mit einem rechtsklick auf den Desktop, “Hintergrund der Arbeitsfläche ändern” > “Visuelle Effekte” auf “Extra” gehen und bekommt dann wabbelige Fenster. Und wer nochmehr will installiert sich einfach das Paket

compizconfig-settings-manager

dass dann unter “System > Einstellungen” zu finden ist. Hier lassen sich ganz bequem Compiz-Plugins aktivieren und deaktivieren. Ich sage nur “Würfel”!

Jetzt aber mal Butter bei die Fische – was geht denn jetzt alles an Hardware “out-of-the-box” mit meinem Dell XPS 1530?

LAN – ja

WLAN – ja

Grafik – ja (nach installation des Nvidia-Treibers auch 3D und Compiz)

eingebaute Webcam – ja

Sound – ja

eingebautes Mikro – ja

Frontmikro – ja (aber erst nach einer besonderen Einstellungen, dazu gleich mehr)

Bluetooth – ja (Probiert mit meinem Nokia 6300)

Fn-Tasten für Helligkeit, CD-Auswurf – ja

Multimedia-Tasten – ja

Card-Reader – ja

USB-Eingänge – ja

Fingerabrucksensor – keine Ahnung, noch nie ausprobiert

Firewire – keine Ahnung, da kein externes Firewire-Gerät

HDMI-Ausgang – keine Ahnung, siehe oben

Habe ich etwas vergessen? Wenn ja, brauch ich es nicht oder habe im Moment kein externes Gerät zum ausprobieren.

Ich muss gestehen, ist jetzt alles fast ein bisschen langweilig, da keine Katastrophen zu berichte sind – es geht einfach alles. Ansonsten gibt es ein paar Neuigkeiten unter der Haube. Augenscheinlich für mich war das andere Fontaliasing und der Software-Center. Der ist ganz nett zum stöbern, leider kann man nur ein Programm gleichzeitig installieren. Somit ist für mich Synaptic immer noch das Mittel zur Wahl. Aber ganz nett ist es.

Ubuntu One

Ach ja, Ubuntu One gibt es ja auch noch! Auf den ersten Blick nichts wirklich neues. Jeder kann jetzt auf 2GB Plattenplatz auf einem Ubuntu (Canonical)-Server verwenden zur Ablage eigener Dateien. Wer mehr Platz braucht (50GB) kann 10 US$ löhnen und diese dann erhalten. Das ist nett, bieten ja aber mittlerweile einige Anbieter an.

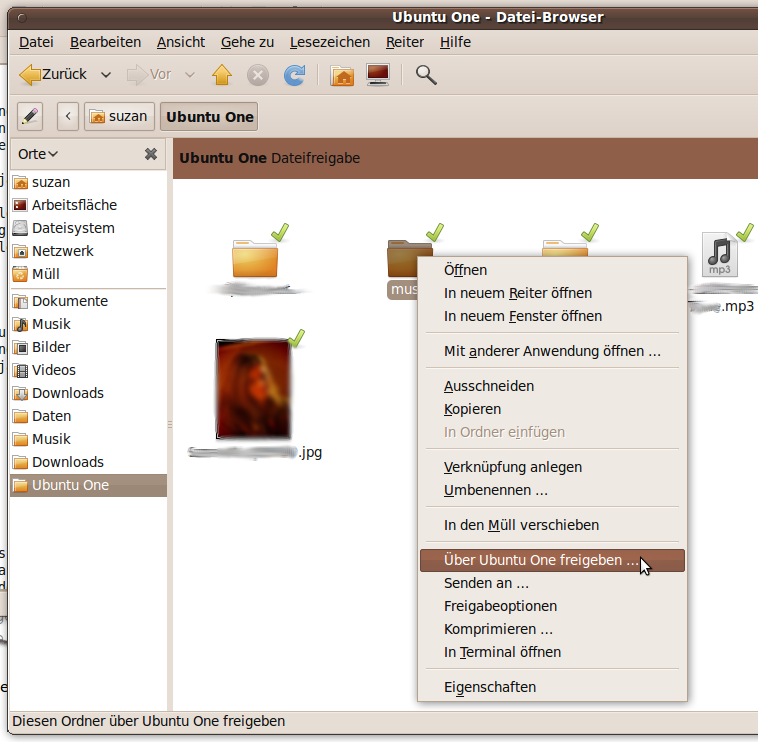

Was aber wirklich sehr schön daran ist, ist die Integration in den Ubuntu-Desktop.

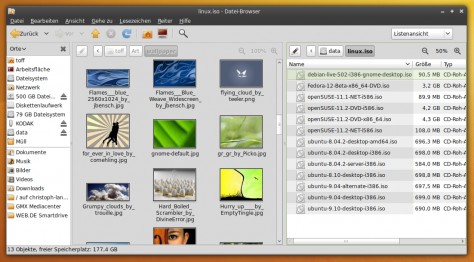

Ubuntu One Integration in Nautilus

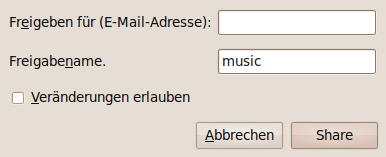

Ganz bequem kann man hier über den Nautilus-Filemanager Dateien auf den Server hochladen und auch Order für andere freigeben.

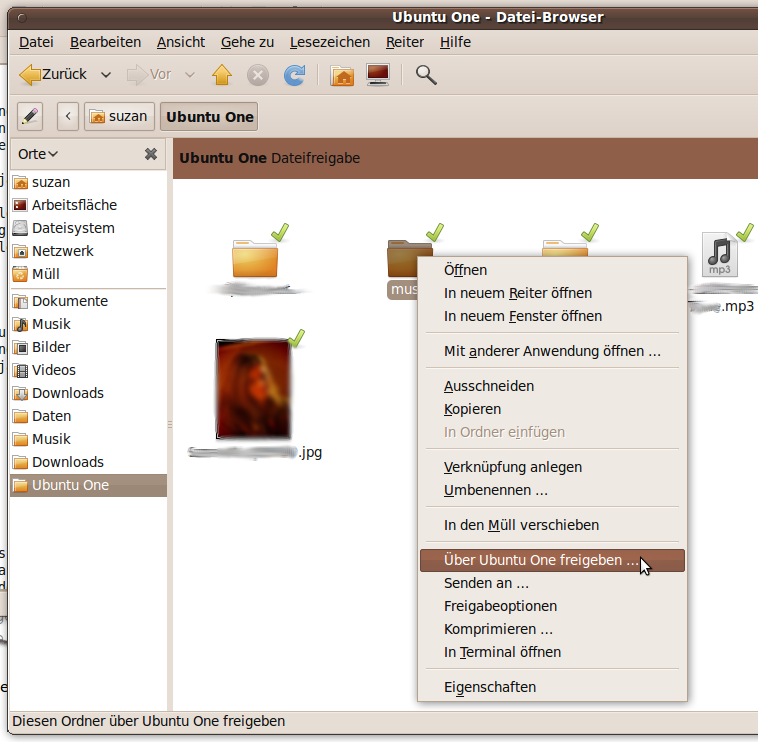

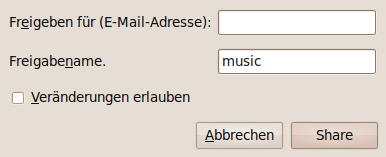

Ubuntu One - Ordner freigeben

Um Ubuntu-One nutzen zu können, benötigt man einen Launchpad-Account. Jaunty-User können Ubuntu-One auch nutzen.

OK, aber eines habe ich:

Frontmikro aktivieren

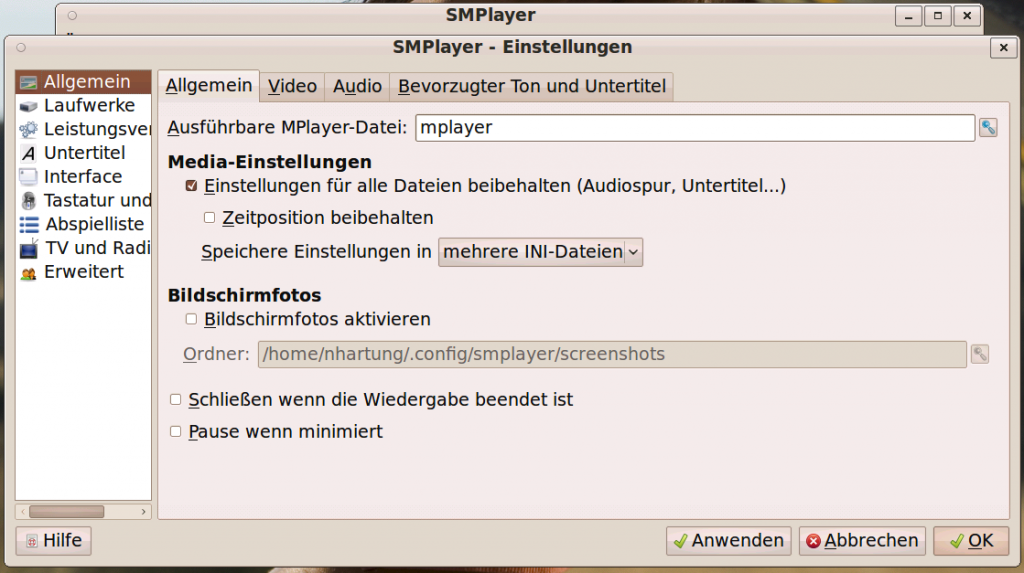

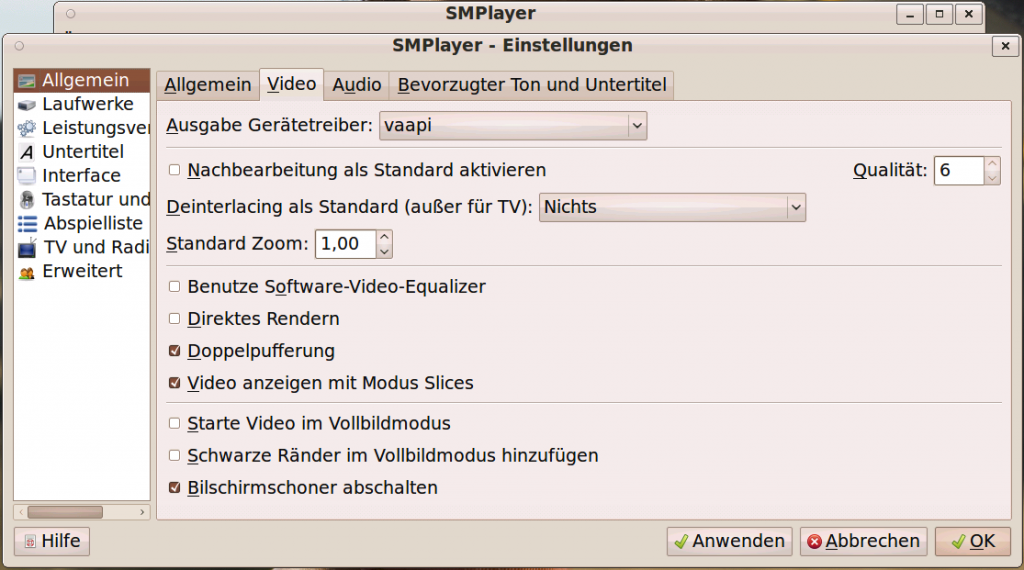

Jaaaaa…. endlich! Ich kann was berichten. Karmic setzt ja jetzt mehr denn je auf Pulseaudio. Wenn ihr mit rechtsklick auf das Laustprechersymbol klickt und dann “Einstellungen” auswählt, bekommt ihr auch nicht mehr den gewohnten Alsa-Mixer sondern die PulseAudio-Einstellungen. Diese langen leider nicht, um das das Frontmikro in Betrieb zu nehmen. Nur die Auswahl “Microphone 2″ ist leider nicht genug.

Was also tun, wenn einem das eingebaute Mikro nicht genügt und man den vorderen Mikrofon-Eingang braucht?

Hier muss man doch wieder auf den guten alten Alsamixer zurückgreifen. Dieser ist zwar nicht mehr ganz so hübsch mit der richtigen GUI erreichbar aber do doch noch mit einer “halben” GUI.

Dazu im Terminal den Befehl

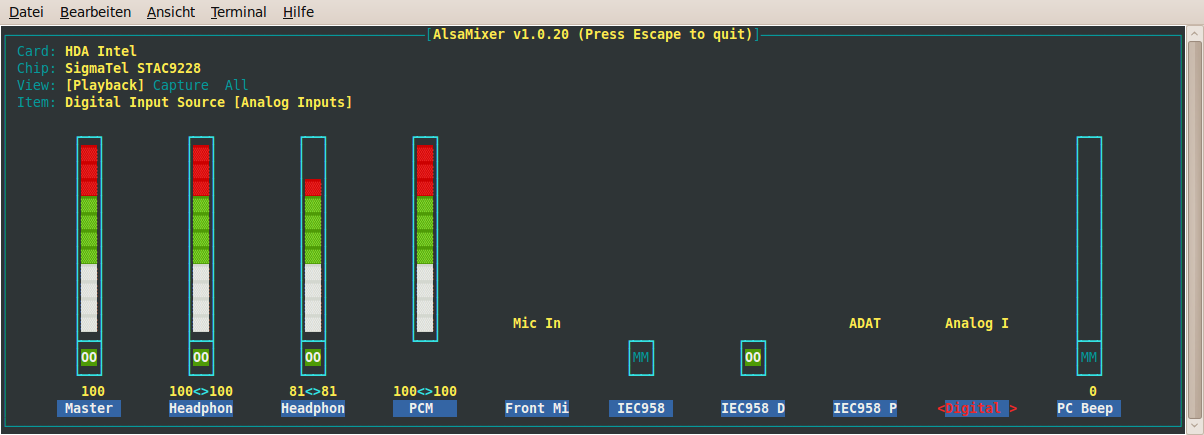

alsamixer

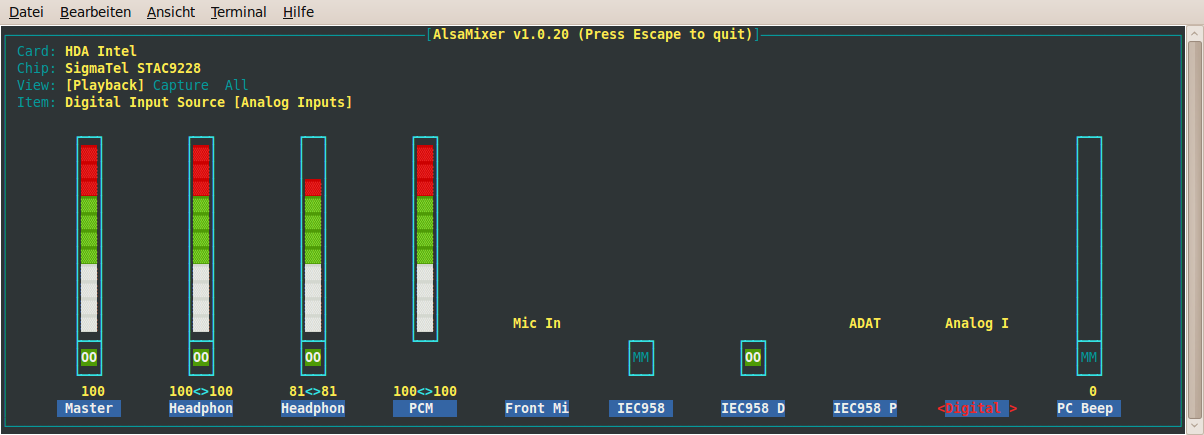

eingeben. Im Terminal bekommt ihr dann den Alsamixer. Am besten ihr zieht das Fenster etwas breiter, dann seht ihr alle Regler. Ihr seid zu Anfangs in den [Playback] Einstellungen. Seht ihr oben unter “View”. Die Einstellungen könnt ihr mit der mit der Tab-Taste durchgehen. Playback, Caputure, all.

Als erstes brauchen wir “Playback”. Hier geht ihr mit der Pfeiltaste (nach rechts) zu und wählt dort “Analog I” aus (mit Pfeiltaste nach oben/unten).

Alsamixer Playback-Einstellungen

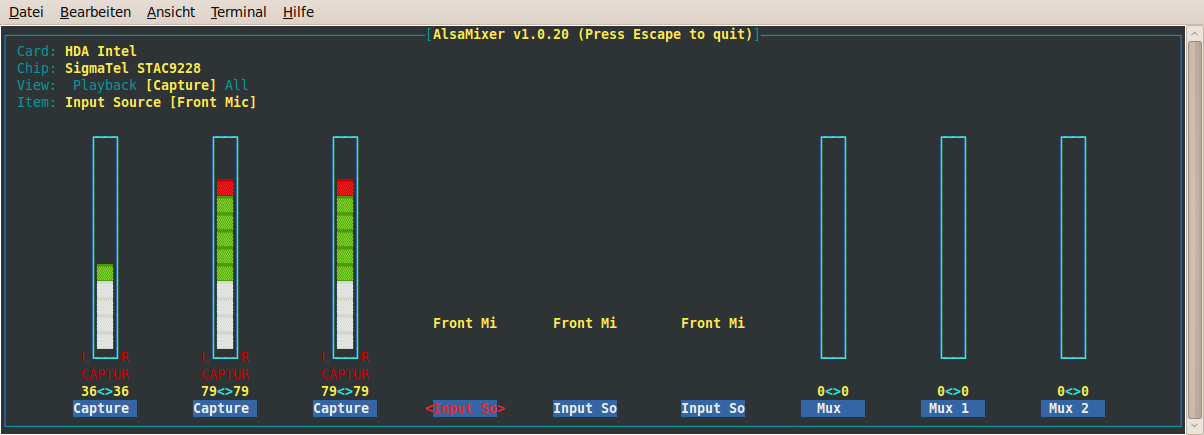

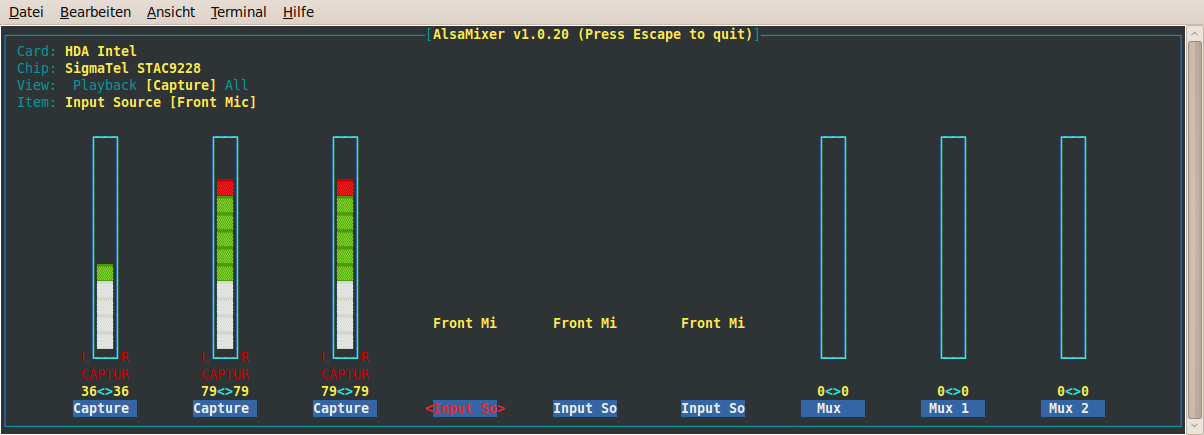

Mit der Tab-Taste nun zum Bereich [Capture] wechseln. Hier gibt es drei Input-Sources. Wie vorher wählt springt ihr mit der Pfeiltaste zu den entsprechenden Reglern und stellt diese nun (mit Pfeiltaste nach oben) alle drei auf “Front Mi”.

Alsamixer Capture-Einstellugen

Mit der Escape-Taste beendet ihr den Alsamixer.

Das war’s auch schon. Zum Test einfach mal ein Mikrofon in den vorderen Eingang stecken und einfach mal mit dem Gnome-Audio-Recorder ausprobieren.

Nochwas zu Webcams

Die eingebaute Webcam des Dell verwendet den UVC-Treiber, der nun auch out-of-the-box von Ubuntu unterstützt wird. Ausprobiert habe ich die Cam mit Skype, Cheese und Pidgin. Camorama kann mit dem UVC-Treiber leider nicht umgehen, da immmer noch nur V4L unterstützt wird, nicht V4L2. Wir Camorma überhaupt noch weiterentwickelt? Wäre irgendwie Schade, wenn nicht.

Außerdem werden Webcams unterstützt, die den PWC-Treiber verwenden, wie zum Beispiel meine externe Webcam Philips SPC900NC/00. Super Teil übrigens, macht gute Bilder auch bei schlechter Beleuchtung. Mein Webcam-Tipp deswegen.

Und – endlich werden auch wieder Cams “einfach so” unterstützt, die den gspca-Treiber verwenden. Habe das mit zwei meiner alten Logictec-Cams ausprobiert.

Somit sollten jetzt wirklich die meisten Webcams unterstützt werden.

Das wars soweit von mir erstmal. Man könnte sagen, ich bin mal wieder glücklich und zufrieden mit meiner Kombination Dell-Laptop und Ubuntu. Ach ja… fällt mir ein, dass das der erste Laptop komplett ohne Windows-Installation ist. Habe diesen Laptop ja schon seit Februar und noch keine Notwendigkeit gesehen, Windows darauf zu installieren. Eine Partition habe ich dafür sogar vorgesehen, aber die ist nach wie vor leer!

Weil Roman letzte Woche schon gefragt hat, nach seinem

Weil Roman letzte Woche schon gefragt hat, nach seinem