Warum ich meine konsolenbasierte Instant-Messaging-Lösung zu schätzen weiss.

Ich habe seit 1999 ICQ, und irgendwann seit 2001 oder 2002 Trillian benutzt. Danach bin ich zu Miranda gewechselt und seit 2 Jahren bin ich überzeugter Pidgin-Nutzer. Seit ein paar Wochen bin ich dies aber mit Einschränkungen.

Ich habe auch während ich im Büro sitze Messenger laufen. Teilweise kommuniziere ich damit mit Kollegen, teilweise mit Freunden, Familie, etc., denn diese Kommunikation lässt sich leichter nebenher betreiben als ein Telefonat.

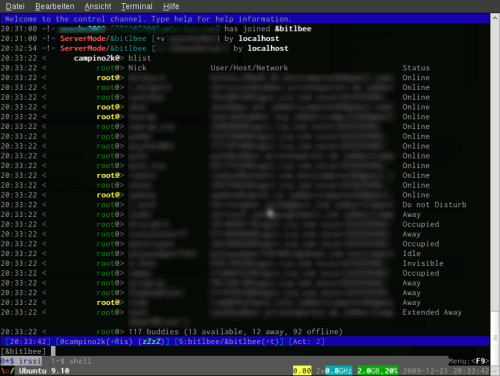

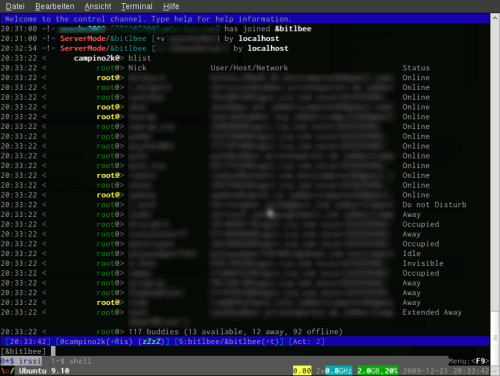

Jetzt ist es so, dass einige Personen das intensiver betreiben als andere und die Notifications von Pidgin, das blinkende Icon, der (eventuell aktivierte) Klang natürlich ständig Aufmerksamkeit auf sich ziehen. Da mich das stört und ich ja zum Arbeiten auf der Arbeit bin, nervt mich das manchmal, dass da ständig irgendwas blinkt, klingelt oder aufpoppt. Also benutze ich etwas, dass weniger Aufmerksamkeit erzeugt:

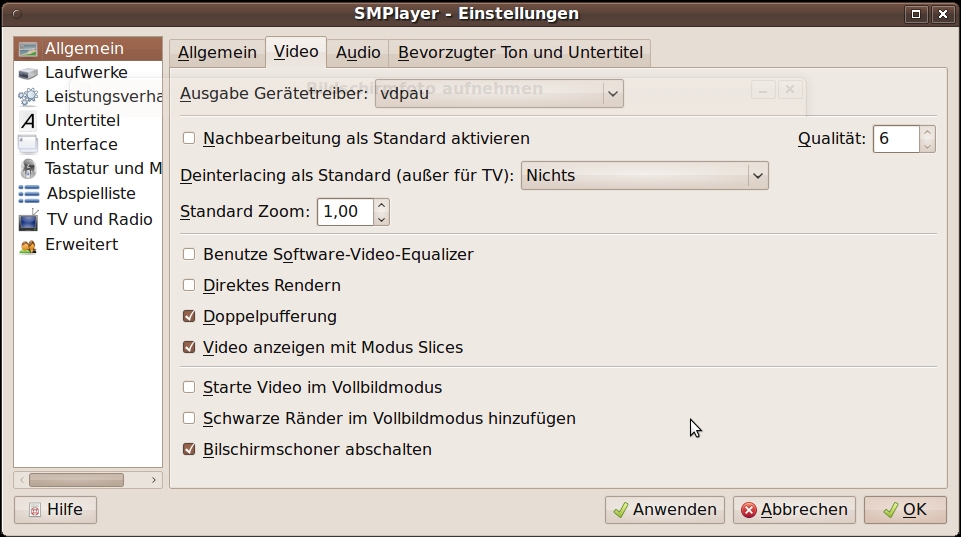

Eine Konsole in Putty oder in SSH, je nach Host-System. Als Frontend benutze ich irssi, einen IRC-Client, als Server wird bitlbee, ein IRC-IM-Gateway genutzt und das ganze hübsch und weich eingepackt gepackt in eine Screensession (wodurch meine Instant-Messenger-Accounts 24/7 online sind). Das ganze lenkt nicht ab und ich sehe dann rein, wenn ich will oder kann. Umgelegt auf die einzelnen Protokolle – bitlbee versteht OSCAR (AIM/ICQ), Jabber und MSN bedeutet das für das Handling folgendes:

Jabber-Accounts

Wer Jabber/XMPP/Google Talk kennt, weiss, dass es dort, im Gegensatz zu anderen bekannten und verbreiteten Messaging-Clients, problemlos möglich ist, von mehreren Orten aus eingeloggt zu sein. Gleichzeitig, versteht sich. Wenn ich also weiss, dass Kollegen, die vornehmlich über Jabber mit mir kommunizieren, dringend häufiger mit mir “chatten” wollen bzw. müssen, dann schalte ich einen lokalen Messenger (Pidgin) hinzu.

Die proprietären Messenger

Bei ICQ, AIM, MSN schaut es nicht so rosig aus, allerdings benutze ich zur Zeit eigentlich nur ICQ und MSN. Alle Messenger erlauben nur das gleichzeitige Login mit einem Rechner zur gleichen Zeit. Daher laufen diese derzeit ausschließlich über bitlbee.

Filetransfer, Gruppenchats & Co.

Klar. Irgendwo muss man Abstriche machen. Smilies in einer Konsolenanwendung sind nicht so der Bringer, sprich, in der Regel ziemlich oldschool, nämlich mit Text. Keine Bilder. Ebenso gibt es mit bitlbee keine mir bekannte Möglichkeit, einen Filetransfer zu initiieren. Für mich wäre es sowieso witzlos, da meine zu versendenden Daten ja im Zweifelsfall auf dem Rechner liegen, auf dem ich gerade bin, während bitlbee auf meinem Server zuhause läuft.

Gruppenchats sind hingegen relativ einfach in bitlbee zu erstellen, allerdings habe ich hier schon mit dem ICQ-Gruppenchat ein paar Probleme zwecks Darstellung von HTML-Tags in den Nachrichten gehabt, die wurden um jede Message eines anderen ICQ-Benutzers drumgelegt, was es ungeübteren Personen etwas schwer machen dürfte, da durchzublicken.

Fazit

Nach all dem, was Messenger heute können und wollen und tun, kann ich mich mit bitlbee auf das wesentliche konzentrieren und bestimme selbst, wann ich und wie ich schreibe oder Nachrichten lese. Das ist in einem gewissen Sinn eine Rückbesinnung auf die Grundidee des Instant Messaging. Nichts nerviges wie Spiele oder Sounds.

Und einen Vorteil hat es außerdem: Mein Handy verfügt über einen SSH-Client, dadurch kann ich auch mit dem Handy auf IRC und Instant Messaging zugreifen.

Ach ja: einen Nachteil für die Kontakte gibts noch: Ich brauche ab und zu länger zum antworten. Online sein heisst ja für mich damit nicht mehr “am Rechner” bzw. “mit der eeeBox verbunden sein”.

![]() .

.![]()