Wenn es einen Trend im 21. Jahrhundert im Internet gibt, dann ist es sicherlich das Cloudcomputing. Anbieter hierfür sprießen wie Pilze aus dem Boden, selbst Canonical, die Firma hinter Ubuntu, bietet so etwas mittlerweile an.

Wenn es einen Trend im 21. Jahrhundert im Internet gibt, dann ist es sicherlich das Cloudcomputing. Anbieter hierfür sprießen wie Pilze aus dem Boden, selbst Canonical, die Firma hinter Ubuntu, bietet so etwas mittlerweile an.

Momentan sind es noch nicht so viele Benutzer, aber ich bin mir sicher dass in den nächsten Jahren dieser Trend immer weiter getrieben wird, bis letztendlich das Alltagsgeschäft über einen fremd gehosteten Dienst abgewickelt wird.

Über die moralischen Bedenken des Cloudcomputing habe ich hier im Blog bereits das eine oder andere Mal geschrieben, auch viele andere Blogger und Podcaster haben schon oft darüber gesprochen.

Selbst die Befürworter (zu denen ich mich glaube ich zähle) müssen irgendwann einknicken und gestehen: Technisch ist es selbstverständlich möglich, dass Fremde auf meine Daten zugreifen könnten. Daran gibt es überhaupt keinen Zweifel. Im Idealfall ist es nur der Anbieter des Dienstes, im Extremfall sind es böswillige Hacker von außerhalb.

Wenn man sich darüber Gedanken macht, wer alles die Daten einsehen könnte, kommt man leicht ins Grübeln und überlegt sich lieber mehrfach, welche Daten für die Wolke geeignet sind und welche nicht. Für skeptische Benutzer ist es natürlich ein gefundenes Fressen, wenn man mit dem Argument kommt: „Lad’ doch nur Sachen hoch, bei denen du kein Problem hätt’st, wenns dei’ Nachbar seh’n würd’“, denn wenn es danach ginge, bräuchte man gleich gar keine Daten in die Cloud laden.

Doch dieses Argument wird hinfällig, wenn man sich ein paar Minuten mit der Open Source Software Truecrypt auseinandersetzt. Hierbei handelt es sich um ein Verschlüsselungsprogramm. Damit ist es auf den drei gängigen Betriebssystemen (Linux, Mac OS und Windows) möglich, Ordner (sog. Container) zu verschlüsseln und quasi als Datentresore auf der Festplatte oder in der Cloud zu speichern.

Truecrypt installieren und Container anlegen

Truecrypt kann man sich für Linux, Mac OS und Windows auf der offiziellen Downloadseite herunterladen. Danach das Archiv entpacken und den Installer ausführen. Für Linux gibt es hier eine ausführlichere Anleitung.

Interessant wird der Spaß ja erst jetzt, man muss einen Container anlegen. Vorher muss man sich leider über die Größe des Containers im Klaren sein, denn meines Wissens nach gibt es keine Möglichkeit, die Größe im Anschluss daran zu verändern. Also: Was will man in den Safe packen, wieviel Speicherplatz steht mir in der Cloud zu und welche Größe würde meine Internetverbindung mitmachen?

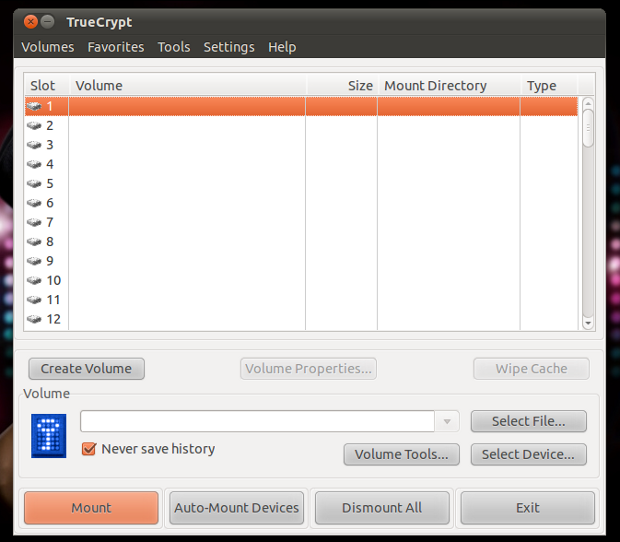

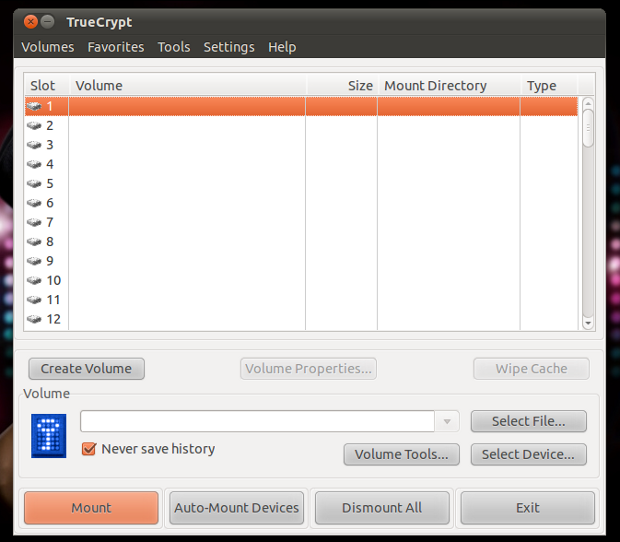

Das Anlegen des Containers selbst scheint eine Wissenschaft für sich zu sein, ist es im Endeffekt aber nicht. Eigentlich muss man nur auf „Create Volume“ klicken, danach öffnet sich ein Assistent.

Da wir hier keine gesamte Partition, sondern nur einen Container verschlüsseln wollen, lässt man im ersten Schritt die Standardeinstellung auf „Create an encrypted file container“. Im nächsten Schritt wird man gefragt, ob man einen Standard- oder einen versteckten Container anlegen will, Standard ist hierfür richtig.

In „Volume Location“ wird es nun interessant. Auf dem Button „select file“ gelangt man in den Standardbrowser des Betriebssystem und wird aufgefordert, einen Speicherort für den Container anzugeben. Ich habe, da ich den Container mit Dropbox synchronisieren möchte, im Dropboxordner einen Unterordner „Privat“ angelegt und darin den Container „Rechnungen“ verpflanzt.

Danach kommt der Verschlüsselungsalgorithmus. Hier gehen sicherlich die Meinungen auseinander, ich habe mich für die Mischung aus AES, Twofish und Serpent entschieden. Nun muss man die Größe des Containers festlegen. Wie gesagt, oben stehende Gesichtspunkte beachten.

Jetzt geht es ans Eingemachte: Passwort festlegen. TrueCrypt motzt solange herum, bis man ein mindestens 20 stelliges Passwort festlegt. Jetzt liegt es natürlich im Auge des Betrachters, wie stark er sein Passwort wählt. Auch Keyfiles können gewählt werden. Bei dieser Methode muss man beachten, dass es sehr unklug ist, die Keyfiles unverschlüsselt in der Cloud zu speichern, dann kann man es auch gleich weglassen. Gut ist es z.B. wenn man es auf einem USB-Stick immer mit sich herumträgt. Blöd ist es nur, wenn man das Keyfile verliert, denn dann hat man sich ausgesperrt…

Als Filesystem würde ich FAT auswählen, weil dabei sichergestellt ist, dass es alle Betriebssysteme unterstützen.

Dateien hinzufügen und auch wieder benutzen

Mit den Containern ist das so: Man hat eine Datei die man nicht öffnen kann, denn eigentlich ist es ein Laufwerk. Mit dem Frontend von TrueCrypt kann man es einhängen und hat danach quasi ein neues Laufwerk, auf dem man Dateien bearbeiten, hinzufügen, löschen oder einfach nur lesen kann. Wenn man es aushängt, ist es wieder verschlüsselt.

Habt ihr einen Container angelegt, öffnet Truecrypt. Wählt zuerst einen der leeren Slots in der Liste oben im Hauptfenster, klickt danach auf „Select File…“ und wählt euren Container aus. Klickt danach auf „Mount“ unten links im Fenstereck.

Gebt die Passwörter und ggf. die Keyfiles an, und schon ist der Container offen.

Wenn die Arbeit im Container abgeschlossen ist, kann man ihn im TrueCrypt Frontend mit einem Klick auf „Dismount“ wieder verschlüsseln. ACHTUNG! Erst jetzt beginnt die Synchronisation mit der Cloud!

Sonst noch etwas beachten?

Ja. Der Container hat die festgelegte Größe, egal ob der Container „voll“ oder „leer“ ist. Bei einer Änderung (z.B. hineinschieben einer kleinen Datei) und dem anschließenden Aushängen des Containers würde die Synchronisations-software den gesamten Container synchronisieren. ALLES, egal wieviel geändert wurde. Doch Caschy hat herausgefunden, dass es auch anders geht.

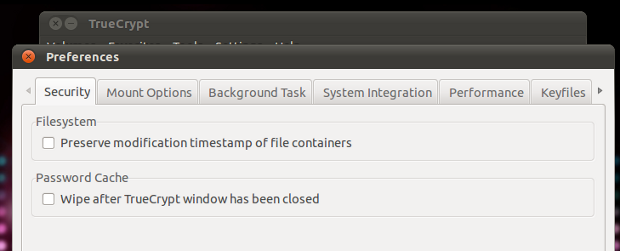

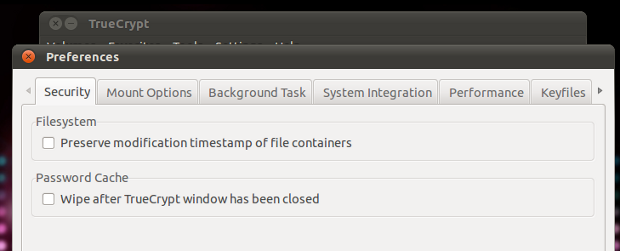

Geht im Hauptfenster von TrueCrypt auf Settings → Preferences. Deaktiviert hier den Haken bei „Preserve modification timestamp of file containers“. Nun wird nach dem Aushängen des Containers nicht mehr das gesamte Monstrum, sondern wirklich nur die veränderten Daten hochgeladen.

Noch kein Dropbox?

Noch kein Dropbox?

![]()

Wenn es einen Trend im 21. Jahrhundert im Internet gibt, dann ist es sicherlich das Cloudcomputing. Anbieter hierfür sprießen wie Pilze aus dem Boden, selbst Canonical, die Firma hinter Ubuntu, bietet so etwas mittlerweile an.

Wenn es einen Trend im 21. Jahrhundert im Internet gibt, dann ist es sicherlich das Cloudcomputing. Anbieter hierfür sprießen wie Pilze aus dem Boden, selbst Canonical, die Firma hinter Ubuntu, bietet so etwas mittlerweile an.

Aus Testzwecken habe ich auf meinem Lastesel Ubuntu Natty mit Gnome 3 installiert. Erstaunlicherweise funktioniert alles wunderbar. Neben ein paar kleiner Bugs, welche mich nicht wirklich stören, funktionierte Empathy überhaupt nicht. Aus irgendeinem Grund wollte es nicht mit dem Gesichtsbuch verbinden. Nach dem Google keinen wirklichen Rat auf mein Problem hatte, versuchte ich mein Glück auf Twitter und siehe da, ich wurde fündig. Zwar war die

Aus Testzwecken habe ich auf meinem Lastesel Ubuntu Natty mit Gnome 3 installiert. Erstaunlicherweise funktioniert alles wunderbar. Neben ein paar kleiner Bugs, welche mich nicht wirklich stören, funktionierte Empathy überhaupt nicht. Aus irgendeinem Grund wollte es nicht mit dem Gesichtsbuch verbinden. Nach dem Google keinen wirklichen Rat auf mein Problem hatte, versuchte ich mein Glück auf Twitter und siehe da, ich wurde fündig. Zwar war die