Keinen Monat nach dem Ende des Humble Frozen Synapse Bundle ist nun das Humble Voxatron Debut erschienen. Das “Bundle” beinhaltet wieder nur einen Titel – Voxatron. Und wieder ist das Spiel einfach nur klasse…

Auf der Humble Bundle Homepage wird Voxatron ein “old-school-gone-new platform shooter” genannt. Das, finde ich, trifft es recht gut. Die Grafik ist sehr grob. Die Umgebung und die Figuren sind aus Blöcken/Voxels zusammengesetzt. Auch der Sound erinnert an “längst vergangene Tage”. Trotzdem ist das Gameplay aber natürlich nicht altmodisch.

Wichtig ist, zu wissen, dass das Spiel derzeit als Alpha-Version verkauft wird. Kommende Updates bekommt man als Käufer des Humble Bundles aber.

Ein Video findet sich ebenfalls auf der Bundle Homepage. Das lässt schon sehr gut erahnen, wie das Spiel läuft.

Für diejenigen, die das Humble Bundle bislang noch nicht kennen, hier ein paar Stichpunkte:

- Das Angebot gilt nur zeitlich begrenzt (~ 14 Tage).

- Das Bundle kann zu einem selbst bestimmten Preis bezogen werden. Bezahlt wird per PayPal, Amazon Payments oder Google Checkout.

- Der Download kann kurz nach der Bezahlung begonnen werden. Der Key zur Downloadseite soll unbegrenzt bestehen bleiben.

- Die angebotenen Spiele laufen i.d.R. auf den großen drei Plattformen: Windows, Mac und natürlich Linux.

- Der bezahlte Preis kann beliebig auf die Spiele-Entwickler, das Humble Bundle und auf zwei wohltätige Organisationen aufgeteilt werden.

Weitere persönliche Eindrücke vom Spiel werde ich in den nächsten Tagen in diesem Artikel online stellen – nachdem ich das Spiel noch etwas besser kennen gelernt habe…

UPDATE 02.09.2011:

Mittlerweile wurde das Bundle zum echten Bundle, in dem es um zwei Spiele erweitert wurde (die beiden anderen Spiel gibt’s allerdings nur dazu, wenn man mehr als den Durchschnittspreis bezahlt). Zudem, denke ich, kann ich nun zu allen Spielen etwas schreiben:

Voxatron

Ein tatsächlich cooles Spiel. Die Grafik ist der Hit: alles ist aus Voxels (soz. ein 3D-Pixel) zusammengesetzt, der Raum, die Gegenstände usw. Wenn man auf Gegenstände schießt, entstehen daran Schäden, man schießt also Voxels aus dem Gegenstand heraus. Und wenn es schneit, dann sieht das so aus, dass Voxels vom Himmel kommen und diese liegen bleiben.

Grafik, Sound und Fun sind also gegeben. Wie lange das Spiel begeistern kann ist tatsächlich noch offen. Toll ist natürlich auch der integrierte Level-Editor. Wer will kann einfach von der Community erstellte Levels spielen. So gibt es z.B. ein Level, in dem ein User den Raum wie einen Mac-Shop aussehen ließ (das derzeit wohl beliebteste User-Level).

Mit der Steuerung kämpfe ich immer noch etwas – ist aber machbar. Der Adventure-Modus kann schon relativ hart sein. Dabei stört mich etwas, dass man nicht mehr in alte Räume zurück kann und dort vielleicht noch Gegenstände einsammeln kann. Ist man zu Beginn eines Raumes stark geschwächt muss man den Raum wohl oder übel so überstehen.

Übrigens merkt man dem Spiel seinen Alpha-Status überhaupt nicht an!

Blocks That Matter

(Derzeit) das Spiel im Bundle mit dem besten Spiel-Prinzip. Vereinfacht gesagt, steuert man einen Roboter der durch eine zweidimensionale Welt läuft und springt. Er kann á la Mario “Steine” auflösen – per Sprung von unten dagegen. Diese Steine wandern dann aber ins Inventar des Roboters. Genauso Steine, die seitlich mit einem Bohrer angebohrt werden. Aus den gesammelten Steinen, kann/muss man sich dann im Puzzle-Modus Brücken und Stufen bauen, um ans Ziel zu kommen.

Nicht leicht zu erklären. Schaut euch das Video auf der Webseite des Spiels an!

Ein Hinweis noch für die Installation unter Ubuntu: das Programm ist wohl in Java geschrieben, daher braucht man ein JRE – das sollte ja aber i.N. schon vorhanden sein. Außerdem müssen per Paketverwaltung noch die beiden Pakete libopenal1 und liblwjgl-java installiert werden. Vorher lässt sich das Programm nicht starten. (gilt wohl nur für die .tar.gz-Variante. Wenn man das .deb-Paket installiert ist das nicht notwendig)

The Binding of Isaac

Ein für mich enttäuschendes Spiel. Ich kann wirklich nicht so richtig erkennen, was hier den Reiz ausmachen sollte. Die einleitende Story war eigentlich noch ganz nett. Das Spiel danach war dann aber mehr als langweilig…

pssst, weitersagen!

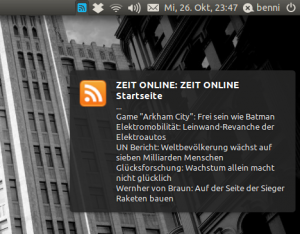

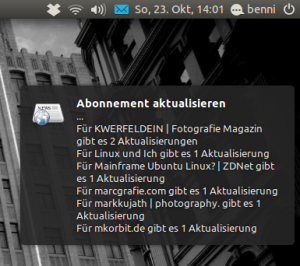

Mit dem GNOME-eigenen RSS-Feedreader Liferea kann man bequem die Feeds seiner Lieblingsnachrichtenseiten abonnieren. Das Programm ist sehr leicht und verständlich aufgebaut und lässt sich intuitiv bedienen. Über den +Button kann man neue Abos hinzufügen, diese erscheinen dann in der Liste und werden regelmäßig aktualisiert. Nun muss man in den Einstellungen noch an der richtigen Stelle einen Haken setzen, und schon wird man über neue Nachrichten informiert. ABER: Man sieht nur, DASS es neue Nachrichten gibt, nicht wie sie lauten.

Mit dem GNOME-eigenen RSS-Feedreader Liferea kann man bequem die Feeds seiner Lieblingsnachrichtenseiten abonnieren. Das Programm ist sehr leicht und verständlich aufgebaut und lässt sich intuitiv bedienen. Über den +Button kann man neue Abos hinzufügen, diese erscheinen dann in der Liste und werden regelmäßig aktualisiert. Nun muss man in den Einstellungen noch an der richtigen Stelle einen Haken setzen, und schon wird man über neue Nachrichten informiert. ABER: Man sieht nur, DASS es neue Nachrichten gibt, nicht wie sie lauten.