Hinweis vorab: Der Artikel ist in der heute erschienenen Ausgabe 05/2012 von freiesMagazin veröffentlicht wurden.

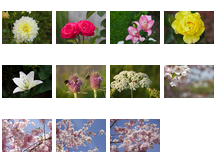

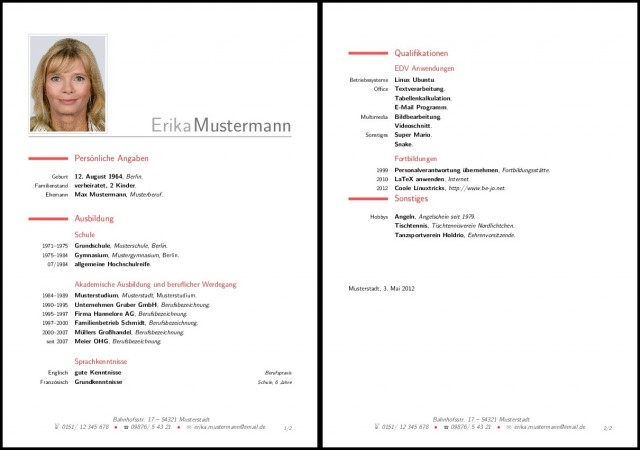

Ob im wissenschaftlichen oder privaten Bereich. Möchte man die volle Kontrolle über das Aussehen seiner erstellten Dokumente behalten, führt oft kein Weg an LaTeX vorbei. Auch freiesMagazin basiert auf den vielfältigen Möglichkeiten von LaTeX .

Eine LaTeX – Umgebung ist mit TeX – Live auch recht schnell auf allen Betriebssystem eingerichtet. Dieser Standardweg zeigt jedoch ein paar Restriktionen auf. Sowohl die Online-Verfügbarkeit des Dokuments von jedem Ort aus, sowie der kollaborative Ansatz, dass mehrere Personen zeitgleich an einem Dokument arbeiten können, ist mit den Standardmitteln der Desktop – installation nicht zu erreichen.

Daher sollen nachfolgend Lösungsansätze vorgestellt werden, die versuchen die gewünschten Zusatzfunktionen bereitzustellen.

Cloud – Anbieter oder eigene Hosting – Lösung?

Vorangestellt sei an dieser Stelle angemerkt, dass es zwei grundlegende Optionen gibt um das Ziel der Kollaboration in Verknüpfung mit der Online – Verfügbarkeit zu erreichen:

- Hosting der LaTeX – Dokumente bei einem Cloud-Dienstleister

- eigener Server in Verbindung mit einem Versionskontrollsystem (SVN, Git, Mercurial usw.)

Die Vor – und Nachteile sind grundsätzlich nicht verschiedenen zur klassischen Diskussion über Nutzen und Gefahren des sogenannten Cloud-Computing, bei dem alle Daten und die eigentliche Anwendung auf die Infrastrukturen eines Anbieters ausgelagert werden und in dessen Verantwortungsbereich liegen.

Ebenso sollte man sich im Voraus Gedanken zu Sicherheit und Seriösität des entsprechenden Anbieters machen. Auch die mögliche Gefahr einer plötzlichen Schließung des Dienstes mit dem eventuellen Verlust seiner Daten gehört stets mit in die Risikobetrachtung.

Dennoch bieten die Cloud-Lösungen für den Anwender eine schnelle und komfortable Einrichtung, die in der Regel in wenigen Sekunden bereitsteht.

Online – LaTeX Editoren

Durch den zunehmenden Fortschritt der Webtechnologien und den deutlich größer werdenden Möglichkeiten Dokumente in Echtzeit über das Internet zu bearbeiten, haben sich verschiedene Anbieter etabliert, die eine bereits fertig konfigurierte LaTeX – Umgebung bereitstellen.

So findet man neben dem reinen Online – Editor mit integriertem Syntax – Highlighting auch Möglichkeiten, die erstellten Dateien auf dem jeweiligen Server zu kompilieren und anschließend zu betrachten.

Um eine für sich geeignete Auswahl zu treffen, bietet sich ein Vergleich der gängigsten Anbieter an.

Hinweis:Es werden jeweils nur die kostenlosen Angebote der einzelnen Angebote getestet, viele Anbieter können jedoch über Abgabe eines kleinen Betrages zusätzlich erweitert werden.

ScribTeX

Ein interessantes Angebot macht das seit Januar 2009 am Markt bestehende ScribTeX. Nach einer kurzen Registrierung auf der Webseite kann man 3 verschiedene Projekte anlegen und insgesamt 50 MB an Speicher für seine Dokumente und Bilddateien etc. verwenden.

Leider stehen in der kostenlosen Version die Möglichkeiten der kollaborativen Bearbeitung an Dokumenten nicht zur Verfügung, wodurch das ansonsten gute Angebot etwas getrübt wird.

Der Editor und die Benutzeroberfläche wirkt aufgeräumt. Es stehen einem in der Menüleiste lediglich die Möglichkeiten zu speichern, Kommentare zu verfassen und das Dokument zu kompilieren zur Verfügung.

Nach den Klick auf Compile wird das Dokument im Hintergrund kompiliert und man bekommt im Anschluss das fertig gerenderte PDF-Dokument in einer Vorschau oder alternativ zum Download angeboten. Der Kompilierungsvorgang geht schneller als auf meinem Desktop-Rechner.

Sofern Fehler auftreten oder Warnungen seitens des LaTeX – Compilers auftreten, sind diese jederzeit im Reiter Log der PDF-Vorschau einsehbar.

Die Vorteile von ScribTeX liegen neben der Versionskontrolle für die einzelnen Dateien besonders auf der Unterstützung für das Versionskontrollsystem Git für all seine Projekte.

Insgesamt mach ScribTeX einen ordentlichen Eindruck, die fehlenden Möglichkeiten der Zusammenarbeit in der kostenlosen Version trüben jedoch den guten Eindruck ein wenig.

ShareLaTeX

Im Gegensatz zu ScribTeX ist ShareLaTeX noch ein junges Projekt, welches sich aktuell noch in der Beta-Phase befindet, ohne jegliche Differenzierungen zwischen Bezahlaccounts und kostenlosen Accounts.

Der Aufbau und die Funktionsweise ist ähnlich komfortabel wie bei ScribTeX, auch hier stehen ein Online-Editor zur Verfügung, der neben Syntx-Highlighting auch die zugehörigen Klammernpaare anzeigt. Einzig ein Befehlsvorschlag mit den in Frage kommenden Befehlen, wie man es aus gewöhnlichen Entwicklungsumgebungen kennt, wäre wünschenswert.

Der Vorteil von ShareLaTeX liegt vor allem auch im Bereich der Kollaboration. Es ist sehr einfach über die Einstellungen einen weiteren Benutzer zum aktuellen Projekt mit Lese- und Schreibberechtigungen auszustatten, sodass der Zusammenarbeit nichts entgegen steht.

In Zukunft denkt man zur Refinanzierung des Projektes darüber nach, die Anzahl der Projekte zu limitieren, es soll aber jederzeit einen kostenlosen Account geben.

Man sollte hier jedoch beachten, dass die Allgemeinen Bedingungen, derzeit noch bearbeitet werden, die man sich nach Ablauf der Beta-Phase noch einmal anschauen sollte.

writeLaTeX

Ein dritter Vertreter der sogar komplett ohne Registrierung auskommt ist writeLaTeX.

Die Bedienung ist hier sehr einfach und intuitiv, denn nach dem Klick auf Start Writing Now wird man automatisch zu einem LaTeX Dokument weitergeleitet, welches direkt bearbeitet werden kann.

Hierfür wird ein eindeutiger Link generiert, den man jetzt einfach seinen Freunden und Mitarbeitern am Projekt weiterleiten kann, die dann ebenfalls direkt mit dem Editieren des Dokuments beginnen können.

Die gesamte Benutzeroberfläche ist hier direkt in zwei horizontale Fenster geteilt, wodurch man mit einer kurzen Verzögerung das Ergebnis direkt auf der rechten Seite sieht, welches man im Code – Editor auf der linken Seite definiert hat.

Das Projekt setzt auf dem durchaus populären Etherpad auf, welches bereits die komfortablen Möglichkeiten der gemeinsamen Online – Bearbeitung von Dateien in mehren Projekten bewiesen hat (siehe u.a. auch das Piratenpad der Piratenpartei)

Generell ist writeLaTeX eines der einfachsten und schnellsten Möglichkeiten gemeinsam an LaTeX – Dokumenten zu arbeiten. Es besteht ebenfalls die Möglichkeit weitere Dokumente hochzuladen, sowie das PDF – Dokument bzw. alle Dateien als Zip-Datei anschließend herunterzuladen. Hier ist man allerdings auf maximal 10 zusätzlich hinzufügbare Dateien (Bilder, .tex – Dateien, Bibliographie – Dateien usw.) limitiert, wodurch writeLaTeX eher für relativ kleine und schnell umzusetzende Projekte geeignet ist.

LaTeX Lab

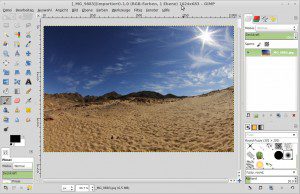

Einen etwas anderen Ansatz als die bisher vorgestellten Lösungen verfolgt LaTeX Lab. Das Projekt steht unter der Apache Licence Version 2 und wird auf Google Code gehostet.

Es setzt direkt auf einer der bekanntesten Plattformen für Zusammenarbeit an Texten auf, nämlich auf Google Docs und integriert in dieses einen LaTeX – Editor.

Demzufolge muss man sich hier auch nicht neu registrieren, sondern man muss über OAuth lediglich der Anwendung den Zugriff auf Google Docs erlauben, damit LaTeX Labs auch die Dateien im Google Docs Account speichern kann. Voraussetzung ist hierfür lediglich, dass man auch bereits einen Google – Account angemeldet hat.

Der Vorteil liegt hier auf der Hand. Man nutzt die Google Technologien und hat ein einheitliches Bild wie aus Google Docs bekannt, lediglich mit den speziellen Funktionen auf LaTeX angepasst.

Generell erinnern die Funktionen am ehesten an die Funktionen, die man aus den klassischen Desktop-Umgebungen wie Kile oder Texmaker kennt. So stehen u.a. Möglichkeiten über das Menü zur Verfügung, um sich Aufzählungen generieren zu lassen, mathematische Zeichenbefehle ausgeben zu lassen, grundlegende Formatierungen zu nutzen u.v.m.

Über die Iconleiste hat man zudem einfach die Möglichkeit das Dokument zu kompilieren und als PDF – Vorschau im Browser angezeigt zu bekommen.

Der große Vorteil liegt bei LaTeX Labs an der tiefen Integration mit Google Docs. So kann man hier 1 GB an Daten speichern und hat die Dokumente bei seinen normalen Dokumenten jederzeit verfügbar, sofern man keine Aversionen allgemeiner Art gegenüber Google hegt.

Zudem steht auch bei Google Docs standardmäßig eine Versionierungsoption zur Verfügung, in dem man auf vorherige Versionen zurückspringen kann, falls man einmal diese früheren Änderungen braucht.

Eigene Hosting Lösung über ein Versionskontrollsystem

Wer seine Daten nicht aus der Hand geben will, weil er entweder den vorgestellten Anbietern der verschiedenen Dienste nicht vertraut oder weil es einfach vertrauliche Dateien sind, die keinem Cloud-Anbieter anvertraut werden sollten, kann sich dennoch behelfen eine möglichst umfangreiche Zusammenarbeit und Verfügbarkeit seiner Dokumente zu erreichen.

Hierfür benötigt es lediglich einen eigens aufgesetzten Server. Grundsätzlich ist es egal ob man diesen mit einem zentralen Versionskontrollsystem wie Subversion, oder einem dezentralen System mittels Git installiert.

In Betrachtung der Möglichkeiten der Versionierung und Nachvollziehbarkeit, wer welche Änderungen am Dokument vorgenommen hat, sind diese durchaus den Online – Lösungen überlegen, die häufig nur eine gewisse Anzahl an Änderungen in der Versionshistorie abspeichern, während man bei SVN & Co alle Änderungen von Beginn des Dokuments einsehen kann.

Der Nachteil liegt eher bei der Zusammenarbeit in Echtzeit. Man kann hier nicht direkt die Änderungen am Dokument so komfortabel verfolgen, wenn man nicht ständig Updates der Quelldateien machen möchte. Hier sind die Online – Tools deutlich im Vorteil.

Im Gegenzug ist man bei der Projektgröße oder der Anzahl an Mitarbeitern am Projekt auf keinerlei Limitierungen von fremden Anbietern angewiesen, sondern einzig auf die Limitierungen die der selbst aufgesetzte Server besitzt.

Bei freiesMagazin setzt man ebenfalls auf die eigene Hosting – Lösung mit einem Subversion – Server, da man die eigenen Daten und die der Autoren nicht aus der Hand geben will.