Es ist einfach nicht schön einen Blog mit nur einem nichts sagenden

Eröffnungspost online zu stellen. Deshalb habe ich beschlossen hier ein

CD-Review zu Ensiferum – Unsung Heroes, welches ich am 25.08.2012 für

ein privates Forum verfasst habe, online zu stellen.

In der Regel fallen meine Worte zu neuen Alben dort eher kürzer aus,

aber da ich diese CD recht ausführlich beschrieben habe, möchte ich mein

Review mit der Allgemeinheit teilen und zur Diskussion stellen. Dazu

möchte ich aber gleich anmerken, dass ich einiges heute, da die CD

mittlerweile den Dauertest bestehen musste, anders bewerten würde.

Ensiferum – Unsung Heroes

{.aligncenter

width=“250”

height=“250”}

{.aligncenter

width=“250”

height=“250”}

Die CD kommt im Digipack mit einer DVD, welche ein Studio-Tagebuch über

die Entstehung vom Album beinhaltet. Die DVD hab ich noch nicht

angeschaut, da mich das auch erst mal gar nicht interessiert. Während

asunder die CD in meine Sammlung rippt schau ich mir mal die Hardware

an:

Das Digipack ist, wie bei Ensiferum üblich, mit einer hübschen (fast

schon kitschigen) Wikinger-Zeichnung bedruckt. Ist eigentlich recht

schick, aber durch die Farbgebung (pink, wtf?) wirkt es diesmal doch

schon arg kitschig.

Wie auch bei den anderen Alben enthält das Booklet, sämtliche Texte, ein

Gruppenfoto der Band und Danksagungen.

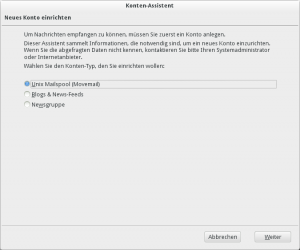

So, asunder ist auch fertig, das Album erscheint in Clementine → los

geht’s mit dem ersten Hören.

”)

”)

Symbols

Ein relativ seichtes Intro mit gezupften Klängen und später

zurückhaltendem Einsatz von Streichern und Bläsern. Relativ

nichtssagend, könnte auch Hintergrundmusik von Spielen wie Gothic oder

mittelalterlichen Filmen sein. Bisher das definitiv schwächste

Ensi-Intro.

In My Sword I Trust

Kennt man ja vom Video, ein typischer Ensiferum-Song. Nichts

außergewöhnliches aber lässt sich anhören, solide Kost wie man sie von

Ensi gewohnt ist.

Unsung Heroes

Der Titelsong beginnt erst mal in einem für Ensi ungewöhnlichen Rhythmus

entwickelt sich aber schnell zu einem typischen Ensiferum-Song mit

heiserem Gesang abgewechselt durch clean vocals und Chorgesang,

melodischen Gitarren überlagert durch Keyboardmelodien. Neu ist, dass

der Chorgesang in diesem Song teilweise klassische Tiefe hat. Ähnlich

den Gesängen in Hollenthons Opus Magnum oder Tyrants and Wraith.

Burning Leaves

Beginnt mit einer flotten, fröhlichen Melodie und führt diese auch bis

zum Rest des Liedes fort, zwischendurch wieder das obligatorische

Wechselspiel zwischen Growls (naja, ist bei Ensi ja eher heiseres

Schreien als growling

)

und clean vocals. Bei den cleanen Passagen fällt allerdings eine

Veränderung in der Gesangsart auf. So habe ich das bisher noch auf

keiner Ensi-CD vernommen. Klingt fast schon wie Mainstream-Gesang…

)

und clean vocals. Bei den cleanen Passagen fällt allerdings eine

Veränderung in der Gesangsart auf. So habe ich das bisher noch auf

keiner Ensi-CD vernommen. Klingt fast schon wie Mainstream-Gesang…

Ok, daran ist erstmals nichts auszusetzen da es gut ist wenn Bands

experimentieren und nicht jedes Lied gleich klingt, aber ich hoffe dass

sie das in den kommenden Songs und Alben nicht weiterführen.

Gegen Ende kommt es nochmal zu einer ruhigeren Stelle mit finnischem

Chorgesang.

[Nachtrag:]{style=“text-decoration: underline;“} Beim zweiten Hören

fällt mir auf, dass die cleanen Passagen etwas an Amorphis erinnern.

Celestial Bond

Ein Lied der ruhigeren Töne mit lieblichem Frauengesang. Vergleichbar

mit Mourning Heart vom 2. Album Iron.

Retribution Shall Be Mine

Nachdem mit Celestial Bond Geschwindigkeit rausgenommen und leisere

Töne angeschlagen wurden geht es hier wieder etwas ruppiger zur Sache.

Ein flotter Einstieg in den Song mit für Ensiferum-Verhältnisse

ungewöhnlich viel Bassdrum und Petri bellt die Vocals raus. Auch wenn

später dezent einsetzende Orchesterpassagen und clean vocals plus Chor

wieder kurzzeitig etwas Geschwindigkeit rausnehmen geht der Song

ziemlich “straight forward” und wird wohl ein schweißtreibender

Moshpit-Kracher für Live-Auftritte werden.

Star Queen (Celestial Bond PartII)

Das Lied startet mit einer Instrumentalen Passage, später setzen auch

E-Gitarren ein, werden aber schnell wieder rausgenommen und es folgt

Gesang in clean vocals. Zum melodischen Refrain mit Ohrwurmcharakter

dürfen die E-Gitarren dann auch wieder einsetzen.

Insgesamt ein eher softes, sehr melodisches Lied das ins Ohr geht.

Pohjola

Pohjola ist wieder ein flotterer Song, der finnisch gesungen wird. Der

Text stammt von Yrjö Koskinen (1803 – 1903), scheint also etwas älter

zu sein.

”)

”)

Die Stimmung des Liedes ist durchaus wieder sehr fröhlich, die Chöre

erinnern aber teilweise wieder etwas an Hollenthon. Später wird eine

Stelle des Liedes eher gesprochen als gesungen, was mich sehr an ein

altes Finntroll-Lied erinnert. Das Lied gefällt mir durchweg ziemlich

gut, vereinzelte Ähnlichkeiten zu Hollenthon oder Finntroll stören mich

nicht, da das beides ebenfalls gute Bands sind und es sich wirklich nur

um Ähnlichkeiten handelt. Ensiferum bleiben ihrem Stil treu, obwohl sie

auf diesem Album wieder etwas anders klingen.

Last Breath

Last Breath ist ein ruhigeres Lied ohne E-Gitarren, dafür mit Flöten

etc.

”)

Der Song transportiert eine ganz coole, teilweise etwas düstere,

Stimmung.

”)

Der Song transportiert eine ganz coole, teilweise etwas düstere,

Stimmung.

Passion, Proof, Power

Ein sehr episches Stück, welches mit orchestralen Klängen beginnt und

anschließend mit melodischem Gesang begeistert. Darauf folgen

Klavierklänge, lieblicher Frauengesang und dann treten sie aufs Gas und

starten mit E-Gitarren und dem Petri-typischen heiseren Gesang durch.

Auch später im Song setzt immer Mal wieder der Frauengesang oder ein

Chor ein.

Dieses Lied enthält alles, Melodic-Death-Passagen, Frauengesang, Chöre,

Gitarrensoli und epische, orchestrale Passagen und sogar Pferdegewieher,

Hühnergegacker (!

)

und einen deutschen Dialog

)

und einen deutschen Dialog

(“Hey, was machst du so?”

“Joar nicht viel, meine Frau ist gerade los und kauft Wurst, ich denk

ich geh auf ein Bier ins Zwielicht-Gasthaus¹.”

“Super, da komm ich mit.”

“Hier her, hier entlang! Willkommen edle Herren. Bei uns sind die Weiber

schön und die Männer wild. Es gibt reichlich zu essen, das beste Bier.

Und am Ende des Tages werden wir eine (???) Hexe dem Feuer übergeben.

Vorher lasst euch unterhalten von weitgereisten Spielleuten, welche

ebenfalls verbrannt werden, sollten sie ihre Spielzeit überziehen.”

“Entschuldigen Sie bitte, wer spielt denn heute Abend?”

Der Zwielicht-Gasthaus-Wirt (?): “Ensiferum und Finntroll aus

Finnland!”

“Ja, wunderbar!” ).

Ein tolles Lied, das 17min lang unterhält ohne dabei langweilig zu

werden.

”)

”)

[Nachtrag:]{style=“text-decoration: underline;“} Der deutsche Dialog

wurde anscheinend von den apokalyptischen Reitern beigesteuert.

”)

”)

Bamboleo

Nach Metallicas Battery und Uria Heeps Lady in Black mal wieder eine

Coverversion. Diesmal rücken sie Gipsy Kings’ Bamboleo zu Leibe.

Was soll man dazu sagen, ein Partykracher halt.

Bamboleo, bambolea\

Porque mi vida, yo la prefiero vivir asi\

Bamboleo, bambolea\

Porque mi vida, yo la prefiero vivir asi

[Fazit]{style=“text-decoration: underline;“}

Nach dem ersten Hören scheint es wieder eine solide Arbeit von Ensiferum

zu sein, die ihr Geld wert war. Ich denke ich werde die CD in den

nächsten Tagen etwas intensiver hören und schauen ob sie den Dauertest

besteht oder schnell langweilig wird. Ich bin mir aber ziemlich sicher,

dass ich an dem Album dauerhauft meine Freude haben werde. Nach dem

ersten Durchgang hat sich noch kein Lied als Favorit herausgestellt, da

das ganze Album durchwegs auf hohem Niveau angesiedelt ist. Einzig

Bamboleo hat schon Kultfaktor.

¹ Twilight-Tavern vom vorigen Album From Afar?

Vor einigen Tagen bin ich auf ein kleines Programm aufmerksam geworden – Knotter. Mit diesem in QT implementierten Programm kann man im Handumdrehen keltische Knoten oder islamische Flechtwerke erstellen. Mit Inkscape geht das zwar auch, ist aber wesentlich aufwendiger. Die Erweiterung für Knotenmuster trennt nur an den Ãœberlappungen die jeweiligen Pfade auf, um Knoten darzustellen.

Vor einigen Tagen bin ich auf ein kleines Programm aufmerksam geworden – Knotter. Mit diesem in QT implementierten Programm kann man im Handumdrehen keltische Knoten oder islamische Flechtwerke erstellen. Mit Inkscape geht das zwar auch, ist aber wesentlich aufwendiger. Die Erweiterung für Knotenmuster trennt nur an den Ãœberlappungen die jeweiligen Pfade auf, um Knoten darzustellen.

{.aligncenter

.size-medium .wp-image-19 width=“300”

height=“250”}

{.aligncenter

.size-medium .wp-image-19 width=“300”

height=“250”} {.aligncenter

.size-medium .wp-image-24 width=“300”

height=“250”}

{.aligncenter

.size-medium .wp-image-24 width=“300”

height=“250”} {.aligncenter

.size-medium .wp-image-25 width=“300”

height=“272”}

{.aligncenter

.size-medium .wp-image-25 width=“300”

height=“272”} {.aligncenter

width=“250”

height=“250”}

{.aligncenter

width=“250”

height=“250”}

”)

”) ”)

”)