Die Gnome-Shell gibt es nun seit dreieinhalb Jahren. Sie war und ist vieldiskutiert und hat inzwischen eine Menge Konkurrenz quasi aus eigenem Hause bekommen. Neben einer Handvoll Varianten sind auch Forks entstanden. Im Ergebnis gibt es statt wie früher einem Gnome nun ein halbes Dutzend Linux-Desktops, auf altem oder neuem Gnome basierend. Dabei ist die Original-Shell im Prinzip ein genialer Desktop für Linux – scheitert letztendlich aber nicht nur am Babyentensyndrom der Benutzer. Ein versöhnlicher Rückblick auf die bisherige Entwicklung sowie eine Übersicht über den aktuellen Stand des Gnome-Desktops und seine Bedeutung für Linux.

Vor ziemlich genau 3 Jahren wurde an dieser Stelle prognostiziert, dass sich die Gnome-Shell in zwei Richtungen entwickeln könnte: entweder wieder zurück zum einstigen Gnome-2-Entwicklungsrhythmus, mit langsamer, aber stetiger Verbesserung – oder das Fortführen der radikalen Vereinfachungsstrategie, die ein homogenes Erscheinungsbild der Oberfläche quasi erzwingt.

„Entweder man kehrt wieder zum Entwicklungsmodell von Gnome 2 zurück, das wie ein Biotop langsam wuchs und sinnvolle Funktionen nach und nach integrierte – oder man hält die Shell möglichst uniform und vermeidet auch optionale Ergänzungen durch den Nutzer selbst.“

Schauen wir, was daraus geworden ist.

Innovation

Die Gnome-Shell ist das Modernste, was Linux oberflächentechnisch derzeit zu bieten hat. Während KDE beim klassischen Desktopparadigma geblieben ist, Unity MacOS kopiert und sich der Rest von Mate über Cinnamon bis XFCE und LXDE immer noch mehr oder weniger wie Windows 95 bedienen lässt oder sogar noch so aussieht, haben sich die Gnome-Leute wirklich mal etwas Neues einfallen lassen – und sich dadurch mit einem Schlag vom traditionellen zum avantgardistischen Desktop katapultiert. Die Gnome-Shell ist innovativ. Sie ist der erste Linux-Desktop, der der Windows-Taste eine zentrale Bedeutung einräumt, statt sie einfach mehr oder weniger ungenutzt auf der Tastatur versauern zu lassen. Das starre Konzept der für Linux typischen virtuellen Arbeitsflächen wurde aufgebohrt und stellt nun in Interaktion mit den Startern im Dock ein dynamisches Arbeitsflächensystem bereit, das sich flexibel an die jeweils aktuelle Arbeitssituation anpasst. Auch mit dem Verzicht auf ein klassisches Startmenü und stattdessen der Einführung einer bildschirmfüllenden Übersicht war Gnome Vorreiter.

Doch diese Innovationen haben nicht jedem gefallen und vor allem die bisherigen Gnome-2-Fans mächtig ratlos dastehen lassen. Als die Gnome-Shell auf die Welt losgelassen wurde, kam so mancher aus dem Staunen nicht mehr heraus. Dieser schlechte Witz sollte der Nachfolger des etablierten und weit verbreiteten Gnome 2 werden? Es sollte, aber es kam anders. Die Anwender flüchteten zu Alternativen wie XFCE, freundeten sich mit KDE an oder schwenkten auf die entstehenden Forks und Umbauten um. Sogar Linus Torvalds wünschte sich von den Fedora-Entwicklern einen Gnome-2-Fork. Das erledigten dann andere, unter den Fittichen von Linux Mint wurde Gnome 2 als Mate wiedergeboren, und die Gnome-3-Technik unter dem Namen Cinnamon zu einer traditionelleren Oberfläche gestrickt.

Konkurrenz aus dem eigenen Lager

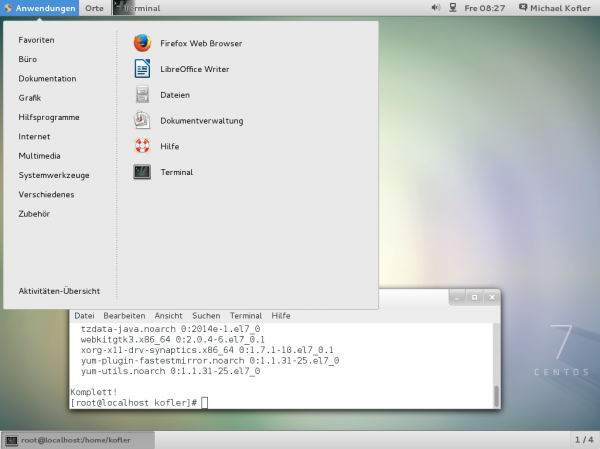

Heute gehört Mate zum Lieferumfang fast aller gängigen Distributionen, Debian und Ubuntu machen es gerade zum offiziellen Bestandteil ihres Angebots, auch Cinnamon beschränkt sich nicht nur auf Linux Mint. Ubuntu, bis dato mit Gnome als Standard, lieferte die Gnome-Shell gar nicht erst aus, sondern etablierte die Eigenentwicklung Unity. Linux Mint stieg zu einer der großen Distributionen auf. Sogar Gnome-Förderer Nr. 1, Red Hat, lässt die Gnome-Shell nur in modifizierter Form auf die Kundschaft los. Fedora und Debian sind damit die letzten der großen Distributionen, die die Gnome-Shell als Standarddesktop installieren.

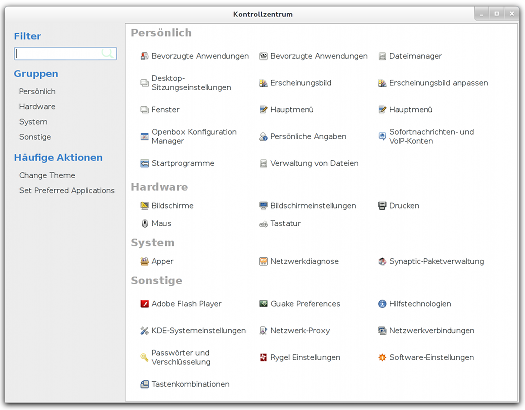

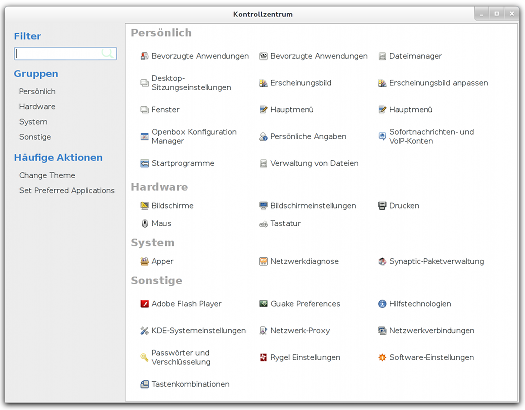

Sinnbild für die auseinandergehende Entwicklung: Das Kontrollzentrum von Mate …

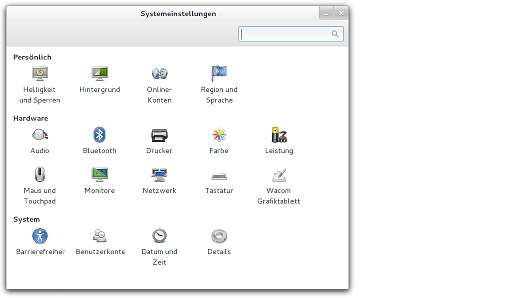

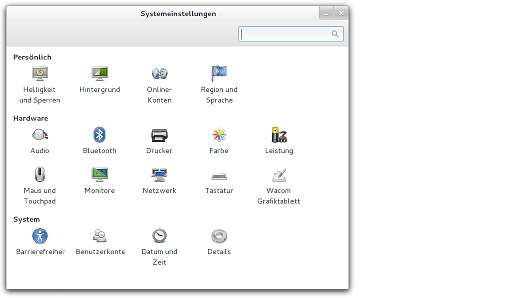

… und die Systemeinstellungen der Gnome-Shell

Selbst hartgesottene Gnome-Shell-Fans kamen in der Regel nicht ohne Zuhilfenahme des Gnome-Tweak-Tools, einer erweiterten Konfiguration zurecht. Gnome sah sich zu Zugeständnissen genötigt. Erst wurde ein Erweiterungssystem geschaffen, das Ergänzungen der rudimentären Funktionen der Shell ermöglichte. Schließlich wurde auch noch der Fallback-Übergangsmodus aufgegeben, um Cinnamon-gleich einen Classic Modus standardmäßig parallel zur normalen Gnome-Shell anzubieten. Dadurch tummeln sich heute statt einem Gnome ganze 6 Desktopvarianten im Linuxbecken, die einen Gnome-Unterbau haben (Gnome 2, Mate, Gnome Fallback, Gnome-Shell, Cinnamon, Gnome Classic).

Design

Optisch setzt Gnome die klare Linie fort, die einst mit der Einführung des Clearlooks-Designs begann, das jedoch nicht mehr zeitgemäß wirkt. In der Gnome-Shell wirkt nichts mehr altbacken wie noch bei Gnome 2, dezente Farben und ein Spiel mit dem Kontrast aus dunklen und hellen Tönen bestimmen die Oberfläche. Shell und Anwendungsprogramme sind optisch getrennt, alles scheint durchdacht, ist visuell ansprechend und in elegante Formen gegossen. Optik und Funktion greifen nahtlos ineinander und ergeben in sich ein stimmiges Bild. Vom ersten Pixel bis zum letzten Fehlerklang-Tönchen stimmt hier alles. Zugegeben, grundsätzliche Smartphone-Einflüsse lassen sich nicht leugnen, was sich vor allem in der oberen Statusleiste ausdrückt, doch die Gnome-Shell bleibt als Desktopsystem erkennbar.

Im Grunde bläst die Shell das Fenstermanager-Konzept der kleinen Window Manager zum Desktoperlebnis auf und bringt damit ein altes Konzept unter dem Deckmäntelchen der Moderne zu neuem Glanz. Die Reduzierung aufs Wesentliche ist dabei der richtige Ansatz, um sich vor allem auch von anderen Oberflächen abzuheben, die sich dem Linuxanwender im Schnitt doch recht überfrachtet präsentieren.

Das Oberflächendesign war, ist und bleibt die Stärke des Gnome-Projekts, auch mit der Gnome-Shell. Die simple Eleganz des User Interface besticht, man merkt, dass hier fähige Designer am Werk waren, die nicht nur Wert auf ein elegantes Erscheinungsbild legen, sondern auch Ahnung von Kommunikationsdesign haben.

Der steinige Weg zu Erweiterungen

Der Geburtsfehler der Gnome-Shell dürfte indes gewesen sein, die Bedienung nicht nur weiter zu vereinfachen, sondern sie gerade dadurch im selben Zuge auch zu verkomplizieren – das passte nicht recht zusammen. Schickes Design und Funktionalität müssen sich nicht gegenseitig ausschließen. Leider tun sie’s oft, so auch bei der Gnome-Shell. Das Wegfallenlassen grundlegender Einstellungen und die Veränderung typischer Bedienmuster macht es eben schwieriger statt leichter, gewünschtes Verhalten zu realisieren. Diese simple Logik fand zumindest in den ersten Versionen der Shell keine Beachtung, so dass das Drama seinen Lauf nahm – die Forks und Abspaltungen waren vorprogrammiert.

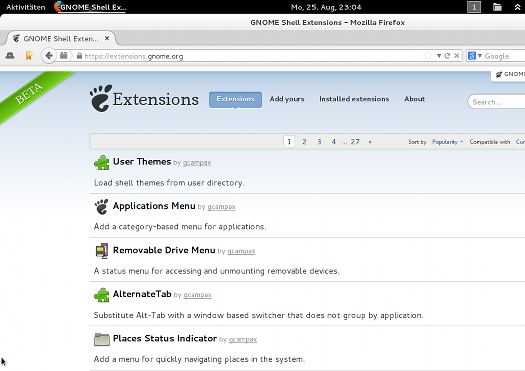

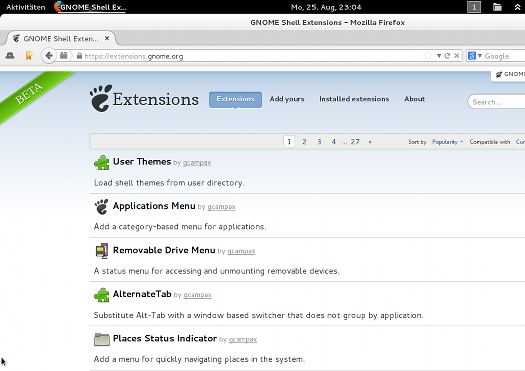

Weiterhin im Beta-Modus: Beliebteste Erweiterungen für die Gnome-Shell

Das Entfernen des Herunterfahren-Punktes im Systemmenü (nur mit Alt-Taste zugänglich), die Veränderung des gewohnten Alt-Tab-Verhaltens oder das Ignorieren der Entfernen-Taste waren dabei nur die Spitze des Eisberges. Viele Nutzer beklagten sich über lange Mauswege und das Fehlen als essentiell empfundener Funktionen. Auch Nutzer, die sich wohlgesinnt auf das Gnome-Shell-Erlebnis einlassen und gewillt sind, sich neue Arbeitsweisen anzugewöhnen, geraten mit der grundlegenden Bedienphilosophie in Konflikt.

Die Einführung der Erweiterungen war im Nachhinein betrachtet das Beste, was Gnome tun konnte, denn letztlich wird die Gnome-Shell für viele Anwender erst durch Erweiterungen produktiv nutzbar und somit auch für Nutzer interessant, die mehr möchten als mit der Desktopumgebung nur den Browser zu starten. Die Shell ist mit Erweiterungen heute tatsächlich gut zu benutzen; diese schließen die Lücken, die die Gnome-Shell bewusst in die Oberfläche geschlagen hat.

Auch wenn die Etablierung des Erweiterungssystems ein Schritt in die richtige Richtung war, kam er dennoch zu spät, ebenso wie die Einführung des Classic-Modus auf Gnome-Shell-Basis. Die Diskussion unter den Entwicklern, ob Erweiterungen überhaupt offiziell zugelassen werden sollten, da sie das ursprüngliche Konzept konterkarierten, verzögerte die Einführung der Erweiterungen – aber sie war durchaus berechtigt, denn die aufoktroyierte Simplizität geht tatsächlich flöten, wenn zu viele Erweiterungen installiert werden. Die Gnome-Shell gleicht dann eher einer User-Interface-Katastrophe statt einer übersichtlichen Lösung. Vielleicht auch deshalb ist das Angebot von Erweiterungen immer noch halbherzig, eine standardmäßige Integration in der Shell gibt es nicht, die Verwaltung erfolgt Plug-in-gestützt primär über den Webbrowser – und die Erweiterungsseite ist noch immer als Beta gekennzeichnet.

Arrangieren oder aufgeben

Die Nutzer, die Gnome nicht den Rücken gekehrt haben, scheinen sich damit zu arrangieren und sich die Gnome-Shell nach ihren Wünschen zurechtzubasteln. Zusätzliche Themes, ein Anwendungsmenü, ein Ordnermenü und das klassische Alt+Tab-Verhalten zählen zu den beliebtesten Erweiterungen. Dennoch bleiben Merkwürdigkeiten im Bedienkonzept oder Einschränkungen, die sich auch durch Erweiterungen kaum geradebiegen lassen.

Gnome wirbt auf seiner Webseite mit dem Slogan „puts you in control“. Oder in den jüngsten Release Notes: „Für 3.12 haben wir mit unseren Nutzern zusammengearbeitet, um das GNOME 3-Erlebnis zu vervollständigen.“ Das wirkt angesichts des ständig abnehmenden Funktionsumfangs wie Realsatire. Wobei man auf die Idee kommen könnte, dass Vervollständigung hierbei nicht für die Ergänzung von Funktionen, sondern eben für die vervollständigte Reduzierung des Leistungsumfanges steht. Neuerungen bestehen überproportional aus Änderungen des Erscheinungsbildes, Modifikationen am Theme, neue Icons, geändertes User Interface.

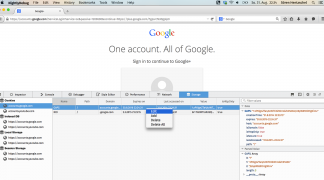

Marketing beherrscht das Gnomeprojekt, aber Nutzerwünsche werden in der Regel abgebügelt. Die geteilte Ansicht flog aus Nautilus, zuletzt wurde die Transparenz im Terminal abgeschafft, die Bitte im Bugtracker, die Funktion wiederherzustellen, vom Entwickler mit einem schroffen „Nein.“ beschieden. Aktuell wird die graphische Autostart-Funktion aus Gnome entfernt, sodass persönliche Startbefehle künftig im Texteditor erstellt werden müssen.

Fazit

Keine der eingangs beschriebenen, einst prognostizierten Szenarien ist eingetreten, Gnome hat eine klare Entscheidung vermieden. Oder man könnte auch sagen: beide Prognosen sind wahr geworden. Weder wurde zurück zum alten Entwicklungsrythmus gefunden, bei dem nach und nach vermisste Funktionalität ergänzt wird, noch wurden Anpassungen durch Dritte verhindert. Gnome hat den Mittelweg gewählt, der jedoch eine klare Positionierung vermissen lässt. Gnome entwickelt sich weiter, baut aber kaum neue Funktionen ein, sondern streicht im Gegenzug sogar weiter Bestandteile aus der Oberfläche. Stattdessen wurden die Erweiterungen initiiert, die nun primäre Anlaufstelle sind für alle, die mit der nackten Shell nicht recht zurechtkommen. Die Nutzer haben damit quasi selbst dafür gesorgt, dass es bei Gnome mit der Entwicklung weitergeht. Die aktuelle Gnome-Shell lebt auch von ihren Erweiterungen, doch das ist kein Ruhmesblatt für die Gnome-Shell, es behält den Charme der Notlösung und hat den Charakter einer Bastelei.

Die Gnome-Shell ist schick gemacht. Und durchdacht. Und fußt auf moderner Technik. Sie macht Spaß. Und dann scheitert’s an Kleinigkeiten. Sie macht es den ambitionierten Anwendern, die gerne mehr Wahlmöglichkeiten innerhalb der Shell hätten, unnötig schwer. Das Tragische ist nicht nur, dass sämtliche Abspaltungen und Variationen nicht notwendig gewesen wären, wenn das Gnome-Projekt seine Anwender nicht zu ihrem Glück zwingen würde und die Gnome-Shell konfigurierbarer gestaltet hätte – für mehr Freiheit in freier Software, auch für den Anwender.

Das Tragische ist vor allem, dass die angestrebte Homogenität des Desktop-Erlebnisses von Gnome selbst unnötigerweise torpediert wurde. Gnome wollte nicht, dass Nutzer ihre Desktops konfigurieren. Das jedoch erst hat dazu geführt, dass sich statt einer einheitlich-schlichten Gnome-Oberfläche nun eine ganze Reihe alternativer Oberflächen auf den Linux-Bildschirmen tummeln – und dass die Gnome-Shell durch Erweiterungen regelrecht zerpflückt werden kann. Die Vision der Entwickler sollte möglichst nicht beschädigt werden, Gnome überall gleich aussehen. Das ging im Ergebnis voll daneben, im schlimmsten Fall läuft nicht mal mehr Gnome bei den Nutzern.

Sechs bis sieben Mal Linuxoberfläche allein auf Gnome-Basis

Vielfalt auf dem Linux-Desktop muss nicht schlecht sein, aber es verhindert langfristig den Durchbruch als verbreiteteres Desktopsystem. Mit bis zu sechs verschiedenen, parallel angebotenen Oberflächen, die alle irgendwie mit Gnome zu tun haben, wird Torvalds Ziel von Linux als selbstverständlichem PC-Betriebssystem Utopie bleiben. Da hilft auch die Strahlkraft eines Ubuntus nicht weiter, das die siebte Variation von Gnome auf den Markt wirft. Die Gnome-Shell wäre die ideale Linuxoberfläche, sie könnte Linux ein unverwechselbares Gesicht geben, das nicht wirkt wie ein Windows- oder Mac-Abklatsch – wäre sie nicht durch eine übertriebene Simplizitäts-Attitüde ins Hintertreffen geraten. So ist sie heute nur noch eine Wahl unter vielen. Tragisch.

Dieser Artikel ist Bestandteil der „Not my Desktop“-Reihe.

Bereits erschienen:

• Wird GNOME wieder zum Zwerg?

• Eine Woche Gnome 3: Der uniformierte Desktop

• Strategien zur GNOME-3-Vermeidung

• Gnome-Shell – es wird immer unübersichtlicher

• Endlich: Gnome rudert zurück

• Die Gnome-Shell macht auf alt

• Die Tragik der Gnome-Shell

• Der Gnome-Shell eine Chance

![]()