Bislang laufen alle unsere Dom0s entweder auf Ubuntu 8.04 oder openSUSE 11.1 oder 11.2. Für einen neuen alten Server wollte ich Ubuntu 9.10 als Basis nehmen, auch um im Mai leichter auf 10.04 wechseln zu können. Bei Ubuntu ist die Xen-Situation nicht besonders rosig: Laut halboffizieller Doku steht weder ein aktueller Xen, noch ein brauchbarer Kernel bereit. Immerhin ein Xend (der Verwaltungsdaemon) in Version 3.3. Erfahrungen seit 3.2 haben gezeigt, dass sich die Schnittstellen kaum noch ändern, so dass der 3.3er Daemon mit dem 3.4er Xen zusammen arbeiten sollte. Denkste.

Ziel waren zwei Server: Ein 64-Bit-System fürs Büro und ein 32-Bit-System für einen alten (AMD Athlon XP 2000, 512MB, 80GB) Hetzner Rootie (Presse-Testsystem). Beide Systeme wurden zunächst mit einem Ubuntu Minimalsystem ausgestattet. Bei Hetzner geschah dies aus dem Notfall-System per debootstrap (fertige OS-Images werden nur einmal am Tag aufgespielt, was stört, wenn man nach einer abgeschossenen Installation neu aufsetzen möchte) und der Server zuhause wurde per Debian-Installer per PXE-Netboot eingerichtet. Die zwei Möglichkeiten, einen Hetzner-Server mit Ubuntu oder Debian auszustatten — debootstrap und den Debian-Installer im SSH-Modus — erkläre ich bei Gelegenheit im Detail.

Benötigte Pakete

Mit dem folgenden Befehl sollten alle Abhängigkeiten aufgelöst werden, die zum Bau von Xen und dem Betrieb einer Dom0 benötigt werden:

apt-get install rsync screen build-essential bin86 bcc libssl-dev \

gettext libncurses-dev python python-dev pciutils-dev libx11-dev \

pkg-config python-twisted bridge-utils gawk

Unter 32 Bit-Systemen sollte man aus Performance-Gründen noch die angepasste C-Bibliothek installieren:

apt-get install libc6-xen

Kernel kompilieren

Ubuntu selbst bietet einen Kernel für Amazons EC2, der sollte einigermaßen gut auf aktuellen Xen-Versionen laufen. Getestet habe ich es nicht. Stattdessen habe ich selbst drei Kernel kompiliert: Einen für AMD64 mit vollem Dom0-Support und vielen Treibern, einen mit stark abgespeckten Treibern (für 64Bit-DomUs) und einen i686-Kernel mit vollem Dom0-Support und der Möglichkeit, auf älteren Xen-Versionen gestartet zu werden. Die für Xen benötigten Frontend- sowie Backend-Treiber habe ich statisch integriert, was den Vorteil hat, dass an der Konfiguration des Initramfs nichts geändert werden muss. Alle Konfigurationen bieten Verbesserungspotential, beispielsweise beim Abspecken um nicht benötigte Treiber. Hier sei allerdings darauf verwiesen, dass das Entfernen vermeintlich nicht benötigter Funktionen Unresolved Symbols und damit Kompilationsabbrüche zur Folge haben kann.

Als Kernel kommt hier Gentoos 2.6.31.12 — konkret das Patchset xen-patches-2.6.31-12.tar.bz2 — zum Einsatz. Die verwendeten Patches stammen größtenteils von openSUSEs Xen-Kernel, wurden aber von SuSE-Spezifika befreit. Das macht das Bauen und die Installation einfacher. Gepflegt werden die Patches als eigenes Projekt bei Google Code.

Meine Konfigurationsdateien:

Und nun zum Bauen des Kernels, hier für AMD64:

mkdir xen-patches-2.6.31-12

cd xen-patches-2.6.31-12

tar xvjf ../xen-patches-2.6.31-12.tar.bz2

cd ../linux-2.6.31

for i in ../xen-patches-2.6.31-12/*.patch1 ; do patch -p1 < $i ; done

wget -O .config http://cdprojekte.mattiasschlenker.de/Public/Xen-Kernel/config-2.6.31.12-mfs001-xen0-amd64

make oldconfig

make

make install

make modules_install

Der Kernel braucht noch ein passendes Initramfs, dieses entsteht mit:

mkinitramfs -o /boot/initrd.img-2.6.31.12-mfs001-xen0-amd64 2.6.31.12-mfs001-xen0-amd64

Falls Sie Xen Frontend- oder Backend-Treiber in Module ausgelagert haben, müssen Sie ggf. die Modulliste des Initramfs anpassen!

Xen Hypervisor installieren

Ohne Xen nützt der schönste Kernel nichts, also bauen und installieren wir Xen 3.4.2 aus dem offiziellen Tarball von www.xen.org:

tar xvzf xen-3.4.2.tar.gz

cd xen-3.4.2

make xen

make install-xen

Bootloader konfigurieren

Der einfachste Weg ist die Erstellung eines simplen Scriptes /etc/grub.d/50_xen, welches hart kodiert Kernelnamen, Xen-Version und Pfade (Root-Device ist hier /dev/sda4) enthält. Zweimal root=... ist kein Tippfehler, sondern als Workaround für einen kleinen Bug in den Scripten des Initramfs gedacht:

#!/bin/sh

exec tail -n +3 $0

# This file provides an easy way to add custom menu entries. Simply type the

# menu entries you want to add after this comment. Be careful not to change

# the 'exec tail' line above.

menuentry "Ubuntu 9.10 - Xen 3.4.2 + Linux 2.6.31" {

insmod ext2

set root=(hd0,4)

multiboot /boot/xen-3.4.2.gz

module /boot/vmlinuz-2.6.31.12-mfs001-xen0-amd64 root=/dev/sda4 ro root=/dev/sda4

module /boot/initrd.img-2.6.31.12-mfs001-xen0-amd64

}

Das Script muss nun noch ausführbar gesetzt werden, sonst wird der neue Eintrag nicht in die GRUB-Konfiguration übernommen!

chmod a+x /etc/grub.d/50_xen

In der Datei /etc/default/grub sollten Sie den Standard-Booteintrag auf den neuen Kernel setzen:

GRUB_DEFAULT="Ubuntu 9.10 - Xen 3.4.2 + Linux 2.6.31"

Danach rufen Sie update-grub auf um die Bootloader-Konfiguration neu aufzubauen. Rebooten Sie jetzt den Rechner mit Xen und dem neuen Kernel.

Installation der Xen-Tools

Die Xen-Tools habe ich in einem frisch entpackten Xen-Tarball kompiliert. Die bei der Installation angegebene Variable ist wichtig, damit die Python-Module in den bei Ubuntu üblichen Pfaden landen. Gibt man diese Variable nicht an, ist es ggf. erforderlich eine Umgebunsvariable PYTHONPATH zu setzen und diese ggf. in das Script /etc/init.d/xend einzubauen:

rm -rf xen-3.4.2

tar xvzf xen-3.4.2.tar.gz

cd xen-3.4.2

make tools

make install-tools PYTHON_PREFIX_ARG=

Wenn alles geklappt hat, lässt sich der Xend starten. Läuft dieser, können die Bootmeldungen des Hypervisors ausgelesen werden.

/etc/init.d/xend start

xm dmesg

Xend in den Runleveln verlinken

Ich habe Xend vor dem SSH-Server verlinkt, den Start der domU-Instanzen danach. Grund waren Probleme mit dem SSH-Server: Upstart (oder der Xend?) versucht diesen neu zu starten, wenn neue Interfaces auftauchen. Das gelingt nicht immer, so dass ich während meiner Tests häufiger ohne SSH da stand. Auf einem Root-Server ist so etwas natürlich ganz bescheiden.

update-rc.d xend start 14 2 3 4 5 . stop 80 0 1 6 .

update-rc.d xendomains start 21 2 3 4 5 . stop 79 0 1 6 .

Vorbereitung für Routing-Setup

Achtung: Siehe auch den Nachtrag vom 19. März für ein besseres Setup!

Provider wie Hetzner oder Strato routen einem Server zugewiesene Subnetze auf dessen primäre IP-Adresse. Deshalb muss bei diesen Servern das Xen-Netzwerk von bridged auf routed umgestellt werden. Achtung: Einige Provider klemmen Server gnadenlos ab, wenn hinter einem Port des Routers bislang unbekannte MAC-Adressen auftauchen. Wer den Xend bei so einem Provider startet, ohne vorher auf routed umgestellt zu haben, fliegt aus der SSH-Verbindung raus und darf mit dem Support telefonieren!

Zuerst wird die Datei /etc/modules um eine Zeile

dummy

für den Dummy-Netzwerk-Adapter erweitert.

Es folgt die statische Konfiguration der primären IP-Adresse auf eth0 und der ersten nutzbaren IP-Adresse auf dummy. In diesem Fall haben wir das Subnetz 172.16.16.112/ 255.255.255.248 (acht Adressen von .112 bis .119) zugewiesen bekommen, .112 ist hier die Adresse des Netzes, .113 wird auf dummy0 gelegt, .114 bis .118 (fünf von acht Adressen) sind für die domUs nutzbar und .119 ist die Broadcast-Adresse:

auto lo

iface lo inet loopback

auto eth0

iface eth0 inet static

address 192.168.1.2

netmask 255.255.255.0

gateway 192.168.1.1

auto dummy0

iface dummy0 inet static

address 172.16.16.113

netmask 255.255.255.248

In der Konfigurationsdatei /etc/xen/xend-config.sxp des Xend muss die Einstellung von bridged auf routed umgestellt werden. Das zu routende Device muss explizit angegeben werden:

# (network-script network-bridge)

# (vif-script vif-bridge)

(network-script 'network-route netdev=dummy0')

(vif-script 'vif-route netdev=dummy0')

An dieser Stelle ist ein Neustart des Xend, besser ein Reboot erforderlich. Anschließend können die domUs konfiguriert werden. Die Routing-Informationen werden hierfür in der Client-Config eingetragen:

kernel = "/boot/vmlinuz-2.6.31.12-mfs006-xenU-minimal-amd64"

ramdisk = "/boot/initrd.img-2.6.31.12-mfs006-xenU-minimal-amd64"

memory = 256

name = "ubuntu-amd64-minimal"

vif = [ 'ip=172.16.16.114' , 'mac=00:16:00:00:00:27' ]

disk = [ 'file:/usr/local/xendomains/test01_64/sda1.img,sda1,w' ]

root = "/dev/sda1 ro"

extras = "console=hvc0 xencons=tty"

Daneben ist es erforderlich, die IP-Konfiguration in der /etc/network/interfaces der domU einzutragen -- DHCP möchte ich an dieser Stelle nicht erklären, das würde den Rahmen sprengen.

Vielen Dank an...

Anmerkungen:

-

Nie erst Ubuntus Xen-Tools 3.3 installieren und dann diese Anleitung durchführen. Das resultierende Versionsmischmasch wird garantiert kein funktionierendes Netzwerk zur Folge haben!

-

Details zur domU-Konfiguration bei Hetzner folgen

-

Details zur Ubuntu-/Debian-Installation aus Hetzners Rettungssystem folgen

![]()

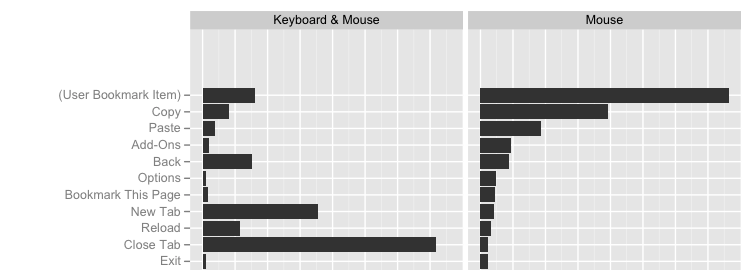

Mozilla möchte mit Firefox natürlich weiterhin so erfolgreich bleiben und den Vorsprung gegenüber anderen Browsern weiter ausbauen. Um dieses Ziel zu erreichen, muss das Internetzugriffsprogramm natürlich weiter verbessert werden, sowohl in der Technik als auch in der Benutzerfreundlichkeit. Die Technik erlernen die Entwickler von anderen Experten, die Nutzungsgewohnheiten der Benutzer müssen jedoch erforscht werden.

Mozilla möchte mit Firefox natürlich weiterhin so erfolgreich bleiben und den Vorsprung gegenüber anderen Browsern weiter ausbauen. Um dieses Ziel zu erreichen, muss das Internetzugriffsprogramm natürlich weiter verbessert werden, sowohl in der Technik als auch in der Benutzerfreundlichkeit. Die Technik erlernen die Entwickler von anderen Experten, die Nutzungsgewohnheiten der Benutzer müssen jedoch erforscht werden.

Der Code ist nun angekommen, die Installation ging soweit ganz gut, es kommen etliche Fenster hoch, die einem Anfänger helfen können, die Texte sind auch fast alle perfekt eingedeutscht, aber es gibt ein paar Ausnahmen

Der Code ist nun angekommen, die Installation ging soweit ganz gut, es kommen etliche Fenster hoch, die einem Anfänger helfen können, die Texte sind auch fast alle perfekt eingedeutscht, aber es gibt ein paar Ausnahmen