Filesharing ist eine tolle Erfindung, die es ermöglicht, vielen Leuten bestimmte Bilder, Videos, Musik, Texte oder andere digitale Daten zugänglich zu machen. Es gibt Anbieter und Protokolle wie Sand am Meer, alle tragen die verrücktesten Namen, die ihren Erfindern eingefallen zu sein scheinen.

Filesharing ist eine tolle Erfindung, die es ermöglicht, vielen Leuten bestimmte Bilder, Videos, Musik, Texte oder andere digitale Daten zugänglich zu machen. Es gibt Anbieter und Protokolle wie Sand am Meer, alle tragen die verrücktesten Namen, die ihren Erfindern eingefallen zu sein scheinen.

Für Linux gibt es einen Client, der einen Großteil dieser Protokolle vereinen kann – er nennt sich MLDonkey. Dieses Paket teilt sich in zwei Teile, zum einen in ein grafisches Frontend, zum anderen einen Kern im Hintergrund, den so genannten Core.

Installiert lässt sich das Paket z.B. über den folgenden Befehl:

sudo apt-get install mldonkey-server

Da der Core ein Dienst ist, wird man bei der Installation gefragt, ob er beim Starten des PCs automatisch gestartet werden soll. Es handelt sich dabei um den Dienst /etc/init.d/mldonkey-server

Sollte man diese Option verneinen, kann man den Server manuell über den Befehl

mldonkey

im Terminal starten (und über Strg + C wieder beenden).

Wie man den Server konfiguriert, könnt ihr z.B. im Wiki bei ubuntuusers.de nachlesen. Ihr benötigt dafür evtl. euere interne IP, die sich über den Befehl

ifconfig

herausfinden lässt.

Grafische Verwaltungstools

MLDonkey Grafische Oberfläche

Die Bedienung des Daemons gestaltet sich wieder sehr Linux-like, d.h. dass man viele Möglichkeiten hat. Eine gute und komfortable Möglichkeit, ist z.B. über das hauseigene GTK+ Interface. Dieses findet sich über Anwendungen → Internet → MLDonkey im GNOME-Menü und zeichnet sich durch wenige Knöpfe im Kopfbereich aus. Diese sind weitestgehend selbsterklärend. Installiert werden kann es über den Befehl:

sudo apt-get install mldonkey-gui

Außerdem gibt es – als weitere komfortable Alternative – ein Interface für den Browser. Über http://localhost:4080/ lässt es sich aufrufen und bedienen. Allerdings ist dazu das Passwort notwendig, dass man in der Konfiguration festgelegt hat.

Als weitere bekannte Oberfläche für MLDonkey ist das Paket Sancho. Das in Java geschriebene Programm hat es bisher nicht in die Repositories von Ubuntu geschafft, weswegen man den Installer von der Homepage beziehen muss, um es zu nutzen. Wie genau sich dieses Interface installieren lässt, ist ebenfalls bei ubuntuusers beschrieben.

Die verschiedenen Interfaces interagieren auch mehr oder weniger miteinander, weswegen man auch mehrere gleichzeitig nutzen kann

Wichtige Hinweise

Filesharing - nicht nur für Esel

Wer sich brav die Pakete installiert hat, jedoch vergeblich versucht ein Suchergebnis in einem der Interfaces zu erhalten bzw. überhaupt in das Interface zu gelangen, dem sei ans Herz gelegt, dass er vergessen hat, den Server zu starten

Nachdem man eine Datei laut grafischer Oberfläche erfolgreich heruntergeladen hat und sich schon auf dessen Benutzung freut, sollte man diese auch wieder finden. MLDonkey ist in der Standardkonfiguration so eingestellt, dass die Dateien auf einem Linuxsystem unter ~/.mldonkey/incoming/files/ bzw. */directories/ gespeichert werden. Da dieser Ordner nur versteckt im Homeordner auffindbar ist, sollte man diese Einstellung korrigieren. Das geht entweder über das Webinterface oder über die Datei ~/.mldonkey/downloads.ini. Dort kann der Ordner in den Zeilen 441ff. geändert werden:

{ dirname = "/home/benni/Downloads/incoming/files"

strategy = incoming_files

priority = 0

};

{ dirname = "/home/benni/Downloads/incoming/directories"

strategy = incoming_directories

priority = 0

};

Filesharing funktionert nach dem Geben-und-Nehmen-Prinzip. Man sollte also immer im Hinterkopf behalten, dass man nicht nur lädt, sondern auch sendet. Im Normalfall betrifft das aber nur die Dateien, die man im shared-Ordner des Programmes hat, also die oben eingestellten Ordner.

Leider werden Filesharing Services immer wieder dazu genutzt, urheberrechtlich geschütztes Material zu verbreiten, was diese „Erfindung“ oft in ein negatives Licht rückt. Das finde ich schade, dass es immer wieder Menschen gibt, die Technologie zu kriminellen Zwecken nutzen. Aber es lässt sich wohl nicht vermeiden.

Nun aber noch viel Spaß beim Datentausch!

Bildquelle

Filesharing ist eine tolle Erfindung, die es ermöglicht, vielen Leuten bestimmte Bilder, Videos, Musik, Texte oder andere digitale Daten zugänglich zu machen. Es gibt Anbieter und Protokolle wie Sand am Meer, alle tragen die verrücktesten Namen, die ihren Erfindern eingefallen zu sein scheinen.

Filesharing ist eine tolle Erfindung, die es ermöglicht, vielen Leuten bestimmte Bilder, Videos, Musik, Texte oder andere digitale Daten zugänglich zu machen. Es gibt Anbieter und Protokolle wie Sand am Meer, alle tragen die verrücktesten Namen, die ihren Erfindern eingefallen zu sein scheinen.

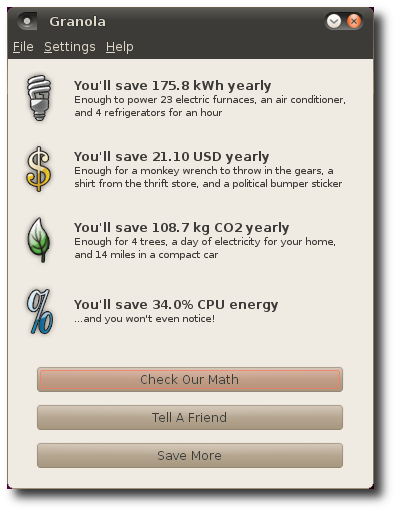

Update: Wie auch zahlreichen Reaktionen auf diesen Artikel zu entnehmen ist, ist es ist fraglich, ob das hier vorgestellte unfreie Programm Granola tatsächlich hält, was es verspricht.

Eine nachweisliche Auswirkung auf den Stromverbrauch hat allerdings das sogenannte Undervolting, welches sich unter Ubuntu aber nur mit einem gewissen Aufwand nutzen lässt (nämlich durch das Kompilieren eines Kernels oder mit dem freien cpupowered). Der Benutzer Hall schlägt daher auf Ubuntu Brainstorm vor, diese Funktion besser in Ubuntu zu integrieren, damit auch normalen Anwender leichter davon profitieren können: