Firefox 4

Vor kurzer Zeit ist die nächste Betaversion von Firefox, mittlerweile die siebte, erschienen. Ich habe mir diesmal wieder die Zeit genommen und mir die Neuerungen etwas näher angesehen.

Auf der Willkommensseite zur siebten Betaversion wird überwiegend mit dem neuen JavaScript Engine JägerMonkey angegeben. Dieser lässt Javascriptanwendungen schneller laufen. Das ist gerade in der heutigen Zeit, in der immer mehr Internetauftritte mit Javascript und Ajax daherkommen, sehr wichtig.

Doch nun zu den offensichtlichen Neuerungen:

Wie auch in den Betaversionen davor sind die Tabs oberhalb der Adresszeile angeordnet. Über Sinn und Unsinn dieser Maßnahme haben wir bereits vor ein paar Wochen geschrieben.

App-Tab

App-Tab

Die App-Tabs wurden verbessert. Unter einem App-Tab versteht man einen kleinen, statischen Tab, den Firefox auf der linken Seite der Tableiste anbringt. Dieser hat die Absicht, Internetseiten, die überwiegend wegen ihrer Funktion geöffnet sind, klein, unauffällig und dennoch erreichbar anzuordnen. Zu dieser Art von Internetseiten gehören z.B. Internetradios, Twitter sowie weitere soziale Netzwerke.

Einen normalen Tab kann mit über das Kontextmenü als App-Tab anpinnen. Was mir aufgefallen ist: Sollte irgendetwas auf der Seite passieren, während sie im Hintergrund ist, wird sie farblich hervorgehoben (sie Screenshot am Twitter-Tab).

Firefox-Sync

Firefox-Sync ist da! Um ehrlich zu sein, weiß ich nicht seit welcher Beta, aber jetzt ist es auf jeden Fall drin. Diese Funktion entstammt den berühmt berüchtigten Mozilla Labs und geht aus dem Projekt Firefox Weave hervor. Es handelt sich dabei um einen Dienst mit dem man (über eine verschlüsselte Verbindung) seine Lesezeichen mit einem Mozillaserver synchronisiert. Dies hat den Nutzen, dass man an einem beliebigen PC mit Firefox 4 seine Lesezeichen von Zuhause dabei hat. Der Clou: Wenn man möchte, kann man auch einen eigenen Server dazu verwenden. Man braucht dazu eigentlich nichts weiter als einen Server mit PHP, einer MySQL und dem Server von der Mozilla-Homepage.

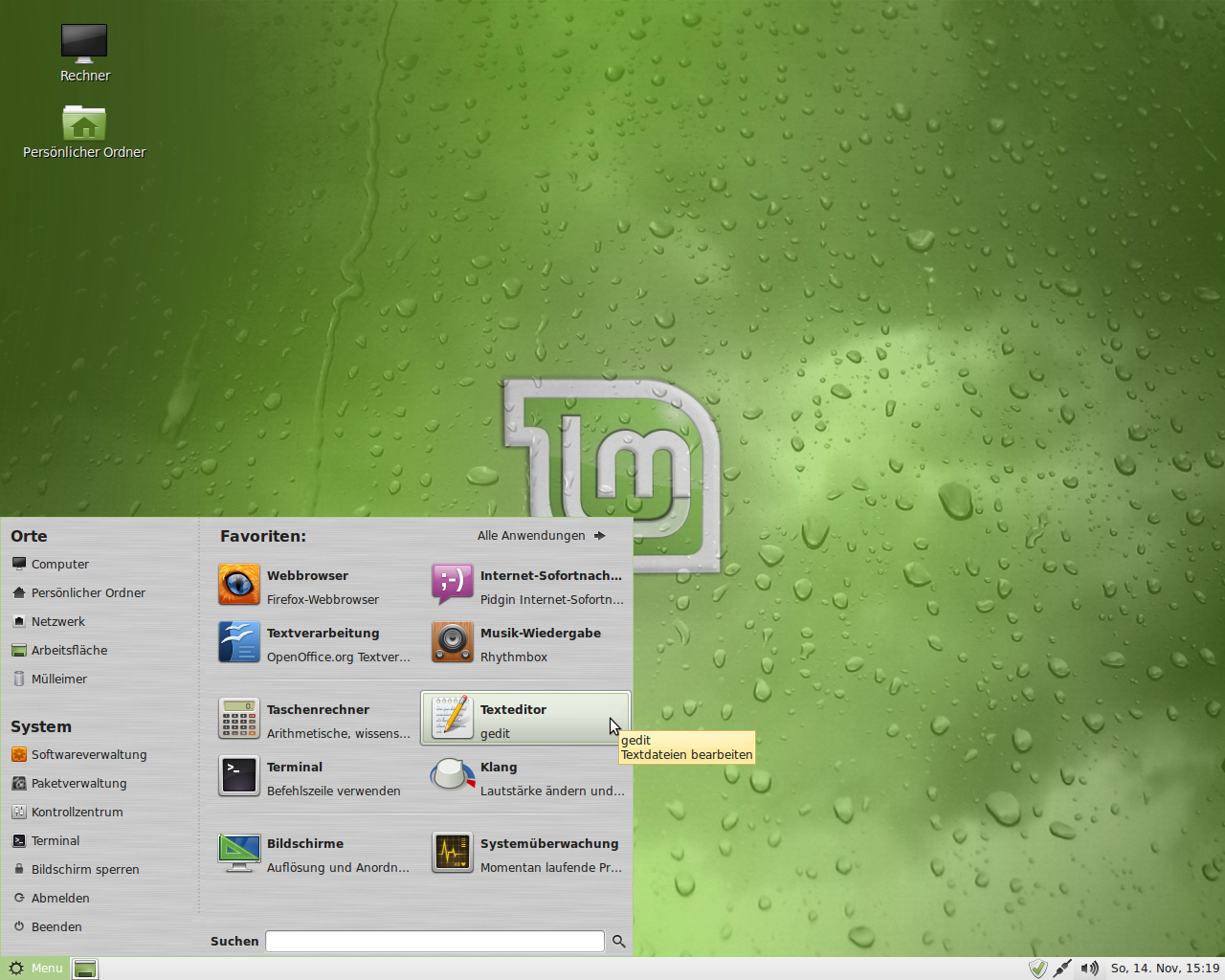

Panorama

Die Funktion von Panorama habe ich mehr oder weniger zufällig gefunden. Es handelt sich dabei um das Projekt, was früher unter dem Namen Tab Candy eingeführt wurde. Gott sei Dank wurde es umbenannt. Über Strg + E gerät man in eine Übersicht aller geöffneten Tabs. Ganz Apple-like findet man dort auch gleich ein erklärendes Werbevideo dazu: Auf dieser „Schreibtischoberfläche“ kann man seine geöffneten Tabs in Gruppen gliedern. Ganz einfach via drag&drop aus der Mappe herausziehen, und entweder auf den Schreibtisch oder in eine schon bestehende Mappe legen. Das ist für diejenigen ganz praktisch, die gleich 100 Sachen gleichzeitig im Internet erledigen wollen und früher unter der Tabflut ertrunken sind. Jetzt kann man z.B. eine Mappe für die geöffneten sozialen Netzwerke und eine für Blogs aufmachen. Wenn man in dieser Darstellung ist, genügt ein Klick auf eine der Internetseiten und sie öffnet sich. Und um sie herum finden sich Tabs mit den restlichen Seiten aus der Mappe.

Firefox 4 mit der Funktion „Panorama“. Sie ermöglicht das gruppieren von Tabs.

Kleinigkeiten

Der Adresszeie wurde nun auch die Funktionen der Statusleiste anvertraut.

Der Reload- bzw- Stopp-Button ist verschwunden… äh, gewandert! Er findet sich bei genauerer Betrachtung des Bildschirms nun rechts direkt neben der Adresszeile

Die Statuszeile ist weg. Endlich! Bei Widescreen-Bildschirmen hat sie eh nur genervt, aber ausblenden hatte zur Folge, dass man bei Mouseover nicht mehr das Ziel eines Linkes sah. Jetzt ist es in den rechten Teil der Adresszeile gewandert: In hellgrauer Schrift sieht man dort das Ziel des Links.

Wenn man in der Tableiste eine Adresse eingibt, die bereits in einem anderen Tab geöffnet ist, fragt Firefox nach, ob man dorthin möchte. Das verhindert das versehentliche öffnen von ein und derselben Seite mehrmals im Browser.

Die Frage, ob Firefox ein Passwort speichern soll oder nicht, kommt nicht mehr über eine Leiste oberhalb der Internetseite, sondern über ein kleines Dialogfenster im oberen Fensterbereich.

Was noch fehlt, aber kommen soll

Bisher fehlt noch die Verlegung von Chronik und Downloads in Tabs. Der Addon-Manager hat es bereits geschafft, aber die beiden erstgenannten benötigen weiterhin eigene Fenster. Mir war lange Zeit auch schleierhaft, ob diese Maßnahme sinnvoll ist oder nicht, aber seitdem ich Chromium als primären Browser nutze, (dort läuft bereits dies alles über Tabs) habe ich den Sinn erkannt: Es ist einfach aufgeräumter. Der Single-Window-Effekt macht sich hier bezahlt.

Was bei den App-Tabs noch fehlt ist die strengere Handhabung. Wenn ich das richtig verstanden habe, dürfte es eigentlich nicht möglich sein, einen App-Tab über einen Link daraus heraus zu ersetzen.

Wer an eine vollständigen Liste der Neuerungen interessiert ist, sei hier glücklich.

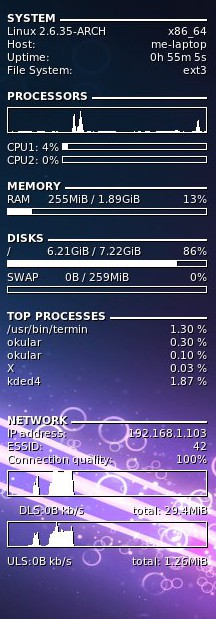

Meine .conkyrc (gehört in den Ordner /home/DEINUSERNAME):

Meine .conkyrc (gehört in den Ordner /home/DEINUSERNAME):

Nach dem Brandenburger Linux-Infotag steht dieses Wochenende die nächste Veranstaltung ins Haus – die

Nach dem Brandenburger Linux-Infotag steht dieses Wochenende die nächste Veranstaltung ins Haus – die