In seinem Blogpost “Diaspora… Ein Gezeitenwechsel?” hat Marc die dezentrale Open Source Alternative zu G+ und Facebook bereits kurz beschrieben und einen kurzen Kommentar zu den einzelnen Funktionen und Bereichen des Netzwerks abgegeben. Lest euch den Beitrag am besten gleich mal durch, um einen Einblick in das Thema zu bekommen.

Vor etwa 11 Tagen habe ich meine Aktivitäten auf dem deutschen Diaspora Pod “pod.geraspora.de” wieder aufgenommen und beschlossen, meine “Social-Network-Aktivitäten” dorthin zu verlagern. Bisher war ich fast nur auf Google+ unterwegs, aber wegen der stetig abnehmenden Qualität des Netzwerks habe ich mir Diaspora nochmal genauer angeschaut, nachdem mein Account dort fast ein Jahr lang brach lag.

Seit meinem letzten Besuch auf dem Diaspora Pod hat sich kaum etwas getan. Keine Änderung an der Software, die mir direkt ins Auge gestochen wäre. Alles war wie vorher – und bis jetzt habe ich keine Änderung gefunden. Ok, das System scheint jetzt zuverlässiger und stabiler zu laufen, aber an den Features hat sich nichts geändert. Die Arbeiten am Diaspora Projekt laufen sehr langsam, was zwei Seiten hat. Einerseits muss man sich als Benutzer nicht ständig umgewöhnen (vgl. Google+), andererseits dauert es lange, bis neue Funktionen eingeführt oder vorhandene verbessert werden.

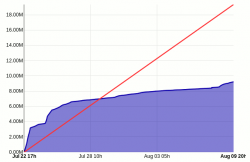

Warum die Arbeiten so langsam vorangehen, weiß ich nicht. Vermutlich ist das Interesse am Diaspora Projekt zu gering und es stehen nicht genug Entwickler zur Verfügung. Möglicherweise wurde es auch schon insgeheim aufgegeben. Die Gründer von Diaspora haben dem Projekt jedenfalls den Rück zugewandt und sind seit einiger Zeit mit einem anderen, kommerziellen Projekt beschäftigt. Das Projekt wurde an die Community übergeben, nur die ist entweder überfordert oder schlecht organisiert.

Ich habe aber gehört, dass demnächst eine neue Einzelbeitragsansicht in Diaspora eingeführt werden soll. Es tut sich also doch was… wenn auch langsam. Den zeitlichen Verlauf der Aktivitäten kann man sich übrigens hier auf der Projektseite bei GitHub ansehen: https://github.com/diaspora/diaspora/graphs

In diesem Post will ich ebenfalls kurz meine Meinung zu Diaspora abgeben. Nachdem ich dort wieder für ein paar Tage aktiv war, hat sich meine Meinung etwas geändert. Es dauert ein bisschen, bis man sich auf das System “Diaspora” umgestellt hat, denn es fehlen an allen möglichen Stellen Funktionen, die man von der Konkurrenz kennt. Dieses Social Network ist anders. Dennoch gibt es Dinge, die ich zu bemängeln habe; damit fange ich an.

… was an Diaspora noch verbessert werden muss.

Am meisten fehlt mir die Möglichkeit, Beiträge und Kommentare nach dem Verfassen und Abschicken korrigieren zu können. Bei G+ ist das problemlos möglich. Diese Funktion habe ich sehr häufig genutzt. Seien es schlechte Formulierungen, Falschaussagen, die ich korrigieren wollte oder einfach nur Tippfehler. Ich weiß nicht, ob man bei Facebook Beiträge und Kommentare bearbeiten kann. Aber diese Funktion geht mir wirklich ab. Wäre schön, wenn man dem Benutzer in Zukunft die Möglichkeit geben würde, seine Beiträge zu bearbeiten. Das Ergebnis: Ich achte vor dem Absenden mehr darauf, dass alles okay ist und nutze ggf. die vorhandene Vorschaufunktion (die G+ wiederum nicht bietet ;) )

Der Zweite Kritikpunkt betrifft das “Weitersagen” / Teilen von Beiträgen. Wenn mit ein Beitrag besonders gut gefällt und ich der Meinung bin, dass ihn mehr Leute sehen sollten, kann ich einen Beitrag weitersagen. Das funktioniert aber nur bei öffentlichen Beiträgen; bei eingeschränkt geteilten Beiträgen steht diese Funktion nicht zur Verfügung. Okay, damit kann ich mich noch abfinden. Das kommt vielleicht daher, weil privat geteilte Beiträge auch wirklich privat bleiben sollen. Gut, versteh ich. Aber:

Warum kann ich weitergesagte Kommentare nicht gleich auch noch kommentieren? Bei G+ war es möglich, über den eigentlichen, zu teilenden Beitrag noch kurz ein Statement abzugeben. War sehr praktisch, wenn man noch etwas dazu zu sagen hatte. Das geht bei Diaspora nicht – zumindest wird das nicht nativ unterstützt. Ein “Zitierscript” kann hier aber Abhilfe schaffen aber es wäre besser, so etwas direkt in das Netzwerk einzubauen.

Gefällt ein Beitrag, dann kann man das zeigen, indem man den “Gefällt mir” Link klickt. Ja, es ist ein Link, kein Button ;)

Was ist aber mit Kommentaren? Die kann man nicht liken, denn ein solcher Link fehlt bei den Kommentaren. Schade, denn oftmals geben User sehr gute Kommentare ab, bei denen man beispielsweise seine Zustimmung zeigen will.

Marc meint dazu, dass das nicht so tragisch sei, weil ja dazu ermuntert werden solle, selbst einen Kommentar abzugeben und nicht stupide einen Kommentar zu “liken”. Das Argument kann ich verstehen… aber trotzdem fehlt mir der Like-Link irgendwie… man kann sich aber daran gewöhnen.

Manchmal will man jemanden erwähnen, damit er den Post nicht verpasst und weiß, dass es gerade um ihn geht. Auch in Diaspora kann man erwähnen; allerdings nur im Hauptbeitrag. In den Kommentaren kann man sich nicht gegenseitig ansprechen. Das wäre noch eine Sache, die meiner Meinung nach eingeführt werden sollte. In seinem Beitrag gibt auch Marc einen Kommentar dazu ab:

“Diaspora* setzt dabei auf #Hashtags und @Mentions (die allerdings nur in den Eingangsposts möglich sind. Das ist beabsichtigt, um zu vermeiden, dass Leserechte durch spätere @Mentions korrumpiert werden).”

… dem könnte man aber entgegenwirken, indem Personen, die für den Hauptbeitrag keine Leseberechtigung haben, bei einem @ nicht benachrichtigt werden bzw. auch im Nachhinein keine Leserechte bekommen. Nur jene, die die Leseberechtigten sind, können sich untereinander erwähnen. Wäre doch eine Lösung, oder? :)

Wo wir schon bei den Benachrichtigungen sind… das Benachrichtigungssystem ist auch verbesserungswürdig. Die Benachrichtigungen werden in einem kleinen Fenster der Reihe nach aufgelistet. Dabei werden sie markiert; je nachdem, ob man eine Benachrichtigung schon wahrgenommen / bearbeitet hat. Komischerweise werden alle aktuellen Benachrichtigungen nach ein paar Sekunden als gelesen markiert und ich weiß dann nicht mehr, welche ich mir noch ansehen sollte. Auch eine kleine Ansicht vom betroffenen Beitrag wäre wünschenswert, damit man gleich weiß, um was es geht. Derzeit stehen nur Sätze im Fenster wie “xyz gefällt dein Beitrag.” “Beitrag” ist dabei verlinkt mit dem Beitrag, um den es geht. Das heißt: Ich muss bei jeder Benachrichtigung erst einmal den Link aufrufen, um überhaupt zu wissen, was Sache ist. Das kann mit der Zeit extrem nervig werden.

Wo wir schon bei den Benachrichtigungen sind… das Benachrichtigungssystem ist auch verbesserungswürdig. Die Benachrichtigungen werden in einem kleinen Fenster der Reihe nach aufgelistet. Dabei werden sie markiert; je nachdem, ob man eine Benachrichtigung schon wahrgenommen / bearbeitet hat. Komischerweise werden alle aktuellen Benachrichtigungen nach ein paar Sekunden als gelesen markiert und ich weiß dann nicht mehr, welche ich mir noch ansehen sollte. Auch eine kleine Ansicht vom betroffenen Beitrag wäre wünschenswert, damit man gleich weiß, um was es geht. Derzeit stehen nur Sätze im Fenster wie “xyz gefällt dein Beitrag.” “Beitrag” ist dabei verlinkt mit dem Beitrag, um den es geht. Das heißt: Ich muss bei jeder Benachrichtigung erst einmal den Link aufrufen, um überhaupt zu wissen, was Sache ist. Das kann mit der Zeit extrem nervig werden.

… was Diaspora besser macht als andere Netzwerke

Kommen wir jetzt aber zu den Aspekten, die ich an Diaspora mag.

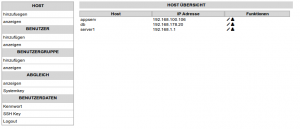

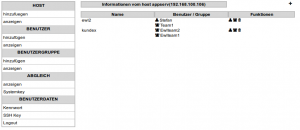

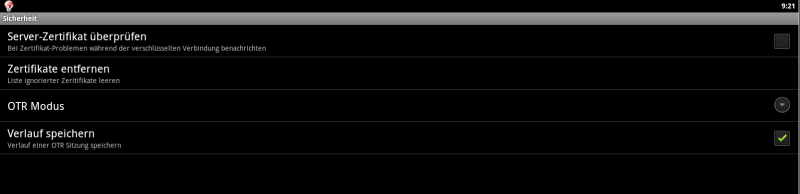

Das wohl wichtigste Argument für Diaspora ist die Unabhängigkeit und der dezentrale Aufbau des gesamten Diaspora Netzwerks. Man ist nicht an einen Server oder einen Anbieter gebunden, sondern kann sogar seinen eigenen Pod aufsetzen (So heißen die Diaspora Server). Seine Daten gibt man nicht in die Hände eines großen Internetkonzerns, sondern oft in die Hände von Privatpersonen, die sich ihrer Verantwortung aber durchaus bewusst sind. Da man aber die Wahl hat, kann man sich seinen Hoster selbst aussuchen und entscheidet, wem man die privaten Daten anvertrauen will.

Was man postet, wird von keiner Software analysiert und ausgewertet: Niemand schlägt Profit aus dem, was die Nutzer posten. Für Datenschutz ist also bestens gesorgt. Vorausgesetzt natürlich, der Betreiber des Pods geht verantwortungsvoll mit den Nutzerdaten um. Wenn man niemandem traut, hat man aber immer noch die Option, sich einfach selbst zu vertrauen und seinen eigenen Pod aufzusetzen ;)

Diaspora ist außerdem ein Open Source Projekt. Ich bin ein großer Fan von Open Source Software. Sie fördert internationale Zusammenarbeit, und verbindet viele Menschen. Der Nutzer kann kontrollieren, wie die Software funktioniert, die er nutzt, und hat die volle Kontrolle über sie. Code kann nicht versteckt werden; jeder sieht alles. Und das ist auch gut so. Backdoors werden unmöglich gemacht und Sicherheitslecks schneller gefunden und gefixt. Viele Augen sehen mehr als eins. Das dürfte bekannt sein ;) Wer Diaspora nutzt, zeigt damit, dass er hinter dem Gedanken von Open Source Software steht und diese unterstützt. Eine tolle Möglichkeit, Open Source Software erfolgreich zu machen, ohne selbst dafür entwickeln zu müssen.

Neben den positiven, ideellen Aspekten hat Diaspora aber auch noch andere tolle Merkmale. In den Stream lassen sich nicht nur sog. Aspekte (Nutzergruppen) integrieren, sondern auch Hashtags. Wenn sich jemand für Linux interessiert, kann er z.B. dem Hashtag “#Linux” folgen und bekommt dann immer aktuelle, passende Beiträge in seinen Stream. Unter dem Hashtag “#neuhier” kann man übrigens neue Diaspora-Nutzer begrüßen :)

Der Stream ist übrigens sehr aufgeräumt und vor allem: Sauber chronologisch geordnet. Im Gegensatz zu Google+ hat hier kein Algorithmus seine Finger im Spiel, der meint, meine Beiträge je nach der von ihm festgelegten Priorität sortieren zu müssen. Google Plus ist in den letzten Wochen fast nicht mehr vernünftig nutzbar geworden. Ständig verpasst man Beiträge oder findet sie nicht mehr, sollte man ihn doch noch einmal ansehen wollen. Der Stream ist ein einziges Durcheinander, in dem man sich kaum mehr zurechtfindet.

Aber das ist noch nicht alles. Zwischen den Beiträgen tauchen auf immer wieder Beiträge fremder Nutzer auf, die einen eigentlich gar nicht interessieren. Warum? Weil jemand aus den eigenen G+ Kontakten diesen einen Beitrag “geplusst” hat. Deshalb wird er einem jetzt auch angezeigt mit dem Hinweis: “xzy hat +1 für diesen Beitrag gegeben.” Also ob mich das interessieren würde. Mit der Einführung dieses “Features” hat sich Google dem Konkurrenten Facebook nochmal ein ganzes Stück angenähert. Kann ich aber absolut nicht brauchen. Ich will in meinem Stream, was ich in meinem Stream will, und nicht, was eine Maschine oder ein anderer denkt, das ich in meinem Stream will. Eh… also… Ihr wisst, wie ich meine. Ich will selbst entscheiden, was ich zu Gesicht bekomme.

… Gut, dass es da Diaspora gibt. Ein ordentlicher, einspaltiger Stream, der nur das enthält, was meine Kontakte von sich geben. Keine Hinweise auf irgendwelche Spielchen oder Spieleeinladungen (die es bei Diaspora übrigens nicht gibt), keine Einladungen in Communities und zu Veranstaltungen.

Wie schön, man hat endlich seine Ruhe und bekommt, was man haben will. Diaspora erinnert mich manchmal an die erste Version von Google+. Damals war die Welt noch gut und Google+ ebenfalls. Das hat sich aber Monat für Monat geändert und jetzt ist Google+ nichts mehr weiter als eine geschminkte Facebook-Kopie. Schade.

Ich werde mich auf alle Fälle in Zukunft mehr an Diaspora orientieren, denn G+ ist mir schön langsam zu blöd. Wer sich gerade überlegt, ob er auch mal Diaspora ausprobieren soll: Ja. Probiert es bitte aus. Die Erfahrung ist eine Registrierung wert.

Mein Profil findet ihr hier: https://pod.geraspora.de/u/thomas_leister und meine Diaspora ID ist thomas_leister@pod.geraspora.de .

An alle Diaspora-User: Was stört euch an Diaspora? Was würdet ihr euch noch wünschen? Was findet ihr besonders toll an Diaspora? Ab damit in die Kommentare, es interessiert mich! :)