Foto: jarmoluk / Lizenz: CC0

Anfang Dezember hatte ich recht abstrakt über die Mängel von Linux in Nischenbereichen geschrieben. Insbesondere in Bereichen, die für klassiche Anwender aus dem MINT-Bereich weniger interessant sind, fällt die Qualität - so zumindest meine Meinung - im Linux-Segment deutlich ab. Mit einer Tendenz zunehmend den Anschluss an andere Plattformen zu verlieren. Entwickler investieren Lebens- und Arbeitszeit nämlich meiner Ansicht nach vor allem aus zwei Motiven: Entweder weil sie es selber benötigen oder weil sie davon ihren Lebensunterhalt bestreiten können. Im Kommentarverlauf kam die Aufforderung "Aber du solltest schon Beispiele nennen, wenn du eine so steile These formulierst". Das soll hiermit nachgeholt werden.

Arbeiten am PC bedeutet für mich vor allem Wissensorganisation und klassisches Personal Information Management. Naturgemäß stößt man in Bereichen, die man vollkommen ausreizt auch am schnellsten an die Grenzen des Machbaren auf einer Plattform.

Daher folgt nun eine kleine Auflistung der Möglichkeiten und Grenzen anhand einiger Beispiel:

Literaturverwaltung

Literaturverwaltung ist eine essenzielle Funktion, wenn man mit Monographien und unselbständig publizierter Literatur im drei- bis vierstellen Bereich arbeitet. In den letzten Jahren haben sich hier vor allem drei Typen von Literaturverwaltungsprogrammen etabliert:

- Kombinationsprogramme aus Literatur- und Wissensmangement wie Citavi oder Papers.

- Reine Literaturverwaltungsprogramme wie EndNote und BibTeX-Frontends.

- Cloud-Dienste wie Mendeley.

In meinem Arbeitsablauf benötige ich mindestens die Literaturverwaltung mit Dokumentenorganisation und Annotations-Funktion wie sie Citavi und Papers beherrscht. Natürlich kann man die Dokumente auch separat verwalten und mit einem PDF-Programm mit Anmerkungen versehen. Das kostet aber Zeit und man setzt elektronische Hilfsmittel wie einen PC ein, um effizienter zu arbeiten und nicht um mehr Arbeitszeit aufzuwenden. Es ist schließlich nicht das Ziel Arbeitszeit in die Pflege des Arbeitsgerätes zu investieren. Cloud-Anbieter kommen naturgemäß nicht infrage. Literatursammlungen und -auswertungen stellen einen nicht unerheblichen Teil wissenschaftlichen Arbeitens dar. Das mit Verlagen (wie z.B. im Fall Mendeley) zu teilen, sollte man sich gut überlegen.

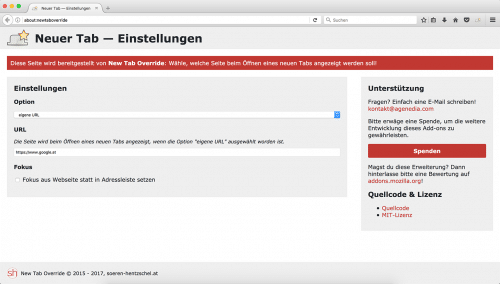

Linux bietet hier vor allem BibTeX-Frontends wie KBibTeX oder JabRef. Das ergänzt natürlich perfekt einen LaTeX-zentrierten Arbeitsablauf (siehe obiges Kommentar zum MINT-Bereich), ist aber ansonsten sehr limitiert im Funktionsumfang. Letztlich bietet eine BibTeX-Literaturverwaltung nicht mehr als eine bloße Auflistung der Literaturliste, die man auch tabellarisch erreichen könnte. Einzig Zotero bietet einen leicht erweiterten Funktionsumfang, aber angesichts der Abkehr Mozillas von XUL kann man sich über die Zukunft von Zotero begründete Sorgen machen. Zumal die Entwicklung in den letzten Jahren allenfalls unter dem Gesichtspunkt Produktpflege erfolgte.

Die Schwäche von Linux in diesem Bereich ist umso bemerkenswerter, weil Linux angeblich gerade im universitären Bereich stark sein soll. Das scheint sich jedoch vor allem auf den naturwissenschaftlich/technischen Bereich zu erstrecken. Anders kann man die schwache Aufstellung in dem Bereich nicht erklären. Oder vielleicht liegt es eben doch an der Kostenlos-Mentalität, da sich die Entwicklung von Programmen wie EndNote oder Papers, die beide aus dem Mac-Ökosystem kommen, scheinbar lohnte - trotz eines ähnlich kleinen Marktanteils.

Office

LibreOffice vs. Microsoft Office ist der Klassiker unter den Endlos-Diskussionen. Es sei hier nur der Vollständigkeit halber wähnt. LibreOffice ist einerseits das Flaggschiff unter den Open Source-Projekten, zeigt aber andererseits auch wie kaum ein anderes Projekt die Schwierigkeiten. Vom Funktionsumfang her gesehen kann es mit den proprietären Programmen gleichziehen (MS Office) oder übertrifft sie sogar deutlich (Apple Programme). Funktionale Einschränkungen wie der immer noch fehlerbehaftete Im-/Export von OOXML-Dokumenten kann man dem Projekt nicht wirklich ankreiden. Sie führen aber leider dazu, dass der Anwender - sofern man auf eine nahtlose Zusammenarbeit angewiesen ist - hier auf die proprietäre Konkurrenz ausweichen muss.

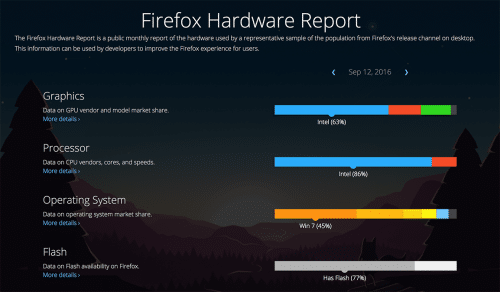

Dies kann man aber leider nicht unter Linux. Microsoft bietet sein Office für Android, iOS, macOS und Windows an - jedoch nicht für Linux. Grundsätzliche Abneigung gegen freie Software kann man nach den Veränderungen der letzten Jahre kaum unterstellen. Offensichtlich lohnt es sich aber für Microsoft ihr Office-Programm für macOS zu entwickeln (hier hat man mit der Version 2016 ja nochmal ordentlich Arbeit investiert), wohingegen man scheinbar davon ausgeht, das es sich bei Linux nicht rechnen wird.

Organisation

Organisation ist der Bereich in dem Linux recht gut aufgestellt ist. Der Bereich muss erwähnt werden, damit es nicht den Anschein hat, hier würden nur die Schwächen gelistet werden. Es gibt zwei ernstzunehmende PIM-Programme: Evolution und Kontact und zudem mit Thunderbird ein stabiles Mailprogramm. Mit einem CalDAV-Backend kann man hier recht gut Kommunikation, Kalender und Aufgaben unter einem Dach verwalten.

Jedoch zeigt auch dieser Bereich die Schwächen des Open Source-Entwicklungsmodells. Für altmodische Groupware-Programme finden sich kaum Entwickler. Evolution hat seit Jahren kaum Fortschritte gemacht, Thunderbird befindet sich quasi offiziell im Wartungsmodus und Kontact wird von einer Handvoll Entwickler mühevoll gepflegt. Fortschritte, wie man sie bei den Apple-Programmen oder auch Outlook sieht, sind hier absolute Fehlanzeige. So lange man mit dem status quo leben kann, reicht das jedoch aus.

Wissensmanagement

Wissensorganisation ist der zentrale Teil wissenschaftlichen Arbeitens. Nicht jeder gelesene Text wird sofort in einer eigenen Publikation verarbeitet, sondern meist aufbereitet abgelegt. Dies kann einerseits durch Anmerkungen am Text selbst erfolgen (z.B. in Form einer Kopie/Scan) oder durch Anmerkungen am elektronischen Text. Die meisten PDF-Programme - auch für Linux - verfügen inzwischen über die Möglichkeit Annoationen im PDF zu speichern.

Problematischer wird es, wenn man Gedanken losgelöst von einem bestimmten Dokument organisieren möchte. Sofern man Textdokument-Sammelsurium anlegen möchte, benötigt man dafür ein Tool zum Wissensmanagement. Textdokumente eignen sich zudem kaum, weil sie durch die Fixierung auf Fließtext nur eine eingeschränkte Aufbereitung ermöglichen.

Die proprietäre Welt von Windows und macOS hat dafür in den letzten Jahren einiges hervorgebracht: OneNote, Evernote, Outline und noch einiges mehr. Für Linux gibt es kaum etwas. Hoffnungsvolle Ansätze wie BasKet oder NixNote scheiterten an mangelndem Entwicklerinteresse. Übrig bleiben Markdown-Editoren in unterschiedlichen Ausrichtungen. Auch hier scheint die Zielgruppe im LaTeX-affinen Umfeld angesiedelt zu sein.

Zusammengefasst

Dies ist nur eine kleine Zusammenfassung aus einem zugegebenermaßen recht speziellen Arbeitsfeld. Multimedia-Experten und Fotografen würden vermutlich andere Schwerpunkte setzen - die Erfahrung aus vielen Diskussionen lehrt aber, dass sie kaum zufriedener mit Linux sind.

Das Problem ist auch weniger, dass Linux in einigen Bereichen schwach aufgestellt ist. Problematisch ist vielmehr, dass sich hier seitdem ich Linux nutze (also seit ca. 10 Jahren) nichts getan hat. Während die anderen Systeme bereits 2006 tendenziell überlegen waren, aber der Vorsprung noch recht klein war, sind sie inzwischen geradezu uneinholbar enteilt. Nach so vielen Jahren, in denen Desktops mehrfach komplett neu entwickelt wurden, aber in diesem Bereich nichts geschah, muss man sich fragen ob man das nicht als strukturelles Problem hinnimmt und seinen eigenen Arbeitsablauf auf ein funktionaleres System umstellt.

Kommerzielle Entwicklung lohnt sich vor allem da, wo Supportverträge bereits die Regel sind und aus diesen Dienstleistungsverträgen Entwicklungszeit in freie Software abgeleitet werden kann. Im Enterprise-Umfeld kann Linux seine Stärken daher voll ausspielen und Privatanwender mit Interesse an diesen Bereichen erhalten ein exzellentes Betriebssystem.

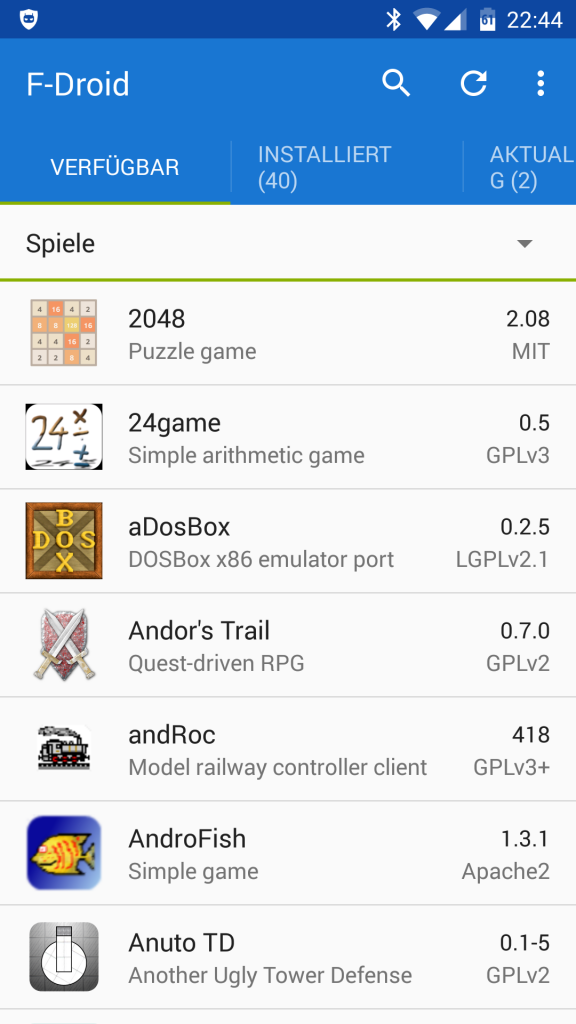

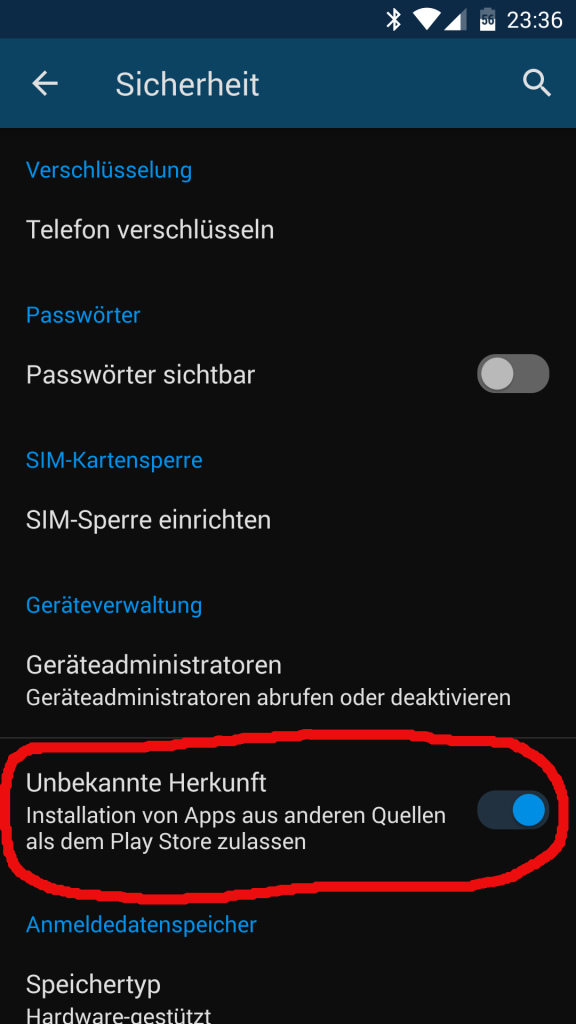

Dort wo aber Entwicklerzeit durch den mühsamen Verkauf von Lizenzen an eine Vielzahl von Anwendern finanziert wird scheitert Linux. Das hat weniger mit den Marktanteilen zu tun, was sich Linux-Enthusiasten manchmal einreden, sondern mehr mit der verbreiteten Freibier-Mentalität seiner Anwender. Mit der zunehmenden Abwanderung von ehrenamtlicher Entwicklerkapazität in mobile Bereiche wie Android wird sich dieses Problem noch verstärken.