Ich finde die neue Benutzeroberfläche sehr gut, und nicht zuletzt gefällt mir die semantische Suche und die doch mittlerweile zahlreichen Widgets für’s Desktop. Weiter so… oce

23. März 2010

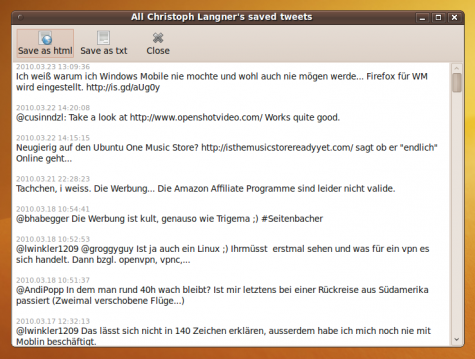

Accountmanager Histwi für Twitter ¶

Für Twitter gibt es ja unzählige webbasierte Tools. Ich will gar nicht erst anfangen Dienste wie FriendOrFollow und Co. zu verlinken. Desktop-Programme zum Managen von Twitter-Accounts sind dagegen selten, noch rarer sind solche Tools für Linux. Eifrige Linux-Twitterer sollten sich daher einmal Histwi ansehen.

Mit dem Programm könnt Ihr füre mehrere Twitter-Accounts die Tweets als .html oder .txt herunterladen, die Kontakte managen und sehen wer folgt, so dass Ihr ihm auch folgen könnt (bzw. andersum) und aufwändige Twitter-Suchen starten.

Für Ubuntu stellt der Autor ein PPA für das Programm zur Verfügung. Debian-Anwender finden auf der Homepage ein .deb Paket und für die restlichen Linux-Distributionen gibts den Python-Code als .tar.gz. Ab Ubuntu Karmic 9.10 installiert Ihr das Programm via…

sudo add-apt-repository ppa:nikolay-blohin/histwi sudo apt-get update sudo apt-get install histwi

…danach könnt Ihr es über “Anwendungen -> Internet -> Histwi” starten. Nach dem ersten Start müsst Ihr eure Accountdaten zu Twitter eingeben, danach braucht ihr – je nach eurer Twitter-Aktivität – etwas Zeit. Histwi braucht zum Auslesen eurer Twitter-Daten etwas Zeit.

Ab jetzt ist das Programm recht selbsterklärend – wenn auch bis dato noch nicht ins Deutsche übersetzt – Wenn ihr Accounts anlegt oder löscht, dann werden diese nur im Programm erzeugt bzw. gelöscht. Der Twitter-Account bleibt natürlich bestehen.

Wer viel Twittert kann über “Tweets” die eigenen Twitter-Hostorie als Text- oder HTML-Datei speichern lassen. So könnt ihr schnell in euren Tweets suchen.

Am praktischsten ist sicherlich die Management-Funktion. Über “Friends” bekommt Ihr eine dreigeteilte Liste eurer Kontakte. Links findet ihr eine Aufstellung aller Kontakte, denen ihr folgt, die euch aber nicht folgen. Mittig sind alle Kontakte aufgeführt denen Ihr folgt und die euch auch folgen. Und rechts kommen noch alle Kontakte, die euch folgen denen Ihr aber nicht folgt… (so viele folgen, entschuldigt dieses Deutsch…)

Ubuntu One Music Store FAQ ¶

Wie der Entwickler Stuart Langridge gestern großmundig auf seiner Minihomepage verkündete, ist der Ubuntu One Music Store nun für Betatester geöffnet. Einen Monat vor Veröffentlichung der neuen Ubuntuversion werden die Betatester mit diesem Schmankerl belohnt. Über Sinn und Unsinn dieses Projektes möchte ich mit diesem Artikel gar nichts sagen, ich nahm mir lediglich die Freiheit, die aktualisierte Fragensammlung von ubuntu.com ins deutsche zu übersetzen.

FAQ für Tester

Frage: Wo soll man Fehler melden?

Fehler sollten grundsätzlich gemeldet werden. Damit das Team die besten Informationen erhält, sollte man folgende Zeile in das Terminal eingeben:

ubuntu-bug rhythmbox-ubuntuone-music-store

F: Wie bekomme ich den Store zum laufen? Es scheint nicht zu funktionieren.

Stelle sicher, dass die Ubuntu One Software richtig verbunden ist. Klicke im Panel auf deinen Namen und wähle Ubuntu One …. Danach auf Geräte und Verbinden. In der Betaphase muss die Verbindung zu Ubuntu One vor der Benutzung des Stores bestehen. Mit dem Befehl

u1sdtool -c

kann man die Verbindung über das Terminal herstellen, mit dem Befehl

u1sdtool -s

kann man den Verbindungsstatus überprüfen.

Allgemeine Fragen:

Hierzu bitte die auch ausführlicheren Antworten von Christoph beachten.

F: Kann man den Account von 7digital und Ubuntu One verbinden?

Obwohl eine Partnerschaft besteht, kann man bestehende Konten von 7digital nicht auf Ubuntu One übertragen.

F: Wie sieht der Music Store genau aus?

Die Lieder aus dem Ubuntu One Music Store sind mit mindestens 256kb/s verfügbar, teilweise sogar höher. Es wird das MP3 Format ohne DRM verwendet (und auch kein Wasserzeichen wird eingebunden), folglich können die Lieder

- beliebig oft auf CD gebrannt

- mit beliebiger Musikabspielsoftware wiedergegeben werden, sofern diese MP3 unterstützt

- mit jedem MP3-fähigen Endgerät synchronisiert werden

Vereinzelt können noch WMA-Dateien im Store auftauchen, die aber frühstmöglich aus dem Verkehr gezogen werden sollen. Es wird empfohlen, diese nicht zu kaufen, das es meistens eine MP3-Datei als Alternative gibt.

F: Systemvorraussetzungen?

Ubuntu 10.04 auf dem PC, eine funktionierende Soundkarte, Rhythmbox und eine Internetverbindung

F: Welche Regionen außerhalb der EU, dem vereinten Königreich und der USA werden für den Store freigegeben?

Nach der Veröffentlichung von Ubuntu 10.04 wird die Benutzung des Ubuntu One Music Stores analysiert und danach entschieden, welche Länder als nächstes freigegeben werden. Wer an der Expansion interessiert ist, sollte dem Ubuntu One Blog folgen.

F: Ubuntu kann in der Standardkonfiguration keine MP3 abspielen. Wie kann ich gekaufte Songs dennoch hören?

Canonical gibt sich Mühe, die Benutzung so einfach wie möglich zu machen. Darum wirst du bei einem Besuch des Stores automatisch informiert, falls du die notwendigen Codecs nicht installiert hast. Sollte dies nicht der Fall sein, wird automatisch das Fluendo MP3-Plugin für GStreamer installiert, welches weltweit Lizenzkostenfrei bezogen werden kann. Dazu ist eine Internetverbindung notwendig.

Quelle: https://wiki.ubuntu.com/UbuntuOne/MusicStore

Mit freundlicher Genehmigung von Matt Griffin

Weitere Infos: http://www.golem.de/1003/74036.html

KDE - Plasma Netbook Reference Platform ¶

Geredet wurde über eine Edition von KDEs Plasmadesktop für Netbooks ja schon lange und auch schon ich habe einige Zeilen darüber hier verloren. Ehrlich gesagt war es lange Zeit recht ruhig um die ganze Sache. Fast ein Jahr hat man in der Öffentlichkeit nichts über Plasma für Netbooks gehört. Scheinbar bringt aber die MeeGo Geschichte wieder Wind in die Sache. Jedenfalls gibt es jetzt installationsfähige Abbilder auf den Servern des openSUSE-Projektes. Die KDE-Netbookvariante basiert auf openSUSE 11.2 und wurde im openSUSE Buildservice gebaut.

Geredet wurde über eine Edition von KDEs Plasmadesktop für Netbooks ja schon lange und auch schon ich habe einige Zeilen darüber hier verloren. Ehrlich gesagt war es lange Zeit recht ruhig um die ganze Sache. Fast ein Jahr hat man in der Öffentlichkeit nichts über Plasma für Netbooks gehört. Scheinbar bringt aber die MeeGo Geschichte wieder Wind in die Sache. Jedenfalls gibt es jetzt installationsfähige Abbilder auf den Servern des openSUSE-Projektes. Die KDE-Netbookvariante basiert auf openSUSE 11.2 und wurde im openSUSE Buildservice gebaut.

Aufnahme im Ubuntuusers-Planeten ¶

Da bin ich nun also im Planeten von ubuntuusers. Eigentlich kann ich es gar nicht wirklich fassen, aber ich freue mich - sehr. Es ist unglaublich, wie schwer es ist, so einen ersten Artikel zu verfassen. Ich habe aufgehört zu zählen, der wievielte Anlauf das hier ist.

Mein Name ist Helena. Ich schreibe in meinen Blog alles was mich interessiert und was ich verbreitenswert finde. Das hat natürlich zur Konsequenz, dass ein Teil der Beiträge bereits woanders beschrieben wurde. In solchen Fällen bemühe ich mich um eine Zusammenfassung der Geschehnisse oder/und um eine einsteigerfreundliche Beschreibung bzw. Linksammlung, so dass sich auch Neulinge mit den Themen auseinandersetzen können. Gleiches gilt für meine linuxspezifischen Artikel. Themen wie top. htop, pstree, ps oder auch Hilfreiches und Nützliches in der Bash (Teil 1 und Teil 2) richten sich immer an Einsteiger in das Gebiet, wobei auch alte Hasen hierbei immer wieder was Neues lernen. Das berichten sie mir zumindest. ;)

Ich selbst würde mich als Frischling bezeichnen, aber auch ich verfalle in einen Fachjargon oder umständliche Formulierungen. Wenn dem so ist, dann fragt nach und weist mich bitte draufhin, damit ich es verbessern kann.

In den Planeten werden nur die Linux-Artikel erscheinen. Ein Besuch des Blogs lohnt sich also für alle, die sich auch abseits davon für Skurrilitäten, Tagesgeschehen oder sonstigen Unfug interessieren. Ich freue mich auf jedenfall auf eure Kommentare, Anmerkungen und Meinungen. Scheut euch nicht mir persönlich zu schreiben oder einen Kommentar zu verfassen, aber die Ubuntuusers-User muss ich dazu nicht noch extra auffordern oder? ;) Ich bemühe mich immer persönlich auf Kommentare zu antworten und Verbesserungsvorschläge aufzunehmen. Ich hoffe, dass ich diesen Vorsatz auch weiter einhalten kann.

So jetzt wünsche ich euch noch viel Spaß beim Stöbern. Und ich schicke nun ein Stoßgebiet an die Servergötter... Lass meinen Server nicht in die Knie gehen.

P.s.: Für Themenvorschläge bin ich auch immer zu haben.... ;)

Deim und Hart auf MacLites ¶

Dirk und ich konnten bei Tillmann, der das Projekt Maclites bewirtschaftet, einige Fragen zu Linux, der Gemeinschaft und zu OpenSource beantworten. Die Fragen, die Tillmann zusammengestellt hat, wirkten auf mich herausfordernd, spannend und interessant. Es ist gar nicht so einfach, substanziell fordernde Fragen zu stellen, deren Beantwortung ist wohl simpler.

Dirks Antworten hat Tillmann bereits gestern veröffentlicht, diejenigen von mir sind heute auf dem Schirm zu sehen.

Vielen Dank für die guten Fragen, Tillmann! Es hat Spass gemacht, die Antworten zu liefern. Und es ist ein gutes Gefühl, zum erlauchten Kreis der Befragten zu gehören.

Ähnliche Artikel

Open Source für die kommerzielle Selbstbeweihräucherung ¶

Mit Open Source Software wird ja leider allerhand Schabernack getrieben, wie z. B. die kostenpflichtigen Downloads für das freie (free as in freedom) OpenOfficeOrg. Viele Anbieter erwecken teils den Eindruck, dass man für freie Software (oft als Profisoftware tituliert) zahlen muss. Gestern bin ich beim schmökern im Zeitungskiosk auf eine neue Variante gestoßen… In der aktuellen Ausgabe der (Profi- ![]() ) Computerzeitschrift com! prangt auf dem Cover direkt auf einer abgebildeten PartedMagic-CD ein Stern mit der Aufschrift “Gratis für com!-Leser”. Für mich erweckt dieses Cover den Eindruck, dass für das kostenlose! PartedMagic im Normalfall gezahlt werden muss und nur com!-Leser kämen jetzt in den Genuss von PM für Lau, wenn sie die Zeitschrift erwerben.

) Computerzeitschrift com! prangt auf dem Cover direkt auf einer abgebildeten PartedMagic-CD ein Stern mit der Aufschrift “Gratis für com!-Leser”. Für mich erweckt dieses Cover den Eindruck, dass für das kostenlose! PartedMagic im Normalfall gezahlt werden muss und nur com!-Leser kämen jetzt in den Genuss von PM für Lau, wenn sie die Zeitschrift erwerben.

Oder wie seht ihr das? Eure Meinungen würden mich interessieren! Kann man so etwas unterbinden?

Ich habe eigentlich ein schlechtes Handyfoto von dem Cover gemacht, aber com! bietet das Cover als PDF auf der Homepage an, also seht selbst…

Festplatte formatiert und nun? ¶

chmod 777 /media/diskein und schon funktionierte das ganze. Manchmal ist die Lösung so einfach

Weitere Informationen gibt es unter:

http://wiki.ubuntuusers.de/gparted

http://de.wikipedia.org/wiki/Ext4

Festplatte formatiert und nun? ¶

Gestern habe ich eine externe Festplatte mittels GParted formatiert. Als Dateisystem wählte ich ext4. Aus alter Gewohnheit (früherer Windowsnutzer halt ![]() ) wollte ich dann gleich etwas auf der Festplatte schreiben, doch die Festplatte wollte das nicht. Nach einigem überlegen kam ich dann drauf, öffnete ein Terminal und gab

) wollte ich dann gleich etwas auf der Festplatte schreiben, doch die Festplatte wollte das nicht. Nach einigem überlegen kam ich dann drauf, öffnete ein Terminal und gab

chmod 777 /media/disk

ein und schon funktionierte das ganze. Manchmal ist die Lösung so einfach ![]()

Weitere Informationen gibt es unter:

http://wiki.ubuntuusers.de/gparted

http://de.wikipedia.org/wiki/Ext4

Hoffentlich kein Aprilscherz: Commodore comes back! ¶

Bild.de gehört beileibe nicht zu meinen Lieblingsquellen. Als aber über Google News diese Meldung reinkam: „Der C64 kommt zurück! …als leistungsstarker Tastatur-PC von Commodore USA“ musste ich das lesen. Und ich gestehe, die Idee hat mich fasziniert. Ein PC im überarbeiteten Look and Feel des C64 bzw. Amiga 500 hat doch etwas. Erst letztens stand ich im hiesigen Elektronikmarkt vor einem PC, der komplett im Monitor integriert war, Apple-Computer in diesem Design gibt es ja schon länger. Auch wenn das sehr modern und edel aussieht, finde ich es nicht so prickelnd, z.B. wegen Monitorproblemen gleich den ganzen PC wegzugeben. Der neue Commodore hingegen ist auch platzsparend und ebenso ein Hingucker:

Wenn man sich die Konfiguration auf der Webseite anschaut (auf Configure klicken), wird man ebenfalls angenehm überrascht. Ausgeliefert wird der PC mit Ubuntu, Windows 7 ist optional erhältlich – und nicht anders herum! Weiterhin soll auf dem Gerät das MacOS ebenso laufen wie das AmigaOSÂ und noch einige andere Betriebssysteme.

Wenn man sich die Konfiguration auf der Webseite anschaut (auf Configure klicken), wird man ebenfalls angenehm überrascht. Ausgeliefert wird der PC mit Ubuntu, Windows 7 ist optional erhältlich – und nicht anders herum! Weiterhin soll auf dem Gerät das MacOS ebenso laufen wie das AmigaOSÂ und noch einige andere Betriebssysteme.

Aber ich gebe es zu, ich bin auch ein klein wenig skeptisch, wenn ich die Webseite anschaue. Sie sieht etwas unreif aus, es wird aber fleißig daran gearbeitet. Und es ist auch nicht klar, ob die Bilder einen Prototypen zeigen oder ob es sich hier um eine Attrappe handelt. Auch stehen noch keine Preise fest, der Shop soll im Juni 2010 Online gehen.

Die Idee hingegen finde ich toll! Gerade die alten Hasen unter uns, die mit C64, Amiga oder Atari aufgewachsen sind, werden feuchte Augen bekommen und bei einem fairen Preis wird das Gerät auch Abnehmer finden. Oder was meint Ihr? Ich drücke den Leuten dahinter auf alle Fälle ganz fest die Daumen, es wäre doch schön, wenn dieses Projekt dem Namen Commodore zu neuem Glanz verhilft!

22. März 2010

Linux 2.6.34-rc2 ¶

Ohne große Ankündigung wurde die zweite Vorabversion des Kernels 2.6.34 veröffentlicht.

Ein großer Anteil der Änderungen liegt in den beiden Dateisystemen btrfs und ceph. Ceph ist ein verteiltes Dateisystem, das als Implementierung ohne „Single Point of Failure“ konzipiert wurde. Der nun im Kernel verfügbare Teil stellt die Client-Komponente dar, während die Serverdienste als Dämonen umgesetzt sind.

Weitere, sehr umfangreiche Änderungen wurden an der ARM-Architektur durchgeführt und sind daneben dem neuen Treiber für die Gigabit-Ethernet-Schnittstelle LAN7500 von SMSC geschuldet.

Der Kernel 2.6.34-rc2 für Ubuntu im Mainline-Kernel-Archiv:

Das Ubuntu-Kernel-Team stellt ein Archiv mit dem Mainline-Kernel zur Verfügung, der ohne die spezifischen Anpassungen der regulären Ubuntu-Versionen erstellt wird.

Achtung! Die Installation des nicht angepassten Kernels kann die Systemstabilität beeinträchtigen!

Die Pakete 2 und 3 müssen nur installiert werden, wenn Anwendungen vorhanden sind, die die Headerdateien benötigen um z.B. Kernelmodule zu kompilieren. Die Pakete sollten dann in der jeweils aufgeführten Reihenfolge installiert werden. Die Kernel-Quellen werden nicht benötigt.

Architektur i386 (32 Bit):

- linux-image-2.6.34-020634rc2-generic_2.6.34-020634rc2_i386.deb (noch nicht verfügbar)

- linux-headers-2.6.34-020634rc2_2.6.34-020634rc2_all.deb (noch nicht verfügbar)

- linux-headers-2.6.34-020634rc2-generic_2.6.34-020634rc2_i386.deb (noch nicht verfügbar)

Architektur amd64 (64 Bit):

- linux-image-2.6.34-020634rc2-generic_2.6.34-020634rc2_amd64.deb (noch nicht verfügbar)

- linux-headers-2.6.34-020634rc2_2.6.34-020634rc2_all.deb (noch nicht verfügbar)

- linux-headers-2.6.34-020634rc2-generic_2.6.34-020634rc2_amd64.deb (noch nicht verfügbar)

Kernel-Quellen:

- Aus dem Ubuntu-Mainstream-Kernel-Archiv (installierbar): linux-source-2.6.34_2.6.34-020634rc2_all.deb (noch nicht verfügbar)

- Direkt von Kernel.org: gzip (ca. 82 MB) / Bzip2 (ca. 64 MB)

Ubuntu One Music Store ist online… ¶

Heute war es endlich soweit. Der Ubuntu Music Store ist heute online gegangen. Ubuntu 10.04 LTS Beta-Nutzer können die öffentliche Beta-Version des Shops nun nutzen und testen. Zu dem ganzen gibt es auch einen Blog-Beitrag mit allen wichtigen Informationen:

Testing goal

Our primary goal for this phase of testing is to ensure that the purchase and download experience is flawless. Integrating a cloud service like Ubuntu One with buying music is new for digital music stores. [...]

Testers must keep in mind that this is a beta test. We are excited to open this feature up for wider testing, but testers must understand that things will break. If something happens preventing a tester from receiving songs, there may be a delay in fulfilling their purchase. [...]

Als “Lieferant”, bzw. Partner kommt 7Digital zum Einsatz, die Musikdateien kommen im DRM-freien mp3-Format auf den Rechner. Der Store ist übrigens mit Hilfe eines Plugins in Rhythmbox integriert und sollte in der Testversion bzw. auch dann in der Finalversion schon installiert sein. So sieht das ganze aus…

Ich möchte aber nicht dazu raten deswegen jetzt auf die Beta-Version von 10.04 LTS zu aktualisieren. Die Version ist weiterhin nicht zum Produktiveinsatz geeignet. Wer sich aber schon einmal einen Überblick über die angebotene Musik machen möchte kann dies auch auf der Website von 7Digital tun.

virtualpixel.de speichert nicht! ¶

Datenschutz ist wichtig und persönliche Daten definitiv schützenswert. Ich bin selbstverständlich ein großer Befürworter der ganzen Thematik. Doch wie heißt es so schön: Man solle sich doch lieber mal an die eigene Nase fassen!

Ganz im Sinne dieses Spruches, habe ich mal geschaut was auf diesem Server und dem Wordpresssystem so alles gespeichert wird und eigentlich gar nicht gespeichert werden muss. Dazu gehörten Wordpress Stats, Google Analytics, Google Adsense und der Webserver Apache an sich. Also ran an den Speck.

Über das Apachemodul mod-removeip wird automatisch das Apachelog anonymisiert. Unter Ubuntu ist es das Paket libapache2-mod-removeip. Nach einem anschließenden Neustartes des Server, sind die IP-Adressen aus den Logs verschwunden.

Die Google Adsense Anzeigen, die ich vor kurzem erst eingeführt habe, sind nun wieder entfernt. Es bringt zu wenig Geld und stört mein ästhetisches Auge einfach zu sehr.

Bleiben noch Wordpress Stats und Google Analytics. Beides wurde nun gegen das selbst gehostete Statistiksystem Piwik getauscht, welches eine OpenSource Alternative zu Google Analytics ist in der neuesten Version ebenfalls die IP Adressen anonymisiert.

Damit werden nun auf virtualpixel.de keine personenbezogenen Daten mehr gespeichert und ihr könnt in Ruhe weiterlesen.

(Achja, auf Planetenblogger.de werden in dem Zuge auch keine personenbezogenen Daten mehr gespeichert.)

Fensterbuttons im neuen Ubuntu 10.04 ¶

Moin liebe Lesergemeinde,

man sieht an der momentanen Diskussion rund um die Fensterbuttons (Schließen, Minimieren, Maximieren), dass die meisten Ubuntu/Linuxuser irgendwie keine anderen Probleme haben, als sich über die neue Position der Buttons aufzuregen.

Das ist eigentlich sehr erfreulich, heißt es doch, dass Ubuntu/Linux so gut wie keine weiteren Probleme mehr macht – wenn man die Zeit hat über so etwas Nebensächliches wochenlang zu diskutieren.

![]()

Übrigens für die Leute, die sich an die Buttons nicht gewöhnen wollen – nehmt Tastenkombinationen. Da können die Buttons auch auf der Rückseite des Programmfensters sein, das ist dann egal ^^.

Schließen: Alt+F4

Minimieren: Alt+F9

Maximieren (ein/aus): Alt+F10

Evolution RSS ¶

Da ich meine Mails unter anderem mit Evolution verwalte, weil es sich mit dem synchronisiertem Adressbuch besser anbietet als Thunderbird, habe ich mit Freude festgestellt, dass sich auch Evolution als RSS-Feed Verwalter umfunktionieren lässt. Bisher nutze ich das Plugin Brief für Firefox, aus ein paar einfachen Gründen: Es stellt meine vielen Feeds übersichtlich dar, aktualisiert sie regelmäßig und ich kann über Firefox’ Statusleiste sofort sehen, ob und wie viele ungelesene Beiträge im Reader auf mich warten.

Da ich meine Mails unter anderem mit Evolution verwalte, weil es sich mit dem synchronisiertem Adressbuch besser anbietet als Thunderbird, habe ich mit Freude festgestellt, dass sich auch Evolution als RSS-Feed Verwalter umfunktionieren lässt. Bisher nutze ich das Plugin Brief für Firefox, aus ein paar einfachen Gründen: Es stellt meine vielen Feeds übersichtlich dar, aktualisiert sie regelmäßig und ich kann über Firefox’ Statusleiste sofort sehen, ob und wie viele ungelesene Beiträge im Reader auf mich warten.

Diese Vorteile sind zwar schön und gut, aber eine Alternative wäre trotzdem nicht verkehrt. Ein Standalonereader kommt für mich nicht in Frage, da dieser nur im Weg wäre. Ein weiteres Fenster nur für Feeds ist mir zu umständlich. Gwibber kann zwar auch RSS-Feeds verwalten, allerdings nutze ich dieses Programm nicht* ![]() Evolution hingegen nutze ich sowieso, da ich meine Mails permanent im Hintergrund abfragen lassen möchte. Darum bietet es sich hervorragend dazu an.

Evolution hingegen nutze ich sowieso, da ich meine Mails permanent im Hintergrund abfragen lassen möchte. Darum bietet es sich hervorragend dazu an.

Um die Feeds in diesem Programm lesen zu können, benötigt man zunächst das Paket evolution-rss, das man z.B. mit dem Befehl

sudo apt-get install evolution-rss

installieren kann. Nach einem Neustart von Evolution findet man einen neuen Eintrag unter Bearbeiten → Einstellungen, über den man RSS Feeds verwalten kann. Im Ordner „Auf diesem Rechner“ ist danach ein neuer Ordner mit eingetragenen RSS-Feeds zu finden. Die einzelnen Beiträge werden wie E-Mails angezeigt und behandelt.

Was mich dabei allerdings stört ist, dass ungelesene Feeds nicht im Indicator Applet angezeigt werden. Das wäre schön, wenn das ginge. *) Ich glaube, Gwibber würde neue Beiträge in den Feeds im Indicatorapplet hervorheben.

Ubuntu One Music Store geht heute online ¶

Wird der UbuntuOne Music Store heute online gehen?

Auf der Website des neuen Music Stores von Canonical (Firma hinter Ubuntu), welcher ab dem Luchs (Ubuntu 10.04) in Rhythmbox dem standard Medienplayer von Ubuntu integriert ist, steht dass dieser heute vielleicht online geht.

Dann bin ich doch mal gespannt wie der Store rein Optisch aussieht und welche Musik angeboten wird.

Enlightenment E17 kommt bald – Wirklich! ;-) ¶

Laut diesem Entwicklerblog soll E17 wirklich bald als Stableversion freigegeben werden. Auf ein definitives Datum will sich aber trotzdem niemand festlegen. ![]() Es werden als erstes die Libaries stabilisiert, anschließend der Rest von E17 und dann wird released!

Es werden als erstes die Libaries stabilisiert, anschließend der Rest von E17 und dann wird released! ![]() Einen Überblick über die Arbeiten kann man sich auf der “Road to Enlightenment” verschaffen. Im Blog werden auch noch ein paar andere häufiggestellte Fragen beantwortet.

Einen Überblick über die Arbeiten kann man sich auf der “Road to Enlightenment” verschaffen. Im Blog werden auch noch ein paar andere häufiggestellte Fragen beantwortet.

Wer sich jetzt schon für E17 interessiert, findet vielleicht meinen Artikel zu den E17-Repos interessant. ![]()

Piwik 0.5.5 ohne IP Speicherung ¶

Vor kurzem ist Piwik in der Version 0.5.5 erschienen. Nachdem Ende letzten Jahres der Release Rythmus sehr schnell war, ist nun wieder etwas Ruhe eingekehrt und die Zyklen sind langsamer geworden.

In der neuen Version ist ein sehr wichtiges Plugin vorinstalliert. Dieses nennt sich AnonymizeIP und sorgt nach der Aktivierung dafür, dass alle IP Adressen in der Datenbank anonymisiert werden. Standardmäßig wird das letzte Oktett genullt, also aus einer IP Adresse 192.168.245.123 würde 192.168.245.0 werden, so wird eine eindeutige Identifizierbarkeit verhindert. In der config/global.ini.php kann man diese Einstellung auch verändern indem man den Wert „ip_address_mask_length = 1“ ändert. Möglich sind die Optionen 0-4, wobei 0 einer Deaktivierung des Plugins gleichkommt und bei 4 wird die komplette IP Adresse genullt. Die Anonymisierung funktioniert aber nur auf zukünftige Einträge, nicht auf schon vorhandene. Wie das ganze bei IPv6 Adressen aussieht weis ich nicht, aber die meisten Webseiten sind ja eh noch nicht über IPv6 erreichbar!

Wir haben dies so eingestellt, dass die letzten 2 Oktette genullt werden. So sind unsere Besucher vollkommen anonym. Vor allem in Deutschland ist das Speichern der IP Adressen ja sehr umstritten, Piwik entgeht der Diskussion so auf einfachem Wege. Jeder der Google Analytics benutzt, sollte sich mal überlegen ob er selber will, das sein Nutzerverhalten in die USA wandert. Ich halte hier von Piwik deutlich mehr, vor allem weil es auf dem eigenen Server ist und ich so die Kontrolle darüber behalte.

Was sich mit der neuen Version sonst noch alles so geändert hat findet man im Changelog! Die deutsche Übersetzung ist nicht aktuell. Wir selber haben einige Male versucht eine aktuelle Deutsche Übersetzung beizutragen, aber über den Kontakt zum Übersetzungsteam erreicht man auch mit mehrmaliger Anfrage niemanden. Wir haben aktualisierte Sprachdateien für die letzten Versionen des öfteren an das Team geschickt und nie wurde diese übernommen und auch kam keine Antwort zurück. Leider verbaut sich Piwik so selber seine Aktualität.

Falls von euch jemand Kontakte zum Team hat, der kann sich ja mal bei uns melden.

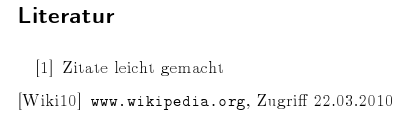

Nicht jeder verwendet LaTeX so wie ich auch für niedere Dienste wie Einkaufszettel. Der natürliche Lebensraum eines gesunden LaTeX-Dokumentes welches in der Blüte seiner Jahre nach kurzer Verpuppung aus dem TeX-Container als wunderschöne PDF-Datei hervorbricht ist die wissenschaftliche Arbeit. Und sofern die Arbeit nicht ausschließlich von Erkenntnissen handelt die der/die Schreiber in Experimenten erhalten haben muss korrekt zitiert und verwiesen werden. Manche Style-Dokumente beinhalten bereits eine Gruppe von vorgefertigten Befehlen mit denen solche Angaben ziemlich automatisch in einem bestimmten Stil erstellt werden können. Da es davon jedoch sehr viele gibt und diese im allgemeinen recht gut dokumentiert sind werde ich mich hier nur um die manuelle Erstellung von Literaturverzeichnissen kümmern.

Grundsätzlich sollte man so vorgehen:

- Das Werk aus dem man zitieren möchte in das Literaturverzeichnis schreiben.

- Mit dem Schlüssel aus dem Literaturverzeichnisses die Zitierung im Text einfügen.

Erstellung des Literaturverzeichnisses

Die Quellenangabe kommt im LaTeX-Dokument ganz zum Schluss. Direkt vor das

\end{document}

und sieht so aus:

\begin{thebibliography}{999}\bibitem {Zitat01} Zitate leicht gemacht\bibitem [Wiki10] {UndNochEinZitat} \url{www.wikipedia.org}, Zugriff 22.03.2010\end{thebibliography}

Wieder erkennt man die typische LaTeX-Umgebung welche mit dem Befehl \begin beginnt und mit dem Befehl \end endet. Um eine Quellenangaben-Umgebung zu schaffen wird thebibliography verwendet. Der zweite Wert "999" bezieht sich auf die maximale Breite der Label. Seit jeher verwende ich 999 um keine Probleme zu erhalten, man kann den Wert aber natürlich anpassen wie man ihn braucht.

Der erste gezeigte Eintrag stellt das Minimum dar mit dem man ein Literaturverzeichnis erstellen kann. Der Befehl \bibitem erzeugt einen neuen Eintrag im Literaturverzeichnis. In den geschwungenen Klammern steht der Schlüssel mit dem man später das Zitat im Text identifiziert. Dieser Schlüssel kann irgendetwas sein da er im fertigen Dokument nicht angezeigt wird. Diese Variante wird automatisch durchnummeriert.

Um einen bestimmten Text statt einer Nummer zu erhalten muss man in eckigen Klammern wie im zweiten Eintrag gezeigt ein Label eintragen. Damit wird dieses Label bei der Zitierung angegeben.

So sieht der obige Code als PDF aus:

Der Titel des Literaturverzeichnisses wird je nach der angegebenen Sprache beim Einbinden des Paketes babel übersetzt.

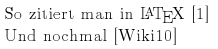

Zitieren

Nun haben wir unser Literaturverzeichnis erstellt und können munter beginnen zu zitieren. Zum Zitieren braucht man keine bestimmte Umgebung sondern kann das Zitat direkt in den Text schreiben. Das funktioniert so:

So zitiert man in \LaTeX{} \cite{Zitat01}\\

Und nochmal \cite{UndNochEinZitat}

Der Befehl \cite fügt die Zitierung ein. Abhängig davon ob im Literaturverzeichnis ein Label angegeben wurde wird dieses oder die fortlaufende Nummer eingefügt. Im ersten Satz habe ich die erste Quelle aus dem Literaturverzeichnis verwendet, im zweiten Satz die Zweite. Das Ganze sieht als PDF so aus:

Ich merke noch einmal an: Der Schlüssel (z.B. Zitat01 oder UndNochEinZitat) wird nur innerhalb des Dokumentes verwendet. Bei einer Zitierung eines des Eintrages im Literaturverzeichnisses wird entweder die dem Eintrag automatisch zugewiesene Laufnummer angezeigt oder der Text eines Labels (z.B. Wiki10) falls man dieses angegeben hat. Um Verwirrungen zu vermeiden sollten diese beiden Systeme jedoch nicht gemischt werden. Professionelle Literaturangaben sehen natürlich anders aus und beinhalten wesentlich mehr Informationen zum zitierten Werk. Je nach euren Vorgaben müsst ihr dies anpassen.

This work by Stefan Ohri is licensed under a Creative Commons Attribution-ShareAlike 3.0 Austria License

=-=-=-=-=

Powered by Blogilo

Filed under: LaTeX, Programmieren, Ubuntuusers

Die erste Mini-Anwendung mit CakePHP ¶

Am vergangen Sonntag durfte ich bei der Schulung von Roland in Sachen CakePHP mit dabei sein. Das Framework interessiert mich an sich und ausserdem sehe ich es als eine Möglichkeit an, damit meine kleinen Webapplikationen neu zu zimmern. Alle Teilnehmer haben ein “nackiges” Framework erstellt und sind von dort aus gestartet. Das ist auch durchaus sinnreich und allemal besser, als wenn wir von Roland ein fertiges Päckli bekommen hätten. Wir haben zwar ein solches Paket erhalten, aber nicht um damit während der Schulung zu arbeiten, sondern um daraus einige Beispiele zu ziehen und natürlich auch für das nachträgliche Studium.

Im Vorfeld habe ich auf meinem kleine EEEPC 1000H einige Vorkehrungen getroffen. Darauf läuft ein Ubuntu 9.10. Es braucht also nicht zwingend ein Server zu sein, auch wenn das natürlich bei einer fertig gebackenen Applikation sinnreich wäre. Aber zum Entwickeln reicht also ein solch kleiner Kerl, der übrigens bloss ein Gigabyte flüchtigen Speicher besitzt.

Im Vorfeld habe ich auf meinem kleine EEEPC 1000H einige Vorkehrungen getroffen. Darauf läuft ein Ubuntu 9.10. Es braucht also nicht zwingend ein Server zu sein, auch wenn das natürlich bei einer fertig gebackenen Applikation sinnreich wäre. Aber zum Entwickeln reicht also ein solch kleiner Kerl, der übrigens bloss ein Gigabyte flüchtigen Speicher besitzt.

Manchmal hätte ich aber dann doch lieber ein etwas grösseren Bildschirm gehabt, gerade bei der Ansicht der Konsole, die ab und an eine ziemlich lange “Backliste” anzeigt. Aber es ging letztlich auch so ganz gut. Ich installierte PHP, den Apache Webserver, den MySQL-Server und für mich noch optional PHPMyAdmin. Wer möchte, kann sich natürlich auch über die Konsole die nötigen Datenbanken Tabellen anlegen. Ich mag einfach lieber das GUI.

sudo apt-get install php5 php5-cli mysql-server apache2 phpmyadmin

Wichtig ist, dass beim Apache-Webserver das Modul mod_rewrite aktiviert ist. Das haben wir nach längeren Detektivarbeiten und Dank Ute herausgefunden. Auf ubuntusers.de gibt es dazu einen gesunden Wiki-Artikel. (Heisst es eigentlich einen gesunden Wiki-Artikel oder ein gesunder Wiki-Artikel?)

Anschliessend holten wir uns die aktuelle und stabile Source auf der Website von CakePHP und entpackten sie. Der Apache muss dann auf das Verzeichnis webroot im Baum des Downloads unter app zeigen. Die Datei default im Verzeichnis /etc/apache2/sites-available hat bei mir folgendes Aussehen, allerdings habe ich keine zusätzlichen virtuellen Hosts, sondern bloss eine Site erzeugt. Auch hier hat mich Ute unterstützt:

<virtualhost *:80> ServerAdmin webmaster@localhost DocumentRoot /home/roman/cakephp/app/webroot <directory /> Options FollowSymLinks AllowOverride FileInfo Options <directory /home/roman/cakephp/app/webroot> Options Indexes FollowSymLinks AllowOverride FileInfo Options Order allow,deny allow from all </directory> ScriptAlias /cgi-bin/ /usr/lib/cgi-bin/ <directory "/usr/lib/cgi-bin"> AllowOverride None Options +ExecCGI -MultiViews +SymLinksIfOwnerMatch Order allow,deny Allow from all </directory> ErrorLog /var/log/apache2/error.log # Possible values include: debug, info, notice, warn, error, crit, # alert, emerg. LogLevel warn CustomLog /var/log/apache2/access.log combined Alias /doc/ "/usr/share/doc/" <directory "/usr/share/doc/"> Options Indexes MultiViews FollowSymLinks AllowOverride None Order deny,allow Deny from all Allow from 127.0.0.0/255.0.0.0 ::1/128 </directory> </virtualhost>

Damit funktionierte CakePHP ganz gut. Die Installation war also recht einfach, die ersten vier kleinen Hürden betreffen die Schreibrechte auf Verzeichnissen, die sichergestellt werden müssen und der “gesalzenen Sicherheit” sind rasch erledigt. Danach kann man bereits loslassen.

Roland hat sein Projekt, das wir ansatzweise an diesem Sonntag erarbeitet haben, in das Netz gestellt, so dass jeder daran partizipieren kann. Auch das ganze Modell und die Anforderungen stehen dort bereit. Die Idee, welche sich hinter diesem Vorgehen verbirgt, soll echte OpenSource-Programmierung abbilden. Jeder von uns kann oder darf einen Teil zu diesem Projekt beitragen, bis ein fertiges Produkt entsteht. So macht “opensourcen” Spass. Ich hoffe, dass ich mir hin und wieder ein Stündchen Zeit nehmen kann, um da mitzuwirken.

Während dem Kurs sind ein paar wenige Bilder entstanden, die ich in eben jener Applikation bereitgestellt habe, die einst durch die neu zu backende Anwendung ersetzt werden soll: In meiner kleinen Bilderdatenbank. An dieser Stelle sende ich ein dickes Dankeschön an Ute und Roland für die Gastfreundschaft und für den interessanten Sonntagnachmittag! Ich komme sicherlich noch einmal auf das Thema zurück und kann dann hoffentlich etwas tiefer über Technisches berichten.

Ähnliche Artikel

21. März 2010

Ixquick – Anonyme Suche ¶

Wer sich ein bisschen mit Suchmaschinen beschäftigt hat und diese nicht nur als Dienst nutzt, weiß, dass vieles was man eingibt von diesen gespeichert und analysiert wird. Vor allem Google ist da oftmals vorne mit dabei. Inwiefern das nun gut oder schlecht ist, kann jeder für sich selbst beantworten. Um eine Alternative, wie man gute Suchergebnisse erhält und keine Daten verrät, handelt es sich bei Ixquick.

Diese Metasearch aus den Niederlande, fasst verschiedene Suchmaschinen wie Bing, Yahoo, Ask und viele mehr zusammen und listet diese als Ergebnisse auf. Es wird aber nicht nur eine reine Suche angeboten, man kann auch eine Bilder-, eine Video- und eine Telefonbuchsuche nutzen. Neben Englisch und Deutsch stehen auch verschiedene andere Sprachen zur Verfügung. Außerdem bietet Ixquick direkt aus der Suche zu jedem Suchergebnis einen sehr schnellen Aufruf über einen Proxy Server bereit. Dazu weiter unten mehr.

Um Ixquick im Firefox zu nutzen, kann man verschiedene Wege gehen. Ich habe Ixquick als Suchmaschine im Suchfeld und auch im Adressfeld. Ich nutze das Ganze unter Ubuntu, man kann die folgenden Schritte aber auch unter anderen Betriebssystemen mit Firefox nutzen.

Zuerst zum Suchfeld, dies ist relativ einfach. Man muss einfach nur auf die Hinzufügen Seite gehen und dort die entsprechenden Einstellungen vornehmen. Neben dem AGB Akzeptieren ist die Sprachwahl vorhanden und vor allem, was viel interessanter ist, die Nutzung von HTTPS. Wenn man dies aktiviert, nutzt man die Suche immer über SSL, das macht die Sache neben der Anonymität sicherer. Nach dem Auwählen der Optionen klickt man einfach auf Installieren und setzt dies noch als Standardsuche im Firefox. Schon nutzt man Ixquick über das Suchfeld mit SSL. Also sicheres und anonymes Suchen!

Etwas komplizierter wird es nun, wenn man, so wie ich auch des Öfteren, über die Adresszeile Begriffe eingibt und so auch Suchergebnisse erhalten will. Dies ist auf der Ixquick Seite leider nicht dokumentiert und auf eine E-Mail Anfrage habe ich auch keine Antwort erhalten. Aber trotzdem geht es! Dafür muss man folgende Schritte machen:

In die Adresszeile about:config eingeben und die Sicherheitsabfrage bestätigen, dann keyword.URL suchen, darauf doppelklicken und als Wert https://eu2.ixquick.com/do/metasearch.pl?query= eingeben. Alles was vorher drin stand natürlich noch löschen. Anschließend kann man die about:config wieder schließen. Auch hier sucht man nun über eine mit SSL verschlüsselte Verbindung.

Auf den Dokumentations-Seiten von Ixquick findet man sonst auch noch einige hilfreiche Sachen, wie die Suchsyntax und einiges mehr. Die Funktion die Ixquick mit dem Proxy anbietet ist besonders interessant, da direkt neben jedem Suchergebnis ein dezenter Hinweis auf den Proxy ist, wenn man diesen anklickt wird die entsprechende Webseite direkt über den Ixquick Proxy aufgerufen, der sehr schnell ist.

Ixquick finanziert sich über Werbeeinblendungen bei den Suchergebnissen, diese sind aber deutlich abgegrenzt und nur oben bzw. unten sichtbar. Diese laufen auch nicht über einen Anbieter wie GoogleAdsense, dies wäre ja wiederum fatal. ![]() Die Werbung lässt sich zwar auch einfach mit AdBlock Plus oder ähnlichen Werbeblocker ausblenden, aber bei einem guten Service, wie Ixquick, kann man diesen ja auch mal unterstützen und seinen Werbeblocker für diese Seiten ausschalten. Außerdem bietet Ixquick auch noch eine Browsersymbolleiste an, aber zumindest für mich sind diese mittlerweile gestorben, ich kann damit irgendwie nichts anfangen.

Die Werbung lässt sich zwar auch einfach mit AdBlock Plus oder ähnlichen Werbeblocker ausblenden, aber bei einem guten Service, wie Ixquick, kann man diesen ja auch mal unterstützen und seinen Werbeblocker für diese Seiten ausschalten. Außerdem bietet Ixquick auch noch eine Browsersymbolleiste an, aber zumindest für mich sind diese mittlerweile gestorben, ich kann damit irgendwie nichts anfangen.

Die Google Suche ist bei Ixquick leider nicht integriert, aufgrund von technischen Beschränkungen seitens Google. Dies ist meiner Meinung nach das größte Manko an Ixquick und so greife ich bei speziellen Sachen doch ab und zu noch auf Google zurück.

Und nun noch die Frage an Euch: Wie nutzt ihr Suchmaschinen? Wie achtet ihr auf eure Sicherheit und Anonymität dabei? Ist es euch egal wenn Google über Jahre hinweg sammelt, was euch alles interessiert.

Blogclient für Unterwegs – Drivel ¶

Nach dem Test von Lekhonee, habe ich mich noch nach Alternativen umgesehen. Jörg hat ja in seinem Blog schon BloGTK näher betrachtet. Bei der weiteren Suche bin ich noch auf Drivel gestoßen.

Drivel ist ein in GTK geschriebener Client, der folgendes beherrscht:

Benutzung von Blogger, xmlrpc, Movabletype, Drupal, WordPress, ATOM-basierte Blogs

Erweiterte Formatierungen (fett, kursiv, durchgestrichen, hoch- und tiefgestellt, Liste etc.)

Einfügen von Bildern

Einfügen von Links

Einfügen von Umfragen

Rechtschreibprüfung

Drivel ist wesentlich ausgereifter als Lekhonee, außerdem unterstützt es eine größere Anzahl von Blogsoftware. Um WordPress einzubinden muss man Movabletype auswählen und folgende Adresse hinterlegen:

http://blog.wordpress/xmlrpc.php

In Zukunft werde ich unterwegs Drivel verwenden ![]() (Dieser Eintrag ist mit Drivel entstanden)

(Dieser Eintrag ist mit Drivel entstanden)

BloGTK - Blog Editor ¶

BloGTK ist ein Editor für verschiedene Weblogs. Man kann mehrere Blogs verwalten, und so z.B. offline Artikel schreiben/editieren oder sich alte Artikel durchlesen (es gibt auch noch andere ähnliche Tools, z.B. lekhonee). Derzeit kann er in Version 2.0 noch nicht allzuviel, z.B. kann man noch keine Multimedia-Dateien (Bilder, Musik, Videos) verwalten, aber alles “schrift”-mäßige wird unterstützt. Des Weiteren ist die Version 2.0 noch nicht im Ubuntu-Upstream angekommen. Installieren kann man die Version aber dennoch.

BloGTK – Blog Editor ¶

BloGTK ist ein Editor für verschiedene Weblogs. Man kann mehrere Blogs verwalten, und so z.B. offline Artikel schreiben/editieren oder sich alte Artikel durchlesen (es gibt auch noch andere ähnliche Tools, z.B. lekhonee).

Derzeit kann er in Version 2.0 noch nicht allzuviel, z.B. kann man noch keine Multimedia-Dateien (Bilder, Musik, Videos) verwalten, aber alles “schrift”-mäßige wird unterstützt. Des Weiteren ist die Version 2.0 noch nicht im Ubuntu-Upstream angekommen.

Installieren kann man die Version aber dennoch. Zuerst besorgt man sich den tar-Ball bei Launchpad und entpackt ihn. Anschließend installiert man die fehlenden Abhängigkeiten per

sudo apt-get install python-gnome2 python-gnome2-extras python-gdata python-webkit python-feedparser

Jetzt wechselt man mit Terminal in das frisch entpackte Verzeichnis blogtk-2.0 und tippt dort

sudo make install

ein. Fertig, ihr findet BloGTK nun im Menü “Internet”.

Ach ja, natürlich ist dieser Beitrag hier mit BloGTK geschrieben.

Dabei ist mir dann auch direkt aufgefallen, dass alle spitzen Klammern (also > und <) einfach gelöscht werden, und der Beitrag dann entsprechend unbrauchbar wird… Evtl. sollte ich doch lieber lekhonee ausprobieren…

Light-Theme Paketquelle für Karmic ¶

Ein Leser von OMG!Ubuntu! hat eine Paketquelle für Karmic Koala erstellt, indem sich die Light-Themes befinden.

Um die Paketquelle zu aktivieren und die Themes zu installieren, müssen folgende Befehle in ein Terminal eingegeben werden:

Install Ubuntu 10.04 Light themes für Ubuntu 9.10

- sudo add-apt-repository ppa:paglia/paglia-ppa

- sudo apt-get update

- sudo apt-get install light-themes ubuntu-mono

Die beiden Themes Ambiance und Radiance können nun über das Erscheinungsbild aktiviert werden.

Quelle: Omg!Ubuntu!