Über eine interessante Gameengine berichtete vor einigen Tagen Golem. Die Engine hört dabei auf den Namen 0 A.D. und bei ihr handelt es sich um eine RTS (Real Time Strategy) Engine. Ursprünglich war das ganze eine Modifikation basierend auf Age of Empires 2. Mittlerweile wurde das ganze auf einen eigenständige Basis gestellt und ist für Linux, Windows und Mac OS Verfügbar. Der Code steht dabei unter GPL Lizenz das Artwork unter CC-BY-SA. Die offizielle Seite ist unter http://wildfiregames.com/0ad/ zu finden.

29. März 2010

Google Chromium ¶

Hallo,

heute möchte ich mir die Zeit nehmen, um Euch den Internet-Browser Chromium vorzustellen. Zuerst sollte man zwischen Chromium und Chrome unterscheiden. Beide Projekte wurden initiiert durch Google. Chromium ist OpenSource und Chrome ist proprietär.

Dieser Browser ist derzeit noch als BETA gekennzeichnet, was heißt, er befindet sich noch in entwicklung, und NICHT für den produktiven Einsatz gedacht. Ich selbst konnte noch keine Probleme feststellen. Chromium ließ sich ohne Probleme starten und läuft bis jetzt ohne Abstürze.

Google bezeichnet zwar seinen Browser Chrome als OpenSource, dies ist aber nicht der Fall. Grundsätzlich basiert der Browser Chrome auf Chromium, es enthält jedoch zusätzlich Bibliotheken, die Proprietär sind. Zum Beispiel existiert in Chrome die Funktion, um Fehler an Google zu berichten. Diese ist proprietär und somit nicht in Chromium enthalten.

Es sind nur “Kleinigkeiten”, die Chrome von Chromium unterscheiden. Ansonsten sind diese beiden Browser identisch. Also – warum Chrome installieren, wenn “ich” Chromium haben kann und somit auf der sicheren Seite bin…

Warum dieser Artikel?

Vor kurzem habe ich Probleme mit Firefox gehabt. Dieser ließ sich nicht mehr starten – und das über eine sehr langen Zeitraum. Als Alternative benutze ich Opera, womit ich nicht wirklich zufrieden bin, da mir einfach die Plugins fehlen. Chrome war mir immer etwas suspekt. Dann habe ich etwas von Chromium gehört. Ich war sofort überzeugt, dass dieser Browser eine gute Alternative zu Firefox ist.

Chromium bietet wirklich sehr gute Features. Auch das Layout des gesamten Programms ist wirklich gut durchdacht und lässt sich super handhaben. Es sind auch viele Plugins Vorhanden – wenn auch nicht so viele, wie bei Firefox.

Chromium sollte nur mit einer schnellen Internetverbindung verwendet werden, da zum ersten die Rendering-Engine nur bei einer schnellen Verbindung ihre volle Leistungsfähigkeit ausleben kann und zum zweiten, wenn etwas in der Adressleiste eingeben wird, wird jedes mal eine Suchanfrage an Google gesendet, was bei schwachen Internetleitungen unkonstrukiv sein kann.

Installation

Die Installation ist wie immer relativ einfach. Dazu muss ein Terminal gestartet werden. Als erstes fügt man Chromium der Softwareliste hinzu mit:

sudo add-apt-repository ppa:chromium-daily/beta sudo apt-get update

Dann wird es installiert mit:

sudo apt-get install chromium-browser chromium-browser-l10n chromium-codecs-ffmpeg-nonfree

Das Paket chromium-browser-l10n ist für das deutsche Sprachpaket. Ansonsten ist Chromium englisch.

Wenn die Installation abgeschlossen ist, kann der Browser über das Gnome-Menü im Untermenü “Internet” oder direkt über chromium-browser gestartet werden.

Weiter werde ich nicht gehen, da soweit alles gut konfiguriert ist – also nichts störendes. Schaut ihn Euch einfach an und bastelt selbst.

Meine Vorschläge für Adons sind:

| AdBlock | Keine Werbung mehr. |

| AdBlock+ Element Hiding Helper | |

| Auto HD for YouTube | YouTube-Video automatisch in bester Qualität abspielen. |

| WOT | Ein Muss. Seitenbewertung. |

| AniWeather | Das Wetter. |

Als Schlusswort muss ich noch sagen, dass mein Vertrauen, zu diesem Google-Produkt in der Version des Chromium-Browsers gestiegen ist, ich aber bei jedem Schritt im Hinterkopf habe, nicht zu viele Daten einzugeben. Dies ist nicht wirklich gerechtfertigt, da es ein OpenSource Projekt ist. Es hat nur einen Faden Beigeschmackt von Google…

Umfrage zum Ubuntu-Design: Das Ergebnis ¶

Vor 14 Tagen fragte ich Euch, wie Ihr es mit dem Design von Ubuntu haltet. An der Umfrage nahmen fast 500 User teil. Euch allen gilt mein herzlicher Dank! :daumenanim:

Folgende Antworten standen zur Wahl, in Klammern das Ergebnis in Prozent:

- Ich passe das Design immer an meine eigenen Wünsche an. [52%]

- Ich ändere gelegentlich nur Kleinigkeiten. [30%]

- Ich arbeite mit dem originalen Ubuntu-Design. [18%]

Ein wenig war ich dann doch überrascht, dass mehr als die Hälfte richtig am Design „schrauben“. Ich hätte getippt, dass die ersten beiden Punkte umgekehrt wären. Deshalb mein Fazit: Selbst am Design feilen macht den Usern Spaß. Kein Wunder, gibt es doch jede Menge Themes, die Community ist sehr kreativ und die Installation ist einfach!

Dass aber gut jeder Fünfte das Standard-Theme nutzt – so wie es ist, finde ich auch gut. Dann hat man bei Canonical also doch nicht alles falsch gemacht. Ich werde diese Umfrage noch einmal im Sommer starten, wenn die erste Gewöhnung an das neue Design von Lucid Lynx vorbei ist. Auf das Ergebnis bin ich jetzt schon gespannt. ![]()

Bash-Completion auch mit sudo-Befehlen ¶

Die automatische Vervollständigung von Befehlen und Datei-/Ordnernamen (aka bash-completion) über die Tabulator-Taste ist eine tolle Sache. Zum einen “tippt” es sich so schneller und zum anderen reduziert man deutlich die Gefahr von Vertippern. Allerdings funktioniert die Bash-Completion nicht mehr sobald man Root-Rechte für einen Befehl braucht. Stellt man einem Befehl ein sudo voran, dann bewirkt die Tab-Taste rein gar nichts mehr.

Ihr könnt Bash-Completion auf jedoch auch unter Ubuntu für sudo aktivieren (wie es mit anderen Distributionen aussieht habe ich jetzt nicht getestet, wichtig ist dass die Bash als Shell verwendet wird), öffnet dazu die ~/.bashrc in einen Editor…

$ gedit ~/.bashrc

…und fügt am Ende die Zeilen…

if [ "$PS1" ]; then

complete -cf sudo

fi

…ein. Speichert die Änderung ab, schließt das Terminal-Fenster und startet es danach neu. Nun sollte die Bash-Completion auch mit “sudo-Befehlen” klappen… Was ich mich jedoch frage, hat das negative Auswirkungen? Oder warum ist das bei Ubuntu noch von Haus aus aktiviert?

(via wiki.archlinux.org)

28. März 2010

Rhythmbox Desktop Art ¶

Ein Plugin für Rhtyhmbox welches auf dem Desktop den spielenden Titel anzeigt.

Das Rhythmbox Desktop Art Plugin ermöglicht es auf dem Gnome Desktop den momentan spielenden Titel inklusive Albumcover anzuzeigen. Desweiteren bietet das Plugin auch die Möglichkeit den spielenden Titel zu Pausieren oder zu Überspringen bzw. den vorherigen Titel zu Wählen.

Die Position und das Erscheinen des Plugins kann in Rhythmbox frei generiert werden.

Wem die Funktionen nicht ausreichen, der kann auch über den Gconf-Editor weitere Anpassungen vornehmen.

|

Installation

Installiert wird das Plugin unter Ubuntu wie folgt:

sudo apt-get install subversion

mkdir -p $HOME/.gnome2/rhythmbox/plugins/

cd $HOME/.gnome2/rhythmbox/plugins/

svn co http://nedrebo.org/svn/rhythmbox/desktop-art

Nach erfolgreicher Installation muss das Plugin in Rhythmbox noch aktiviert und gegebenfalls angepasst werden. Das Plugin startet immer automatisch und beendet mit dem Player, sofern es aktiviert ist

Quelle: Mathias Nedrebø’s Website

Einige Ideen für Choqok ¶

Choqok ist meiner Meinung nach einer der besten Twitterclients. Allerdings ist auch Choqok nicht perfekt und ich störe mich an einigen Details der GUI. Im nachfolgenden Bild habe ich mal versucht die Probleme zu verdeutlichen:

Es sind keine großen Sachen, sondern nur kleine Details. Es fehlt ein wenig der letzte Schliff. Ich habe mich also mal an Photoshop gesetzt und versucht diese Probleme zu beseitigen:

Ich denke die beiden Bilder sind relativ selbsterklärend. Das sie auf englisch sind liegt daran, dass ich diese Bilder auf kde-apps.org gepostet habe damit sie auch die Entwickler erreichen.

Wie findet ihr den Entwurf?

27. März 2010

Backup | Adium Einstellungen und Plugins sichern ¶

Ein gegebener Anlass brachte mich dazu mein Adium neu installieren zu müssen. Um es mir auch längerfristig merken zu können, paste ich wie immer alles in meinen Blog.

~/Library/Application Support/Adium 2.0/

~/Library/Preferences/com.adiumX.adiumX.plist

weg kopieren und nach der neuen Installation wieder einspielen. Und die Pfade für solche Späße bei Mac OS X gefallen mir immernoch nicht. Was soll man machen.

In eigener Sache: 321tux bei Twitter, Identi.ca und Facebook ¶

Lange Zeit stand ich Social-Networks wie Facebook und vor allem Microblogging-Diensten, wie Twitter und dessen freien Pendant Identi.ca, skeptisch gegenüber, da sich mir u.a. deren Nutzen nicht völlig erschloss.

Letzte Woche habe ich mich dann doch dazu entschlossen, mich bei Facebook anzumelden, da dort ebenfalls meine halbe Schule registriert ist. Natürlich habe ich die Privatsphäre-Einstellungen genutzt und nur unbedenkliche Inhalte veröffentlicht (abgesehen von Name und Foto). Da man bei Facebook neben seinem privaten Account auch sogenannte “Fanseiten” erstellen kann, habe ich mir gedacht, dass ich das auch mal ausprobieren sollte. Gesagt, getan – nun ist 321tux.de auch auf Facebook vertreten.

Und da ich schon so schön in Fahrt war, habe ich mich gestern außerdem bei Twitter und Identi.ca registriert. Dort blicke ich zwar noch nicht ganz durch, aber ich hoffe, dass sich das bald ändern wird.

Ich habe auf 321tux.de noch nicht besonders viel gebloggt, weshalb ich auch nicht mit allzu vielen Followern rechne. Aber vielleicht möchte es ja doch der eine oder andere nutzen (ich würde mich auf jeden Fall freuen).

Hier nun die Links zu den entsprechenden Seiten:

(http://twitter.com/321tux)

(http://identi.ca/321tux)

(http://www.facebook.com/pages/321tux/103318329703299)

An die Leser des ubuntuusers-Planeten: Ich war hin und hergerissen, ob ich diesen Beitrag im Planeten veröffentlichen soll, da es inhaltlich nicht um Ubuntu geht. Letzten Endes habe ich mich für die Veröffentlichung entschieden, da ich auch einen gewisse Masse erreichen möchte. Entschuldigt dies bitte, falls ihr anderer Meinung seid. Wen es sehr stört, kann mir das über das Kontaktformular kurz mitteilen. Ggf. werde ich den Post dann wieder aus dem Planeten entfernen (falls das möglich ist).

Jolicloud nun mit Desktop-Modus ¶

Das Cloud-Betriebssystem Jolciloud, basierend auf einem stark angepassten Ubuntu Kernel bietet nun einen Desktop-Modus

Das Cloud-Betriebssystem Jolciloud, basierend auf einem stark angepassten Ubuntu Kernel bietet nun einen Desktop-Modus

In Jolicloud gibt es nun die Möglichkeit zwischen dem Netbook-Modus und einem richtigen Desktop mit Fenster zu wechseln, welcher vorallem das Arbeiten an einem externem Display erleichtern soll, da der Standard-Desktop eher für geringe Auflösung gedacht ist. Momentan ist der Desktop-Modus noch recht schlicht gehalten.

Jolicloud Netbook-Modus

Jolicloud Desktop-Modus

Das untere Bild zeigt Jolicloud auf einem externen Monitor, und das Menü zum Wechseln zwischen dem jeweiligen Desktop.

Quelle: Jolicloud Blog

26. März 2010

“skipfish” in Ubuntu installieren ¶

Kürzlich hat Google den Security-Scanner für Webanwendungen “skipfish” als Open Source freigegeben. Das Tool (beta, Lizenz: Apache 2.0) kann mit heuristischen Methoden Schwachstellen auf Webservern aufspüren.

Es folgt eine Kurzanleitung, wie man “skipfish” unter Ubuntu (getestet für Jaunty) zum Laufen bringt. Sollte so aber auch für Koala funktionieren.

Vorbemerkung: Nach dem Download des Archivs mit wget und dem Entpacken wird ein Ordner mit dem Namen “skipfish” erstellt. In diesem Ordner liegen dann etliche Dateien, u.a. das ausführbare “skipfish”. Vor dem Download wechselt man also am Besten in das Verzeichnis, in dem der Ordner “skipfish” später zu Hause sein soll.

1. In gewünschten Zielordner wechseln, z.B.:

cd /usr/local/bin

2. Dann das Archiv herunterladen:

wget -c http://skipfish.googlecode.com/files/skipfish-1.13b.tgz

3. Nun brauchen wir noch ein paar Bibliotheken:

sudo apt-get install libssl-dev libidn11-dev

4. Das Archiv entpacken:

tar xvzf skipfish-1.13b.tgz

5. In den Installationsordner wechseln

cd skipfish

6. Mit “make” installieren:

sudo make

7. Wörterbuch definieren (zur Entscheidungshilfe bitte die README-Datei lesen):

sudo cp dictionaries/default.wl skipfish.wl

8. Fertig! Nun kann die EIGENE Webseite nach Schwachstellen gescannt werden.

DISCLAIMER: Vor dem Scannen einer Webseite obliegt es dem Anwender zu prüfen, ob dies in Übereinstimmung mit deutschen Gesetzen geschieht oder einen Gesetzesverstoss darstellt.

skipfish wird aus dem Installationsordner heraus aufgerufen.

sudo ./skipfish -o output http://meine-eigene-webseite.org

Im obigen Beispiel wird ein weiterer Ordner “output” erstellt (wobei -o [zielordner] frei gewählt werden kann), worin sich eine Datei index.html befindet. Dies ist der Report des Scans, den man mit dem Browser aufrufen kann.

[UPDATE 10.4.2010:] Das Ergebnis könnte dann z.B. so aussehen (Dies ist ein Beispiel für einen Scan, der nach ein paar Minuten abgebrochen wurde. Das Ergebnis eines vollständigen Scans einer umfangreichen Seite würde dementsprechend viel umfangreicher ausfallen):

Kürzlich erschienen:

Shell-Guru: Ein Heft sieht wie das andere aus

Ähnliche Artikel

Erste stabile Version des Gnome Media Players erschienen ¶

![]() Die erste Stabile Version des Gnome-Media-Players, basierend auf dem bekannten “VLC Media Player” ist heute erschienen

Die erste Stabile Version des Gnome-Media-Players, basierend auf dem bekannten “VLC Media Player” ist heute erschienen

Der Gnome Media Player ist nun in der Version 0.1.1 erschienen. Die Unterstützung der schnellen Umschaltung zwischen den drei Engines VLC, Xine und GStreamer wurde verbessert. Sowie eine Automatische-Erkennung der Engine, ist nun auch integriert. Die Deutschesprachunterstützung liegt momentan bei ca. 90%.

Installation:

Wer den Player installieren möchte, muss unter Karmic und Lucid folgende Befehle in einem Terminal ausführen.

Hinweis: Es handelt sich bei dieser Paketquelle um eine Entwickler PPA

sudo add-apt-repository ppa:gnome-media-player-development/development

sudo apt-get update

sudo apt-get install gnome-media-player

Gnome-Media-Player wird über “Anwendungen->Unterhaltungsmedien->Gnome Media Player” gestartet

EDIT: Es ist eine weitere Version des Players erschienen, welche nun auch einen Lautstärkeregler beinhaltet.

Ubuntu Ambiance und Radiance Personas für Firefox ¶

Zwe i Personas für Firefox 3.6, welche dem Browser das Aussehen von Ambiance oder Radiance ermöglichen

i Personas für Firefox 3.6, welche dem Browser das Aussehen von Ambiance oder Radiance ermöglichen

Ich habe heute nach einem schönen Persona für Firefox 3.6 unter Lucid Lynx gesucht und zwei Themes gefunden, die den Browser entweder in das Ambiance oder das Radiance Theme verwandeln.

Download der Personas:

Wie man die Ausnahmen wieder findet ¶

Beinahe hätte ich ein Ticket umsonst aufgemacht, peinlich.

Seit dem Update auf Ubuntu 10.04 vermisse ich im Einstellungsmenü in Firefox den Knopf, um Seiten einzutragen, die von der Cookie-Löschung beim Beenden des Browsers ausgenommen sind.

Aufruf zum Featurerequest für lekhonee ¶

Heute war ich ganz überrascht, als ich die Kommentare in meinem Blog durchgegangen bin. Unter den auf Moderation wartenden Kommentaren fand ich einen Kommentar des lekhonee-Entwicklers Kushal Das. Er möchte ein bisschen Feedback und Vorschläge für die kommende Version von Lekhonee 0.9 haben. ![]()

Hi,

Thanks a log for testing lekhonee-gnome, 0.8 version is also out for a long time. I am working on the release of 0.9 which is a complete rewrite in Vala.I want to know a little bit more about blockquote formatting (an example will do).

My primary target for lekhonee was to have a desktop client for wordpress, I had livejournal support long time back, but in future will only have WordPress support.Thanks once again, please inform me about the features you are looking for in it.

Kushal

Ich hab mir schon folgende Features gewünscht ![]()

- syncing Tags from WordPress if you are online (like already the Categories)

- an offline-mode for people working with net- and notebooks (this would be the definitely killer feature for me and the others working offline )

- if syncing works, improved offline-mode so that you can choose the synced Tags and Categories for the new article

- adding Blockquote

Tags for Blogquote

- adding Codebox Codebox Tag

Also fleißig Featurerequests in englisch in den Kommentaren zu diesem Artikel schreiben ![]() Ich sende ihm diese dann gesammelt in einer Email, bzw er liest sie hier.

Ich sende ihm diese dann gesammelt in einer Email, bzw er liest sie hier.

ARTE über das OLPC-Projekt ¶

arte+7 hat gerade eine 45 minütige Dokumentation über das OLPC-Projekt im Programm, auf die ich euch gerne aufmerksam machen würde. (Danke an Stefan für den Tipp)… arte+7 hält die Beiträge nur für sieben Tage vor, behaltet daher im Kopf dass die Dokumentation nur noch bis zum 30.03. zu sehen ist.

Bildung ist das wichtigste Mittel, um die Chancen auf eine erfolgreiche Zukunft zu erhöhen. Die Dokumentation von Chiara Sambuchi begibt sich auf die Spuren eines revolutionären Bildungsprojektes. Die Idee bestand darin, den Ärmsten in den Entwicklungs- und Schwellenländern den denkbar besten Zugang zu Wissen zu ermöglichen und den Sprung ins 21. Jahrhundert zu erleichtern. Der amerikanische Informatiker Nicholas Negroponte fand einen Weg, diese Vision Realität werden zu lassen.

Ihr könnt den Beitrag entweder über die plus7.arte.tv-Homepage ansehen, oder natürlich auch via Totem und dem arte+7-Plugin. Eine Suche nach “laptop” bringt euch dann zum Film.

25. März 2010

Einen eigenen Splash-Screen in Gimp verwenden ¶

![]() Wer Gimp etwas persönlicher gestalten möchte, kann z.B den Splash-Screen durch einen eigenen austauschen. Wie das geht, zeige ich in diesem Tuturial.

Wer Gimp etwas persönlicher gestalten möchte, kann z.B den Splash-Screen durch einen eigenen austauschen. Wie das geht, zeige ich in diesem Tuturial.

A

ls erstes begibt man sich mit Rootrechten in das Verzeichnis “/usr/share/gimp/2.0/images” in dem der Splashscreen von Gimp liegt.

ls erstes begibt man sich mit Rootrechten in das Verzeichnis “/usr/share/gimp/2.0/images” in dem der Splashscreen von Gimp liegt.

Dort gibt es die Dateien:

“gimp-splash.png, wilber.png und gimp-logo.png“.

Benötigt wird die “gimp-splash.png”.

Nun kann entweder das bestehenden Splashscreenbild verändert werden, oder Ihr ertsellt ein neues Bild. Die Größe des Bildes kann beliebig sein.

Ist das Bild fertig, so muss es unter dem Namen gimp-splash.png abgespeichert werden. Dann wird der neue Splash-Screen in das Verzeichnis (“/usr/share/gimp/2.0/images”), welches zuvor geöffnet wurde hineinkopiert.

Jetzt erscheint bei jedem Start von Gimp der eigene Splash-Screen.

Es gibt auch noch eine Möglichkeit, dass bei jedem Start ein anderer Start-Screen verwendet wird. Dazu begebtI hr Euch in Euer Homeverzeichnis.

Da “.gimp” ein versteckte Ordner ist, muss dieser erst sichtbar gemacht werden. Am schnellsten geht das über die Tastenkombination STRG+H, Ihr könnt aber auch den Umweg über: “Bearbeiten-> Verborgene Dateien anzeigen” gehen.

Ist dies erledigt so wird nun unter “~/.gimp-2.6/” ein neuer Ordner mit dem Namen “splashes” (falls nicht schon vorhanden) angelegt. Dort können nun alle Bilder die Ihr als Start-Screen verwenden wollt hinein kopiert werden.

Die Namen der Bilder sind dabei egal, beachtet aber dabei, dass kein Bild “gimp-splash.png” heißen darf, da sonst nur diese verwendet wird.

EDIT: Wer keinen eigenen Splash-Screen erstellen möchte, wird hier bestimmt fündig.

Linux auf dem Asus A52JR — Teilerfolg mit Mobility Radeon 5470 ¶

Nachdem gestern der Ati Catalyst Treiber 10.3 erschienen ist (und seit heute auch downloadbar ist), dachte ich mir, ich könnte die Treiberinstallation auf dem A52JR noch einmal probieren. Nach der Installation des Treibers mit

./ati-driver-installer-10-3-x86.x86_64.run

probierte ich erneut

aticonfig --initial

Das Ergebnis war ernüchternd: Wieder wurde mir gesagt, dass keine unterstützten Karten im Rechner vorhanden waren, eine Konfiguration daher nicht möglich sei. Zur Erinnerung: lspci erkennt die Karte wie folgt:

01:00.0 VGA compatible controller [0300]: ATI Technologies Inc Device [1002:68e0]

Doch heute packte mich ein wenig der Spieltrieb und ich probierte zunächst anhand einer minimalen xorg.conf, ob denn die Karte erkannt wird, wenn ich dem Treiber explizit mitteile, dass er für sie zuständig ist — das besorgt die Zeile ChipID. Über SSH loggte ich mich also am Notebook ein und baute die Konfigurationsdatei auf. Bereits mit einer Section “Screen” und einer Section “Device” erhielt ich ein Bild in der nativen Auflösung des Widescreen-Displays. Die minimale xorg.conf:

Section "Screen"

Identifier "Screen_AUTO_1366x768"

Defaultdepth 24

SubSection "Display"

Modes "1366x768" "1024x768" "1024x600" "800x600"

EndSubSection

EndSection

Section "Device"

Identifier "Card0"

Driver "fglrx"

ChipId 0x68e0

VendorName "ATI"

BusId "PCI:1:0:0"

EndSection

Die vollständige xorg.conf kann hier heruntergeladen werden. Die größte Änderung dürfte sein, dass ich Option "SWCursor" "true" aktiert habe, um nach einem Logout das Fehlen des Zeigers zu vermeiden. Wer diese xorg.conf als Basis für eigene Experimente verwendet, sollte wie ich sich per SSH einloggen, den gdm stoppen und dann remote versuchen, ob sich der Xserver starten lässt: Logdatei und Meldungen in der Konsole, in dem der Start durchgeführt werden, sind aussagekräftig – Oft muss ChipId oder BusId angepasst werden.

Fehlendes Kernelmodul

Leider lässt sich auf meinem 2.6.33.1 das fglrx-Kernelmodul nicht kompilieren. Nach dem Wechsel nach /lib/modules/fglrx/build_mod und Aufruf von ./make.sh mäkelt das Script zunächst über zwei fehlender Header. Nach dem softlinken dieser Header geht es aufgrund geänderter Funktionen auch nicht weiter. Ich werde dieses Problem irgendwann angehen, gebe mich zunächst mit weniger (gar keiner?) Beschleunigung zufrieden.

Nerviges Overlay “Unsupported Hardware”

Im rechten unteren Eck befindet sich ein Overlay “Unsupported Hardware”. Dieses lässt sich nur abschalten, indem man mit dem Hex-Editor an das Treiber-Binary herangeht. Der User “Crypto2600″ aus den Ubuntu-Foren hat hierfür ein kleines Script geschrieben, das den Vorgang automatisiert:

#!/bin/sh

DRIVER=/usr/lib/xorg/modules/drivers/fglrx_drv.so

for x in $(objdump -d $DRIVER|awk '/call/&&/EnableLogo/{print "\\x"$2"\\x"$3"\\x"$4"\\x"$5"\\x"$6

}'); do

echo found $x

sed -i "s/$x/\x90\x90\x90\x90\x90/g" $DRIVER

done

Das Ende vom Lied?

Fürs erste läuft die Grafik zufriedenstellend. Das fehlende Kernelmodul rüste ich bei Gelegenheit nach — ich mutmaße einmal, dass die Buildscripte für Lucid bald gepatcht sind, so dass diese Änderung nicht mehr viel Arbeit bedarf. Und vielleicht supported Ati die 5470 ja irgendwann einmall ganz offiziell…

Nachtrag, 6. April 2010: “fglrx” hatte die Lösung. Umgesetzt habe ich sie, indem ich nach dem Download des Patches von http://aur.archlinux.org/packages/catalyst/catalyst/fglrx-2.6.33.patch und Anwenden desselben die Module unterhalb von /lib/modules gebaut habe. Quick and dirty gelang diese mit:

cd /lib/modules/fglrx patch -p5 < /tmp/fglrx-2.6.33.patch cd build_mod ./make.sh cd .. ./make_install.sh

Anschließend lies sich das Modul wie erwartet laden und Hardwarebeschleunigung ist nun aktiv aktiv.

Ubuntu Wochenrückblick in Schweizerdeutsch ¶

Als kleine Geste zu meinem Einstieg bei Ikhaya auf ubuntuusers.de möchte ich hier gerne etwas Leichtes beisteuern. Ich darf ja jede Woche den Ubuntu Wochenrückblick für RadioTux sprechen und so spreche ich den einmal ganz speziell für die Eidgenossen hier auf Schweizerdeutsch. Ich verstehe diese Aktion als einmalige Schandtat und werde sie wohl nicht so schnell wiederholen. Dazu nutze ich einen etwas anderen Jingle als der bei RadioTux. Aus dem Album The Dead Rocks und den Jungs von der One Million Dollar Surf Band setze ich das Stück EasyJob ein. Gerade weil es für mich sehr leicht ist, in meiner Muttersprache zu reden, handelt es sich dabei tatsächlich um ein “Easy Job”. Ganz im Gegensatz zu den Jungs, welche den Wochenrückblick zusammenstellen. Der Musiktipp stammt übrigens vom Bürgermeister.

Am Schluss des Rückblicks habe ich das ganze Stück angehängt, es lässt sich aber auch hier herunterladen.

Audio-Datei herunterladen (uuwr.mp3)

MP3 10.5 MB 11:01 Minuten Download

Ähnliche Artikel

24. März 2010

Inkscape: unser fetter tuxiger Pinguin ¶

Es an der Zeit wieder ein mal ein kleines Tutorial für Inkscape zu veröffentlichen. Was ein Linuxnutzer immer gebrauchen kann sind wohl Pinguine und die sind eigentlich ganz leicht mit einfachen grafischen Formen erstellbar. Wie in der Abbildung links so soll am Ende unser Pinguin aussehen, er hat wie bei Tux dem Linuxmaskottchen üblich natürlich orange Füße und einen Schnabel in der gleichen Farbe.

Das Ganze ist wie gesagt recht einfach und besteht überwiegend aus geometrischen Figuren. Wir werden zuerst alle Einzelteile zeichnen und im Anschluss dann zusammensetzen. Beginnen wir also mit dem Augenpaar. Dafür zeichnen wir mit dem Werkzeug “Kreise, ellipsen und Bögen erstellen (F5)” einfach eine Ellipse. Diese drehen wir dann sanft etwas nach links, danach zeichen wir eine weitere etwas kleinere Elipse und positionieren diese wie in der Abbildung. Anschließend zeichnen wir einen kleinen Kreis und auch diesen positionieren wir wie in der Abbildung. Jetzt gehen wir daran, den gezeichneten Formen die richtigen Farben zu geben. Der untersten Ellipse geben wir eine Füllung mit einem kreisförmigen Farbverlauf von weiß (ffffffff) nach einem sanften hellblau (d9ffffff). Die zweite Ellipse wird schwarz (000000ff) und die letzte weiß (ffffffff) und dieser geben wir eine Unschärfe (bei mir Faktor 30). Das Ergebnis sollte dann in etwa so aussehen, wie in der Abbildung. Wenn das der Fall ist markieren wir all diese Elemente und gruppieren diese, dazu entweder um alle Elemente mit der Maus einen Markierungsrahmen ziehen oder alle Elemente einzeln selektieren, dabei die Shifttaste gedrückt halten. Und im Anschluß über Objekt > Gruppieren (Strg+G) gruppieren. Nach dem wir die Elemente alle gruppiert haben, legen wir von dem Objekt eine Kopie an, Strg+D und spiegeln diese horizontal (Objekt horizontal umkehren (H) ). Dann verschieben wir das neue Objekt einfach mit den Cursortasten so, dass es wie auf der Abbildung aussieht und fertig ist unser Augenpaar.

Jetzt widmen wir uns dem Schnabel unseres Pinguin. Dafür zeichnen wir wieder eine Ellipse, dieses Mal etwas breiter aber keine Angst das kann man nachher noch passend skalieren. Dann zeichnen wir mit dem Werkzeug “Bezier-Kurven und gerade Linien zeichnen (Umschal+F6)” eine Bezierkurfe wie in der Abbildung, keine Angst wenn sie nicht gleichmäßig wird, dass erreichen wir später durch das versetzen der Knoten. Die Bezierkurve setzen wir im Anschluss auf unsere Schnabelellipse und wählen das Werkzeug “Bearbeiten der Knoten oder der Anfasser eines Pfades (F2)“, dann setzen wir die Endpunkte unserer Bezierkurve auf die gleiche Höhe und an den Umriss der Ellipse. Die Strichstärke läßt sich über die “Muster der Konturlinie” in den Objekteinstellungen beeinflussen. Nachdem wir diese, wie in der Abbildung zu sehen angepßt haben, bei mir (2,8px), wandeln wir über Pfad > Kontur in Pfad umwandeln (Strg+Alt+C) die Bezierkurve in einen Pfad um. Dann wählen wir wieder das Werkzeug “Bearbeiten der Knoten oder der Anfasser eines Pfades (F2)” und setzen einfach durch Doppelklick jeweils in der Mitte oben und unten einen Knoten und verschieben diese und/oder die Anfasser der Kurven so, dass es am Ende den Eindruck eines leicht geöffneten Schnabel, so wie in der Abbildung zu sehen hat. Dann können wir den Schnabel noch etwas einfärben, ich hab hier wieder einen kreisförmigen Farbverlauf von einem dunklem Orange (ff6600ff) nach einem hellerem (ff8f00ff) benutzt. Danach ist unser Schnabel eigentlich fertig und muss nur noch zum Augenpaar hinzugefügt werden und eventuell in der Größe etwas angepasst werden.

Das nächste mit dem wir uns beschäftigen, werden die Füße sein, die sind ganz einfach aus mehreren Ellipsen zusammen gesetzt, wie in der Abbildung zu sehen. Die beiden äußeren Ellipsen sind etwas gedreht und an die passenden Postionen geschoben und im Anschluss alle Ellipsen über Pfad > Vereinigung (Strg++) miteinander vereinigt. Für die Füllung habe ich den gleichen Farbverlauf wie beim Schnabel des Pinguin benutzt.

Jetzt haben wir alle schwierigen Elemente für unseren Pinguin gezeichnet und können daran gehen ihn zu vollenden. Zeichnen wir als ersten den Grundkörper des Pinguin, das ist wie sollte es anders sein ein große Ellipse. Nach dem zeichnen das vorher gruppierte Augen-Schnabelpaar auf dem Grundkörper platzieren und entsprechend anpassen. Allerdings sieht die Grundform unseres Pinguins noch etwas seltsam aus aber das lösen wir auf einfache Art und Weise. Die Grundform selektieren und über Objekt > Objekt in Pfad umwandeln (Umschalt+Strg+C) umwandeln. Im Anschluß das Werkzeug “Bearbeiten der Knoten oder der Anfasser eines Pfades (F2)” auswählen. Die Knoten der Ellipse werden sichtbar. Zuerst den obersten Knoten wählen und die Knotenanfasser etwas zusammenschieben, dadurch wird dieses Ende etwas spitzer. Dann die beiden seitlichen und den unteren Knoten etwas nach innen verschieben. Das Ganze sollte dann etwas eiförmig in etwa wie auf der Abbildung aussehen. Dann zeichnen wir eine weitere Ellipse, den Bauch den habe ich mit dem gleichen Farbverlauf, wie die Augen gefüllt. Ein kleiner Kreis mit einer Füllung von Schwarz nach Transparent dient als Bauchnabel. Die Arme sind dreimal dürft ihr raten, genau einfach langezogene Ellipsen, die etwas gedreht wurden. Dann heisst es nur noch die Füße anpassen und drei Haare (das sind nichts anderes wie Freihandinien (F6) ) und ein Schatten auf den Boden und fertig ist unser tuxiger Pinguin.

Radio Tray, minimaler Player für Internet-Radio ¶

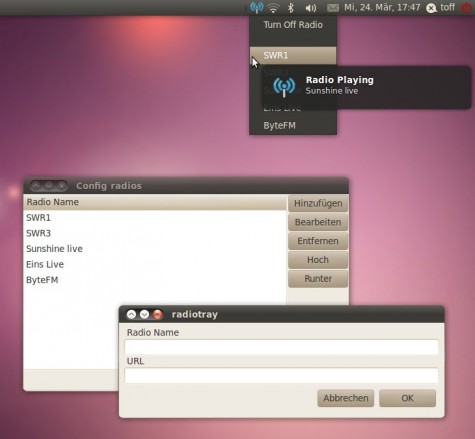

Ich höre ganz gerne mal Internetradio, allerdings finde ich Rhythmbox, Amarok und Co. dafür eigentlich viel zu mächtig. Wenn man wirklich NUR Radio über das Internet hören möchte, dann braucht es keinen Medienspieler mit Datenbank, Lyrics usw., der vor lauter Funktionen gar nicht mehr gehen kann. Interessierte sollten sich daher einmal Radio Tray ansehen. Das kleine Programm spielt nur Internetradio-Streams ab und spart so gegenüber Rhythmbox deutlich Ressourcen.

Einmal gestartet, nistet sich das Programm im Tray (aka Benachrichtigungsfeld) ein. Es werden leider keine Radio-Stationen mitgeliefert, Ihr müsst daher erstmal selber eure Liebling-Stationen eintragen. Über einen Rechtsklick auf das Icon und “Config radios…” öffnet ihr den Stationsmanager. Dort könnt ihr dann über “Hinzufügen” einzelne Stationen eintragen. Eine Liste mit den URLs zahlreicher Internetradios findet Ihr bspw. im Wiki von ubuntuusers. Alternativ könnt ihr euch unter Surfmusik.de interessante Stationen raussuchen und die URL zum Stream aus dem Quellcode fischen…

Radio Tray könnt ihr unter Debian, Ubuntu oder Linux Mint recht einfach installieren. Die Macher bieten .deb Pakete an, die sich auf Debian-basierten Systemen mit einem Doppelklick installieren lassen. Ihr findet sie auf der Projektseite bei Sourceforge. Nach der Installation könnt Ihr das Programm via “Anwendungen -> Unterhaltungsmedian -> Radio Tray” starten.

Das Programm ist noch recht jung und muss zum Teil auch noch übersetzt werden. Auf Transifex gibt es schon ein Projekt für die Übersetzung von Radio Tray. Wer dem Projekt folgend möchte, der findet im Blog zu Radio Tray fortlaufend Informationen.

Ordnervorschaubilder in Nautilus mit „Cover Thumbnailer“ ¶

Im Gegensatz zu KDE oder Windows bietet GNOME bei dessen Dateimanager Nautilus keine integrierte Vorschaufunktion (Thumbnails) für den Inhalt eines Ordners an. Im Internet findet man zwar zahlreiche Skripte, um anstelle der normalen Icons eine im Ordner enthaltene Grafik zu verwenden, doch sind diese aus folgenden Gründen nicht die ideale Lösung des Problems: Man kann kaum noch zwischen Ordner und Datei unterscheiden kann, da sich diese in der Miniaturansicht sehr ähnlich sehen. Außerdem muss man die Skripte nach dem Erstellen neuer Ordner stets neu ausführen und zu guter Letzt sind die Änderungen oft nur schwierig rückgängig zu machen.

Bei dem Programm Cover Thumbnailer (GPL) treten diese Probleme nicht auf und die Ordner sehen mehr als hübsch aus. Gerade bei umfangreichen Musik- und Bildersammlungen steigern die passenden Cover oder Vorschaubilder (meiner Meinung nach) die Navigation im Dateimanager enorm.

Installation

Ab Ubuntu 9.04

- PPA hinzufügen und Schlüssel importieren:

- Ubuntu 9.04 Jaunty Jackalope

sudo sh -c "echo 'deb http://ppa.launchpad.net/flozz/flozz/ubuntu jaunty main' >> /etc/apt/sources.list" sudo apt-key adv --keyserver keyserver.ubuntu.com --recv-keys 75034BEC

- Ab Ubuntu 9.10 Karmic Koala

sudo add-apt-repository ppa:flozz/flozz

- Ubuntu 9.04 Jaunty Jackalope

- Paketliste neu einlesen und Cover Thumbnailer installieren:

sudo apt-get update sudo apt-get install cover-thumbnailer

- Nautilus neu starten:

nautilus -q && nautilus

Ältere Ubuntu-Versionen und Debian

Für ältere Ubuntu-Versionen als 9.04 oder Debian kann ein Debian-Paket von der Homepage heruntergeladen und wie gewohnt installiert werden.

Konfiguration

In den Einstellungen, welche bei Ubuntu unter “System -> Einstellungen -> Cover Thumbnailer” zu finden sind, lässt sich festlegen, in welchen Verzeichnissen Cover Thumbailer Vorschaubilder erzeugen soll und welche ignoriert werden sollen. Standardmäßig sind bereits die passenden Ordner für Musik und Bilder ausgewählt.

Deinstallation

Damit die Thumbnails nach der Deinstallation von Cover Thumnailer nicht mehr angezeigt werden, sollte man zuvor in den Einstellungen den Reiter “Verschiedenes” wählen und dort auf “Thumbnail-Cache löschen” klicken. Alternativ kann man auch das Verzeichnis “~/.thumbnails” löschen:

rm -r ~/.thumbnails

Schöner Debuggen mit DebugMessages – Stacktraces mit Quelltextanzeige ¶

Das Standardverhalten von Perl beim Auftreten eines Fehlers ist mit der Funktion die zu beenden. Dabei wird neben einer Fehlerursache die Zeilennummer ausgegeben, welche den Fehler verursacht hat

Tritt ein Fehler in einer sehr häufig genutzten Funktion auf (z.B. Umrechnen eines Wertes), so ist es sehr schwer festzustellen, von wo und mit welchen Parametern diese Funktion aufgerufen wurde.

Beispiel:

#!/usr/bin/perl use strict; use warnings; sub divide { my ($x,$y) = @_; return $x/$y; } sub printDivision { my ($x,$y) = @_; print "$x durch $y = ".divide($x,$y)."\n"; } sub divideList { my $x = shift; my $listReference = shift; my @list = @{$listReference}; foreach my $i(@list){ printDivision($x,$i); } } my @divList1 = (22,7,16); my @divList2 = (2,5,33,50,0,7,65); divideList(100,\@divList1); # do something else ... divideList(100,\@divList2);

Zugegeben ist dies ein recht künstlich konstruiertes Beispiel, jedoch ist es nicht leicht ein möglichst einfaches und gleichzeitig realistisches Beispiel zu finden. Die Funktion divide dividiert zwei übergebene Zahlen ohne überprüfung, ob durch 0 dividiert wird. printDivision nutzt diese Funktion um das Ergebnis einer Division auszugeben. Die Funktion divideList bekommt eine Zahl und eine Referenz zu einer Liste übergeben, durch die die Zahl jeweils geteilt und das Ergebnis mit der Funktion printList ausgegeben werden soll. Schließlich wird die Funktion divideList erst mit einer Liste ohne 0 und dann mit einer Liste aufgerufen, in der eine 0 vorkommt.

Die Ausgabe des Programms ist:

100 durch 22 = 4.54545454545455 100 durch 7 = 14.2857142857143 100 durch 16 = 6.25 100 durch 2 = 50 100 durch 5 = 20 100 durch 33 = 3.03030303030303 100 durch 50 = 2 Illegal division by zero at ./test.pl line 8.

Wenn man die beiden Lisen jetzt nicht direkt so vor Augen hat (weil sie z.B. während des Ablaufs generiert werden), kann man schwer sagen, welcher Funktionsaufruf den Fehler verursacht hat. Man weiß nur, dass der Fehler in Zeile 8 lag. Auch wenn der Fehler abgefangen wird, kommen wir nicht an die Stelle, an der der falsche Parameter ins Spiel gekommen ist.

Ein Stacktrace kann da ein wenig Abhilfe schaffen. Nutzt man das Modul Carp, so kann man die Funktionen warn und die mit carp und croak überschreiben und bekommt nun zusätzlich einen Stacktrace. Dafür werden die beiden folgenden Zeilen an den Anfang des Programms eingefügt:

use Carp; $SIG{__DIE__} = sub {croak shift;};

Die Ausgabe sieht nun so aus:

100 durch 5 = 20

100 durch 10 = 10

100 durch 33 = 3.03030303030303

100 durch 50 = 2

Illegal division by zero at ./test.pl line 9.

at ./test_croak.pl line 5

main::__ANON__('Illegal division by zero at ./test_croak.pl line 9.\x{a}') called at ./test.pl line 9

main::divide(100, 0) called at ./test.pl line 15

main::printDivision(100, 0) called at ./test.pl line 22

main::divideList(100, 'ARRAY(0x87d6d28)') called at ./test.pl line 34Bei einer Warnung kann das Programm zwar noch weiter ausgeführt werden, doch sind die Ergebnisse dann in der Regel falsch (vor allem wenn die Warnung wegen einer nicht initialisierten Variablen auftritt). Daher kann es sinnvoll sein die Funktion warn mit croak zu überschreiben, so dass das Programm auch bei einer Warnung abbricht.

Noch praktischer wäre es natürlich, wenn man nun noch die Elemente der Liste kennen würde, mit deren Referenz die Funktion divideList aufgerufen wurde.

Daher habe ich ein kleines Modul entwickelt (die Grundidee stammt aus einem Perl-Buch), welches noch etwas mehr kann. Das Modul DebugMessages gibt bei einem Fehler einen Stacktrace aus, wobei die aktuellen Parameter des Aufrufs mit ausgegeben werden. Auf Wunsch werden werden auch Inhalte von Listen und Hashes ausgegeben.

Zusätzlich wird der Quelltext mit ausgegeben und zwar ab n Zeilen über der Zeile, die den Fehler erzeugt hat bis n Zeilen danach. (Die Anzahl der Zeilen n kann beliebig gewählt werden). Die Zeile mit dem Fehler wird dabei markiert.

Das Modul kann folgendermaßen eingebunden werden:

use lib "path/to/module"; use DebugMessages exit_on_warning => 1, errors => 3, warnings => 3, level => 5, verbose => 1;

Die Pfadangabe "path/to/module" muss natürlich auf das Verzeichnis zeigen, in dem die Datei DebugMessages.pm liegt.

Die einzelnen Parameter haben dabei folgende Bedeutung:

- exit_on_warning: Wenn dieser Parameter 1 ist bricht das Programm schon bei einer Warnung ab. (Default ist 0)

- errors: Anzahl der Zeilen, die jeweils vor und nach der Zeile ausgegeben werden sollen, die einen Fehler produziert hat. -1 deaktiviert DebugMessages für Fehler. (Default ist 3)

- warnings: Anzahl der Zeilen, die jeweils vor und nach der Zeile ausgegeben werden sollen, die eine Warnung produziert hat. -1 deaktiviert Default für Warnungen. (Default ist 3)

- level: Anzahl der Rekursionslevel für den Stacktrace. (Default ist 3)

- verbose: 1 zeigt den Inhalt von Listen und Hasheses in kompakter Schreibweise an. 2 Zeigt den Inhalt ausführlich an. 0 deaktiviert das Ausgeben von Listeninhalten.

Die Fehlermeldung des obigen Beispiels sieht ist nun sehr ausführlich:

100 durch 22 = 4.54545454545455

100 durch 7 = 14.2857142857143

100 durch 16 = 6.25

100 durch 2 = 50

100 durch 5 = 20

100 durch 33 = 3.03030303030303

100 durch 50 = 2

Error: Illegal division by zero at ./test.pl line 11.

0008:

0009: sub divide {

0010: my ($x,$y) = @_;

* 0011: return $x/$y;

0012: }

0013:

0014: sub divideAll {

-------------------------------------

Verbose output of parameters for call of main::divide

100

0

-------------------------------------

main::divide(100,0) called at line 33 in file ./test.pl (package main):

0030:

0031: sub printDivision {

0032: my ($x,$y) = @_;

* 0033: print "$x durch $y = ".divide($x,$y)."\n";

0034: }

0035:

0036: sub divideList {

-------------------------------------

Verbose output of parameters for call of main::printDivision

100

0

-------------------------------------

main::printDivision(100,0) called at line 41 in file ./test.pl (package main):

0038: my $listReference = shift;

0039: my @list = @{$listReference};

0040: foreach my $i(@list){

* 0041: printDivision($x,$i);

0042: }

0043: }

0044:

-------------------------------------

Verbose output of parameters for call of main::divideList

100

0..6 2 5 33 50 0 7 65

-------------------------------------

main::divideList(100,ARRAY(0x9ff2528)) called at line 52 in file ./test.pl (package main):

0049:

0050: # do something else ...

0051:

* 0052: divideList(100,\@divList2);So kann man den Fehler über alle Funktionsaufrufe zurückverfolgen ohne in den Editor wechseln zu müssen. Man hat ja auch den Kontext des Quellcodes vor Augen.

Zusätzlich wurde noch eine kleine Verschönerung für die Ausgabe von Listen hinzugefügt. Mit eingebundenem Modul kann man Listen folgendermaßen ausgeben:

my @list = ("Hallo Welt", "a", "b",1,2,3); print "[@list]\n";

Statt der normalen Ausgabe:

[Hallo Welt a b 1 2 3]

bei der man nicht erkennen kann, wie viele Elemente die Liste enthält, bekommt man mit eingebundenem DebugMessages Modul folgende Ausgabe:

[Hallo Welt] [a] [b] [1] [2] [3]

Das Modul DebugMessages habe ich bei GitHub hoch geladen. Die Adresse ist: http://github.com/zimon/DebugMessages

Ubuntu-/Linux-Treffen im Unperfekthaus (Essen) ¶

Mittlerweile ist das Ubuntu-Treffen im Unperfekthaus zu einem festen Termin in meinem Kalender geworden. Wann immer ich kann, der Tank es erlaubt und ich nicht krank bin, bin ich da. Das ist bisher drei oder vier Mal gewesen. Die Zahl ist nicht besonders hoch, aber sie wird es ja noch.

Ich weiß noch, wie komisch das Gefühl war das erste Mal in eine für mich geschlossene Gruppe zu kommen. Ich war regelrecht nervös. Ich wußte nicht, was auf mich zu kommt und ob ich als (weiblicher) Frischling überhaupt Anschluß finde. Alle meine Bedenken wurden sofort zerstreut. Die Menschen gehen offen und herzlich auf jeden zu - egal ob Anfänger, Profi, weiblich, männlich oder was auch immer. Von wegen geschlossene Gruppe, eingeschworener Kreis oder so was, alles andere ist der Fall. Das Interesse aneinander war von Anfang an groß und so findet man schnell Gesprächstehemen; durchaus auch abseits von Linux oder Ubuntu. Die Stunden vergehen dann wie im Flug und ganz schnell ist es wieder Zeit aufzubrechen.

In der Zwischenzeit wurden Probleme gelöst, Programme diskutiert, Lösungen gesucht, der neue Laptop begutachtet, der alte gefixt oder zumindest das Problem herausgefunden. Man hat eine Menge neuer und netter Leute kennengelernt und was dazu gelernt.

Ich kann jedem die Treffen in seiner Nähe nur empfehlen. Auch wenn ich bisher nur dieses kennengelernt habe, hörte ich doch, dass sich das in vielen Regionen ähnlich abspielt. Und wer zu uns kommen möchte, egal ob zum monatlichen Ubuntutreffen oder zum wöchentlichen Linux-Treffen, der kann gerne vorher noch im IRC vorbeischauen oder im Thread im Ubuntuusers-Forum. Im IRC ist natürlich jeder willkommen. Er muss nicht aus dem Ruhrgebiet stammen. Allerdings ist es ein Laberchannel. Wer also Probleme hat, sollte sich an die offiziellen Chans wenden oder hoffen, dass grad jemand bei Ubuntu-Ruhr ist der Ahnung vom Thema hat. ;)

Und zum Abschluss gibt es noch Fotos, die ich am Ende des letzten Treffens gemacht habe. Leider ist die Qualität schlecht - meine Kamera spinnt ein wenig.

23. März 2010

Ubuntu One Music Store online ¶

Der lange erwartete UbuntuOne Music Store ist nun seit gestern für alle Beta-Tester von Lucid Lynx (Ubuntu 10.04) verfügbar.

Der lange erwartete UbuntuOne Music Store ist nun seit gestern für alle Beta-Tester von Lucid Lynx (Ubuntu 10.04) verfügbar.

Der Store ist in Rhythmbox integriert und Musik kann momentan auch nur von da aus gekauft werden.

Der Store ist in Rhythmbox integriert und Musik kann momentan auch nur von da aus gekauft werden.

Die angebotene Musik ist nicht DRM geschützt und kann somit problemlos auf CD´s gebrannt werden. Jeder Titel kann 60 Sekunden Probegehört werden. Durschnittlich kostet ein Titel 0,99 €. Merkwürdigerweise kosten die Musiktitel auch 0,99 $. Müsste es da nicht eigentlich einen Preisunterschied geben, wegen den verschiedenen Kursen?

Bezahlt wird entweder via PayPal, Clickanbuy oder Kreditkarte.

Der Store befindet sich zurzeit leider nur auf Englisch, so dass Personen, die dieser Sprache nicht mächtig sind, Probleme beim Zurechtfinden im Store haben werden.

Auszug aus der Bekanntmachung durch Canonical:

Ubuntu One Music Store now in public beta

Hello Lucid Testers!

Many in the Ubuntu community are excited about the Ubuntu One Music Store. The ability to search and buy popular music from within Rhythmbox is right around the corner. Today is the day that we are expanding testing by inviting all Ubuntu Lucid users to take part in the public beta of this new feature.

Testing goal

Our primary goal for this phase of testing is to ensure that the purchase and download experience is flawless. Integrating a cloud service like Ubuntu One with buying music is new for digital music stores. While it brings many benefits to users, it also adds technical complexity that increases the opportunity for problems to occur.

Testers must keep in mind that this is a beta test. We are excited to open this feature up for wider testing, but testers must understand that things will break. If something happens preventing a tester from receiving songs, there may be a delay in fulfilling their purchase. The best thing to do is to tell us about the problem using the channels below so we can resolve it quickly.

[Mini-Workaround] IP Blacklist für Yourls 1.4 ¶

Vor ein paar Tagen hatte ich leider sehr viele Spamkürzungen ausgehend von einer IP. Da ich sehr wenig Zeit hatte, habe ich nun einen Miniworkaround eingebaut, dass man von dieser IP keine Kürzung beantragen kann.

Wichtig: Es musste einfach sehr sehr schnell gehen da ich keine Zeit hatte, daher dieser etwas unschöne Workaround.

Änderungen in der Datei functions.php:

In die function yourls_add_new_link in der Zeile 209 folgenden Code einfügen:

// modified by Technical-Life – blacklisting spam ip

$ip_black = yourls_get_IP();

if ( $ip_black == ‘xx.xx.xx.xx’ ) {

$return['message'] = ‘Go away Script-Kiddie’;

return $return;

}

Statt der XX-Zeichenfolge einfach die IP eintragen von der, der Spam ausgeht.