3. Januar 2011

LibreOffice hat nun ein PPA ¶

Der OpenOffice.org-Fork der Document Foundation, LibreOffice, hat neben einer offiziellen Website nun auch ein PPA bei Launchpad bekommen. Damit lässt sich der RC2 der Bürosoftware unter Ubuntu nun ein bisschen einfacher installieren. Bisher musste man eine Reihe von deb-Paketen herunterladen und “von Hand” installieren. Nun kann man das direkt über die Paketverwaltung tun.

Ich habe mir das ganze vor ein paar Tagen schonmal mit den einzelnen deb-Paketen installiert gehabt und hatte noch einige Darstellungsfehler im Writer festgestellt. Die Schrift sah unscharf und einfach nicht schön aus.

Nun habe ich allerdings mal die Pakete aus dem PPA genommen und dort schaut das auch besser aus. Vorher habe ich sicherheitshalber die Einzelpakete, die ich installiert hatte, aber erst einmal entfernt. Installieren kann man LibreOffice mit folgenden Befehlen:

sudo add-apt-repository ppa:libreoffice/ppa sudo apt-get update sudo apt-get install libreoffice

Beim Installieren wird OpenOffice.org vollständig von der Platte entfernt (ausgenommen selbst installierte Pakete wie openoffice.org-hyphenation-de oder openoffice.org-thesaurus-de, falls diese installiert sind). Da LibreOffice noch in der Testphase ist sollte man sich überlegen, ob man das wirklich möchte. Der übliche Hinweis zu Fremdquellen gilt natürlich auch für das LibreOffice PPA.

Um LibreOffice besser in den GNOME Desktop zu integrieren muss noch das Paket libreoffice-gnome installiert werden. Für KDE heißt das Paket libreoffice-kde.

Ich denke es gibt noch keinen zwingenden Grund bereits jetzt auf LibreOffice umzusteigen. Der einzige spürbare Unterschied ist, dass LibreOffice bei mir gefühlt schneller startet als OOo. Aber das ist ein rein subjektiver Eindruck. Große Veränderungen kann man aber wohl auch noch nicht erwarten, da das Projekt ja immer noch recht jung ist. Ich bin dennoch gespannt wohin die Entwicklung geht.

Linux: Verzeichnisse mit mkdir anlegen ¶

Möchte man unter Linux mehrere Verzeichnisse auf einmal anlegen, stößt der Dateimanager Nautilus schnell an seine Grenzen und das Ganze artet in zeitraubende Arbeit aus.

Möchte man unter Linux mehrere Verzeichnisse auf einmal anlegen, stößt der Dateimanager Nautilus schnell an seine Grenzen und das Ganze artet in zeitraubende Arbeit aus.

Auf der Konsole ist das erstellen von Verzeichnissen, Dank mkdir (make directory), äußerst simpel.

Die Syntax lautet: mkdir [Optionen] Verzeichnis

Die wichtigsten Optionen für mkdir:

| -m, –mode=MODE | Angabe der Zugriffsrechte (chmod) |

| -p, –parents | Übergeordnete Verzeichnisse werden mit angelegt. Sind diese bereits vorhanden, wird kein Fehler ausgegeben |

| -v, –verbose | Für jedes erstellte Verzeichnis wird eine Meldung ausgegeben |

| –help | Anzeigen der Hilfe zu mkdir |

| –version | Ausgabe der mkdir-Version |

Erstellen von Ordnern:

Erstellen eines Verzeichnisses pirates-of-art im aktuellen Verzeichnis

mkdir pirates-of-art

Um mehrere Verzeichnisse zu erstellen werden diese, durch ein Leerzeichen getrennt, hintereinander angegeben.

mkdir pirates-of-art1 pirates-of-art2 pirates-of-art3

Durch die komplette Pfadangabe können Verzeichnisse auch außerhalb des aktuellen Verzeichnisses erstellt werden.

mkdir /tmp/pirates-of-art

Ist das Elternverzeichnis nicht vorhanden wird dieses mit folgendem Beispiel zusätzlich erstellt.

mkdir -p poa/pirates-of-art

Folgender Befehl setzt gleich die Rechte des Verzeichnisses, dies kann auch für mehrere Verzeichnisse verwendet werden.

mkdir -m 400 pirates-of-art1 pirates-of-art2

Die Option -v zeigt an ob die Verzeichnisse angelegt wurden oder diese bereits existieren.

mkdir -v pirates-of-art1 pirates-of-art2 pirates-of-art3

Anleitung wurde mit Ubuntu 10.04 erstellt

Fazit: Mit mkdir kann man auf einfache Weise, größere Verzeichnisstrukturen schnell und unkompliziert anlegen.

Klar soweit?

Euer RSB

Sqlite-Commander – Curses Client für SQLite Datenbanken ¶

Clients für SQLite Datenbanken gibt es schon einige, so zum Beispiel eine Firefox Extension SQLite Manager. Wer allerdings auf der Kommandozeile arbeiten will war bisher auf die Kommandos angewiesen, die SQLite selbst mitbringt. Da auch die Suche nach einem passenden Client für Sankar P ergebnislos verlief, hat er sich kurzerhand hingesetzt und Sqlite Commander geschrieben, eine Cursesbasierte Anwendung für Sqlite Datenbanken. Der Name ist inspiriert vom MidnightCommander und ähnlich sieht Sqlite Commander auch aus, bietet aber noch nicht so viele Möglichkeiten, wie sein Vorbild. Ehrlich gesagt fehlen noch jede Menge Funktionen, bisher lassen sich die verschiedenen Tavellen nur darstellen und mit den Cursortasten in ihnen navigieren. Die ToDo-Liste von Sankar weisst aber die nächsten Features bereits auf, die er implementieren will und er will die Software auch weiterhin pflegen, wenn sich genug Nutzer finden, die dieses Tool nützlich finden.

Anzahl reservierter Blöcke herabsetzen ¶

sudo tune2fs -l /dev/md0In der Ausgabe dieses Befehls gibt es dann eine Zeile namens Reserved block count in der die reservierten Blöcke stehen und eine Zeile namens Block size in der die Blockgröße steht. In meinem Fall beträgt diese 4096 Bytes. Nun kann man ausrechnen wie viele Blöcke man benötigt um den gewünschten freies Speicherplatz zu reservieren. Bei mir soll es genau ein Gigabyte sein, also exakt 262144 Blöcke. Gesetzt wird das ganze dann mittels:

sudo tune2fs -r 262144 /dev/md0wobei /dev/md0/ das entsprechende Gerät ist. Und schon ist der neue Wert gesetzt.

Weitere Informationen gibt es unter:

http://wiki.ubuntuusers.de/ext

http://www.pro-linux.de/artikel/2/1125/dateisystem-tuning.html

http://entwickler.com/itr/online_artikel/psecom,id,868,nodeid,9.html

Anzahl reservierter Blöcke herabsetzen ¶

Unter der ext Dateisystemfamilie ist es so, dass standardmäßig fünf Prozent des Speicherplatzes für root reserviert sind so das das Dateisystem nicht “vollaufen” kann, ohne das der Nutzer root es wieder richten kann. Das Problem an dieser Reglung ist das sie manchmal eine ziemliche Platzverschwendung ist. Bei meinem NAS beläuft sich diese auf zirka 300 GB. Glücklicherweise kann man diesen Wert aber korrigieren. Im ersten Schritt sollte man dazu die Blockgröße des Gerätes ermitteln. Dies geschieht mittels:

sudo tune2fs -l /dev/md0

In der Ausgabe dieses Befehls gibt es dann eine Zeile namens Reserved block count in der die reservierten Blöcke stehen und eine Zeile namens Block size in der die Blockgröße steht. In meinem Fall beträgt diese 4096 Bytes. Nun kann man ausrechnen wie viele Blöcke man benötigt um den gewünschten freies Speicherplatz zu reservieren. Bei mir soll es genau ein Gigabyte sein, also exakt 262144 Blöcke. Gesetzt wird das ganze dann mittels:

sudo tune2fs -r 262144 /dev/md0

wobei /dev/md0/ das entsprechende Gerät ist. Und schon ist der neue Wert gesetzt.

Weitere Informationen gibt es unter:

http://wiki.ubuntuusers.de/ext

http://www.pro-linux.de/artikel/2/1125/dateisystem-tuning.html

http://entwickler.com/itr/online_artikel/psecom,id,868,nodeid,9.html

CAcert und Chromium ... ¶

Dem kann sehr schnell Abhilfe geschaffen werden. Zuerst müssen die nss-tools installiert werden:

sudo aptitude install libnss3-tools

Anschliessend lädt man die Zertifikate von der CAcert-Webseite herunter und importiert diese:

cd /tmp

wget http://www.cacert.org/certs/root.crt

certutil -d sql:$HOME/.pki/nssdb -A -t "C,," -n "CAcert Class 1" -i root.crt

wget http://www.cacert.org/certs/class3.crt

certutil -d sql:$HOME/.pki/nssdb -A -t "C,," -n "CAcert Class 3" -i class3.crt

Überprüfen kann man das erfolgreiche Importieren mittels:

certutil -d sql:$HOME/.pki/nssdb -L

2. Januar 2011

Der Dezember im Kernelrückblick ¶

Die Entwicklung des 2.6.37 nähert sich dem Ende, die Finalversion wurde im Dezember jedoch noch nicht veröffentlicht. Eine Änderung in der Pflege der Langzeit-Kernel-Versionen, der Kernel der kommenden Debian-Version und der Jahresbericht der Linux Foundation sind ebenfalls Themen dieses Kernelrückblicks. Dieser ist, neben vielen anderen interessanten Beiträgen, in der aktuellen Ausgabe von freiesMagazin enthalten.

Kernel 2.6.37

Der November endete mit einer kleinen Enttäuschung: Ein endlich beseitigt geglaubter Fehler in der Behandlung von Verzeichnisauflistungen des Netzwerkdateisystems NFS erwies sich als äußerst widerstandsfähig und konnte auch mit einigen in -rc4 (siehe „Der November in Kernelrückblick“, freiesMagazin 12/2010 [1]) aufgenommenen Patches nicht beseitigt werden. Auch -rc5 [2] konnte hier keine Abhilfe schaffen. Dafür können nun Schnappschüsse des verteilten Dateisystems Ceph [3] als Block-Devices in Unterverzeichnisse unterhalb des zugehörigen Abbildes eingehängt werden, was die Übersichtlichkeit im Umgang damit erhöhen soll. 2.6.37-rc6 [4] brachte dann eine Erweiterung des GPIO-Treibers (General Purpose Input/Output – Mehrzweck-Ein/Ausgabe), mittels derer nun Geräte an der Schnittstelle verwendet werden können, die den Kernel nicht mittels eines Interrupts auf ein angelegtes Signal aufmerksam machen können, wie zum Beispiel ein einfacher Schalter. Ist diese neue Funktion aktiviert, wird die Schnittstelle permanent auf Signaländerungen überwacht.

Kurz vor den Feiertagen setzte Torvalds der Entwicklergemeinde dann den -rc7 [5] vor. Mit diesem wurden Änderungen der PCI-Treiber rückgängig gemacht, die leider zu Problemen führten. Auch der Treiber für Intel-Grafikchips bereitet derzeit Probleme, ebenso das Entfernen des Big Kernel Lock aus dem V4L-Treiber. Wenigstens letzteres beschränkte sich in erster Linie auf die Leistung des Video-Treibers und soll mittels einiger Änderungen des Entwicklers Hans Verkuil behoben werden. Ein weiterer großer Wurf dieser Vorabversion ist ein größerer Patch, mit dem ein Fehler der Funktion NO_HZ vollständig ausgemerzt werden soll. Dieser äußert sich in der fehlerhaften Anzeige der Systemlast. NO_HZ soll das zeitgesteuerte Aufwachen des Prozessorkerns gegen einen bedarfsgesteuerten Aufwachzyklus tauschen und damit den Energiehunger des Prozessors dämpfen.

Änderung der Langzeit-Kernelpflege

Bislang galt beim Kernel immer die Devise „The latest is the greatest“ (Der Neueste ist der Beste) und entsprechend trägt automatisch immer die zuletzt veröffentlichte Version das Prädikat „stable“; zu deutsch „stabil“ im Sinne von „beständig“ oder „sicher“ [6]. Das bedeutet grundsätzlich, dass bei Erscheinen eines neuen Kernels zügig auf diesen aktualisiert werden sollte. Dazu kamen noch die von Greg Kroah-Hartman über längere Zeit gepflegten Versionen, „Longterm Releases“ genannt, dies sind derzeit 2.6.27, 2.6.32 und 2.6.35. Welche Versionen zum Longterm Release werden, entscheidet Kroah-Hartmann selbst. Jedoch erhält er zunehmend Anfragen, die jeweils aktuelle Version in die Langzeitpflege aufzunehmen. Aus Zeitgründen zieht Kroah-Hartman hier nun einen Strich unter die Praxis der Langzeit-Veröffentlichungen [7] und pflegt künftig nur noch die aktuellsten ein oder zwei Versionen, um den Nutzern einen sanften Umstieg ohne große Hektik ermöglichen zu können.

Die bereits angekündigten und derzeit gepflegten Longterm-Versionen werden entsprechend weiter gepflegt, werden jedoch eventuell andere Betreuer erhalten. Dies wird zum Beispiel 2.6.35 betreffen, der künftig von Andi Kleen gepflegt wird. Auf der offiziellen Kernel-Seite [8] sind diese Versionen als „longterm“ gekennzeichnet.

Freier Kernel für Debian

Als „freies“ Betriebssystem erfreut sich Linux einiger Beliebtheit. Jedoch findet sich bereits im offiziellen Linux-Kernel stellenweise proprietärer Code, der in Form von binären Blobs vorliegt. So laden zum Beispiel Netzwerktreiber beim Start die Firmware auf den Chipsatz der Netzwerkkarte, auch bei Grafiktreibern ist dies Praxis. Das Debian-Projekt hat nun den Kernel selbst von diesen unfreien Bestandteilen befreit und bringt mit der kommenden Debian-Version 6.0 „Squeeze“ einen vollständig freien Kernel mit [9].

Während die Idealisten jubeln, müssen Besitzer von Hardware, für die keine vollständig freien Treiber zur Verfügung stehen, auf Squeeze jedoch nicht verzichten. In den „non-free“-Repositories stehen alternative CD-Abbilder zum Download bereit, die die unfreien Treiber beinhalten.

Jahresbericht

Den jährlichen Bericht über die Kernel-Entwicklung legte die Linux Foundation im Dezember vor [10]. Er versucht die Fragen „Wie schnell geht es voran?“, „Wer macht es“?, „Was machen sie?“ und „Wer fördert es?“ zu beantworten. Daraus erschließt sich eine mittlere Entwicklungszeit von etwa 81 Tagen pro Kernelversion, zumindest in den letzten beiden Jahren hat sich dieser Zeitraum eingebürgert. Die Zahl der Patches gibt nach einem Spitzenstand von fast 12.000 bei 2.6.30 wieder leicht zurück auf etwa 9800 bei 2.6.35, dies lässt sich unter anderem damit erklären, dass sich die Entwicklung einiger Subsysteme, darunter die Dateisysteme ext4 und btrfs mittlerweile stabilisiert hat und nun weniger Arbeit erfordert. Mittlerweile über 13 Millionen Quelltext-Zeilen verteilen sich auf über 33.000 Dateien. Die Anzahl der aktiven Entwickler ist wieder gestiegen. Nach einem kurzen Zwischenhoch von 1248 bei 2.6.32 sank die Zahl auf 1150 bei 2.6.34, im Entwicklungszyklus von 2.6.35 kamen wieder 37 neue hinzu. Insgesamt haben über die letzten Jahre 6117 Entwickler zum Linux-Kernel beigetragen. Dagegen sinkt die Zahl der beteiligten Unternehmen seit 2.6.32 von 259 auf 184 (2.6.35) weiter ab. Die absoluten Top-Entwickler sind David S. Miller und Ingo Molnar, der Betreuer des Schedulers. Unter den Firmen, die die Linux-Entwicklung unterstützen, liegt Red Hat mit 12% aller Änderungen vorne, gefolgt von Novell mit 7% und IBM mit 6,9%. 6,4% der Änderungen am Kernel konnten keinem Unternehmen zugeordnet werden, mit 18,9% liegt ein doch noch recht großer Anteil bei „freien“ Entwicklern [11].

Ein Abbild (Englisch: Image) ist eine Eins-zu-Eins-Kopie eines Dateisystems oder Datenträgers. Es kann dazu verwendet werden, ein Dateisystem zu sichern, indem ein Abbild zu einem bestimmten Zeitpunkt erstellt wird und dieses anschließend jederzeit wieder auf den Datenträger zurückgespielt werden kann. Es erscheint dann gegenüber dem Zeitpunkt, zu dem es erstellt wurde, unverändert. Abbilder werden auch von CDs erstellt und verbreitet, zum Beispiel für die Installations-CD der Lieblingsdistribution. Manchmal wird der Begriff Abbild auch für im Netzwerk abgelegte Datenspeicher verwendet.

Schnappschüsse (Englisch: Snapshot) stellen ebenso den Zustand eines Dateisystems zu einem bestimmten Zeitpunkt dar, werden jedoch nicht zu diesem Zeitpunkt vollständig erstellt. Es werden vielmehr die Änderungen im Dateisystem zwischen dem Zeitpunkt des Schnappschusses und dem jetzigen mitprotokolliert. Dadurch kann ein Schnappschuss im laufenden Betrieb durchgeführt werden, ohne dass Zugriffe darauf unterbunden werden müssten.

Quellen:

[1] http://www.freiesmagazin.de/freiesMagazin-2010-12

[2] http://lkml.org/lkml/2010/12/7/9

[3] http://ceph.newdream.net/

[4] http://lkml.org/lkml/2010/12/15/457

[5] http://lkml.org/lkml/2010/12/21/226

[6] http://www.dict.cc/?s=stable

[7] http://lkml.org/lkml/2010/12/2/388

[8] http://master.kernel.org/

[9] http://www.pro-linux.de/news/1/16516/debian-60-soll-vollstaendig-freien-...

[10] http://www.linuxfoundation.org/docs/lf_linux_kernel_development_2010.pdf

[11] http://www.pro-linux.de/news/1/16462/kernel-jahresbericht-der-linux-foun...

Ayatana in openSUSE ¶

Schon vor einigen Tagen hat Nelson Marques bekannt gegeben, das das von Chanonical für Ubuntu entwickelte Ayatana System auch für openSUSE verfügbar sein wird. Marques hat bereits vorher OSD-Notify auf openSUSE portiert. Die openSUSE Version von Ayatana is im Gegensatz zu der von Ubuntu voll zu Gnome kompatibel, man hofft auch darauf das einige der Entwicklungen zurückfliessen werden in das Projekt von Ubuntu und somit die Kompatibilität aufrecht erhalten wird. Ayatana in openSUSE wird es zunächst für die Gnome Version 2.32 geben, Teile sind aber schon mit GTK3 geschrieben und laufen deshalb unter GNOME 3.

Nachdem bereits einige Wünsche in openFATE aufgetaucht sind, Ubunutus Unity auch für openSUSE verfügbar zu haben arbeit man nun auch daran.

Komfortables Backup-Skript (rsync) (Update) ¶

Gute grafische Backup-Programme gibt es mittlerweile auch unter Linux en masse, jedoch hänge ich nach wie vor an meinem selbst geschriebenen Backup-Skript, welches das freie Tool rsync für die (inkrementelle) Sicherung auf eine externe Festplatte verwendet. Der Grund hierfür ist eigentlich recht simpel: ich konnte bislang keine Backup-Software finden, welche meinen Anforderungen hundertprozentig gerecht werden konnte. Außerdem arbeiten Skripte zumindest subjektiv schneller und zuverlässiger. Das alles soll Grund dafür sein, euch das Bash-Skript einmal vorzustellen.

Das Backup zeigt zu Beginn die gewählten Einstellungen an (im Bild wurden 2 Profile mit anschließendem Herunterfahren gewählt)

Funktionen

Das „Kernstück“ des Skriptes bildet rsync, welches beliebig viele Verzeichnisse mit einem Zielverzeichnis vergleicht und synchronisiert. Dies verläuft nur in eine Richtung (unidirektional), was bedeutet, dass mögliche Änderungen im Zielverzeichnis verloren gehen, da die Verzeichnisse nicht zusammengeführt (merge) werden können. Bei einem Backup ist das aber unerheblich, da das Zielverzeichnis, in dem sich das Backup befindet, ohnehin nicht manuell verändert werden sollte.

Wird eine Datei im Quellverzeichnis erstellt, verändert oder gelöscht, so wird diese Datei von rsync in das Zielverzeichnis übertragen bzw. im Zielverzeichnis ebenfalls gelöscht. Sobald rsync mit der „Arbeit“ fertig ist, sind Quell- und Zielverzeichnis identisch.

Mehr Informationen zu rsync und dessen Funktionsweise, sind zum Beispiel im Wiki von ubuntuusers.de zu finden.

Mein Backup-Skript bietet darüber hinaus noch ein paar weitere nützliche Funktionen:

- Es lassen sich beliebig viele Backup-Profile konfigurieren (mit unterschiedlichen Verzeichnissen und Einstellungen).

- Es können mehrere oder alle Profile auf einmal gestartet werden (-p* -p* / -a; s.u.).

- Optional können zu synchronisierende Verzeichnisse direkt an das Skript übergeben werden (-m; s.u.).

- Nach abgeschlossenem Backup kann der Computer optional automatisch heruntergefahren werden (mit Abbruchmöglichkeit). Dazu sind in der Regel keine Root-Rechte erforderlich (-s; s.u.).

- Dateien und Verzeichnisse lassen sich unkompliziert von der Sicherung ausschließen (<<EOF und EOF; s.u.)

- Aussagekräftige Fehlermeldungen und eine Anleitung erleichtern die korrekte Verwendung des Skriptes.

- Benachrichtigungen mit notify-send und wall (dadurch kann das Skript auch gut im Hintergrund ausgeführt werden).

Abhängig von den Optionen von rsync sind zudem folgende Dinge möglich und standardmäßig eingestellt:

- Im Quellverzeichnis gelöschte Dateien werden auch im Zielverzeichnis gelöscht.

Aber: alle gelöschten und veränderten Dateien werden zuvor in einem separaten Ordner gesichert und müssen dort manuell gelöscht werden ($BAK_DIR; s.u.) - Eine Logdatei, in der alle Aktionen von rsync aufgezeichnet werden, wird angelegt ($LOG; s.u.).

Konfiguration

Da die Konfiguration nicht furchtbar kompliziert ist, sollte sie auch ohne größere Erfahrung mit Skripten zu bewältigen sein. Zudem helfen die Kommentare (#) im Skript bei der Einrichtung.

In der Variablen $RSYNC_OPT werden die Optionen gespeichert, mit denen rsync vom Skript aufgerufen wird (siehe auch man rsync). $MOUNT enthält optional den Mountpoint einer externen Festplatte, um überprüfen zu könne, ob diese korrekt angeschlossen und eingebunden wurde. $BAK_DIR gibt einen Ordner für gelöschte und veränderte Dateien an, wobei dabei die Variable $TARGET (Zielverzeichnis) verwendet werden kann.

Die Einstellungen der einzelnen Profile werden in sogenannten Arrays gespeichert (n ist dabei durch eine Zahl zu ersetzen):

title[n]="" arg[n]="" source[n]="" target[n]="" log[n]="${target[n]}/${title[n]}_log.txt" exfrom[n]="$(mktemp -t "tmp.rsync.XXXX")" cat > "${exfrom[n]}" <<EOF EOF

Im Array title[n] wird eine Bezeichnung und in arg[n] ein Argument (i.d.R. bestehend aus einem Buchstaben), mit dem das Profil aufgerufen wird, gespeichert. Beide Angaben werden in der Hilfe und bei der Ausführung des Skriptes angezeigt.

In source[n] stehen die Quellverzeichnisse, wobei (nur) in diesem Fall Pfadangaben, welche ein Leerzeichen enthalten, von \” umschlossen werden müssen. Das Zielverzeichnis wird mit target[n] festgelegt.

Zwischen <<EOF und EOF kann man Dateien und Verzeichnisse angeben, welche nicht gesichert werden sollen. Hierbei ist pro Zeile lediglich 1 Pfadangabe erlaubt, wobei Leerzeichen diesmal nicht besonders behandelt werden dürfen.

Der Pfade zur Logdatei in log[n] und zur temporäre Datei in exfrom[n] müssen nicht zwingend geändert werden.

Skript ausführen

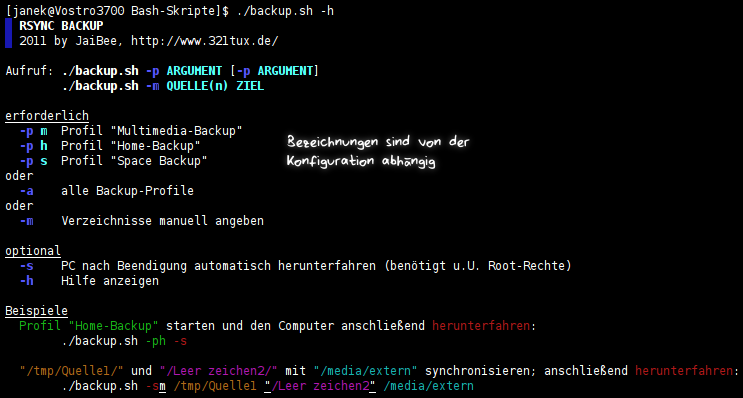

Wie das Skript korrekt aufgerufen wird, ist folgendem Screenshot zu entnehmen:

Und noch einmal in Worten: um ein bestimmtes Profil zu starten, muss an das Skript die Option -p, gefolgt von dem entsprechenden Argument, übergeben werden. Alternativ kann man mit der Option -a sämtliche Profile auf einmal starten oder mehrere Profilaufrufe hintereinander auflisten (-p ARGUMENT -p ARGUMENT2).

Darüber hinaus gibt es noch die Option -m, die als Argument Quell- und Zielverzeichnis erwartet. In diesem Fall, müssen Verzeichnisse, die Leerzeichen enthalten, lediglich von “ umschlossen werden.

Mit -s wird der Computer nach dem Backup automatisch heruntergefahren und die Option -h zeigt die Hilfe an.

Mehr gibt’s eigentlich nicht zu sagen, außer vielleicht noch, dass ich hoffe, dass das Skript auch bei euch fehlerfrei läuft; getestet habe ich es in der jetzigen Version mit Ubuntu 10.10 und Arch Linux.

Update (12. Juni 2011)

Stefan hat mich in den Kommentaren auf Fehler aufmerksam gemacht, die auftreten, wenn das Skript als Cron-Job aufgerufen und wenn als Quelle das Root-Verzeichnis (/) angegeben wird. Zudem hat er vorgeschlagen, auf Systemen ohne grafische Oberfläche echo anstatt notify-send zu verwenden. Praktischerweise hat er auch gleich passende Lösungen geliefert, welche ich in fast identischer Form übernommen habe.

An dieser Stelle nochmals vielen Dank, Stefan, für die Verbesserungsvorschläge und Lösungsansätze… und für das Testen des angepassten Skriptes.

Folgende Änderungen sind in die neue Version eingeflossen:

- Fehler im Zusammenhang mit clear bei Ausführung als Cron-Job behoben

- notify-send wird nur noch bei Systemen mit grafischer Oberfläche verwendet, ansonsten echo

- das Zielverzeichnis wird angepasst ($TARGET/ROOTFS), wenn als Quelle das Root-Verzeichnis verwendet wird

- “ERROR” wurde durch das schöne deutsche Wort “FEHLER” ersetzt

- noch ein paar Kleinigkeiten

Wer das Skript bereits verwendet, kann ohne Probleme auf die verbesserte Version umsteigen. Dazu einfach die bisherigen Profileinstellungen in das neue Skript kopieren.

Update (13. Juni 2011): Ich hatte noch einen kleinen Bug eingebaut, der zum Glück von Stefan bemerkt und mittlerweile korrigiert wurde.

Update (7. Januar 2012) – weitere Funktionen von Stefan

Stefan hat das Backup-Skript auf seinem Blog um einige nützliche Funktionen erweitert:

- Ein- und Aushängen des Sicherungs-Ziels

- Entfernen von alten Sicherungen und Log-Dateien nach einstellbarer Zeit (Tage)

- Konfiguration ausgelagert, um den Einsatz auf mehreren Systemen zu vereinfachen (zum Skript)

- FTP-Server als Quelle (zum Skript)

Zum Download

Das Skript könnt ihr auf der nächsten Seite herunterladen ![]() .

.

Der Unity Desktop benötigt deine Hilfe ¶

Das Projekt Unity wurde 2010 von Mark Schuttleworth und Canonical als Fenstermanager für den Ubuntu Desktop auf Netbooksysteme und Geräte mit Touchdisplay ins Leben gerufen. Revolutionierendes Design und Benutzerfreundlickeit sind der Kern des Projektes.

Nach dem Erscheinen von Ubuntu 10.10 wurde beschlossen, dass Unity Einzug in die Ubuntu-Desktop Edition erhalten soll. So wird in der im April erscheinenden Ubuntu Version 11.04 Natty Narwhal, nicht mehr der Standard Gnome Desktop sondern der auf Gnome aufbauende Unity-Desktop der Blickfang sein.

Deine Hilfe ist gefragt. Mit Deiner Hilfe machst du Unity für Natty startklar.

Wie du helfen kannst:

Fehler beheben

1. Lese die Anweisungen zum Programmieren

2. Wähle einen bestehenden Fehler/Bug aus

3. Lese die Anweisungen wie du beim Beheben eines Fehlers/Bugs vorgehst

4. Achte darauf dich bei #ayatana auf Freenode IRC anzumelden um Fragen zu stellen

Natty/Unity Testen

1. Das Ubuntu 11.04 (Natty Narwhal) Daily Build Image herunterladen

2. Installiere das Image z.B. mit Virtualbox oder erstelle einen Life USB-Stick

3. Wenn du einen Bug findest, öffne ein Terminal und führe folgenden Befehl aus: ubuntu-bug unity -> Folge den Anweisungen.

4. Achte darauf dich bei #ayatana und #ubuntu-desktop auf Freenode IRC anzumelden um Fragen zu stellen

Designen

1. Diskutiere hier mit anderen über deine Ideen.

2. Achte darauf dich bei #ayatana auf Freenode IRC anzumelden um Fragen zu stellen

Übersetzen

Uniyt ist derzeit in über 60 Sprachen übersetzt worden und jede weitere Sprache ist willkommen.

Sollte deine Sprache oder eine Sprache die du zusätzlich zu deiner Muttersprache beherrschst nicht in der Liste sein, so hast du die Möglichkeit die jeweilige Sprache hinzuzufügen.

- Wenn du noch nie auf Launchpad eine Software übersetzt hast, so hilft dir diese Einstiegsanweisung.

- Als nächsten Schritt gehst du auf die Übersetzungsseite

- Bei Fragen kannst du das Übersetzungsteam kontaktieren.

Der neue TeamViewer: Mikogo Desktop Sharing Lösung bald auch für Linux ¶

Der neue TeamViewer: Mikogo ist eine Plattform-unabhängige Desktop Sharing Lösung für Web Konferenzen, Online Meetings oder Remote Support.

Fast jedem ist die kommerzielle Fernwartungssoftware TeamViewer ein Begriff. Die wohl beste Alternative ist die vom TÜV für das Qualitätsmanagement nach ISO 9001 zertifizierte Desktop Sharing Lösung Mikogo.

Mikogo wird in den nächsten Wochen / Monaten in der Version 4 erscheinen und laut einem Entwickler von Mikogo auch Linux unterstützen. Bisher war die Anwendung nur für Windows und Mac zum kostenlosen Download und für kommerzielle Zwecke auch kostenlosen Nutzung erhältlich, so dass Benutzer von z.B Ubuntu, Wine zum Verwenden von  Mikogo einsetzen mussten.

Mikogo einsetzen mussten.

Mit Mikogo ist es besonders einfach, Freunde, Bekannte oder Kollegen zum Betrachten eines Desktops einzuladen. Diese müssen natürlich ebenfalls Mikogo installiert haben. Online-Support bei Problemen mit dem jeweiligen System, Echtzeit-Präsentationen oder Meetings über das Internet waren noch nie einfacher.

Die völlige Kontrolle über den PC den Gästen (maximal zehn Leute gleichzeitig) zu geben ist möglich. Programmstarts, Tastatur-Eingaben oder Mausklicks sind so über die Ferne möglich.

Damit sich keine Unbefugten in die Sitzung mogeln können, bietet Mikogo eine 256-Bit Enkryption. Zusätzlich zu der ID, kann für jede Anmeldung ein persönliches Passwort vergeben werden.

Mikogo wurde 2007 von der deutschen Firma BeamYourScreen GmbH, einem Anbieter von web-basierten Online Collaboration Tools, gelauncht. Firmensitz ist in Mannheim. Also fast nebenan von TeamViewer, die in Göppingen Ihren Sitz haben.

Die BeamYourScreen GmbH wurde 2004 in Mannheim von Erik Boos und Mark Zondler als Anbieter von innovativen Web-Kollaborations-Lösungen für kleine und mittelständische Unternehmen gegründet. Das Produktportfolio umfasst Lösungen für Online Meetings, Online Präsentationen und Remote Support. Unternehmen rund um den Globus profitieren vor allem durch deutlich reduzierte Reisezeiten und -kosten. Kunden sind vor allem kleine und mittelständische Firmen, aber auch Großunternehmen wie Toshiba, Yamaha und Roche.

BeamYourScreen bedient nicht nur 1500 Unternehmenskunden in 40 Ländern weltweit, sondern wurde 2007 auch offiziell mit dem Innovationspreis der Initiative Mittelstand für die Online Präsentations Lösung Beam2Present ausgezeichnet.

Nachdem BeamYourScreen aufgrund der zahlreichen Anfragen insbesondere von Privatnutzern für ein kostenloses Desktop Sharing Tool den Bedarf hierfür erkannte war die Idee für Mikogo geboren.

Um ein Betatester zu werden, habt Ihr die Möglichkeit in diesem Forum Euch dafür zu bewerben, oder folgt Mikogo auf Facebook um up to date zu bleiben.

RSS-Feeds als Magazin ¶

1. Januar 2011

Android Tablet – Infotmic PAD-1003 ¶

Wie schon im letzten Artikel besprochen, habe ich mir das Infotmic PAD-1003 mit 10″ erstanden. Hier ein kleiner Anwendungsbericht.

Das Tab liegt sehr gut in der Hand. Das Gehäuse ist mit einer Art Kunststoff-Schutz umgeben, wenn man es in den Händen hält, fühlt es sich irgendwie weich an. Die Anschlüsse sind alle auf einer Seite angeordnet. Ein Strom-Adapter die in unsere schweizer Steckdose passt ich auch im Lieferumfang. Eine Web-Kamera ist eingebaut, die Lautsprecher sind an der oberen Seite intergriert und auch ein Mikrofon ist dabei.

Eine Ausnahme bildet hier der RJ45 Ethernet Anschluss. Dieser kann wie bei einem normalen Computer an das Netzwerk angeschlossen werden. Auch eher etwas speziell sind die 2 Micro SD Karten-Slot. So kommt das Tab auch mit 2 USB Anschlüssen, was einem diverse Möglichkeiten offen lässt.

An der Oberkante befinden sich die Bedienungselemente. In der Mitte steht sogar noch ein Anschluss für die GPS Antenne zur Verfügung (ist im Lieferumfang enthalten). Hier könnte man dann schon bald in Versuchung geraten, das Tab ins Auto einzubauen und als Navigationsgerät zu nutzen.

Technische Merkmale

- Screen Size: 10″

- Processor Brand: infortmic x220

- Processor Type: infotmic x220

- Hard Drive Capacity: 2GB

- Memory Capacity: 256MB

- Processor Main Frequency: 1GHZ

- Weight: 0.65kg

- OS: Android 2.1

- HDMI

- GPS yesgravity sensor

- Ethernet RJ45

- Extended micro sd card slot 2x

- Standby time: 10 hours

- Camera 3.1 mp

Inbetriebnahme

Ich habe das Tab nach dem auspacken erst mal an die Steckdose angeschlossen. Nach einiger Zeit war der Akku voll geladen und es konnte losgehen. Beim Booten hat das Tab schon seine Zeit und es erscheinen verschiedene Logos und Hintergrundbilder. Hier erscheint bei Android normalerweise nur das Android-Logo. Macht nichts, ich kann damit leben. Wenn das Tab bereit ist, dann ist es eigentlich immer gesichert. Wie bei einem Smart-Phone muss man das Display entsperren. So gesehen eigentlich das erwartete, einschalten und los gehts.

Die Oberfläche

Das Display hat eine Auflösung von 1024×600 Pixel. Dies ist eine angenehme Grösse zum arbeiten. Der Startbildschirm erscheint ganz aufgeräumt. Wie bei einem Apfelgerät hat man am unteren Rand dann eine Art Dock. Hier kann man seine Favoriten Apps platzieren.

An der Oberkante befindet sich eine Art Navigationsleiste. Diese sieht nicht ganz so aus wie man sich das von einem Android 2.1 gewohnt ist, hat aber auch seine Vorzüge, da weitere Funktionen eingebaut sind. Die Desk lassen sich nach Links oder rechts verschieben. Der Übergang wird mit einem 3D Würfel im Slide-Effekt angezeigt, schöne Idee. Der Market ist auch schon bereit und braucht nur noch mit seinen Google Kontaktdaten versehen zu werden.

Die Apps

Einige Apps sind schon vorinstalliert. Es sind nicht zu viele, so dass das Tab nicht überlastet ist. Finde ich eine gute Idee, denn jeder hat so seine eigenen Apps die er gerne haben möchte und kann diese dann über den Market installieren.

Ich habe das Tab nun einmal als “Familien-Tab” konfiguriert. Es dient im Moment im Wohnzimmer als allgemeines Auskunfts-System. So sind auf dem Tab Apps für folgende Funktionen installiert:

- Aktuelle Zeitung (20min)

- Wetterinformationen (wetter.net)

- Bus und Zugfahrplan (ZVV Fahrplan)

- Fernsehprogramm (tvtv)

- Telefonauskunft (search.ch)

- Kinoprogramm (Cineman)

- Wikipedia (Wikidroid)

- Strasseninformationen (Swiss Traffic)

Es gibt natürlich noch weitere Apps die wir dann noch ausprobieren werden, je nach Anforderungen im Haushalt.

Eine weitere App ist Skype. Ohne Probleme läuft Skype nach der Installation. Was noch fehlt ist die Unterstützung von der integrierten Webcam, damit auch die Videotelefonie auf den Tab kommt.

Fazit

Das Infotmic PAD-1003 macht auf mich eine wirklich guten Eindruck. Wenn man den Preis von 240€ anschaut, dann kann man einen Vergleich zu einem Apfel-Gerät gar nicht in Betracht ziehen.

Ähnliche Artikel

Aptosid 2010-3 veröffentlicht ¶

Kurz vor Jahresende haben die Aptosid-Entwickler die Version 2010-3 der auf Debian unstable beruhenden GNU/Linux-Distribution freigegeben.

Im September des vergangenen Jahres kam es zu Meinungsverschiedenheiten zwischen dem Verein sidux e. V. und den Sidux-Entwicklern. Daraufhin haben sich die Sidux-Programmierer von dem Verein losgelöst.

Aufgrund dessen, dass der Verein sidux e. V. im Besitz der Namensrechte für Sidux ist, musste sich die Sidux-Community für einen neuen Namen – Aptosid – entscheiden.

Gemäss den Veröffentlichungsnotizen werkelt in Version 2010-3 (Codename: Ἀπάτη) der Linux-Kernel in der Version 2.6.36.2.

Aptosid 2010-3 kann in den Varianten KDE-lite, KDE-full und XFCE von einem der Spiegel-Server des Projekts heruntergeladen werden.

Planet-Statistik des Monats Dezember [Update] ¶

Wie bereits vor wenigen Tagen angekündigt, startet hiermit die von nun an monatlich erscheinende Statistik zum ubuntuusers-Planeten.

Es wurden im Monat Dezember (31 Tage) 180 Artikel veröffentlicht. Diese Beiträge wurden von 45 Blogs geschrieben. Insgesamt wurden 5.81 Artikel pro Tag veröffentlicht.

56% der eingetragenen 80 Blogs waren im vergangenen Monat aktiv im ubuntuusers-Planeten.

| Blog | Anzahl Artikel | |

| 1 | blog.elektronik-projekt.de | 20 |

| 2 | ubuntublog.ch | 14 |

| 3 | drice.org | 13 |

| 4 | picomol.de | 11 |

| 5 | deimeke.net | 10 |

| 6 | seeseekey.net | 8 |

| 7 | menzer.net | 7 |

| 8 | ubuntuxx.de | 6 |

| 9 | zockertown.de | 6 |

| 10 | virtualpixel.de | 6 |

| 11 | be-jo.net | 5 |

| 12 | suckup.de | 5 |

| 13 | rockiger.com | 4 |

| 14 | onli-blogging.de | 4 |

| 15 | everflux.de | 4 |

| 16 | knetfeder.de | 4 |

| 17 | linuxnetz.wordpress.com | 4 |

| 18 | behind.ubuntuusers.de | 3 |

| 19 | ubuntu-center.de | 3 |

| 20 | pablo-bloggt.de | 3 |

| 21 | trompetenkaefer.wordpress.com | 3 |

| 22 | campino2k.de | 3 |

| 23 | blog.bugie.de | 3 |

| 24 | marcopeter.radio-gfm.net | 2 |

| 25 | karl-tux-stadt.de | 2 |

| 26 | hyperblog.de | 2 |

| 27 | ichmaglinux.de | 2 |

| 28 | beyondserenity.wordpress.com | 2 |

| 29 | skweez.net | 2 |

| 30 | blog.encodingit.ch | 2 |

| 31 | taach.wordpress.com | 2 |

| 32 | danielnoegel.de | 2 |

| 33 | ubuntu-blog.at | 1 |

| 34 | fernmannblog.wordpress.com | 1 |

| 35 | erbenux.com | 1 |

| 36 | loggn.de | 1 |

| 37 | datenteiler.de | 1 |

| 38 | disfunctions.de | 1 |

| 39 | blog.nlinux.org | 1 |

| 40 | blog.root1024.ch | 1 |

| 41 | noqqe.de | 1 |

| 42 | oyox.de | 1 |

| 43 | produnis.de | 1 |

| 44 | shutter-speed.ch | 1 |

| 45 | aboettger.wordpress.com | 1 |

Update: Die Statistik wird aus dem Planeten von ubuntuusers.de meinerseits entfernt. Die Statistik wird weiterhin hier auf picomol.de veröffentlicht. Wer will, kann sich auch den Feed dazu (rechts in der Sidebar) abonnieren. Gründe für die Umstellung: Siehe Kommentare.

Happy New Year ¶

Wieder ist ein Jahr vergangen und ich darf in unserem Blog dieses Jahr mit dem ersten Artikel beginnen.

happy new year

Wir wünschen euch allen ein tolles und erfolgreiches 2011.

Wir Blogschreiber und Community-Worker schreiten in ein weiteres ubuntu-Jahr ein. Ich habe mal als kleiner Zeitvertreib eine Spezial-Edition ubuntu-cube erstellt. Die Schnittmuster können hier herunter geladen werden.

Ähnliche Artikel

IMAP sicher über Android ¶

Bei Android ist ja Standardmäßig kein CACert im Zertifikatsmanager als Root-CA hinterlegt.

Bei vielen Webdiensten ist ein Verzicht auf ordentliche HTTPS-Sicherheit vielleicht noch akzeptabel, spätestens bei Mails auf dem eigenen Server aber vollkommen inakzeptabel!

Man hat nun verschiedene Möglichkeiten das Problem zu lösen:

- CACert Root Certificate in den Zertifikatsmanager importieren: Umständlich

- VPN verwenden: Möglich

- IMAP über SSH mit ConnectBot tunneln: Einfach

Man richtet sich ConnectBot ganz normal, wie jeden anderen SSH Clienten ein. Ich selbst bevorzuge ein Passwortloses Login über das integriert Public Key Verfahren welche mit einer Passphrase geschützt sind.

Im nächsten Schritt baut man den Tunnel auf, hierzu einfach auf die Verbindung im ConnectBot gehen (langer Druck mit dem Finger) und dann die Portforwardings bearbeiten, folgende benötigen wir für IMAP und SSH:

- SMTP von 1125 auf 127.0.0.1:25

- IMAP von 1143 auf 127.0.0.1:143

Sobald man jetzt eine Verbindung zu diesem Host aufbaut wird automatisch auch die Portweiterleitung aktiviert. Im Mailclient wird jetzt immer 127.0.0.1 (alternativ auch gerne localhost) als Server verwendet, der Port für IMAP ist dann die 1143 und für SMTP nimmt man 1125. Die Verbindung zum Server ist aber nicht Verschlüsselt, das übernimmt ja der gute alte ConnectBot für uns. Ob man für den Postausgangssserver (SMTP) ein Passwort benötigt kommt auf die Konfiguration des Mailservers an, oft benötigt man kein Login wenn man über SSH zugreift, da es sich dann um eine lokale Verbindung hat die meistens in der my_networks vom Postfix schon erlaubt ist.

Abgesehen davon kann man den Mailclient wie gewohnt verwenden und konfigurieren, einen Nachteil möchte ich aber nicht verschweigen: Automatische Mailchecks oder Aktionen die ausgeführt werden wenn kein ConnectBot im Hintergrund läuft funktionieren mit dieser Lösung natürlich nicht. Wird dies benötigt muss man also auf den umständlichen Weg das CACert Certificate importieren.

Schöner fände ich es wenn man Root-CAs einfacher importieren könnte, und nicht dieses umständlichen Weg gehen müsste, der noch dazu Root Rechte erfordert! Leider kann Android auch kein OpenVPN ohne Root, so macht das mit einem VPN natürlich auch keinen Spaß :-(

IMAP sicher über Android ¶

Bei Android ist ja Standardmäßig kein CACert im Zertifikatsmanager als Root-CA hinterlegt.

Bei vielen Webdiensten ist ein Verzicht auf ordentliche HTTPS-Sicherheit vielleicht noch akzeptabel, spätestens bei Mails auf dem eigenen Server aber vollkommen inakzeptabel!

Man hat nun verschiedene Möglichkeiten das Problem zu lösen:

- CACert Root Certificate in den Zertifikatsmanager importieren: Umständlich

- VPN verwenden: Möglich

- IMAP über SSH mit ConnectBot tunneln: Einfach

Man richtet sich ConnectBot ganz normal, wie jeden anderen SSH Clienten ein. Ich selbst bevorzuge ein Passwortloses Login über das integriert Public Key Verfahren welche mit einer Passphrase geschützt sind.

Im nächsten Schritt baut man den Tunnel auf, hierzu einfach auf die Verbindung im ConnectBot gehen (langer Druck mit dem Finger) und dann die Portforwardings bearbeiten, folgende benötigen wir für IMAP und SSH:

- SMTP von 1125 auf 127.0.0.1:25

- IMAP von 1143 auf 127.0.0.1:143

Sobald man jetzt eine Verbindung zu diesem Host aufbaut wird automatisch auch die Portweiterleitung aktiviert. Im Mailclient wird jetzt immer 127.0.0.1 (alternativ auch gerne localhost) als Server verwendet, der Port für IMAP ist dann die 1143 und für SMTP nimmt man 1125. Die Verbindung zum Server ist aber nicht Verschlüsselt, das übernimmt ja der gute alte ConnectBot für uns. Ob man für den Postausgangssserver (SMTP) ein Passwort benötigt kommt auf die Konfiguration des Mailservers an, oft benötigt man kein Login wenn man über SSH zugreift, da es sich dann um eine lokale Verbindung hat die meistens in der my_networks vom Postfix schon erlaubt ist.

Abgesehen davon kann man den Mailclient wie gewohnt verwenden und konfigurieren, einen Nachteil möchte ich aber nicht verschweigen: Automatische Mailchecks oder Aktionen die ausgeführt werden wenn kein ConnectBot im Hintergrund läuft funktionieren mit dieser Lösung natürlich nicht. Wird dies benötigt muss man also auf den umständlichen Weg das CACert Certificate importieren.

Schöner fände ich es wenn man Root-CAs einfacher importieren könnte, und nicht dieses umständlichen Weg gehen müsste, der noch dazu Root Rechte erfordert! Leider kann Android auch kein OpenVPN ohne Root, so macht das mit einem VPN natürlich auch keinen Spaß :-(

Wallpaper-Kalender Januar ¶

Beim Smashing Magazine gibt es ja bekannter Weise immer wieder interessante Wallpaper mit Kalendern für den aktuellen Monat. Gerade für den Januar 2011 sind wieder mal ein paar dabei, die mir richtig gut gefallen. Insgesamt 65 Stück werden hier vorgestellt, da sollte also für jeden etwas dabei sein. Das gute: die Hintergründe gibt es für viele verschiedene Auflösungen und sowohl mit als auch ohne Kalender. Hier meine 5 Favoriten, allerdings ohne Kalender.

On the ground

Treelight

Purple Dze

Get started with drupal 7

Another Chance

31. Dezember 2010

Top 5 Artikel in 2010 ¶

Ok, eigentlich wollte ich keinen Jahresrückblick veröffentlichen, aber extra für die Leser des Ubuntuusers-Planeten habe ich doch nochmal die Top 5 Blog-Posts des letzten Jahres zusammengestellt. Ich gehe einfach davon aus, dass die meisten Ubuntuusers-Mitglieder diese Posts eh nicht kennen.

- Ubuntu-Linux 10.04 auf dem Laptop: Optimieren

- Ubuntu-Linux 10.04 auf dem Laptop: Installieren

- Ubuntu-Linux 10.04 auf dem Laptop: Programme

- Ubuntu App des Tages: Preload

- Linux-User sind Raubkopierer

In diesem Sinne wünsche ich euch allen eine frohes und spannendes neues Jahr 2011.

Verlangen³ ¶

Ich halte derzeit ausschau nach einem geeigneten Nachfolger für mein Nokia E71.

Ein iPhone will ich nicht, was man sich sicherlich denken kann. Auch wenn ich mal kurz darüber nachgedacht habe. Was mich selbst verwundert hat, wenn ich ehrlich bin.

Ich bin aber derzeit bei den folgenden Alternativen stehen geblieben: Desire, Desire Z oder Desire HD. Auch das warten auf das Nexus S habe ich in Erwägung gezogen. Allerdings stellt sich mir die Frage, warum ich dieses Handy kaufen sollte, das “nur” 16GB internen Speicher besitzt und keinen SD-Slot hat? Immerhin ein Fakt, den ich bei Apple anprangere.

Neulich konnte ich das Desire von @P2063 mal richtig ausprobieren konnte, also mit Market und Anwendungen installieren und so, was das Nerd-Herz begehrt eben. Und da für mich zentraler Bestandteil der Handynutzung ein SSH-Zugang mit Screen und irssi ist, ist natürlich ein entsprechender Client vonnöten. Platzhirsch unter den Android-SSH-Clients scheint ConnectBot zu sein. Davon gibt es auch eine spezielle Version zur Nutzung mit irssi. Channel wechseln scheint mir mit der “normalen” Version von ConnectBot nicht zu gehen, ich habe keinen Alt-Key-Modifier gefunden… Der war gut versteckt und überzeugt mich immer noch nicht. Vor allem, weil das Desire HD und auch das Nexus S-Referenzdesign für Gingerbread über keinen Trackball oder ein Trackpad oder wie auch immer der Nippel da heisst, verfügen.

Und dann, als ich mir AndChat mal genauer ansah, stand auf der Seite etwas von “Works with Irssi proxy, ZNC, Bip, psyBNC, Miau and sBNC (if it works for you with another bnc, lemme know)“.

Was ein irssi-Proxy ist, wusste ich bis etwa 10 Minuten später nicht. Aber im Endeffekt ist das ein geniales Konzept, das ich mittlerweile auch mal gerne am Desktop zuhause benutze (X-Chat). Nur stellen sich mir folgende Fragen:

- Wie bekomm ich den Proxy über SSL/TLS ans laufen?

- Kann ich AndChat sagen, dass es eine SSHVerbindung aufbauen soll?

oder: kann AndChat mit SOCKS-Proxies? - oder: Kann ich aus ConnectBot heraus eine Anwendung starten?

Hat da jemand Informationen oder Vorschläge für mich?

Das Silvesterupdate für Invertika ¶

Neben diesem gibt es nun auch in einem der Wohnhäuser ein geheimnisvolles Bild. Was sich wohl dahinter verbergen mag? Für alle die Invertika nicht kennen, es handelt sich dabei um ein freies (unter GPL stehendes) Onlinerollenspiel. Dabei gibt es Clients für Linux und Windows. Das Spiel läuft dabei auch auf schwächeren Rechnern. Zu finden ist das Spiel unter http://invertika.org. Viel Spaß beim Feuerwerk und einen guten Rutsch wünsche ich, sowie das gesamte Invertika Team

Das Silvesterupdate für Invertika ¶

Das neue Jahr kündigt sich langsam an und das geht auch an Invertika nicht spurlos vorbei. Neben einigen behobenen Fehler erwartet euch auf dem Marktplatz der Feuerwerker.

Neben diesem gibt es nun auch in einem der Wohnhäuser ein geheimnisvolles Bild. Was sich wohl dahinter verbergen mag? Für alle die Invertika nicht kennen, es handelt sich dabei um ein freies (unter GPL stehendes) Onlinerollenspiel. Dabei gibt es Clients für Linux und Windows. Das Spiel läuft dabei auch auf schwächeren Rechnern. Zu finden ist das Spiel unter http://invertika.org. Viel Spaß beim Feuerwerk und einen guten Rutsch wünsche ich, sowie das gesamte Invertika Team ![]()

by

by