Da blätter ich aus Langeweile im aktuellen Katalog von Pearl und stoße hier auf dieses gigantische Schnäppchen.

Da blätter ich aus Langeweile im aktuellen Katalog von Pearl und stoße hier auf dieses gigantische Schnäppchen.

Da versucht Pearl doch glatt eine fast 3 Jahre alte Ubuntu Version 8.04 (steht für Veröffentlichung April 2008) statt für 39,95 Euro für 4,90 Euro also super Angebot zu verkaufen. Hierbei ist man auch noch so dreist und verwendet als Überschrift “Das meistgenutzte Betriebsystem in neuster Version”.

Ich dachte erst an einen Druckfehler, aber das Angebot ist auch im Internet zu finden (www.pearl.de/a-KS584-3611.shtml)

Ich dachte erst an einen Druckfehler, aber das Angebot ist auch im Internet zu finden (www.pearl.de/a-KS584-3611.shtml)

Im Moment kann man über Ubuntu die aktuelle Version 10.10 beziehen und die neue Version 11.04 mit dem Codenamen “Natty Narwhal” erscheint am 28. April 2011.

Ich glaube jedoch nicht, dass Pearl damit allzuviel Erfolg haben wird, da ja normalerweise jedem bekannt ist, dass Ubuntu kostenlos erhältlich ist. Einfach herunterladen und auf CD brennen oder über einen USB-Stick installieren (www.ubuntu.com/desktop/get-ubuntu/download)

Verfügt man nur über eine langsame Internetverbindung, kann man sich über Ubuntu.com auch kostenlos eine CD zusenden lassen. Hierbei muss man jedoch mit einer Lieferzeit von 6 Wochen rechnen.

Da sag ich doch nur ….. Ich hab n Glas voll Dreeeck! ….

Klar soweit?

Euer RSB

30. Januar 2011

Ostereier obwohl es nicht Ostern ist ¶

Die folgenden “Eastereggs” lassen sich im Linux-Alltag finden und falls du auch noch ein paar Eastereggs kennst, würde ich die gerne hören… ![]()

YouTube:

Snake auf Youtube spielen ->

1.) Video bei 0:00 anhalten

2.) Pfeiltaste nach Links drücken

3.) danach zusätzlich Pfeiltaste kurz nach Oben drücken

4.) Vorsicht, das Spiel geht sofort los… ![]()

Telnet:

… ich verrate mal nichts ![]()

telnet towel.blinkenlights.nl

telnet towel.blinkenlights.nl 666

Google:

In meiner “Feature-Liste” von Google fehlt noch einiges… ![]()

- suche nach ASCII-Art und dann achte auf das Google-Logo -> http://www.google.com/search?q=ascii+art

- auch wenn ich das schon einmal erwähnt habe -> www.google.com/bsd | www.google.com/linux | www.google.com/microsoft

- einfach einmal auf “Insert Coin” klicken und spielen -> http://www.google.com/pacman/

- folgendes bei Google eingeben ![]() -> answer to life, the universe and everything

-> answer to life, the universe and everything

aptitude:

Ich habe vor einiger Zeit bereits über “aptitude“ berichtet, hier noch ein paar Features…

aptitude moo

aptitude -v moo

aptitude -vv moo

aptitude -vvv moo

aptitude -vvvv moo

aptitude -vvvvv moo

Die Ausgabe der Befehle spare ich mir, will dir ja nicht den Spaß verderben… ![]()

Zudem ist unter der aptitude-Hilfe noch ein Osterei zu finden:

aptitude -h | tail -n 1

Außerdem ist noch ein Feature in aptitude eingebaut -> Minesweeper

aptitude

<Strg>+t

Vim:

Auch in meiner umfangreichen “vim“-Sammlung fehlt ein entscheidender Befehl:

:help 42

:Ni!

wget:

wget -S http://wordpress.com -O- 2>&1 | grep hacker

Gnome:

Unter GNOME-Desktop -> Eingabeaufforderung (Alt + F2) -> und folgendes eingeben ->

“free the fish” -> kleiner schwimmender Fisch auf dem Desktop (klick auf den Fisch und versuche ihn zu verscheuchen…) ![]()

“gegls from outer space” -> GEGLs from Outer Space

Firefox:

Folgendes bei Firefox in der Adresszeile eingeben. ![]()

about:robots

about:mozilla

Debian / Ubuntu etc.:

… um das “Fake-Release” anzuzeigen, muss man in der Konsole den folgenden Befehl eingeben, klappt auch bei Ubuntu! ![]()

zgrep "The.*Release" /usr/share/doc/dpkg/changelog.Debian.gz

zcat /usr/share/doc/linux-image-`uname -r`/changelog.Debian.gz | egrep -e "Release"

… und hier noch ein Befehl der generell unter Linux funktionieren sollte. ->

ddate

Arch Linux: (pacman)

In der Datei /etc/pacman.conf im Bereich unter [options] fügen wir ILoveCandy ein… und schon haben wir eine neue Folgschrittsanzeigt bei pacman… ![]()

Ähnliche Blog-Einträge

Android 3 – Honeycomb ¶

Es ist soweit, das neue Android 3 mit dem Namen Honeycomb kommt.

In den letzten Tagen ist das Preview für das SDK vom Android 3 erschienen. Der offizielle Start wird sich in kürze ankündigen und dann gehts auch schon los mit den Geräte-Hersteller. Die Hersteller sind natürlich schon in den Startlöchern und wie erwartet wird Honeycomb sich vermehrt den Tablet Geräten widmen. Hier aber der Reihe nach.

Preview

Das Preview ist für uns Developer für das SDK erschienen. Im AVD Manager kann man das Preview downloaden und installieren. Nach der Installation steht dann das Android 3 im Emulator zur Verfügung. Wie man das SDK und die verschiedenen Plattformen nutzen kann, habe ich in den letzten Artikeln beschrieben. Das Preview ist noch nicht ganz stabil und es läuft eher langsam. Schon bei der Erstellung des AVD’s ist klar wohin die Reise gehen wird. Der Bildschirm kommt mit einer Auflösung von 1280×800 Pixel und wird wohl zukünftig für die Tablet Geräte gedacht sein.

Erster Eindruck

Mein erster Eindruck ist sehr positiv. Die Oberfläche hat ein neues Layout erhalten. Das Bedienerkonzept hat sich verändert und sich den Tablet Geräten angepasst. Eine Art Hauptleiste befindet sich am unteren Rand. Dort werden die wichtigsten Informationen angezeigt. Unten links befinden sich die Navigations-Buttons. Open rechts kann man mit dem Button + die Übersicht über alle Tabs und weitere Elemente einblenden lassen.

Einstellungen

Das Menü für die Einstellungen ist sehr übersichtlich angelegt. Natürlich hat man bei einem Tablet mehr Platz und somit weitere Möglichkeiten der Darstellung als Beispielsweise bei einem Smart-Phone. Die Übersicht der Menüs sind somit einfacher und übersichtlicher. Schon implementiert sind z.B. die Einstellungen für WLAN, Blauzahn, VPN und Mobilfunknetze.

Die Bedienung

Als erstes fällt auf, dass die Bedienung wirklich neu sein wird. Man hat sich aber schnell an das Konzept gewöhnt und findet sich sehr schnell auf der Oberfläche zurecht. Wie immer muss man neue Symbole erst kennen lernen und so hatte ich auch ein wenig Mühe den Home-Button zu finden. Bei der Preview sind noch nicht viele Apps dabei, daher kann man über die Bedienung noch nicht sehr viel erzählen. Was auffällt ist der Browser, dieser sieht nun aus wie ein “richtiger” Browser und hat sogar eine Art Tab-Funktion (ist man sich ja mitlerweile gewohnt).

Fazit

Das Android 3 macht einen guten Eindruck wenn es um die Benutzung für Tablet Geräte geht. Sollte das System noch stabiler und schneller laufen, müssen sich die Apfel Geräte warm anziehen.

Ähnliche Artikel

29. Januar 2011

Dukto R4 released ¶

Dukto ist heute in der Version R4 veröffentlicht worden. Dukto ist ein kleines Programm um Dateien im LAN Betriebssystem übergreifend (Linux, Windows, MacOSX und Symbian) zu verteilen (siehe Artikel Dukto).

Die neue Version erlaubt unter Anderem das senden kompletter Ordner von Symbian aus und die Geschwindigkeitsprobleme unter Windows wurden beseitigt, weitere Änderungen sind im msec.it/blog zu finden.

Luzerner Schulen setzen auf OpenOffice.org ¶

Luzern, Schweiz | Die Print-Ausgabe der Luzerner Zeitung hat diese Woche berichtet, dass die Schulen der Stadt Luzern dank dem Einsatz der freien Büro-Suite OpenOffice.org pro Jahr 100’000 Franken (rund 78’000 €) einsparen.

OpenOffice ist mehr als nur ein Word- und Excel-Ersatz.

“Nachdem wir uns ursprünglich aus finanziellen Gründen für OpenOffice entschieden haben, stellten wir schnell fest, dass es vieles kann, was Microsoft Office auch anbietet. OpenOffice ist nicht nur kostenlos, das Produkt ist absolut zuverlässig”, so Thomas Steimen, IT-Leiter der Stadtschulen Luzern.

Falls die Schüler daheim mit MS Office und in der Schule mit OpenOffice arbeiten, könnte es beim Dateiaustausch passieren, dass Formatierungen verloren gehen.

Deshalb hat die Stadt den Schülern der Volksschule USB-Sticks mit vorinstalliertem OpenOffice verteilt und appelliert nun an alle Eltern, die MS Office-Alternative auch zu Hause einzusetzen.

In der kleinen Luzerner Gemeinde Eschenbach wollte man den Informatikunterricht in der Schule ebenfalls weniger produkt- und mehr anwendungsbezogen gestalten.

“Jetzt können alle Schüler dasselbe System verwenden, ohne dass es sie etwas kostet.”, sagt René Brun, Schulleiter von Eschenbach. Da OpenOffice freie Software ist, können die Schüler es kostenlos und legal auf jedem beliebigen Computer installieren, auch auf ihrem eigenen.

Auch wenn die 600 Kinder am Arbeitsplatz eines Tages mit Microsoft-Produkten arbeiten müssen, wird das für sie kein Problem sein.

René Brun dazu: “Die Benutzeroberfläche und die Programmsymbole sehen in OpenOffice fast genau gleich aus, wie wir es von anderen Officepaketen kennen. Deshalb haben sich die Schüler mit der neuen Software sofort zurecht gefunden”.

Gemäss Brun spart die Schule Eschenbach dank OpenOffice jährlich 10’000 Franken (~7’800 €) , was für eine kleine Gemeinde mit rund 3000 Einwohnern ganz beachtlich ist.

OpenOffice.org Switzerland äussert sich zum Zeitungsartikel

Daniel Stoni, Präsident des Vereins OpenOffice.org Switzerland, hat bereits zum Zeitungsartikel des Redakteurs Martin Messmer geäussert.

Er bedankt sich bei Messmer für den informativen und ausführlichen Bericht über OpenOffice.

Schade findet Stoni jedoch, dass am Tag zuvor mit LibreOffice sozusagen der freie Nachfolger von OpenOffice.org erschienen ist und dies im Artikel nicht erwähnt wird.

LibreOffice ist der "inoffizielle Nachfolger" von OpenOffice.

Desweiteren beschreibt er den Ausdruck “Gratissoftware” als heikel, da viele proprietäre Programme, welche im Internet gratis angeboten werden auch Einschränkungen mit sich bringen. Er hätte den Begriff “Freie Software” für angemessener gehalten, da diese dem Benutzer und nicht zuletzt auch den Entwicklern alle Freiheiten gibt.

Links:

de.openoffice.org

de.libreoffice.org

Wichtiger Hinweis: OpenOffice.org bzw. dessen “Nachfolger” LibreOffice können kostenlos und legal für die Betriebssysteme Linux, Mac OS X und Windows heruntergeladen werden. Bitte laden Sie das Programm ausschliesslich von der offiziellen Projekt-Homepage herunter (de.openoffice.org bzw. de.libreoffice.org).

Grund: Im Internet gibt es betrügerische Abo-Abzockerportale, welche Ihnen die Software zwar kostenlos anbieten, jedoch im Kleingedruckten einen kostenpflichtigen Download-Abovertrag abschliessen. Deswegen ist es wichtig, Software immer von der Original-Seite herunterzuladen, dann kann so etwas nicht passieren.

TomTom Navis mit Ubuntu verwalten ¶

TomTom stellt zur Verwaltung seiner Navigationsgeräte die „TomTom HOME“ Software zur Verfügung, diese gibt es allerdings nur für Windows und MacOS. Soll das Navi ohne extra Windows Installation verwaltet werden, muss auf andere Programme zurückgegriffen werden. Zwei Open Source alternativen sind „jTomTom“ und „pyTomTom„, wobei beide nicht über die komplette Funktionalität von TomTom HOME verfügen.

„jTomTom“ ermöglicht die Aktualisierung der „QuickFix“ Informationen, welche es dem Navi ermöglichen die Satelliten schneller zu finden, wenn diese regelmäßig aktualisiert werden.

Außerdem ist es mit „jTomTom“ möglich Informationen über Radarfallen in Form von POIs auf das Navi zu übertragen (allerdings sind hierfür nur Daten für Spanien und Frankreich verfügbar…) und Backups in Form von .iso-Dateien zu erstellen.

„jTomTom“ ist in Java geschrieben und muss nicht installiert werden. Nach dem Download der „jTomtom.jar“ Datei, wird diese ausführbar gemacht (Rechtsklick -> „Eigenschaften“ -> „Zugriffsrechte“ und den Haken bei „Datei als Programm ausführen“ setzten) und dann durch einem Rechtsklick „Mit OpenJDK Java 6 Runtime öffnen“ geöffnet. Alternativ wird es mit

java -jar jTomtom.jar

über die Konsole geöffnet.

Eine Liste der mit „jTomTom“ kompatiblen Geräte befindet sich auf http://jtomtom.sourceforge.net/index.php?page=doc-compatibilite.

„pyTomTom“ erlaubt auch die Aktualisierung der „QuickFix“ Informationen und das erstellen von Backups (im Gegensatz zu „jTomTom“ findet sich hier auch eine „Wiederherstellen“ Option). Außerdem können mit „pyTomTom“ POIs auf das Navi kopiert werden, diese im Internet zu finden und in die pyTomTom Datenbank einzuspielen bleibt allerdings den BenutzerInnnen überlassen (Ich selbst habe keine Seite finden können auf der man POIs unkompliziert, ohne vorherige Anmeldung bekommt, vielleicht kennt jemand eine gute Seite…).

„pyTomTom“ gibt es als .deb Paket, dieses kann einfach durch einen Doppelklick mit dem „Ubuntu Software Center“ installiert werden. Dann befindet es sich unter „Anwendungen“ -> „Zubehör“ -> „pyTOMTOM„.

Nach dem ersten Start muss der Einhängepunkt und das Modell angegeben werden. Nach einen Neustart sind dann alle Funktionen verfügbar. Eine Liste der kompatiblen Geräte befindet sich im Wiki von „pyTomTom“.

Über die Möglichkeit Kartenupdates und Kartenkorrekturen einzuspielen verfügen beide Programme nicht, wer diese Funktionen braucht, ist wohl weiterhin auf eine Windowsinstallation/MacOSinstalliation angewiesen bzw. muss hoffen, dass TomTom vielleicht doch noch irgendwann eine Linuxversion der HOME Software anbietet.

Meine Meinung zu LibreOffice und Unity ¶

Nachdem Ubuntu 11.04 im April dieses Jahres mit LibreOffice und Unity ausgeliefert wird, möchte ich mich hier kurz dazu äussern.

Die Entscheidung in Zukunft auf LibreOffice zu setzen – halte ich – wie die meisten Ubuntu-User für sinnvoll. Immerhin hat sich Oracle seit der Übernahme scheinbar nicht gerade Mühe gegeben das OpenOffice.org-Projekt zu unterstützen. Canonical Ltd. arbeitet zwar auch in einigen Bereichen eher in Richtung kommerzieller Interessen (Ubuntu One, Landscape, …) und weniger in Richtung Quelloffenheit, doch das Unternehmen scheint die Entscheidungen meist auch sorgfältig abzuwiegen um den privaten Ubuntu-User nicht zu sehr abzuschrecken oder zu verärgern.

LibreOffice hat zahlreiche und nahmhafte Unterstützer, obwohl erst vor kurzem die erste stabile Version erschienen ist.

Zu Unity kann ich – auf Grund mangelnder Erfahrung – noch kaum etwas sagen. Ein größerer Umbau der Benutzeroberfläche ist immer eine etwas riskante Sache, da der Mensch Gewohnheiten nachgeht – der Anwender und der Administrator müssen also damit erstmal klar kommen. Es hängt letztlich von der Umsetzung ab, welche Natty Narwhal nach der Veröffentlichung beinhaltet. Ich schätze die Chancen, dass Benutzer wegen Unity abwandern eher gering ein. Zur Sicherheit sollte allerdings auf jeden Fall ein alternatives Ubuntu mit GNOME-Oberfläche bereitgestellt werden.

Keine ähnlichen Posts

FTP mit dem Midnight Commander ¶

Da war ich nun auf der Konsole und wollte mich bequem mit einem FTP Server verbinden um einige Daten herunterzuladen. Nach einigem Überlegungen fiel mir ein das der Midnight Commander (mc) dies doch beherscht. Nur die Syntax muss man sich merken:

/#ftp:seeseekey:geheim@seeseekey.net

Sprich Nutzername, Passwort und dann der entsprechende Server. Danach kann man problemlos Dateien von dem FTP kopieren.

Weitere Informationen gibt es unter:

http://wiki.ubuntuusers.de/Dateimanager

FTP mit dem Midnight Commander ¶

/#ftp:seeseekey:geheim@seeseekey.netSprich Nutzername, Passwort und dann der entsprechende Server. Danach kann man problemlos Dateien von dem FTP kopieren.

Weitere Informationen gibt es unter:

http://wiki.ubuntuusers.de/Dateimanager

Interview mit Entequak über open-slx ¶

Das Suseportal unter http://community.open-slx.de/ läuft mit Inyoka - genau der Software die ubuntuusers betreibt, laut Absprachen schon lange frei sein sollte, es aber nicht ist. Grund genug, mit EnTeQuAk vom Webteam ein Interview zu führen und so ein bisschen Licht in diesen recht ungewöhnlichen Vorgang zu bringen.

Onli: Hallo Christopher. Stelle dich doch bitte erst einmal vor.

CG: Mein Name ist Christopher Grebs, derzeit bin ich 20 Jahre alt, seit Ende 2007 im Webteam von ubuntuusers.de und seit Ende 2008 Webteamleiter. Nebenher arbeite ich an vielen freien Projekten wie z.B. Pocoo mit und engagiere mich in verschiedenen Vereinen.

Onli: Das open-slx-Portal ist ja erst diese Woche mit eurer Hilfe gestartet.

Wie und wann kam denn der initiale Kontakt zwischen der Firma open-slx und dem Team von ubuntuusers zustande?

CG: open-slx, in Person Rupert Horstkötter, hat bereits in der Vergangenheit Kontakt mit dem Wikiteam von ubuntuusers.de gehabt für eine eventuelle Kooperation, damals jedoch mit Bedacht die Artikel in das opensuse.org Wiki zu integrieren. Daraus ist aus verschiedenen Gründen nichts geworden, also startete open-slx sein eigenes Portal und hat gegen Ende Juni 2010 Kontakt zum Webteam aufgenommen für eine Kooperation im Bereich der Portalsoftware - Inyoka.

Daraufhin gab es viele, ausgiebige Diskussionen innerhalb des Teams und letztenendes bin ich dann mit in das open-slx Team gekommen um es bei dem Aufbau des Portals zu unterstützen. Dies war dann der perfekte Zeitpunkt um zu testen ob Inyoka im Stande war auch für andere Systeme lauffähig gemacht zu werden und es stellte sich halt heraus das es das nicht war, zu viele ubuntuusers-spezifische Anpassungen, zuviele unkonfigurierbare (Hardcoded) Stellen im Code... da stand dann viel Arbeit vor mir/uns, aber es hat sich gelohnt.

Onli: Meinst du mit open-slx-Team das Team vermutlich ehrenamtlicher Mitarbeiter, die das Portal betreuen, oder bist du nun ein bezahlter Mitarbeiter der Firma?

CG: Es gibt sowohl angestellte Mitarbeiter im Team als auch ehrenamtliche, jedoch geht die Arbeit auch für die Mitarbeiter oftmals ins ehrenamtliche über.

Onli: Ihr musstet also Inyoka anpassen, damit es verwendet werden konnte für das andere Portal. Habt ihr dafür Hilfe eines Programmierers von open-slx bekommen, oder wie sah die Kooperation sonst aus?

CG: Ich wurde von open-slx Teilzeit eingestellt um die entsprechenden Änderungen einzupflegen. Bevor die Frage gleich aufkommt: open-slx behält keine Rechte am Quellcode von Inyoka, diese bleiben komplett beim Autor und somit beim Projekt an sich.

Onli: Das heißt, es gibt auch keine Absprachen wie "Inyoka wird nicht vor 2012 veröffentlicht"?

CG: Richtig. Was aus Inyoka wird ist und bleibt Entscheidung des ubuntuusers.de-Webteams beziehungsweise der entsprechenden am Code beteiligten Autoren. Wie im Neujahrsartikel auf Ikhaya angekündigt wird es dieses Jahr ein paar Dinge geben die viele Leute glücklich stimmen wird und daran werden wir auch festhalten.

Onli: Nochmal zum Portal selbst. Ich stelle mir vor, dass die Diskussion ziemlich lebhaft war. Auf der einen Seite ist open-slx eine kommerzielle Firma, die mit dem Portal wohl vornehmlich kommerzielle Interessen verfolgt, und mir ist noch nicht klar, warum genau das Team dieser Firma helfen wollte. Es müssen gewichtige Argumente auf der anderen Seite gestanden haben. Welche waren das denn?

CG: Nun, das Diskussionen bei uns im Team immer lebhaft sind kennst du ja aus deiner aktiven Zeit. Und dass wir sehr stur gegenüber kommerziellen Angeboten eingestellt sind, auch von daher haben wir uns genug Gedanken gemacht. Jedoch gibt es hier zwei total unterschiedliche Punkte die man beachten muss: Einmal die Zusammenarbeit im Bereich des Wikis und die Zusammenarbeit mit dem Webteam.

Die Inhalte vom Wiki können bekanntlich von jedem verwendet werden, solange die entsprechenden Richtlinie der von uns verwendeten Lizenzen erfüllt werden. Von daher war hier kaum Diskussionsstoff, man brauchte halt nur warten bis das finale Produkt rauskommt.

Die Zusammenarbeit mit dem Webteam war schon eher diskussionswürdig, jedoch haben wir uns hier auch recht schnell geeinigt. Denn, klar ist open-slx eine Firma die Geld verdienen möchte. Doch haben auf der einen Seite wir als Webteam und Autoren von Inyoka jegliche kommerziellen Benutzungen von Inyoka untersagt, auf der anderen Seite hat open-slx ohnehin vor die kommerziellen Angebote klar von der Community zu trennen.

Man braucht nicht immer gewichtige Argumente. Uns waren die kleinen Dinge wichtiger, viel wichtiger war allerdings auch das hinter der Plattform ein Plan gestanden hat. Somit wissen wir auch worauf wir uns vorab einlassen und was am Ende dabei raus kommt.

Onli: Bleibt die Frage, inwiefern man bei sowas kommerziell abtrennen kann.

Sehe ich das richtig: Im Grunde hatte ubuntuusers nicht wirklich einen konkreten Nutzen von der Kooperation, das Webteam dagegen hatte Hilfe bei der Abstrahierung von Inyoka - oder auch das nur indirekt durch deine Einstellung zu diesem Zweck?

CG: Währenddessen das ganze stattgefunden hat, ja – da hast du recht. Wir gucken aber nicht nur in eine Richtung sondern in mehrere und sind am Planen wie man am besten beide Plattformen zukunftsträchtig verheiraten kann um die Arbeitskraft beider Communities effizient zu nutzen. Zumindest im Wiki ist das möglich und wir streben halt einfach an, dass es zentrale Inhalte gibt, die für Distributionen entsprechend angepasst sind. Die zentralen Inhalte und Grundlagenartikel sind ja für Ubuntu und openSUSE grundlegend gleich, daher kann man sich hier sehr gut ergänzen.

Es sind bereits einige Benutzer dabei Artikel auf beiden Seiten zu bearbeiten und zu verbessern, hier kann es nur besser werden denke ich.

Onli: Du hast jetzt Inyoka als Job angepasst, kannst also genau sagen, wie schwer diese Arbeit war. Gehen wir davon aus, ihr hättet Inyoka wie geplant schon vor einem Jahr - oder inzwischen schon früher - zur freien Software gemacht. Du bist überzeugt, dass nicht auch andere außer open-slx Interesse daran gehabt hätten, Inyoka nicht schon viel weiter wäre?

CG: Ich werde meine Glaskugel versteckt lassen. Was passiert wäre, wenn und aber… es ist einfach so und wir gehen unseren Weg. So viele Leute interessiert es anscheinend jedenfalls nicht, denn die Anzahl derer die sich ernsthaft mit uns damit auseinandergesetzt haben oder gar Hilfe angeboten haben hielt sich nicht nur in Grenzen – es war fast nicht vorhanden. Lediglich ein paar wenige Leute haben überhaupt den Weg ins IRC zu uns gefunden und näher nachgefragt.

Onli: Christopher, ich danke dir für das Gespräch.

28. Januar 2011

Natty Daily Builds immer aktuell halten ¶

Es gibt eine einfache Möglichkeit, seine Kopie des Daily Builds immer aktuell zu halten, ohne die Datei jedesmal komplett neu laden zu müssen

Für das Altualisieren der iso-Datei wird zsync bentutzt. Es hat den Vorteil, dass es die Prüfsummen der Quelldatei auf dem Server mit den Prüfsummen der eigenen Datei abgleicht. Stellt zsync dabei einen Unterschied fest, werden nur Teile der iso-Datei neugeladen. Dies verhindert, dass man jedesmal 700MB herunterladen muss, was vor allem für leute mit langsamerer Internetanbindung wie mich einen gewaltigen Vorteil darstellt. So muss man die 700MB nur einmalig herunterladen.

Daily Build herunterladen

Ich habe mir dazu ein eigenes Verzeichnis namens „natty“ angelegt. Dort habe ich die Datei dann per wget heruntergeladen (jedes andere Downloadprogramm wird auch funktionieren).

Datei aktuell halten

Die Datei muss man nun per zsync aktuell halten. Zuerst einmal zsync installieren:

sudo apt-get install zsync

Dann muss man in das Verzeichnis wechseln, in dem die iso-Datei liegt – in meinem Fall „natty“.

cd natty

Nun zsync aufrufen. Die Syntax ist:

zsync URL

URL muss durch eine der folgenden URLs ersetzt werden:

http://cdimage.ubuntu.com/daily/current/natty-alternate-amd64+mac.iso.zsync

http://cdimage.ubuntu.com/daily/current/natty-alternate-amd64.iso.zsync

http://cdimage.ubuntu.com/daily/current/natty-alternate-i386.iso.zsync

http://cdimage.ubuntu.com/daily/current/natty-alternate-powerpc+ps3.iso.zsync

http://cdimage.ubuntu.com/daily/current/natty-alternate-powerpc.iso.zsync

Skripte

Hier mein Ursprüngliches Skript:

#!/bin/bash

zsync http://cdimage.ubuntu.com/daily/current/natty-alternate-amd64.iso.zsync

Und so mit einer kleinen Rückmeldung an den User; teilweise auch komfortabler, da man es direkt aus dem Home-Verzeichnis starten kann.

#!/bin/bash

echo „Starte Natty 32-bit update“

zsync http://cdimage.ubuntu.com/daily/current/natty-alternate-i386.iso.zsync

echo „Fertig!“

echo „Starte Natty 64-bit update“

zsync http://cdimage.ubuntu.com/daily/current/natty-alternate-amd64.iso.zsync

echo „Fertig!“

Das Skript kann dann mit

chmod +x skriptname

ausführbar gemacht werden.

Tagged: 11.04, daily build, Natty, Ubuntu, ubuntuusers, zsync

1 Pixel Border virtuell verbreitert ¶

Beim Ubuntu Default Theme ist der Fensterrahmen seit einer Weile nur einen Pixel breit. Das sieht zwar gut aus, ist aber lästig, wenn man das Fenster vergrößern/verkleinern will. Man braucht manchmal 3-4 Anläufe, bis man trifft.

Das ändert sich jetzt. Der Rahmen wird wieder breiter. Aber nur “virtuell”. Optisch bleibt er einen Pixel breit. Der Trick: der Schatten wird als versteckter Rahmen verwendet.

Man sieht auf dem Screenshot die Breite des Rahmens. Das eigentliche Fenster endet am Hellgrauen Rand der Scrollbar. Der weiße Streifen markiert den äußeren Rand. Der dunkle Streifen dazwischen ist eigentlich der Schatten des Fensters. Diese Breite steht jetzt jedoch zum anklicken zur Verfügung. Diesen Rand gibt es jedoch nur seitlich und unten.

Einen Nachteil hat das ganze (bis jetzt). Wer mit Hilfe der Snap Funktion die Fenster an den Bildschirmrand anheften möchte dürfte sich über einen Zwischenraum wundern.

Ob an dem Problem gearbeitet wird kann ich derzeit noch nicht sagen, aber ich gehe mal davon aus. Ansonsten ist der verbreiterte Rahmen eine wirklich angenehme Sache. Endlich ist das Verkleinern und Vergößern von Fenstern wieder ohne Zielwasser gegen den Tatterich möglich ![]()

Das AppStream-Projekt ¶

In den letzten Tagen ging ja das AppStream-Projekt durch die (Linux-affinen) Medien. (Siehe auch den Blog-Beitrag von Picomol für eine kurze Zusammenfassung) Dem Projekt vorrausgegangen war eine Mini-Konferenz in Nürnberg, parallel zum “Bretzn”-Meeting des openSUSE/KDE Projektes, über die ich im englischen Teil dieses Blogs bereits berichtet habe. Da ich nun mit dem Listaller-Projekt ein Tool entwickle, welches Teile der im Meeting angesprochenen Probleme (leider ungenügend) abdeckt, betrifft diese Konferenz mich bzw. das Listaller-Projekt direkt. Ich wurde gefragt, ob ich auch kommen könnte, aber leider ging das bei mir terminlich nicht. Stattdessen habe ich die Entwicklung des Konzeptes vom Schreibtisch aus mitverfolgt. (Und gebe jetzt meinen Senf dazu ![]() )

)

Herausgekommen bei der Minikonferenz, bei der unter anderem Vertreter von Debian, Ubuntu, OpenSUSE, Fedora, Megeia und viele mehr anwesend waren, ist ein konkreter Aktionsplan unter dem Arbeitstitel AppStream. Aber worum geht es dabei genau? Viele News-Seiten haben das leider etwas verzerrt wieder gegeben. (Hallo, Golem!) Grob gesagt geht es darum, Software-Installationen und Software-Management unter Linux distributionsübergreifend zu verbessern.

Gleich vorweg: Die im folgenden genannten Punkte sind mitnichten statisch, es handelt sich dabei um einen groben Plan des AppStream-Projektes, welcher sich natürlich noch ändern kann.

Der wichtigste Punkt ist das distributionsübergreifende Handling von Metadaten und nutzergeneriertem Inhalt. Metadaten sind dabei z.B. Programmbeschreibungen, Symbole, Zusatzinfos oder Screenshots zu einer Anwendung. Dabei präsentiert AppStream dem Nutzer grundsätzlich Anwendungen und keine Pakete, wie das momentan noch der Fall ist. Zur Verdeutlichung hat Richard Hughes, PackageKit-Autor, dieses Architekturdiagramm angefertigt:

Die Distributionen extrahieren auf einem “Compose Server” Metadaten aus ihren Paketen (Icons/Beschreibungen etc. Allgemeine Infos über alle Anwendungen, welche im Software-Repositorium enthalten sind) und stellen diese als Paket bereit. Diese Daten werden dann – wie heute schon bei Debian/Ubuntu üblich – vom Nutzer heruntergeladen. Dabei kann jedes Repositorium ein eigenes Paket mit Metadaten bereitstellen. Alle diese Daten werden dann auf dem System des Nutzers in eine Xapian-Datenbank eingepflegt. Diese Datenbank wird nun vom für den Nutzer sichtbaren Software-Center gelesen und somit werden die Anwendungen angezeigt.

Als “Software-Center” wurde das aktuell in Ubuntu installierte “Ubuntu Software Center” (USC) gewählt. Das USC wird in SC umbenannt und auf PackageKit portiert, womit es automatisch distributionsunabhängig und auf z.B. Fedora nutzbar wird. (Auf PackageKit zu wechseln war sowieso schon lange geplant) Dies geschieht jedoch nur dann, wenn Canonical sein Copyright-Assignment für das Software-Center aufgibt, da nur so Mitarbeiter anderer Distributionen Code beisteuern können. Aktuell laufen Gespräche darüber.

Im Software-Center werden dann auch Nutzergenerierte Inhalte angezeigt, wie z.B. Bewertungen oder Kommentare. Dafür wird ein Tool entwickelt, welches Pakete zwischen den Distributionen vergleicht und gleiche Pakete erkennt. So kann Fedora dann zum Beispiel für die Anwendung im Paket “FooBar-2″ genau die Bewertung anzeigen, welche ein Debian-Nutzer zuvor der selben Anwendung, welche unter Debian jedoch im Paket “foobar-bin” enthalten ist, gegeben hat. Somit ist es möglich, Bewertungen zwischen den Distributionen zu teilen. Zudem kann so der Debian-Screenshot-Service unter screenshots.debian.net von anderen Distributionen genutzt werden. Gleichzeitig wird auch das DebTags-System von Debian für alle anderen Distributionen nutzbar. (Mit Debtags kann man einfach Pakete “taggen”, also mit Stichwörtern versehen) (Übrigens: Es scheint nicht nur so, dass viel Debian-Technik übernommen wird, es ist einfach so. (Und zeigt, wie cool Debian ist ![]() )) Als netten Nebeneffekt können in Zukunft auch Patches zwischen Distributionen einfacher geteilt werden. So kann man unter Debian über dieses “Package-Mapping” sehen, dass Fedora gerade das Paket A, welches das gleiche Modul enthält wie Debian-Paket B, gepatcht hat und dann die Initiative ergreifen und den Fedora-Patch auch unter Debian in Debian-Paket B anwenden.

)) Als netten Nebeneffekt können in Zukunft auch Patches zwischen Distributionen einfacher geteilt werden. So kann man unter Debian über dieses “Package-Mapping” sehen, dass Fedora gerade das Paket A, welches das gleiche Modul enthält wie Debian-Paket B, gepatcht hat und dann die Initiative ergreifen und den Fedora-Patch auch unter Debian in Debian-Paket B anwenden.

Alles in Allem wird dieses Projekt der gesamten Linux-Platform eine richtig tolle Infrastruktur bieten, um Software zu verwalten, zu bewerten und neue Anwendungen zu installieren. Außerdem werden die Distributionen in Zukunft noch besser zusammenarbeiten können. (Der O-Ton des Meetings war sehr positiv, die Zusammenarbeit funktioniert anscheinend hervorragend und ist definitiv produktiv)

Auch an ein einheitliches Format zur Software-Verteilung am Paketmanager vorbei wird gedacht: Da alle Listaller-Ziele mit AppStream in einer Dimension erreicht wurden, von der ich nie zu träumen gewagt habe, bleibt als einziges Listaller-Feature sein distributionsunabhängiges Installer-Format und der NewStuff-Installer. Aktuell integriere ich gerade den Listaller in PackageKit, um ihn für Distributionen einfach nutzbar zu machen. Dies bedeutet aber nicht, dass der Listaller zum einheitlichen Linux-Installer werden wird. Viele Entwickler liebäugeln auch mit einer Klik-Ähnlichen Lösung wie Glick. (Halte ich für schlecht, aber wofür diskutiert man?) Vielleicht wird aber auch ein völlig neues Format geschaffen… Fest steht, dass wenn es überhaupt jemals ein Cross-Distro-AppInstall-Format geben wird, eine Sandbox wie z.B. Arkose in jedem Fall mit dazu gehört, um die Rechte des 3rd-Party Programms genau zu kontrollieren. Aber wie gesagt, die Diskussion läuft. (Achja, um den üblichen Spruch nicht zu vergessen: Der Listaller braucht dringend Entwickler, also wer Interesse hat…! ![]() )

)

Ich halte das AppStream-Projekt für einen absoluten Meilenstein in der Geschichte der Kooperation zwischen Distributionen. Wenn der aktuelle Plan, welcher noch viel mehr Details beinhaltet, die ich hier ausgelassen habe, aufgeht, dann wird das das coolste Stück Linux-Software dieses Jahres. (vllt. mit GNOME3 und KDE4.7 zusammen ![]() )

)

Mal sehen, was in Zukunft passiert. Für Interessierte möchte ich noch auf die Wiki-Seite des Projektes auf fd.o verweisen, welche den aktuellen Stand hervorragend dokumentiert. (Auch das Video ist zu empfehlen, wenn man viel Zeit hat ![]() )

)

Audio von DVD rippen mit mplayer ¶

Ich habe hier eine Musik-DVD, von der ich die Audiospur rippen wollte. Das ganze besteht aus 2 Titeln mit mehreren Kapiteln. Das ganze sollte natürlich gleich nach Kapiteln – also nach Tracks – geschnitten werden. K9copy soll das irgendwie können, aber ffmpeg wollte da nicht mitspielen und mir nichts vernünftiges ausgeben. Als das Programm meinte, es bräuchte dafür über 6 Stunden habe ich den Spaß abgebrochen.

Realisiert habe ich das ganze dann mit mplayer und einem kurzen, kleinen Script, das mir das ganze in einer Schleife erledigt ohne dass ich jedes Kapitel mit einem extra Befehl rippen musste. Das Script ist zwar nicht besonders sexy, dennoch aber vielleicht für den einen oder anderen interessant, wenn man sowas mal schnell braucht. Das ganze sieht dann folgendermaßen aus:

#!/bin/bash for i in $(seq 1 2); do for j in $(seq 1 9); do mplayer -dumpaudio -chapter $j-$j dvd://$i mv stream.dump title$i-chapter$j.dump done done

Das i steht für die Titel auf der DVD (Beginn bei 1, Ende bei 2), das j für die einzelnen Kapitel (Beginn bei 1, Ende bei 9). Ausgegeben wird beim audiodump mit mplayer immer die Datei stream.dump. Damit diese nicht immer überschrieben wird wird diese immer umbenannt – am Einfachsten im Format mit Titel i – Kapitel j.

Um das ganze einfach zu halten ist hier nicht eingebaut, dass die 2 Teile unterschiedlich viele Kapitel haben (Teil 1 hat 9 Kapitel, Teil 2 hat 6 Kapitel). Nachdem Kapitel 6 vom zweiten Teil fertig war habe ich das Script dann einfach abgebrochen.

Ist das ganze geschafft kann man die Dateien nehmen und mit einem Konvertierungsprogramm in das gewünschte Format umwandeln. ich habe dafür Soundconverter genommen und die dump-Dateien ins ogg-Format umgewandelt. Wer das lieber auf der Kommandozeile machen will, sollte hier nachschauen. Zum richtigen Benennen der fertigen ogg-Files und zum Einfügen der Metadaten (Tags) habe ich dann EasyTAG verwendet.

Blog-Pause bis April ¶

Bloggen macht Spaß, keine Frage – aber es ist auch sehr zeitaufwendig, da ich auf gut recherchierte und inhaltlich ansprechende Artikel Wert lege. Da ich Mitte März 2011 das Abitur schreiben werde und die Zeit bis dahin immer knapper wird, habe ich mich entschlossen, bis Anfang April auf das Bloggen zu verzichten. Schule muss eben vorgehen; leider ![]() .

.

Ich möchte euch bitten, mir „treu“ zu bleiben und 321tux.de nicht aus eurem Feedreader zu werfen. Auch gibt es keinen Grund, mir auf Twitter nicht weiterhin zu folgen.

In einigen Wochen werdet ihr auf meinem Blog wieder (hoffentlich) interessante Beiträge rund um unser aller Lieblings-OS Linux und das „weltweite Netz“ finden.

Bis dahin; macht’s gut!

Janek aka JaiBee

SSH-Problem “Broken Pipe” ¶

Wenn ich mich mit Ubuntu Lucid Lynx LTS per Secure Shell auf einen entfernten Rechner verbinde, kann es passieren, dass die SSH-Verbindung nach einer Weile abgebrochen wird. Es erscheint die Meldung:

Wenn ich mich mit Ubuntu Lucid Lynx LTS per Secure Shell auf einen entfernten Rechner verbinde, kann es passieren, dass die SSH-Verbindung nach einer Weile abgebrochen wird. Es erscheint die Meldung:

Write failed: Broken pipe

Dazu kommt es, wenn über die Verbindung eine Weile lang keine Daten ausgetauscht werden. Abhilfe schafft hier ein Eintrag in die Datei /etc/ssh/ssh_config auf dem Ubuntu-Rechner (Klient):

ServerAliveInterval 60

Erhält Lucid innerhalb 60 Sekunden keine Daten durch den SSH-Server, kontaktiert der Klient den Server, um eine Antwort zu “provozieren”. Den Zeitwert von 60 Sekunden kann man durch Versuch und Irrtum individuell anpassen. Auch auf der Kommandozeile kann man bei einer einmaligen Verbindung dafür sorgen, dass die Verbindung permanent steht. Beispiel (Intervall 10 Sekunden):

ssh -o ServerAliveInterval=10 login@server

Verwandte Artikel: SSH-Tunnel, Mit scp Dateien kopieren

Bildlizenz: GNU General Public License (Für Details bitte Bild anklicken)

© 2011 by Netz 10 |

Permalink |

Tags: bash, lucid, openssh, planetuu, Secure Shell, server, shell, ssh, sshd, ubuntu

Ubuntu Kernel 2.6.32-28-generic ¶

Aus meiner Erfahrung kann ich vor dem aktuellsten Kernel (“2.6.32-28-*”) von Canonical nur warnen, wenn man einen rt2860sta-Treiber (Ra-Link-Wlan) oder Compiz via dem (seitens Ubuntu-Manager installierten) proprietären Nvidia-Treiber nutzt.

Weder das eine noch das andere funktionierte mit dem Kernel, der Ubuntu-Treiber-Manager kann auf dem Desktop keine neuen Nvidia-Treiber installieren, der Server kann das Paket linux-backports-modules-wireless-lucid-generic nicht installieren und quittiert mit einem

Die folgenden Pakete haben nicht-erfüllte Abhängigkeiten:

linux-backports-modules-wireless-lucid-generic:

Hängt ab: linux-backports-modules-compat-wireless-2.6.34-2.6.32-28-generic

ist aber nicht installierbar

E: Kaputte PaketGrund zum feiern ist das nicht gerade, wenn ich einen neuen Kernel bekomme, aber der Rest der Pakete noch nicht geschnürt ist.

Update: Das Nvidia-Problem scheint nur den 2.6.32-28-generic-pae Kernel zu betreffen. Compiz oder 4GB RAM. Diese Entscheidnung hatte ich doch schon damals, als nur der Server-Kernel mit >4GB Speicher zurechtkam…

27. Januar 2011

Ein Paketmanager für alle? ¶

Golem berichtet heute von einem Projekt, Appstream genannt, das es endlich schaffen soll, die Installationsmechanismen für Linux-Distributionen zu vereinheitlichen. Jetzt werden viele schreien, dass es schon unzählige solcher Versuche gab, das Ganze aber nie richtig funktioniert hat und man nicht schon wieder was Neues einführen sollte. Ich bin allerdings der Meinung, dass das Appstream-Konzept vielversprechend klingt.

Für die eigentliche Installation soll Packagekit verwendet werden, ein Projekt, das sich schon lange versucht, die Installation und Verwaltung von Paketen distributionsunabhängig zu machen. Ich persönlich bin sehr erfreut, dass auf bereits bestehende Projekte aufgebaut und das Rad nicht zum 100. mal neu erfunden wird. Außerdem werden die Ergebnisse des im vergangen Jahr durchgeführten Bretzn-Projektes in Appstream miteinfließen. Appstream soll in bestehende Programme, wie z.B. dem Ubuntu Software Center eingebaut werden.

Besonders interessant ist die Liste der Distributionen, die entschieden haben, beim Projekt mitzumachen. So soll neben Debian und Ubuntu, auch OpenSUSE, Mandriva/Mageia sowie Fedora/Red Hat mit an Bord sein. Nur wenn alle (wichtigen) Distributionen an einem Strang ziehen, kann aus dem Vorhaben was werden. Wir werden sehen, was aus Appstream 2011 werden wird.

Ubuntu 11.04 kommt mit “Aero Snap”-ähnlicher Funktion ¶

Windows 7-Benutzer lieben Aero Snap, eine Funktion, die es erlaubt, Fenster einfach am Desktop anordnen zu können. Zieht man zum Beispiel ein Fenster an die linke Bildschirmkante, nimmt das Fenster automatisch die halbe Bildschirmbreite und die ganze Bildschirmhöhe ein. Dadurch kann man sehr schnell zwei Fenster nebeneinander anordnen. Für Ubuntu gibt gibt es bereits seit langem Möglichkeiten, die “Aero Snap”-Funktion aus Windows 7 mit Compiz nachzuahmen. Wirklich ausgereift ist dies bis jetzt jedoch nicht. Die Möglichkeiten sind zwar irgendwie da, allerdings muss man sich diese bisweilen von Hand einrichten und erhält zum Schluss so etwas Ähnliches, aber doch nicht ganz das Selbe. Außerdem funktioniert bei mir das Alles kaum einmal fehlerfrei.

KDE kann das schon lange

Ich weiß nicht seit wann, aber KDE 4 verfügt seit mindestens der Version 4.5 über eine “Aero Snap”-ähnliche Funktion. Diese ist soweit auch gut umgesetzt und funktioniert anständig. Allerdings hilft das dem Ubuntu-Nutzer, der die Desktopoberfläche GNOME bevorzugt nun aber auch nicht wirklich viel. Und ob ein Benutzer aufgrund dieser (zugegebenermaßen sehr praktischen Funktion) den Desktop wechselt, wage ich zu bezweifeln.

Unity soll es richten

Mit der kommenden Ubuntu-Version 11.04, Unity und Compiz, soll das Ganze dann aber out-of-the-box funktionieren. Nun handelt es sich bei Unity auch nicht um einen GNOME-Desktop, die meisten Ubuntu-Nutzer dürften sich daran aber wenig stören. Ein Video, dem ich heute über den Weg gelaufen bin, zeigt, dass Unity in Ubuntu Natty das Ganze wohl auch können wird – und zwar ohne selbst Hand an der Konfiguration anlegen zu müssen. Ob man für die Gnome Shell eine ähnliche Funktion geplant hat, ist mir nicht bekannt. (Nachtrag: Gnome-Shell wirds auch können – siehe Kommentare).

Ich find’s gut

Ich bin sehr erfreut über die Funktion. Da ich öfters mal unter Windows 7 arbeite, hab ich Aero Snap sehr zu schätzen gelernt. Da hat Microsoft wirklich hervorragende Arbeit geleistet. Vor allem bei großen, breitformatigen Bildschirmen und mehreren offenen Fenstern, spielt Aero damit seine Stärken aus. Ich hoffe, die Funktion wird für Natty gut umgesetzt, es wäre ein deutlicher Usability-Gewinn.

Hier noch das Video, für alle Interessierten.

(Im ubuntuusers-Planeten leider nicht zu sehen -> Hier gehts zum Video)

Tiled 0.6 erschienen ¶

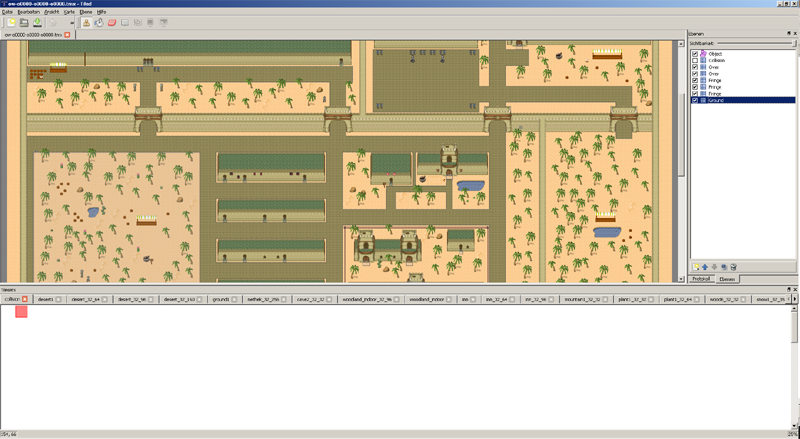

Heute ist die neue Version 0.6 von Tiled erschienen. Dabei handelt es sich um einen Open Source Mapeditor welcher auf Basis von Tilesets arbeitet. Dieser Mapeditor wird für viele Projekte benutzt wie z.B. Invertika.

Es sind in der neuen Version eine Menge Features hinzugekommen, wie z.B. das Öffnen von mehreren Karten in einer Instanz von Tiled. Ein sehr interessantes Feature ist das sogenannte Automapping. Dabei wird eine Regeldatei erstellt und mit dieser kann Tiled anhand eines vorgegebenen Umrisses Maps erstellen z.B. eine Höhle. Dies sollte eine Menge Arbeit sparen, da man sich nun auf die wichtigen Dinge konzentrieren kann.

Weitere Features sind die OpenGL beschleunigte Anzeige, sowie einige neue Werkzeuge. Bezogen werden kann der Editor unter http://www.mapeditor.org/.

Weitere Informationen gibt es unter:

http://wiki.themanaworld.org/index.php/User:Argul/automapping

http://sourceforge.net/apps/mediawiki/tiled/index.php?title=Main_Page

Tiled 0.6 erschienen ¶

Es sind in der neuen Version eine Menge Features hinzugekommen, wie z.B. das Öffnen von mehreren Karten in einer Instanz von Tiled. Ein sehr interessantes Feature ist das sogenannte Automapping. Dabei wird eine Regeldatei erstellt und mit dieser kann Tiled anhand eines vorgegebenen Umrisses Maps erstellen z.B. eine Höhle. Dies sollte eine Menge Arbeit sparen, da man sich nun auf die wichtigen Dinge konzentrieren kann.

Weitere Features sind die OpenGL beschleunigte Anzeige, sowie einige neue Werkzeuge. Bezogen werden kann der Editor unter http://www.mapeditor.org/.

Weitere Informationen gibt es unter:

http://wiki.themanaworld.org/index.php/User:Argul/automapping

http://sourceforge.net/apps/mediawiki/tiled/index.php?title=Main_Page

Firefox 4.0 Beta 10 ¶

Die 9. Betaversion von Firefox 4 war doch nicht die letzte vor dem ersten Release Candidate.

Mozilla hat nun die 10. Beta veröffentlicht.

In den wie immer englischsprachigen Veröffentlichungsnotizen steht, dass Firefox unter Mac OS X jetzt stabiler mit dem proprietären Adobe Flash-Plugin zusammenarbeitet. Ausserdem beansprucht die aktuelle Beta unter allen Betriebssystemen weniger Arbeitsspeicher als die vorherigen Testversionen.

Desweiteren scheint Mozilla eine schwarze Liste (“Blacklist”) für inkompatible Grafikkartentreiber eingeführt zu haben, um die Stabilität des Browsers zu gewährleisten.

Im Februar soll der erste Release Candidate und evtl. auch die finale Version von Firefox 4.0 erscheinen. Die Leute bei Mozilla arbeiten mit Hochdruck an der Beseitigung der verbleibenden Bugs.

Firefox 4.0b10 kann in insgesamt 76 verschiedenen Sprachen von den Seiten des Mozilla-Projekts unter anderem für Linux, Mac OS X und Windows heruntergeladen und getestet werden.

Apropos Sprachen: Eine alemannische Version von Firefox wäre auch mal eine nette Idee ![]() . Ich überlege gerade, ob und wie ich Mozilla bei der Übersetzungsarbeit helfen könnte.

. Ich überlege gerade, ob und wie ich Mozilla bei der Übersetzungsarbeit helfen könnte. ![]()

Das Testen erfolgt übrigens – wie immer – auf eigene Gefahr, weil es sich noch um eine Betaversion handelt. Jedoch sind bei mir nach dem Update auf 4.0b10 unter Ubuntu Linux 10.04 bisher noch keine Probleme aufgetreten. Auch meine Add-Ons (Adblock Plus, DownloadHelper, etc.) funktionieren nach der Aktualisierung weiterhin einwandfrei.

Ich kann die fertige Version von Firefox 4 kaum noch erwarten. Es kann sich nur noch um Wochen handeln, bis das finale Release erscheint. ![]()

Bis dahin heisst es für mich abwarten, testen und ggf. Bug-Reports an Mozilla senden.

26. Januar 2011

KDE 4.6 wurde von Golem getestet ¶

Mittlerweile sollten die meisten von euch mitbekommen haben, dass KDE 4.6 veröffentlicht wurde. Auch mein geliebtes News-Portal Golem hat davon Wind bekommen.

Golem bestimmt meiner Meinung nach nicht durch erstklassigen Journalismus bzw. gut recherchierten Artikeln, aber der Artikel über KDE konterkariert ihren Anspruch „IT-News für Profis” liefern zu wollen auf komische Art und Weise. Hier ein paar Punkte aus dem Artikel:

“Im Vordergrund steht der Compositing Manager, der zwar inzwischen mit zahlreichen Effekten aufwartet, beim Bildaufbau aber bisweilen langsam wirkt und zumindest auf Rechnern mit schwacher CPU und Grafikkarte den Benutzer dazu zwingt, auf den Augenschmaus zu verzichten.“

KDE und besonders KWin sind mittlerweile nicht dafür gemacht auf jedem Wald-und-Wiesen-PC zu funktionieren. Dafür sind einfach zu viele Techniken implementiert die Leistung brauchen. Und auch auf einer alten Geforce 4200 funktioniert das System gut. Diese Karte ist ca 5 Jahre alt. Benutzer mit älteren Rechnern würde ich zu LXDE raten. Ich weiß nicht mit welcher Hardware dort getestet wurde. Wäre schön gewesen wenn der Autor seine Konfiguration genannt hätte.

„Der Dateimanager Dolphin wurde mit einer lang ersehnten Funktion ausgestattet: der Spaltenansicht, die den Inhalt mehrerer Ordner einer Verzeichnishierarchie anzeigt.“

Diese Funktion ist dem Autor wohl seit der Version 4.0, mit der sie das erste Mal Einzug in KDE hielt, entgangen. :) Die Spalten wurden in 4.6 überarbeitet, aber die Funktion gibt es nun seit ca 3 Jahren.

„Dateien können von Dolphin auch ohne laufenden Nepomuk-Server inhaltlich durchsucht werden. Allerdings muss Nepomuk zuvor die Daten indiziert haben.“

Auch das ist leider falsch. Wird ein Begriff in die Suchleiste eingegeben, so erkennt das System ob der Ordner von Nepomuk indexiert wurde, oder nicht. Wurde er es, wird über Nepomuk gesucht. Wurde er es nicht, so wird „wie früher“ mittels KFind bzw richtiger kio_filenamesearch gesucht. Befindet man sich in einem solche nicht indexierten Ordner, so sind auch die Filter in der Seitenleiste nicht verfügbar.

Edit: Ich weiß nicht ob es an der Mail an die Golem Redaktion liegt, aber ist auch egal. Der Teil mit der Spaltenansicht in Dolphin wurde überarbeitet und korrigiert. Prima. :)

ID3-Tags von v2.4 nach v2.3 ¶

Viele Android User kennen das Problem. Man hat eine schön gepflegte Musiksammlung auf dem Rechner, wenn man jedoch die Titel auf sein Android Gerät kopiert, werden die hälfte der Tags nicht richtig angezeigt. Der Grund dafür ist, dass Android nur die ID3-Tags in der Version 2.3 unterstützt. Zuerst habe ich versucht alle Dateien mit EasyTAG zu konvertieren. Obwohl das funktioniert hat, habe ich nach kurzer Zeit abgebrochen, da es auf diesem Weg einfach zu viel Zeit in Anspruch nimmt. Eine weitaus schnellere Konvertierung ist dank dem Einsatz des Terminals möglich.

eyeD3 ein mächtiger ID3-Tag Editor für die Konsole

Mit eyeD3 hat man viele Möglichkeiten seine ID3-Tags auf Vordermann zu bringen.sudo apt-get install eyed3Das Programm hat viele Einstellungsmöglichkeiten und Parameter, auf welche ich an dieser Stelle nicht eingehen möchte.

Dateien finden und konvertieren

Um rekursiv eyeD3 auf alle Mp3 bzw. ogg Dateien anzuwenden benötigen wir die zwei Programme, nämlich find und xarg. Zuerst wechselt man in sein Musik Verzeichnis und anschliessend werden mit find alle Mp3 und ogg Dateien gesucht. Gleichzeitig werden die gefundenen Resultate an xarg übergeben, welches wiederum eyeD3 mit der "Konvertiere zu ID3-Tag v2.3" Option aufgeruft.cd ~/Musik/Nun sollten alle alle Audio Dateien rekursiv durchgeforstet und bearbeitet werden. Der Android Musik Player dankt nun mit vollständig angezeigten Tags.

find . -iname '*.ogg' -o -iname '*.mp3' -print0 |xargs -0 eyeD3 --to-v2.3

Hinweis

Bei mir hatten einige Dateien keinen ID3-Tag, was dazu führte, dass eyeD3 einen Fehler gemeldet hat. Nachdem ich die betroffenen Dateien jedoch bearbeitet hatte, funktionierte der Befehl einwandfrei. Falls jemand weiss wie ich diese Fehlermeldungen überspringen bzw. ignorienen kann, der schreibe doch einen Kommentar, damit ich den Befehl dementsprechend anpassen kann.25. Januar 2011

Vim - pseudo addieren ¶

Ich brauchte eine Möglichkeit, wie ich in einer Datei eine Zeichenkette die immer am Ende einer Zeile stand und immer C000 hieß hoch addierte. Eine Lösung ergab sich mit der Hinzuziehung von 3 Nullen und der Zeilennummer, damit der Ausdruck C000 “hochgezählt” wird.

Ich brauchte eine Möglichkeit, wie ich in einer Datei eine Zeichenkette die immer am Ende einer Zeile stand und immer C000 hieß hoch addierte. Eine Lösung ergab sich mit der Hinzuziehung von 3 Nullen und der Zeilennummer, damit der Ausdruck C000 “hochgezählt” wird.

:%s/C\zs000\ze$/\="000".line('.')/g

Das Ergebnis sah dann folgendermaßen aus:

... C0003

... C0004

... C0005

usw.

Quelle: Vim docs