Wie angekündigt habe ich versucht auf das Galaxy Tab 2 KDE zum laufen zu bringen, leider erfolglos.

Nachdem das Gerät erfolgreich gerootet wurde (dies wird für Installation von Ubuntu benötigt, bzw. für alle Anwendungen die im chroot Kontext laufen sollen) habe ich Ubuntu per Installer darauf installiert. Ich wurde nach dem Booten auf der Shell begrüßt und habe danach ein apt-get install kde-desktop eingegeben. Alle Pakete wurde runter geladen und installiert. Leider fährt das Ubuntu danach nicht richtig hoch, man sieht kurz den Bildschirm flackern und landet danach in einem Blackscreen. Im Logfile des Grafikservers ist leider kein Hinweis zu finden, was schief gelaufen ist, auch die sonstigen Logfiles sehen sauber aus. Leider fehlt mir nun die Zeit mich damit weiter zu beschäftigen, aber einen Versuch war es wert.

30. Dezember 2012

29. Dezember 2012

Skript: Bilder verkleinern und versenden (2. Update) ¶

Unter Windows XP gibt es eine Funktion, dass man in der Explorer-Bilderansicht mehrere Bilder auswählen kann, dann links auf „In E-Mail versenden“ (oder so ähnlich) klickt und die Bilder werden automatisch verkleinert und in eine E-Mail gepackt. Vor kurzem sagte jemand, dies geht unter Windows so einfach und unter Linux ist das so umständlich mit den Standardmitteln. (Weswegen derjenige auch lieber Windows startet.)

Aus dem Grund habe ich ein Skript geschrieben, was genau diese Verkleinerung der Bilder mit Hilfe von ImageMagick vornimmt und dann mit dem Standardmailprogramm versendet. Thunderbird versendet. Ich habe leider nicht herausbekommen, ob es analog zu x-www-browser etwas für das Standard-Mailprogramm gibt. Wer das Skript für etwas anderes als Thunderbird nutzen will, muss es also ggf. noch anpassen.

#!/bin/bash

ALLFILES=""

# Zuerst alle Bilder verkleinern

for FILE in "$@"

do

# Ersetze Leerzeichen durch Unterstriche

BASENAME=`basename "$FILE" | sed 's/ /_/g'`

echo "BASENAME: $BASENAME"

rm -rf "/tmp/$BASENAME"

convert -geometry 640x640 "$FILE" "/tmp/$BASENAME"

ALLFILES+="--attach /tmp/$BASENAME "

done

# Nun die Bilder versenden.

echo "xdg-email $ALLFILES"

xdg-email $ALLFILES

Das Skript ist sehr einfach und iteriert über alle Argumente ($@). Im /tmp-Verzeichnis wird dann mittels convert eine kleinere Version abgespeichert, die eine Maximalbreite oder -höhe von 640 Pixel hat. Dies kann man nach Belieben anpassen, unter Windows ist dies so eingestellt. Alle Bilder werden dann in eine Liste ALLFILES gesteckt und mittels xdg-email (Standardmailprogramm) verschickt.

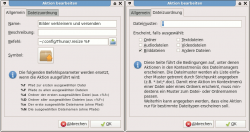

Weil das Skript noch nicht alles ist, kann man sich in den meisten Dateimanagern auch eine eigene Aktion definieren, die das Skript aufruft. Ich habe es unter ~/.config/Thunar/.resize abgespeichert und dann in Thunar über „Bearbeiten -> Benutzerdefinierte Aktionen“ ein neue Aktion mit folgenden Daten erstellt:

- Name: Bilder verkleinern und versenden

- Befehl: ~/.config/Thunar/.resize %F

- Dateizuordnung: nur Bilddateien

28. Dezember 2012

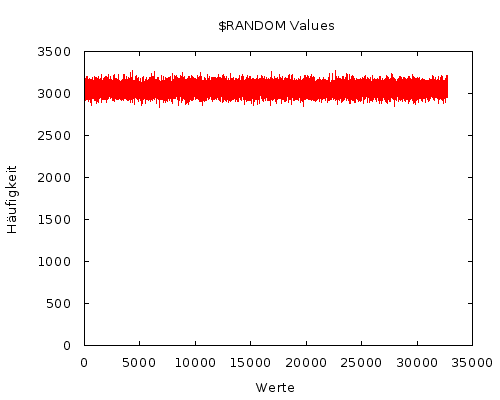

Wie der Zufall so will. ¶

Ab und zu stößt man auf etwas und fragt sich “Wie kommt das eigentlich zu

stande?”. So ging es mir die Woche mit $RANDOM. Die globale Variable der

bash liefert einen Wert zufälligen Wert zwischen 0 und 32767 zurück. Dieser

lustige kleine Integer erzeugende Kamerad ist mir jetzt nicht umbedingt neu.

2009 schrieb ich bei Codecocktail mal

einen Blogpost

darüber. Anders als damals interessierte mich aber was hinter der Value steht

und wie sie zustande kommt.

Randomness in Bash

Ich lud mir den Source der bash herunter und

laß erstmal etwas. Sollte man eigentlich öfters mal tun, weil man auch über

andere unbekannte Dinge wie z.B. $LINENO stößt. Außerdem interessante

Comments:

/* From “Random number generators: good ones are hard to find”, Park and Miller, Communications of the ACM, vol. 31, no. 10,

October 1988, p. 1195. filtered through FreeBSD */

Das Paper (das nebenbei gesagt älter ist als ich) lässt schon bisschen erahnen wohin die Reise geht. Außerdem erfährt man, dass der Random Number Generator von Turbo Pascal wohl nicht so der Wahnsinn ist. Schade eigentlich.

Im Source etwas umgeschaut findet man aber schnell das was man sucht. Mit etwas Bitwise XOR Spass einen Seed auf Zeit- und PID-Basis erstellt, durch den minimalen Standard aus dem Paper gejagt und schon wars das eigentlich.

1

| |

Taugt das was?

Ich wollts dann schon noch etwas genauer wissen. Mit einem Einzeiler

1

| |

habe ich dann (innerhalb 90 Minuten) 100 Millionen Zahlen generiert. Mein Thinkpad war von dem ganzen Gerechne (immerhin 18500 Values pro Sekunde) allerdings nicht so begeistert:

1 2 | |

Wahrscheinlich habe ich es etwas übertrieben. Was solls. Auf die Sample Size kommts schliesslich an!

Die 540MB große Datei hab ich dann etwas sortiert und in einen Graphen gestopft.

Die Null-Hypothese dabei: Einer der Werte ist statistisch signifikant höher als

alle anderen. Weil für Google Charts 32k Values wohl etwas zu viel ist, ein

Graph mit gnuplot

Den vielen Values gedankt sei auch die Unübersichtlichkeit des Graphen. Deshalb

noch ein kleinwenig mehr Statistikpr0n. Im Durchschnitt wird jede der Zahlen bei 100 Mio. Durchgängen ca. 3050 mal

genannt. Wesentlich interessanter dabei ist aber die Abweichung vom

Durchschnitt (siehe auch Standard Deviation).

Bei der Bestimmung derer hilft eine kleine awk Zeile.

1

| |

Bei meinen File wich also jeder der Werte durchschnittlich 53.6643 von der Durchschnittshäufigkeit ab. Wenn man das weiß, hat man schonmal ein ziemlich gutes Gefühl für das Auftreten der Integers.

Unterm Strich empfinde ich $RANDOM als eine mehr als zufriedenstellende Variante eines Random Number

Generators. Vielleicht war aber auch einfach nur ein guter Tag (wörtlich!) für das

zufällige generieren von Zahlen.

Raspberry Pi - Media Center/XBMC (Teil 2) ¶

Um auf der Raspberry Pi überhaupt Software auszuführen, benötigt man eine SD-Karte. Empfehlenswert ist eine möglichst schnelle und mindestens 2 Gigabyte große Karte, um lange Ladezeiten zu vermeiden. Ich benutze hier eine Transcend Extreme-Speed SDHC 16GB Karte, die es z.B. bei Amazon für unter 12€ gibt. Die Karte bietet Schreib und Leseraten von um die 20MB/s.

Die SD-Karte wird dann am PC (Windows, Mac, Linux) mit dem ausgesuchten Betriebssystem bespielt.

Für den Einsatz als Media Center gibt es drei größere Distributionen, die ich alle durchprobiert habe:

- XBMC als Frontend

- einen vollautomatischen Installer

- 1080p Video Wiedergabe (H264, für VC1 und MPEG2 kann man günstige Lizenzen kaufen)

- Streaming über die Netzwerkprotokolle: SMB, NFS, AFP, FTP, DLNA, Airplay, HTTP

- CEC Unterstützung um die Steuerung komplett über die Fernbedienung des Fernsehers zu ermöglichen.

Raspbmc

- sehr kleines SD-Karten Image (20Mbyte). Lädt dann allerdings alle benötigten Komponenten während der Installation aus dem Netz

- Auto Konfiguration der Sprache/Region. Zeitzone muss manuell eingestellt werden

- Auto-Updater

- Unter Programme findet man einen Raspbmc Einstellungsdialog, der es u.a. ermöglicht die Raspberry Pi zu übertakten oder Mpeg2 bzw. VC-1 Lizenzen freizuschalten

- ermöglicht es alle Pakete aus dem Debian Repository nachzuinstallieren

OpenELEC

- ca. 1Gbyte großes SD-Karten Image, dass auf die SD-Karte kopiert werden muss. Anschließend aber keine Online-Installation nötig

- Auto-Updater

- Auto Konfiguration der Sprache/Region. Zeitzone muss manuell eingestellt werden

- OpenElec Einstellungen, die allerdings sehr allgemein sind und nicht extra für den Raspberry Pi optimiert worden sind. Um tiefere Einstellungen zu machen muss man per SSH connecten

xbian

- Ebenfalls 1Gbyte großes und fertiges SD-Karten Image.

- Soll Performance mäßig am besten sein, da hier u.a. auf der Raspberry Pi selber kompiliert wird (was >1 Tag dauert). Gemerkt hab ich aber keinen Unterschied

- Update etwas komplizierter (SSH apt-get upgrade ...)

- Keine automatischen Spracheinstellungen

- Keine GUI-Einstellungen (nur XBMC). Konfiguration komplett über SSH.

Fazit:

Raspberry Pi - Performance Optimierung

- Genug Strom. 5V mit mindestens 800mA sollte das Netzteil stark sein. Ich empfehle allerdings gleich ein Netzteil mit 1A zu nehmen, um ggf. genug Reserven zum Übertakten zu haben.

- Schnelle SD-Karte. Ich benutze eine Transcend 16Gbyte Class 10 Karte mit der man ca. 20MB/s Lesen und Schreiben kann. Man merkt den Unterschied definitiv bei Ladezeiten aber auch beim Buffering von Video.

- DolbyDigital / DTS Passtrough richtig konfigurieren. Wenn der Ton über einen AV-Receiver geht oder über einen TV der DolbyDigital und DTS decodieren kann, solltet ihr das Signal ungefiltert durchgeben (Passtrough), so dass der TV die komplette Decodierung übernimmt. Falls das TV-Gerät das nicht kann, wird hier die CPU der Raspberry Pi stark belastet. Bei hohen Bitraten mit DTS kann es dann evtl. zum Ruckeln kommen. Abhilfe? Übertakten

- Übertakten. Die Pi lässt sich relativ leicht übertakten und das auch ohne Garantieverlust (zumindest wenn man nichts an den Spannungen ändert). 850Mhz Cpu Takt sollten locker drin sein. Manche User berichten sogar von bis zu einem Ghz. Ich empfehle hier einfach Raspbmc zu nutzen und in den Einstellungen den Modus auf Fast zu stellen (Bei Super kann es zu Bildfehlern kommen).

- Nutzt NFS für Dateifreigaben. Im Gegensatz zu SMB (Microsoft) oder AFP (Apple) ist NFS komplett offen und ermöglicht es so relativ einfach diese Protokoll effizient zu implementieren. Aus diesem Grund solltet ihr wenn möglich NFS nutzen. Alternativ kann man auch FTP nutzen, das ähnlich hohe Datenraten ermöglicht. AFP führte bei mir immer wieder zu längeren Buffer Pausen.

- Nicht zu viel Hintergrunddienste installieren. Falls ihr z.B. OwnCloud und parallel dazu XBMC wollt, würde ich Euch empfehlen zwei Pis zu kaufen.

Weitere Anmerkungen:

Wo kriegt man die Raspberry Pi möglichst günstig?

Brauche ich eine Fernbedienung?

Wie schaut es mit 24Hz und der Performance aus?

LiveTV?

Update zum Humble Indie Bundle 7 ¶

Wie üblich gibt es eine Woche nach dem Start des Humble Indie Bundle 7 eine kleine Erweiterung mit noch mehr Spielen. Um diese zu erhalten, muss man aber mehr als den aktuellen Durchschnittspreis zahlen (derzeit 6.51 US-Dollar).

Offspring Fling ist ein Jump'n'Run-Spiel mit einer Kreatur, die von der Form irgendwie an Kirby erinnert. Man hüpft und springt durch 100 Level und sucht seine verlorenen Kinder.

The Basement Collection ist eine Zusammenstellung von acht kleineren Flash-Spielen aus der Feder von Edmund McMillen, der schon Super Meat Boy und Binding of Isaac (auch im Humble Indie Bundle 7 enthalten) mit entwickelt hat.

Cave Story+ ist ein großartiges Action-Jump'n'Run-Adventure im 8-Bit-Stil mit einer guten Geschichte und Musik. Das Spiel war bereits im Humble Indie Bundle 4 enthalten.

Full Circle Magazine 68 erschienen ¶

Gestern ist die neue Ausgabe des englischsprachigen Magazins Full Circle Magazine erschienen. Themen der 68. Ausgabe sind unter anderem

- Command and Conquer – Synology DS213+

- Python programmieren – Teil 39

- Libre Office – Teil 21: Base (Datenbank)

- Anleitung: Ubuntu 12.10 auf einem Asus Eee PC installieren

- Blender-Tutorial – Teil 1

- Inkscape-Tutorial – Teil 8

- Webentwicklung – CRUD (Teil 4)

- Linux Lab: Phoronix Test Suite

- Windows-Äquivalente unter Linux – Programme automatisch starten

- Was ist … Raspberry Pi

- Buch-Review: Super Scratch Programming

- Review: Linux Mint Debian Edition KDE

- Interview: Didie Roche

- Ubuntu Games: Steam Beta

- News, Leserbriefe und mehr

Anmerkung: Die „Command and Conquer“-Reihe sollte ggf. mal umbenannt werden, da es mit der Konsole nicht mehr viel zu tun hat und worum es eigentlich mal ging. Man könnte damit die Leser etwas verwirren.

Das Blender-Tutorial finde ich klasse, da Blender eine recht komplexe Software ist und man mit Versuch und Irrtum nicht sehr weit kommt.

27. Dezember 2012

Live-Hörspiel: Cassandra's Run ¶

Aktuell läuft mit dem Titel Cassandra's Run ein Hörspiel der besonderen Art. In einem dystopischen Nürnberg des Jahres 2040, kämpft Runnerin Cassandra für den Widerstand gegen den bösen Großkonzern NorCon. Da ich die Vorgeschichte von Cassandra nicht kenne, weiß ich leider nicht genau, was es alles damit auf sich hat, aber prinzipiell ist das auch nicht ganz so wichtig.

In jedem Akt des Hörspiels erlebt man einen kleinen Teil der Geschichte, der mit einer offenen Entscheidung Cassandras endet. Gewalt anwenden oder verhandeln? Flucht nach oben oder unten? Abstimmen können alle Hörer per E-Mail, die so als „brainZ“ den weiteren Fortgang der Geschichte bestimmen.

Für Leute, die Hörspiele mögen, ist dies eine großartige Art der Unterhaltung. Die Akte sind kurz, sodass man sie auch zwischendurch hören kann. Die Abstimmung per E-Mail dauert auch nicht lange. Auf der Webseite wird auch fleißig von den brainZ darüber diskutiert, was die Vor- und Nachteile von Entscheidungen sind und worum es eigentlich geht. Denn nicht alle Ziele und Umstände der Geschichte sind klar, was die Spannung aufrecht erhält.

Um den Bogen zu Freien Inhalten zu schlagen: Das Hörspiel unterliegt der Creative-Commons-Lizenz CC-BY-NC-SA 3.0. Die einzelnen Akte gibt es nach der Abstimmung (die bisher immer 24 Stunde dauerte) auf der Webseite zum Anhören. Am Ende der Geschichte gibt es das ganze Hörspiel sicher auch wieder zum Download unter CC-Lizenz.

via Ikhaya

Linux als Spieleplattform ¶

Ich finde es durchaus reizvoll, Linux als Plattform für große Produktionen von Spielen zu betrachten. Das würde nämlich endlich mal etwas Druck auf Hardwarehersteller erzeugen, die dann hoffentlich mal vernünftige Treiber die Linux bereitstellen müssten.

Spiele und Sex sind immer die richtigen und wichtigen Zugpferde, wenn es um die Einführung von neuen Technologien geht. Und Spiele sind da doch wirklich eine bessere Wahl wie als mit „unter Linux laufen die Pornos flüssiger“ zu „werben“.

Und Valve hat ja bei der Steam-Portierung schon festgestellt, das manche Dinge unter Linux schneller gehen…

Vielleicht wird dann ja 2013 das Jahr des Linux-Desktops. #scnr

delayed: Weihnachtsgruß ¶

Meine Highlights 2012 ¶

Das Jahr 2012 geht langsam dem Ende entgegen. Daher habe ich mir einmal überlegt, welche Höhepunkte es im technischen Bereich für mich gegeben hat. Und das ist dabei herausgekommen. Zumindest zum Teil. 2012 war einfach zu viel los, so dass ich nicht alles anreißen kann.

Raspberry Pi. Ursprünglich war der kleine Rechner dafür gedacht, Kinder das Programmieren näher zu bringen. Inzwischen hat gefühlt jeder zweite so ein Teil. Und die Einsatzzwecke sind inzwischen ins uferlose gewachsen. Von reinen Downloadbüchsen, über Mediacenter, bis hin zu Hausautomationen und was weiß ich noch, ist alles dabei. Inzwischen gibt es immer mehr Zubehör und sogar einen eignen Store über den Software ggf. gegen eine Gebühr, oder auch nicht, angeboten wird.

Der Wechsel zu Uberspace.de. Für mich bisher der beste Webspace-Anbieter, den ich je hatte. Und das waren über die Jahre schon so einige. Domain aufschalten, die bei einem anderen Anbieter wie INWX liegt? Eine kurze E-Mail in der man die Domain und den Namen des eigenen Uberspace nennt und kurz darauf kann man loslegen. Ein eigener XMPP-Server? Einfach installieren und um die Freischaltung der Ports bitten. Kommt man bei etwas nicht weiter, einfach eine E-Mail schreiben und sich dann viel Zeit zum lesen der Antwort nehmen. Denn die wird nicht aus kurzen Textbausteinen bestehen, sondern wird sehr umfassend sein. Ich könnte jetzt vermutlich noch x Beispiele bringen, was man dort alles anstellen kann. Aber ich denke man versteht was ich damit sagen will. Man hat einfach viel mehr Möglichkeiten als bei anderen Anbietern. Und den Preis darf man auch noch selbst bestimmen. Gut nicht ganz. Ein Euro im Monat muss man mindestens Abdrücken. Einen kleinen Haken gibt es aber. Zumindest für die, die eine grafische Oberfläche zum Verwalten des Webspace erwarten. Den die gibt es nicht. “Nur” einen SSH-Zugang. Aber auch das ist kein Hexenwerk und dank des vorhandenen Supports kann man auch als Newbie einsteigen. Sofern man sich damit beschäftigen will bzw. kann.

Mageia. Jetzt werden sich einige Fragen, warum das ein Höhepunkt 2012 für mich ist, wo doch die erste Version 2011 erschienen ist. Ganz einfach. Weil die zweite Version 2012 veröffentlicht wurde und das ganze somit keine Eintagsfliege ist. Und weil mit dem Fork von Mandriva eine der einsteigerfreundlichsten Distributionen, wenn nicht sogar die einsteigerfreundlichste, weiterlebt. Bei Mandriva habe ich da weiterhin meine Bedenken. Wer also mit Distributionen aus dem Hause Canonical und deren Forks nichts anfangen kann, sollte unbedingt einen Blick riskieren.

Arch Linux. Als 2010 das Unternehmen hinter Mandriva mal wieder pleite war, habe ich mich nach ca. 10 Jahren Mandrake/Mandriva nach einer anderen Distribution umgesehen. Arch Linux war eigentlich keine Alternative. Da aber ein Großteil der Meinungen über die Distribution positiv waren, habe ich sie mal in VirtualBox installiert. Und schließlich hat Arch dann doch Mandriva abgelöst, da man einfach keine vorgegebene Standardinstallation hat, sondern sich seine eigene zusammenbaut. Ein Highlight 2012 ist Arch für mich, weil es für mich eine geniale Distribution ist. Rolling Release und quasi bleeding edge. Trotzdem habe ich damit auch nicht mehr Probleme oder Aufwand als mit einer “stabilen” Distribution, die nur alle x Monate eine neue Version veröffentlicht. Und unterhalten wird man dort auch noch. Die Diskussion, als der Wechsel zu systemd von den Entwicklern beschlossen wurde, war einsamme Klasse. Da passt der Spruch “Was der Bauer nicht kennt, frisst er nicht” wunderbar.

So und nun seit ihr an der Reihe. Was waren euere Höhepunkte 2012? Oder wie sehr ihr meine Highlights 2012?

26. Dezember 2012

Raspberry Pi - Allgemein (Teil 1) ¶

Ich starte hier mal eine kleine Artikelreihe über mein neues Lieblingsspielzeug, dem Raspberry Pi.

In Teil 1 gehe Ich Allgemein auf das süsse Gerät ein und stelle ein paar mögliche Anwendungszwecke vor.

Im zweiten Teil folgt eine Anleitung um den Pi zu einem MediaCenter zu machen.

Im dritten und letzten Teil zeige Ich dann mal in einem Video vom Raspberry Pi bei mir im Einsatz.

Teil 2: Raspberry Pi - Media Center/XBMC (Teil 2)

Teil 3: Raspberry Pi - Media Center/XBMC (Teil 3)

|

| Raspberry Pi von Oben |

Als dann noch einige XBMC Entwickler einen Port für das kleine Ding ankündigten, stieg meine Vorfreude natürlich nochmals an.

Hardwaremässig findet man auf der Platine fest verlötet:

- 700Mhz ARM CPU (ArmV6 Intruktionssatz)

- Broadcom GPU, die Hardware-Beschleunigung für verschiedene Video-Codecs bietet

- 512 Mbyte Arbeitsspeicher in Rev 2.0 (A-Version: 256MB, B-Version davor auch 256MB)

- Micro-USB Anschluss für 5V Stromversorgung (empfehlenswert sind mindestens 700mA)

- Zwei USB-Ports (A-Version: Einen Usb-Port)

- SD-Karten Slot an der Unterseite

- Ethernet Port mit 100Mbit (A-Version hat keinen)

- HDMI-Out für Video & Audio (REV 1.3 & 1.4)

- Composite-Video Out (Analog Video, Pal & NTSC)

- 3.5mm Klinkenstecker für Audio Out

- 16 GPIO-Pins z.B. zur Ansteuerung von LEDs

Erst Anfang Dezember hab ich überraschend (keine Versandbestätigung) die Lieferung erhalten.

Anwedungszwecke für das kleine Teil gibt es enorm viele. Alles was man so mit einem Computer tun kann und was nicht zu viel Rechenleistung erfordert ist damit zu realisieren.

Hier einige Beispiele:

- Als Media-Center mit XBMC (mehr dazu in Teil 2)

- Debian drauf und damit Programmieren lernen

- Als Webserver

- Als NAS (Network Storage)

- Eigene Cloud z.B. mit OwnCloud

- Als Classic-Console Emulator um z.B. NES, SNES Spiele darauf zu spielen

- AirPlay Client oder DLNA Client zum Streamen von Musik,Bilder und Videos vom Smartphone und Tablet

- Als Internetradio mit Wlan-Stick und angeschlossenen Lautspechern

Commandlinefu ¶

Für die Shell-Fetischisten habe gerade einen recht nützlichen Link ausgegraben.

Http://www.commandlinefu.com ist eine Sammelstelle für diverse Shell-Befehle inkl. deren Erklärung. Dort findet man relativ leicht nachvollziehbare Befehle wie

file -sL /dev/sda4

mit denen man beispielsweise das Dateisystem einer Partition herausfinden kann. Aber auch schwerere Geschütze wie

ps -eo size,pid,user,command --sort -size |awk '{hr[1024**2]="GB";hr[1024]="MB";for (x=1024**3; x>=1024; x=1024){if ($1>=x){printf ("%-6.2f %s ", $1/x, hr[x]);break}}}{printf ("%-6s %-10s ", $2, $3)}{for (x=4;x<=NF;x++){printf ("%s ",$x)} print ("/n")}'

mit denen man sich in einer übersichtlichen Weise anzeigen lassen kann, welche Speichermenge sich die Prozesse geschnappt haben. In der rechten Spalten der Seite gibt es diverse Tags wie bzip2, chmod, oder screen. Damit lässt sich das ganze schon einmal eingrenzen, wenn man sich nur Befehle für einen bestimmten Befehl/Bereich anzeigen lassen will. Eine Suchfunktion ist ebenfalls vorhanden, wenn man etwas genauer suchen will.

Filme unter Ubuntu für das Google Nexus 7 konvertieren ¶

Das Tablet Nexus 7 von Google hat eine ordentliche Auflösung aber dafür etwas wenig Speicher. Um den einen oder anderen Film unterwegs ansehen zu können, müssen die Filme zuvor in das richtige Format konvertiert werden.

Google Video Player :: Fail

Erste Versuche unter Ubuntu das richtige Format – zwischen Quantität und Qualität – zu erstellen …

Filme können unter Ubuntu u.a. mit der Software HandBrake in verschiedene Formate konvertiert werden. Die aktuellste Version kann im Terminal nach hinzufügen des Pakets durch „apt“ installiert werden.

$ sudo apt-add-repository ppa:stebbins/handbrake-releases

$ sudo apt-get update

$ sudo apt-get install handbrake-gtk

Nach erfolgreicher Installation befindet sich HandBrake im Starter und bietet umfangreiche Einstellungsmöglichkeiten an.

Ubuntu HandBrake :: Encoding

Folgende Formate werden empfohlen.

| SD (Low quality) | SD (High quality) | HD | |

|---|---|---|---|

| Video codec | H.264 | H.264 | H.264 |

| Video resolution | 176 x 144 px | 480 x 360 px | 1280 x 720 px |

| Video frame rate | 12 fps | 30 fps | 30 fps |

| Video bitrate | 56 Kbps | 500 Kbps | 2 Mbps |

| Audio codec | AAC-LC | AAC-LC | AAC-LC |

| Audio channels | 1 (mono) | 2 (stereo) | 2 (stereo) |

| Audio bitrate | 24 Kbps | 128 Kbps | 192 Kbps |

Als Kompromiss zwischen Qualität und Dateigröße habe ich folgende Einstellungen gewählt.

Video Encode: H.264

Framerate: 30

Bitrate (kbps): 500

Nach Auswahl der Quelle (Source) und des Titels (Title) kann die Konvertierung über „Start“ gestartet werden.

Die Video-Dateien können komfortabel durch AirDroid mit dem Browser auf das Tablet geladen werden.

Die Filme sollten nach dem hinzufügen auf dem Tablet in der Anwendung „Play Movies“ unter „Meine Videos“ zur Auswahl angezeigt werden …

Play Movies :: Meine Videos

… und können direkt abgespielt werden. :-)

Quellen:

25. Dezember 2012

Von Mozilla mitentwickeltes Format WOFF für Webfonts wird zum Standard ¶

Das Word Wide Web Consortium (W3C) hat WOFF 1.0 den Status einer W3C Recommendation gegeben. Damit ist das von Mozilla mitentwickelte Dateiformat für Webfonts nun offiziell ein Webstandard.

Das Format WOFF (Web Open Font Format) wird von Firefox bereits seit der im Jahr 2010 erschienenen Version 3.6 unterstützt und kann wie auch andere Formate über @font-face genutzt werden. Google Chrome unterstützt das Format seit Version 6, Safari seit Version 5.1, Opera seit Version 11.10 und auch der Internet Explorer seit Version 9.

Wesentliche Vorteile von WOFF sollen die Komprimierung und damit geringe Dateigröße sowie die Möglichkeit der Speicherung von Metainformationen sein. WOFF unterstützt gewöhnliche OpenType- oder TrueType-Schriftarten, welche nach der Dekomprimierung wieder im Originalformat vorliegen.

24. Dezember 2012

Mozilla Jahresrückblick 2012 ¶

Mozilla hat eine Infografik veröffentlicht, welche auf das Jahr 2012 und die Dinge, welche Mozilla in diesem Jahr erreicht hat, zurückblicken lässt.

Mozillas Jahresrückblick liest sich natürlich wie aus einer Werbebroschüre, was man ihnen aber auch kaum verübeln kann, schließlich wurden tatsächlich einige nennenswerte Dinge erreicht, auf welche man natürlich mit Stolz zurückblicken darf. Klar ist natürlich, dass Angaben zur Performance bei solchen Rückblicken immer den Optimalfall nennen und nicht unbedingt bei jedem derart deutlich ausfallen müssen wie genannt. ![]()

Die Infografik verrät, dass im Jahr 2012 über 3 Milliarden Downloads von Add-ons stattgefunden haben. Über Firefox Sync wurden mehr als 50 Milliarden Items synchronisiert. Insgesamt mehr als 17.000 Verbesserungen bei über 100 neuen Features sind in Firefox, welchen es in 89 Sprachen gibt, eingeflossen, Firefox soll 50% schneller geworden sein und für Power-User mit sehr vielen installierten Erweiterungen bis zu viermal weniger Arbeitsspeicher verbrauchen. Besondere Erwähnung findet hier das SocialAPI, welches unter anderem eine Integration von Facebook erlaubt.

Firefox für Android, welcher komplett neu entwickelt worden ist, soll der Grafik nach zweimal schneller als der Standard-Browser sein. Mit der Unterstützung von ARMv6-CPUs wurde Firefox außerdem auf über 15 Millionen weitere Smartphones gebracht. Außerdem konnte eine erste Vorschauversion des Firefox Marketplace, einem Appstore für HTML5-Apps, veröffentlicht werden.

Natürlich hat Mozilla auch in diesem Jahr wieder zu einem leistungstärkeren Web beigetragen und rund 30 neue Web-APIs eingeführt. Mit der Entwicklung von Firefox OS steht man zudem kurz vorm Start des weltweit ersten Open Web Devices. Firefox OS basiert zu allergrößten Teilen auf Web-Standards und von Mozilla entwickelten APIs.

Auch Mozillas Bestrebungen bezüglich Do-not-Track tragen Früchte. So haben über 19% der Android-Nuzer und 8% der Desktop-Nutzer Do-not-Track aktiviert. Mit der Blackout-Kampagne gegen SOPA hat man mehr als 30 Millionen Menschen erreicht.

Auch die Webmaker-Projekte waren ein voller Erfolg. So wurden mehr als 30.000 Projekte und 685 Events mit 6.000 Menschen in 80 Ländern durchgeführt. Das Mozilla Developer Network erreichte im Schnitt 4.5 Millionen Page Views und zwei Millionen Besucher pro Monat.

Der Rückblick liest sich aus Mozilla-Sicht bereits sehr gut. In Wirklichkeit gibt es noch so viele Dinge mehr, die eine Erwähnung verdient hätten. Wie Beispielsweise der Beta-Start von Mozilla Persona, die Einführung von ESR-Versionen, der Popcorn Maker, der Add-on Builder, die Arbeiten an der Sprache Rust und der Engine Servo, dem iPad-Experiment Junior, einem experimentellen Flash Player auf HTML5-Basis, dem Add-on Collusion, dem Ende von Firefox Home für iOS, die Änderungen bezüglich des Entwicklungs- und Release-Modells von Thunderbird, die Metro-Version von Firefox für Windows 8, sonstige Aktivitäten und Investitionen Mozillas. Diese Liste ließe sich fast beliebig verlängern. Ganz zu schweigen von den ganzen Produkt-Neuerungen im Detail. All dies zu erwähnen, würde den Rahmen aber deutlich sprengen und ist auch nicht Teil von Mozillas Infografik.

Man darf gespannt sein, was 2013 bringen wird.

Frohe Weihnachten ¶

Tux und ich wünschen euch und euren Freunden und Verwandten ein schönes Weihnachtsfest und einen guten Rutsch ins neue Jahr.

Tux: "santa clux" von Santang

Frohe Weihnachten ¶

Tux und ich wünschen euch und euren Freunden und Verwandten ein schönes Weihnachtsfest und einen guten Rutsch ins neue Jahr.

Tux: "santa clux" von Santang

Linux 3.8-rc1 ¶

Die erste Entwicklerversion des Kernels 3.8 liegt vor und bewegt sich vom Volumen der Änderungen her betrachtet wieder in einem normalen Rahmen.

Während der längsten Nacht des Jahres - zumindest in Kalifornien, in Mitteleuropa war der tiefste Stand der Sonne um 12.00 Uhr Mittags und daher beide Nächte um den 21. herum gleich lang - schloss Torvalds das Merge Window.

Dass die Unterstützung für 386SX/DX - „Nuke 386-DX/SX support“ - entfernt wurde, ist schon bekannt und ging auch bereits ausführlich durch jegliche Linux-News, die Blogosphäre, Google+ und wer weiß sonst noch, also halte ich mich damit nicht weiter auf.

Ansonsten wurde mit F2FS ein Dateisystem speziell für Flash-Speicher wie USB-Speicher oder SD-Karten in den Kernel aufgenommen. Die bereits vorhandenen Dateisysteme ext4, xfs, btrfs und ceph haben teilweise umfangreiche Überarbeitungen erfahren. Sprich: Da wurde viel Code hinzugefügt und modifiziert, die Commit-Liste bin ich nicht komplett durchgegangen.

Die Statistik sieht diesmal vernünftig aus. Es gibt nicht mehr so viel Geschiebe wie bei der letzten Version, die zahl der Commits liegt jedoch so hoch wie bei keinem anderen 3.x-Kernel. Grob überflog scheinen aber auch ziemlich viele Fehlerkorrekturen dabei zu sein und auch die Bewegungen im Bereich der staging-Treiber scheint größer als in den letzten Versionen.

Naja, sehen wir mal, was in den nächsten Wochen so kommt. Frohes Fest!

Die letzten rc1-Versionen:

Eine Übersicht über die ersten Entwicklerversionen der letzten Kernel

| Commits | geänderte Dateien | eingefügte Zeilen | gelöschte Zeilen | Datum | Tage * | |

|---|---|---|---|---|---|---|

| 3.0-rc1 | 7 728 | 7 345 | 515 283 | 434 481 | 30.05.2011 | 11 |

| 3.1-rc1 | 7 620 | 8 567 | 682 861 | 567 884 | 08.08.2011 | 17 |

| 3.2-rc1 | 10 730 | 12 103 | 1 628 367 | 1 406 543 | 08.11.2011 | 15 |

| 3.3-rc1 | 9 460 | 10 078 | 569 551 | 360 626 | 19.01.2012 | 15 |

| 3.4-rc1 | 9 859 | 10 526 | 553 618 | 344 653 | 31.03.2012 | 12 |

| 3.5-rc1 | 10 068 | 9 139 | 605 187 | 400 813 | 03.06.2012 | 14 |

| 3.6-rc1 | 9 160 | 7 629 | 512 898 | 248 227 | 02.08.2012 | 12 |

| 3.7-rc1 | 11 083 | 15 096 | 1 543 528 | 1 226 219 | 14.10.2012 | 14 |

| 3.8-rc1 | 11 737 | 10 482 | 554 790 | 340 624 | 21.12.2012 | 11 |

* Tage seit dem letzten Release

Quelle: git diff --stat --color v3.7..v3.8-rc1, Linux Kernel Mailing List

Schneeflocken im Terminal ¶

Gerade habe ich ein schönes Bash-Skript gefunden, dass einem schöne Schneeflocken in das Terminalfenster zaubert.

Als Screensaver eignet sich das Skript hervorragend.

Weihnachtliche Grüße

* ** * ** * * * *

* * * * * * * *

* * * * * * * * ** * *

****** ****** **** ** * * * * ** * * ****

Hinweis: Neues Diaspora* Wiki ¶

Das Diaspora* Wiki zieht gerade von Github in eine MediaWiki Installation um und ist jetzt unter wiki.diaspora-project.org zu finden. Die Startseite macht schon einen sehr aufgeräumten Eindruck.

Wer beim Umzug der Inhalte von Github in das neue Wiki helfen möchte findet hier eine kurze Checkliste, was dabei zu beachten ist und welche Artikel schon umgezogen sind.

Fröhliche Weihnachten mit Redshift ¶

Fröhliche Weihnachten wünsche ich euch mit diesem tollen Programm für die dunklen Nächte:

Redshift

MonoDevelop und das Auswerten von Ausdrücken ¶

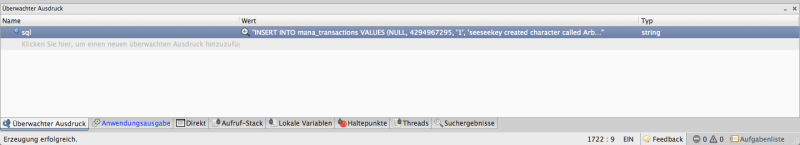

Vor einiger Zeit hatte ich einen Artikel darüber geschrieben, was mich an MonoDevelop stört. Seit heute gibt es da noch eine weitere Sache. So kann man in MonoDevelop Ausdrücke und Variablen auswerten, was bei der Entwicklung doch sehr praktisch ist.

Problematisch wird es dann, wenn das Fenster dazu verleitet nach Fehlern zu suchen, die eigentlich nicht existent sind. So kürzt es automatisch den Wert der überwachten Variable ein. Selbst wenn man auf „Kopieren“ drückt, wird nur die gekürzte Fassung in die Zwischenablage geschoben. Dadurch kann es dann passieren das man anstatt:

"ABCDEFGHIJKLMNOPQRSTUVWXYZ"

den Wert:

"ABCDEFGHIJKLMNOPQRS..."

auswertet. Möchte man an dieser Stelle ganz sicher sein, so hilft nur der umständliche Weg über die Lupe, in welcher der ganze Wert in einem extra Fenster angezeigt wird.

23. Dezember 2012

Wohlfühldinge für den Desktop ¶

Da ich ja schon mal schrieb, dass das Grid-Plugin von Compiz und sein Nicht-Vorhandensein in anderen Desktop-Environments ein Grund dafür sei, dass ich eher weniger umstiegslustig sei, habe ich mittlerweile eine passende Lösung gefunden, die auf jeden Fall unter KDE4 und Gnome3 funktioniert. Unter Gnome3 habe ich sie selbst laufen, unter KDE4 hat sie mein Kollege getestet. Dort auch sogar mit 2 Bildschirmen. Da ich nur einen habe, sei das mal egal.

Wer sich aber für so eine Grid-Lösung á la Winsplit Revolution interessiert, darf sich bei Stephan Sokolow bedanken, der das wunderbare Python-Skript “Quicktile” geschrieben hat.

Ein gesegnetes Weihnachtsfest ¶

Weihnachten steht vor der Tür und das Jahr neigt sich dem Ende. Auf diesem Weg wünsche ich euch und euren Familien ein gesegnetes Weihnachtsfest und alles Gute für das kommende Jahr.

Autostart ¶

Woran erkennt man ob ein Software Entwickler oder jemand der für diese Person Entscheidungen trifft versagt hat? Richtig, unter anderem an dem Fakt das man meint ein Problem mit dem Autostart von Software lösen zu können.

Autostart ist eine Maßnahme etwas zu starten bevor es der Benutzer tatsächlich angefordert hat. Vor allem unter Windows ist das eine sehr beliebte Möglichkeit alte Hardware an die Grenzen ihrer Leistungsfähigkeit zu treiben, denn noch vor wenigen Jahren waren Systeme mit 4GB oder mehr Arbeitsspeicher eher die Ausnahme als die Regel.

Oft versprechen sich die Entwickler folgendes davon, die Reihenfolge hierbei zufällig:

- Information des Benutzers über Ereignisse

- Präsentation das alles OK und aktuell ist

- Schnelleres starten einer Anwendung

- Aktualisierung einer Anwendung im Hintergrund

Nehmen wir uns mal einen typischen SOHO-Anwender, und beobachten dabei was dieser beim Einschalten seines PCs beachtet: Nichts.

Das ist eine Feststellung welche ich in den letzten Jahren immer und immer wieder gemacht habe, der normale Anwender beschäftigt sich erst mit dem Rechner wenn alles geladen ist. Meldungen beim oder direkt nach dem Systemstart haben keine Information welche der Benutzer beachtet, Beispiele gefällig?

- Hinweise auf Updates werden geschlossen.

- Hinweise auf eine leere Tintenpatrone werden geschlossen.

- Hinweise das eine Gefahr besteht (Danke Norton!) werden ignoriert.

Als Ursache hierfür 2 mögliche Gründe:

- Der Benutzer möchte einfach Arbeiten oder im Internet surfen.

- Der Benutzer weiß nichts mit der Meldung anzufangen.

So, wir wissen jetzt das die Meldungen in den ersten ungefähr 5 Minuten wertlose Informationen enthalten. Dann kommen wir zum nächsten Kritikpunkt an diesen tollen Autostart Funktionen welche (eigentlich) niemand haben will: Performance

Jedes Programm welches beim Systemstart geladen wird muss eben bei jedem Systemstart geladen werden. Das klingt doof, ist aber wirklich so. Die Ressourcen die hierbei verbraucht werden stehen nach dem Start anderen Anwendungen nicht zu Verfügung. Gleichzeitig benötigt das System (wesentlich) länger zum Starten als ohne diese (dämlichen) Tools. Ich konnte in den letzten Jahren regelmäßig auf vielen Systemen mehrere hundert Megabyte Arbeitsspeicher und teilweise Minuten an Startzeit des PCs sparen indem ich nichts weiteres gemacht habe als mit msconfig unter Windows die Autostarts zu weiten teilen zu deaktivieren. Bei den meisten Einträgen handelt es sich um Tools für Update Benachrichtigungen oder aber Programme welche dem Anwender "Zusatzfunktionen" bringen möchten.

Zum Thema Performance gehört auch die Anbindung an das Internet, viele dieser Tools sind der Meinung einfach ohne Rückfrage dieses Internet von dem immer alle reden benutzen zu dürfen: Falsch, ein Anwender der gerade im Zug sitzt und EDGE bei gedrosseltem Volumentarif verwendet dürfte darüber nicht sonderlich Glücklich sein, das seine Internetverbindung noch zusätzlich unbrauchbar gemacht wird.

Wie wir oben erfahren haben wir der normale Anwender diesen Update Benachrichtigungen keinen großen Wert schenken, zumindest nicht so lange die Meldung einfach zu schließen ist. Gleichzeitig wird der typische Anwender auch mit einem ATI Catalyst Tool oder dem Pendant von nVidia nur wenig Anfangen. Zumindest ich kenne keinen Office Anwender welcher die Kantenglättung oder VSync verändert um die beste Performance beim scrollen von Excel Sheets zu haben ;-)

Jetzt haben wir 2 Probleme angesprochen, zum einen die sinnlosen Informationen, und zum anderen die sinnlose Verschwendung von teuer gekauften Systemressourcen. Kommen wir also zum letzten Punkt: Sicherheit.

Jedes Programm welches man auf seinem System installiert, mit all seinen Abhängigkeiten, stellt ein potentielles Sicherheitsrisiko dar. Insbesondere dann wenn es ohne Benutzerinteraktion etwas tut und im schlimmsten Fall sogar mit Administratorrechten läuft. Es gibt genug Fälle in denen automatische Routinen verwendet wurden um auf ein (eigentlich) sicheres Systeme unerwünscht etwas zu installieren. Oft haben die Entwickler hier schon an anderer Stelle versagt, z.B. beim überprüfen ob die Verbindung zum Updateserver tatsächlich ein gültiges SSL Zertifikat hat und die Software welche aktualisiert wird auch tatsächlich die passende digitale Signatur trägt. Der liebe Update Mechanismus spielt einem also statt dem tollen Updaten für das nette Freeware Office Programm, lieber einen Schwung Trojaner auf.

Ich denke es gibt noch wesentlich mehr Gründe warum man keine Programme will die beim Start vom System automatisch starten, natürlich möchte ich aber noch ein paar Lösungen vorschlagen, in der Hoffnung das diese irgendjemand beachtet:

- Zeige Informationen immer dann an wenn der Anwender diese benötigt, eine leere Druckerpatrone beschäftigt den Anwender beim Druckvorgang, und nicht beim starten vom System.

- Wenn dein Programm eine neue Version findet, was beim Start der Anwendung zu prüfen ist, sollte der Benutzer informiert werden das eine neue Version vorhanden ist. Bei einem vorhandenen Sicherheitsloch sollten z.B. Plugins für den Browser (häufiger Angriffsvektor!) ihren Dienst einstellen bis das Problem behoben wurde.

- Einstellungen welche 99% der Anwender im normalen Leben nicht benötigen muss der Benutzer auch nicht als Tray-Icon sehen, es ist ausreichend diese an geeigneter Stelle in der Systemsteuerung zu verknüpfen.

- Zeige dem Benutzer nur Informationen zu Sachen an die ein Problem sind, weniger Informationen werden mehr beachtet als durchgehend Meldungen vom selben Programm. Die Information das ein Virenscanner (anderes Thema) heute schon 4 Updates erhalten hat ist weniger relevant als die Information das seit 7 Tagen keine Verbindung zum Updateserver mehr erfolgen konnte.

- Wenn dein Programm ohne aktiven Autostart sehr lange Ladezeiten hat, löse dieses Problem und schreibe dir keinen Autostart.

- Wenn du wirklich (!!!) ein Programm in den Autostart installieren möchtest, frag zuvor den Anwender bei der Installation. Standard sollte hierbei sein das kein Autostart erfolgt.

Dieser Artikel war sehr stark auf Windows ausgerichtet, gilt aber zu weiten teilen auch 1:1 für Linux. Hier ist mit z.B. erst Google Chrome negativ eingefallen welcher sich automatisch in den Autostart vom Desktop einträgt, nur damit irgendwelche Apps im Hintergrund laufen können. Ob diesen Artikel wirklich Entwickler lesen, und vor allem auch beachten werden?