Meist wird es nur als optische Spielerei abgetan, als Luxusproblem – die Möglichkeit, seinen Desktop so anpassen zu können, wie es einem selbst gefällt. Doch dieser Luxus wird zur Notwendigkeit, wenn man z.B. eine Sehbehinderung hat. Dann ist man darauf angewiesen, dass sich der Desktop optimal an die persönlichen Bedürfnisse anpassen lässt, also etwa Farbeinstellungen und Größenverhältnisse individuell und programmübergreifend ändern lassen. Gastautorin Jennifer Rößler hat sich unter diesem speziellen Gesichtspunkt die gängigen Linuxoberflächen einmal angesehen, und zwar nicht die extra auf Behinderte zugeschnittenen Distributionen wie z.B. Vinux, sondern die normalen Oberflächen, wie sie mit Ubuntu ausgeliefert werden.

Auf der Suche nach dem richtigen Desktop, mit dem auch Sehbehinderte klarkommen, die keine Sprachausgabe, dafür aber große Schrift und eine angepasste Hintergrund- und Schriftfarbe benötigen, haben wir einmal alle verfügbaren Desktops für Ubuntu auf ihre Sehbehindertenfreundlichkeit hin getestet. Es gibt eine Gruppe von Sehbehinderten, die einen schwarzen Hintergrund und gelbe, große Schrift benötigen, um komfortabel damit arbeiten zu können. Dies aber stellt sich nicht so einfach dar wie man vielleicht denken könnte.

Unity

Einmal völlig abgesehen davon, dass das Fehlen eines Startmenüs, das Finden eines Programms nur über die Suche im Dash, das Arbeiten unter Unity für einen Laien nicht gerade intuitiv gestaltet, sind auch die Farb- und Schrifteinstellungen genauso spartanisch wie der Rest. Will man als Sehbehinderter Unity auf einem Net- bzw. Notebook nutzen, müssen dafür bestimmte Voraussetzungen erfüllt sein. Es muss ein Theme auswählbar sein, das einen schwarzen Hintergrund der Menüs aller Anwendungen ermöglicht und die Schriftfarbe und -größe muss nach den persönlichen Bedürfnissen des Sehbehinderten einstellbar sein. Leider bietet Unity auf einem Netbook bspw. nur drei Themes, davon nur eines invertiert; der Hintergrund ist dann zwar dunkel, aber dunkelblau und nicht schwarz. Dies macht es notwendig, weiß als Schriftfarbe zu verwenden, was leider auf Dauer für manche Sehbehinderte zu anstrengend wird, da sie weiß als zu grell empfinden.

Unity bietet nur Dunkelblau/Weiß als Kontrastfarben an – und stellt Beschriftungen bei großer Schrift nicht richtig dar

Auch bei der Schriftgröße hat man keine große Wahl. Es gibt nur „klein“, „normal“, „groß“ und „größer“. Die größte Schriftgröße reicht gerade einmal, um halbwegs zurechtzukommen, da viele Programme keine eigene Schriftgrößeneinstellung mitbringen und so manch ein Anwendungsfenster dann immer noch mit so kleiner Schrift daherkommt, dass sie kaum lesbar ist. Ein weiteres Problem, dass sich bei sehr großer Schrift ergibt, ist, dass Anwendungsfenster nicht mehr komplett auf den Bildschirm passen und man droht, den Überblick zu verlieren, da man umso mehr scrollen muss. Stellt man die Schriftgröße aber so ein, dass alles auf den Bildschirm passt, ist die Schrift zu klein. Menüs, die nicht mehr am oberen Rand einer Anwendung zu finden sind, sondern sich im Bereich des Panels befinden und je nach aktiver Anwendung wechseln, sind auf Dauer äußerst anstrengend, da man schnell den Überblick darüber verliert, wo man sich gerade befindet.

XFCE (Xubuntu)

Wesentlich komfortabler gestaltet sich da XFCE. Es kommt mit einem klassischen Panel und einem Startmenü daher, was einem die Suche nach diversen Einstellungen sofort erleichtert. Zwar ist es ungewohnt, das Panel oben statt unten zu haben, aber daran gewöhnt man sich schnell.

XFCE ebenfalls nur in Blau/Weiß – und die Bestätigungsbuttons sind nicht mehr erreichbar, weil die Fenster über den Bildschirmrand ragen.

Die Theme-Auswahl ist hier bereits von Haus aus wesentlich umfangreicher. Doch auch hier findet sich mit dem Zusatz „invertiert“ nur ein dunkelblauer statt schwarzer Hintergrund. Dafür lässt sich aber die Schriftgröße beliebig groß einstellen. Man stelle sich aber einmal Schriftgröße 32 auf einem 10 Zoll-Bildschirm vor. Diese Größe ist notwendig, um die Schrift in einigen Anwendungsfenstern bequem lesen zu können, ohne mit der Nase auf dem Monitor kleben zu müssen. Da bedeckt ein ausgeklapptes Menü locker den halben Bildschirm und reicht bis zum unteren Rand. Was aber für die Menüs gar nicht notwendig wäre.

LXDE (Lubuntu)

Wirklich positiv überrascht hat hier LXDE. Wer bis jetzt noch mit Ubuntu 10.10 arbeitet, weil er sein Gnome 2 nicht aufgeben mochte, dem sei gesagt, LXDE sieht fast genauso aus. Panel unten, klassisches Menü, wie bei Gnome 2. Hier die Farbeinstellungen zu finden war überhaupt kein Problem. Für Fenster, Menü oder Minitipps lassen sich problemlos sowohl Farbhintergrund wie auch Schriftfarbe nach Wunsch anpassen. Jedoch ist dies nicht bei allen Themes möglich, bei einigen ist diese Möglichkeit deaktiviert.

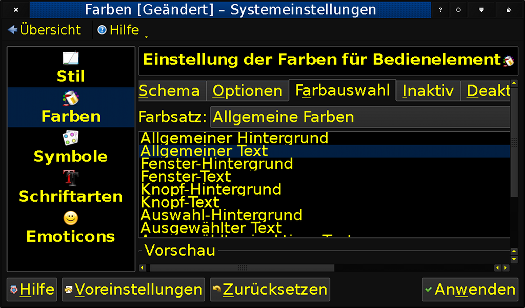

Vorbildlich: LXDE lässt bequem individuelle globale Farbeinstellungen zu.

Nur die Schriftgröße stellt das gleiche Problem dar wie bei den anderen Desktops auch. Sie ist nur generell für alles einheitlich einstellbar. Bis man also die Schrift in bestimmten Fenstern (als Beispiel sei hier das Pidgin-Nachrichtenfenster genannt) auf die benötigte Schriftgröße gestellt hat, ist die Schrift in anderen Fenstern oder Programm- oder Arbeitsflächenmenüs so groß, dass sie nicht mehr komplett auf den Bildschirm passen. Schriftgröße 18 ist die Grenze, wo man z. B. wenigstens noch an den Schließen-Button eines Fensters herankommt. Die oben erwähnte gelbe Schrift macht es möglich, dass man notfalls auch mit dieser Schriftgröße zurechtkommt. Die Alternative wäre, jedes Mal die Schrift nach Bedarf umzustellen. Zwar lässt sich hier sogar alternativ der DPI-Wert erhöhen, dieses hat dann aber natürlich wieder Auswirkungen auf alle Fenster und Anwendungen und führt u. U. Zu Problemen bei der Fensterdarstellung.

KDE (Kubuntu)

Wenn es um Farbeinstellungen geht, bleiben bei KDE kaum Wünsche offen. Für jede Eventualität lässt sich die Farbe zumindest bei einigen Themes beliebig einstellen. Selbst die Schriftgröße lässt sich generell oder für Leisten, Fenster oder Sonstiges beliebig einstellen, auch der DPI-Wert ist anpassbar, hier ergibt sich dann jedoch im Zweifelsfall das gleiche Problem wie bei LXDE. Im Ergebnis lassen sich sämtliche Menüs in gewünschter Größe darstellen. Es lassen sich aber nicht alle Programme an die Systemeinstellungen anpassen; hier ist es von Vorteil, wenn das Programm eigene Schriftgrößeneinstellungen mitbringt.

Perfekt: Einstellungen bis ins Detail und alles passt auf den Bildschirm

So einfach das Verändern der Farbeinstellungen unter KDE auch ist, einen Haken hat das Ganze: muss man die Einstellungen für andere Anwendungen öffnen, sei es nur, um vielleicht mal die Schriftgröße für irgendeinen Punkt zu ändern (man hat also den Farbeinstellungsbereich selbst gar nicht geöffnet), dann kann man sämtliche Farbeinstellungen neu einstellen, denn jede Anwendung, die nach dem Aufenthalt in „Einstellungen für Anwendungen“ geöffnet wird (ohne dass man an den Einstellungen etwas verändert hätte) startet dann wieder mit Standardfarben. Dafür bietet KDE als einziger Desktop die Möglichkeit, den Mauszeiger zu vergrößern.

Leerer KDE-Plasma-Desktop eines Sehbehinderten

Gnome-Shell

In puncto Farb- und Schriftgrößeneinstellungen unterscheidet sich Gnome Shell (hier in der Ausweichvariante genutzt) nicht von Unity. War Unity vorher schon installiert, werden die Einstellungen komplett übernommen. Auch die Themenauswahl bleibt die gleiche.

Fazit

Ist von Linux die Rede, wird oft von großer Vielfalt gesprochen. Sucht man als sehbehinderter Mensch aber einen Desktop, der beliebig anpassbar ist, muss man meist Abstriche machen. Nicht alles lässt sich wie gewünscht einstellen und nicht alle benötigten Möglichkeiten, wie etwa die zur Vergrößerung des Mauszeigers, sind überall vorhanden. Der perfekte Desktop wären die Mausvergrößerungsoption, Farb- und Größeneinstellungsmöglichkeiten und das einfache Umstellen des Arbeitsflächenhintergrundes von KDE, und die Sicherheit, dass alles so eingestellt bleibt wie es war, wie bei LXDE.

![By User:SKopp [Public domain or Public domain], via Wikimedia Commons Flag of India](http://upload.wikimedia.org/wikipedia/commons/thumb/4/41/Flag_of_India.svg/128px-Flag_of_India.svg.png)