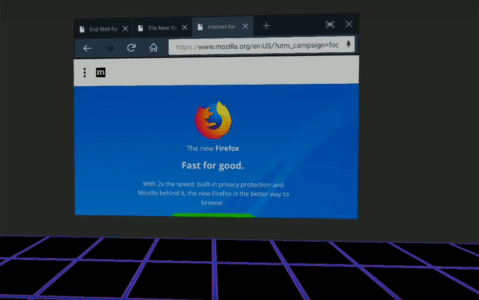

Neben der Vielzahl an Einstellungsmöglichkeiten, die sich unter „(Firefox) -> Einstellungen -> Einstellungen“ verbergen, möchte ich hier ein paar Dinge hervor heben, bei denen an der about:config geschraubt werden muss.

Am Ende des Beitrages findet ihr den Inhalt meiner user.js. Diese Datei könnt ihr

~/.mozilla/firefox/profilname ablegen, dann müsst ihr euch nicht selber durch die about:config klicken.

Darüber hinaus seien euch Projekte wie Waterfox oder der Tor-Browser empfohlen, die schon ab Werk einige Einstellungen wesentlich datenschutzfreundlicher Gestalten.

Ein Teil der folgenden Infos stammen von der sehr guten Seite ffprofile.com auf der ihr euch eine user.js nach eigenen Wünschen zusammenstellen könnt. Dort sind, wie ebenfalls im unteren Teil dieses Beitrages einige sinnvolle Add-ons gelistet.

Überblick

- Konfiguration

- temporäre Dateien verschieben

- Kamera und Mikrofon-Zugriff unterbinden

- Geolocation / Standortbestimmung unterbinden

- Sitzungswiederherstellung unterbinden

- Telemetrie-Datensammlung überprüfen

- Tracking blockiern

- Zeitmessung des Seitenaufrufs abschalten

- Vorrausladen von Inhalten unterbinden

- Fingerprinting erschweren

- Pastejacking verhindern

- TLDR user.js

- Erweiterungen installieren

Konfiguration

temporäre Dateien verschieben

Unter anderem weil ich eine SSD verwende, möchte ich, dass Firefox die temporären Dateien im Ordner /tmp/ ablegt. Wie das geht, wird im Wiki-Artikel auf ubuntuusers.de erklärt.

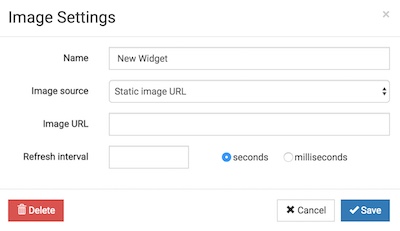

Dazu muss about:config in die Adress-Zeile eingegeben und der auftauchende Hinweis bestätigt werden. Nun ist die Zeile browser.cache.disk.parent_directory neu einzufügen und auf /tmp/firefox-cache zu stellen.

Kamera und Mikrofon-Zugriff unterbinden

Um zu verhindern, dass mein Browser Zugriff auf meine Webcam und mein Mikrofon haben, gilt es den Zugriff auf diese Hardware zu unterbinden.

Dazu müssen wiederum Zeilen in der about:config angepasst werden. Die entsprechenden Zeilen lautent media.navigator.enabled und media.peerconnection.enabled. Beide existieren bereits, müssen als Wert jedoch jeweils von true auf false gesetzt werden. Dein Doppelklick genügt dafür. Überprüfen lässt sich die Änderung zum Beispiel auf den Test-Seiten für die WebRTC-Implementierung.

Doch nicht nur der Browser selbst, auch das Flash-Plugin bietet Möglichkeiten auf diese Hardware zu zu greifen. Dies lässt sich auf der Einstellungsseite verhindern.

Geolocation / Standortbestimmung unterbinden

Auch die Standort-Bestimmung möchte ich dem Browser unter keinen Umständen erlauben. Wie das geht wird auf den Seiten von Mozilla erklärt.

Die entsprechende Zeile in der about:config lautet geo.enabled. Auch diese muss per Doppelklick von true auf false gesetzt werden.

Darüber hinaus bietet der Browser ab Werk die Möglichkeit WLan-Netzte der Umgebung zu analysieren, um mittels eines Google-Service die Standort-Genauigkeit noch zu verbessern. Wer das nicht möchte entferne die URL unter geo.wifi.uri.

Sitzungswiederherstellung unterbinden

Seit geraumer Zeit bietet Firefox an, die aktuelle Sitzung (engl. Session) nach einem Absturz oder dem plötzlichen Beenden des Browsers wiederherzustellen. Warum das sinnvoll sein kann und unter welchen Umständen der Browser dies tut, wird auf der Website des Entwickler-Teams von Mozilla erklärt.

Dieses an sich sehr nützliche Verhalten bürgt die Gefahr, dass beim Öffnen des Browsers Dritte einblick bekommen, welche Websiten zuletzt besucht wurden und je nach Cookie-Politik Websiten zugriff auf Online-Konten bekommen können, aus denen sich (zB wegen eines Absturzes) nicht mehr ausgeloggt werden konnte. Die datenschutzrechtlichen Implikationen werden von Mozilla selbst angesprochen.

Zum Deaktivieren der Sitzungswiederherstellung muss in der schon von oben bekannten about:config der Wert browser.sessionstore.resume_from_crash gesucht und auf false gesetzt werden.

Telemetrie-Datensammlung überprüfen

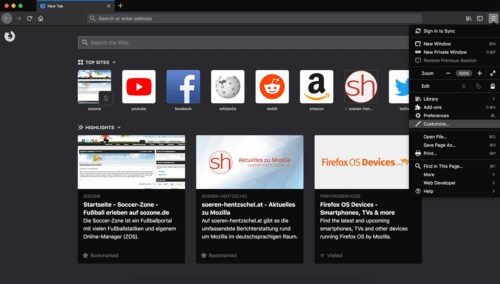

Seit längerem sammeln die Testversionen des Firefox bereits sogenannte Telemetrie-Daten. Sören Hentzschel erklärt in seinem Blogbeitrag dazu:

Firefox besitzt mit dem Telemetrie-Feature eine Mess-Infrastruktur, um diverse Leistungsdaten von Firefox anonym an die Mozilla-Server zu übertragen. Ab sofort ist Telemetrie in den Betaversionen standardmäßig aktiviert.

Telemetrie liefert Mozilla wichtige Erkenntnisse zur Nutzung des Browsers, um diesen zu verbessern. Für Nutzer der Nightly- sowie Aurora-Versionen von Firefox war Telemetrie bereits standardmäßig aktiviert, Gleiches trifft nun auch für Nutzer der Beta-Versionen zu.

Die Einstellungen für die Sammlung telemetrischer Daten lässt sich leicht unter about:telemetry überprüfen.

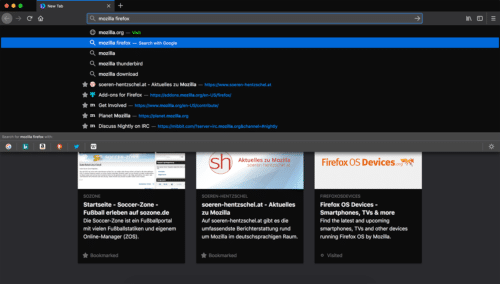

Tracking blockiern

Seit Version 42 hat der Firefox eine Tracking Protection für private Browser-Tabs:

Sie soll den Surfer davor schützen, dass Werbenetze sein Nutzungsverhalten verfolgen, um Informationen für Profile zu sammeln. Dazu blockiert die Firefox-Beta das Laden von Site-Elementen, die bekannt dafür sind, Surfer zu tracken.

Um den Tracking-Schutz auch in normalen Tabs zu aktivieren folgen wir der Anleitung von Martin und suchen in der about:config den Wert privacy.trackingprotection.enabled. Dieser muss nun auf true gesetzt werden. Mehr Infos finden sich bei mozilla.org.

Zeitmessung des Seitenaufrufs abschalten

Mittels einer Funktion im DOM lassen sich Seitenaufrufe messen und eventuell zur Erzeugung eines individuellen Fingerabdrucks nutzen. Um das zu verhindern muss in der about:config der Wert von dom.enable_performance auf false gesetzt werden. Im Torbrowser ist dies bereits der Fall.

Eine ähnliche Funktion stellen dom.enable_resource_timing und dom.enable_user_timing bereit, die ebenfalls mittels false deaktiviert werden können.

Vorrausladen von Inhalten unterbinden

Firefox analysiert bereits während eines Seitenbesuchs die Link-Struktur dieser Seite und lädt mögliche Seiten vor, die „wahrscheinlich“ angeklickt werden. Dies kann zur Folge haben, dass die Internetanbieter oder Nachrichtendienste, die den Datenverkehr abschürfen, Seitenaufrufe dokumentieren, die nie getätigt wurden.

Das Deaktivieren mittels setzen des Wertes False in network.prefetch-next schafft hier Abhilfe.

Eine verwandte Funktion stellt das DNS-Prefetching dar. Hier löst Firefox IPs auf, bevor ihr auf den entsprechenden Link geklickt habt. Zur Unterbindung muss

network.dns.disablePrefetch auf True gesetzt werden.

Auch für TCP gibt es eine Vorlade-Funktion, die getrost deaktiviert werden kann. Dazu network.predictor.enabled auf False setzen.

Etwas anders aber ebenfalls rein spekulativ funktioniert die Funktion network.http.speculative-parallel-limit die Anzahl von TCP-Verbindung bereits beim Überfahren von Links bestimmt. Um das zu verhindern sollte der Wert auf 0 gesetzt werden. Im Torbrowser ist dies bereits der Fall.

Fingerprinting erschweren

Das Team, dass den Tor-Browswer entwickelt hat Strategien entwickelt, um Fingerprinting, also das Sammeln von Identifizierungsmerkmalen, die insgesamt eine recht genaue Identifikation des Webbrowser und damit des Nutzenden ermöglichen, zu erschweren. Um diese Funktionen zu verwenden muss der Schlüssel privacy.resistFingerprinting auf True gesetzt werden.

Pastejacking verhindern

Seit Version 41 erlaubt Firefox Webseiten den Zugriff auf die Zwischenablage. Manche Zeitungen nutzen dies um an kopierte Beitrags-Ausschnitte die URL automatisiert anzuhängen. Dieses Feature könnte jedoch auch genutzt werden, um zB von einer Website kopierten Quellcode oder Befehlszeilen so zu verändern, dass Schadcode auf dem Rechner ausgeführt wird. Sicherheitsforscher haben den Begriff Pastejacking dafür geprägt.

Firefox kann den Zugriff auf die Zwischenablage unterbinden. Dazu muss in der about:config der Wert dom.event.clipboardevents.enabled auf false gesetzt werden.

user.js

Die Datei muss im Profil-Ordner eures Browser ~/.mozilla/firefox/PROFILNAME/ als user.js gespeichert werden.

// http://barfoos.blogsport.eu/firefox-an-die-eigenen-beduerfnisse-anpassen/#temp_Dateien

user_pref("browser.cache.disk.parent_directory", "/tmp/firefox-cache");

// http://barfoos.blogsport.eu/firefox-an-die-eigenen-beduerfnisse-anpassen/#Kamera_und_Mikrofon

user_pref("media.navigator.enabled", false);

user_pref("media.peerconnection.enabled", false);

// http://barfoos.blogsport.eu/firefox-an-die-eigenen-beduerfnisse-anpassen/#Geolocation

user_pref("geo.enabled", false);

user_pref("geo.wifi.uri", "");

// http://barfoos.blogsport.eu/firefox-an-die-eigenen-beduerfnisse-anpassen/#Sitzungswiederherstellung

user_pref("browser.sessionstore.resume_from_crash", false);

// http://barfoos.blogsport.eu/firefox-an-die-eigenen-beduerfnisse-anpassen/#Telemetrie

user_pref("toolkit.telemetry.enabled", false);

user_pref("toolkit.telemetry.rejected", false);

user_pref("experiments.enabled", false);

user_pref("experiments.supported", false);

// http://barfoos.blogsport.eu/firefox-an-die-eigenen-beduerfnisse-anpassen/#Tracking

user_pref("privacy.trackingprotection.enabled", true);

// http://barfoos.blogsport.eu/firefox-an-die-eigenen-beduerfnisse-anpassen/#Navigation_Timing

user_pref("dom.enable_performance", false);

user_pref("dom.enable_resource_timing", false);

user_pref("dom.enable_user_timing", false);

// http://barfoos.blogsport.eu/firefox-an-die-eigenen-beduerfnisse-anpassen/#Vorrausladen

user_pref("network.prefetch-next", false);

user_pref("network.dns.disablePrefetch", true);

user_pref("network.predictor.enabled", false);

user_pref("network.http.speculative-parallel-limit", O);

// http://barfoos.blogsport.eu/firefox-an-die-eigenen-beduerfnisse-anpassen/#Fingerprinting

user_pref("privacy.resistFingerprinting", true);

// http://barfoos.blogsport.eu/firefox-an-die-eigenen-beduerfnisse-anpassen/#Pastejacking

user_pref("dom.event.clipboardevents.enabled", false);

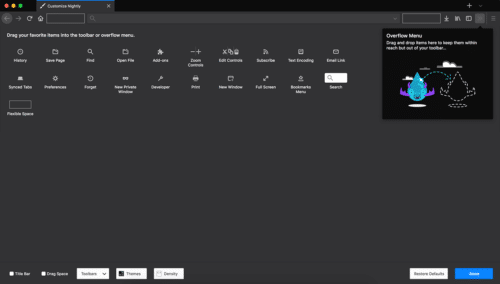

Erweiterungen installieren

Zu guter Letzt gilt es noch ein paar für mich unumgängliche Erweiterungen zu installieren:

- uBlock Origin – Werbeblocker, der AdBlock Edge abgelöst hat

- uMatrix – Matrix-basierte Firewall, die NoScript abgelöst hat

- Cahoots – zeigt Verbindungen von Journalisten zu Vereinen, Organisationen und Unternehmen

- HTTPS Everywhere – Verbindung verschlüsseln, wenn der Server das anbietet

- Privacy Badger – mächtiger aber einfach bedienbarer Script-, Cookie- & Ad-Blocker

- Calomel SSL Validation – tiefergehende Bewertung der TLS-Verschlüsselung zum Server

Alte Add-ons, die ich nicht mehr nutze:

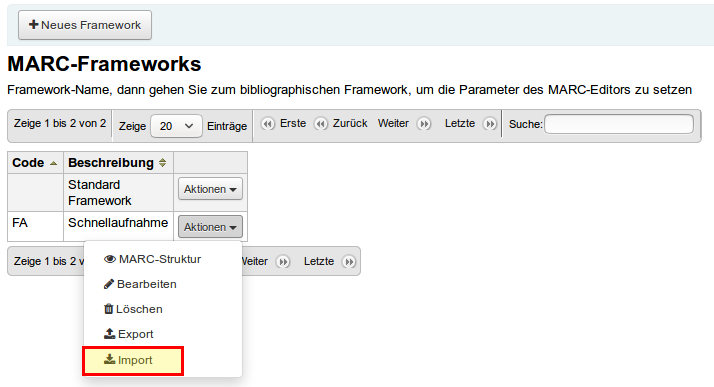

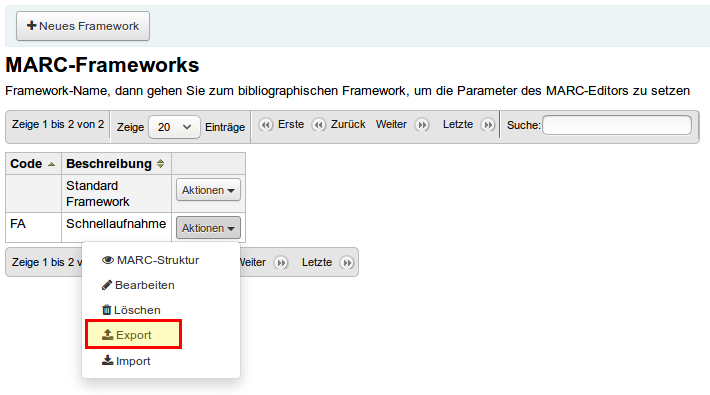

Framework anpassen

Framework anpassen