Falls jemand in Bildbearbeitung mit GIMP einsteigen möchte und ein gutes praxisnahes Buch sucht, dem kann ich das “GIMP 2.6 Praxisbuch” (ISBN 978-3-8266-5517-3) des mitp-Verlages empfehlen. Wie der Buchtitel verrät versucht das Buch dem Anwender in praktisch erklärten Kapiteln GIMP näher zu bringen. So widmen sich die einzelnen Kapitel neben dem Einstieg in GIMP auch praktische Anwendungen für einzelne Funktionen in GIMP, beispielsweisse Farb-/Helligkeitskorrektur oder das Entfernen von Piercings in Portraits oder störender Telefonleitungen in Landschaftsfotografien. Kapitel über den Umgang mit RAW-Formaten und HDR/DRI Fotografien komplettieren das Ganze.

Falls jemand in Bildbearbeitung mit GIMP einsteigen möchte und ein gutes praxisnahes Buch sucht, dem kann ich das “GIMP 2.6 Praxisbuch” (ISBN 978-3-8266-5517-3) des mitp-Verlages empfehlen. Wie der Buchtitel verrät versucht das Buch dem Anwender in praktisch erklärten Kapiteln GIMP näher zu bringen. So widmen sich die einzelnen Kapitel neben dem Einstieg in GIMP auch praktische Anwendungen für einzelne Funktionen in GIMP, beispielsweisse Farb-/Helligkeitskorrektur oder das Entfernen von Piercings in Portraits oder störender Telefonleitungen in Landschaftsfotografien. Kapitel über den Umgang mit RAW-Formaten und HDR/DRI Fotografien komplettieren das Ganze.

Das Buch umfaßt 350 Seiten, die durchgehend farbig sind und sehr viele Bilder und Illustrationen enthalten, was das Verstehen einzelner Schritte und Zusammenhänge wesentlich erleichtert. Zusätzlich kommt das Buch mit einer DVD daher, die neben GIMP für Windows und MAC auch die für die Übungen verwendeten Quellbilder als auch die entsprechenden XCF-Dateien enthält. Ausserdem enthält die DVD die einzelnen Übungen noch in Videoform. Das einzige, was da die Freude trübt ist, das es sich dabei um Flashvideos handelt. Wer möchte kann vorher beim Verlag sich ein Probekapitel durchlesen und auch einen Blick in einige Videos werfen.

24. August 2011

23. August 2011

Upgrade Debian Lenny-Squeeze vollzogen ¶

Am Sonntag habe ich spontan den Rootserver von Lenny auf Squeeze (Debian 6) upgegraded.

Bis auf ein paar Klemmer hat es gut geklappt.

Probleme:

- Wie auch von anderen berichtet, wurde mysql nicht installiert,

die Nachinstallation war easy, nur lief Mysql dann nicht sofort, eine Option in my.cnf war verkehrt

ich musste skip-bdb rauswerfen und mysql_upgrade starten.

Fehlermeldung:

Fehlermeldung /usr/libexec/mysqld: Table 'mysql.plugin' doesn't exist 14:23:18 [ERROR] Can't open the mysql.plugin table. Please run mysql_upgrade to create it. 14:23:19 InnoDB: Started; log sequence number 0 42353 14:23:19 [ERROR] /usr/libexec/mysqld: unknown option '--skip-bdb' 14:23:19 [ERROR] Aborting

- Mit Mail hatte ich so meine Probleme, hat sich irgendwie von selbst gelöst,

... unprofessionell und unbefriedigend... - Die

neue php 5.3x führte zu einigen Hickaufs bei den Webs. Zockertown.de

lief allerdings ohne Probleme. Aber das ist halt semiprofessionelle

Software.

Im Kern beschränkte es sich auf auskommentieren einiger Funktionen in Joomla Plugins

Im Kern beschränkte es sich auf auskommentieren einiger Funktionen in Joomla Plugins - munin muss etwas angepasst werden, steht aber gut beschrieben im Changelog.

Teamspeak 3 in den Unity-Launcher integrieren ¶

Ich fragte mich die Tage, ob es nicht möglich sei, Teamspeak 3 für Linux (in meinem Fall Ubuntu) besser in den Launcher zu integrieren. Bisher hatte ich nur eine Verknüpfung auf dem Desktop und nach Starten von Teamspeak dann ein Icon im Launcher. Hielt ich dies mit “Im Startet behalten” fest, so konnte ich Teamspeak durch einen Klick auf das Icon jedoch nicht starten.

So schaute ich mir einmal die anderen Verknüpfungen an, die im Launcher waren. Die Dateien hierzu liegen in »/usr/share/applications/«. Ich kopierte mir also einfach eine Datei und passte diese auf meine Bedürfnisse an:

[Desktop Entry]

Version=3.0.1

Name=Teamspeak 3 Client

Name[de]=Teamspeak 3 Client

GenericName=Teamspeak

GenericName[de]=Teamspeak

Comment=Spreche mit Freunden

Comment[de]=Spreche mit Freunden

Exec=/home/florian/Arbeitsfläche/TeamSpeak3-Client-linux_x86/ts3client_runscript.sh

Terminal=false

X-MultipleArgs=false

Type=Application

Icon=Teamspeak3

Categories=

MimeType=

StartupWMClass=Teamspeak

StartupNotify=true

Eigentlich könnt ihr euch alles so anpassen wie ihr möchtet, jedoch muss die Option “Exec” stimmen. Diese legt fest, wo sich das Start-Script (im Teamspeak-Installationsordner vorhanden) befindet. Diese Datei müsst ihr dann nur mit Root-Rechten in den Ordner »/usr/share/applications/« unter z.B. »teamspeak3-client.desktop« abspeichern und die Datei auf den Launcher ziehen. Dies sollte jedoch soweit ich weiß beim nächsten Anmelden auch passieren. Somit kann man Teamspeak 3 aus dem Launcher starten und auch darüber kann man dann schließen usw.

UniOS und AndLinux ¶

Nach dem Beitrag von Golem über UniOS kam anhand eines Screenshots schnell die Vermutung auf das im Hintergrund AndLinux arbeitet:

Bei AndLinux handelt es sich um ein Ubuntu (Maik Mixdorf sagt ja selber das das System auf Ubuntu 10.10 aufbaut) welches sich nahtlos in Windows 2000 und höher integriert. So langsam sollten die UniOS Leute einfach mal reinen Tisch machen, denn mittlerweile artet das doch in einer Hexenjagd aus, wenn man sich die Kommentare bei Facebook so anschaut.

AndLinux würde auch erklären warum im Moment nur eine 32 Bit Version von UniOS angeboten wird, es gibt nur eine dementsprechende Version von AndLinux. Alles in allem denke ich ist UniOS in etwa so aufgebaut:

- Windows XP mit ein paar veränderten Designs und Bootanimationen

- AndLinux für die Ausführung von Linux Anwendungen

- ein paar Anwendungen die nicht nach Windows aussehen (Explorerersatz et cetera)

Gerade gab es bei Golem ein Update:

Nachtrag vom 23. August 2011, 17:40 Uhr:

Am Dienstag hatte Maik Mixdorf einigen seiner Kritiker das System vorgeführt. Dabei hat sich bestätigt, was einige Anhand unseres Artikels bereits vermutet hatten: Es handelt sich bei UniOS um ein angepasstes Windows XP, auf dem andLinux läuft. Bei dem verwendeten Theme könnte es sich um GSM VS handeln, wie uns ein Leser per E-Mail mitgeteilt hatte.

Weitere Informationen gibt es unter:

http://andlinux.org

http://seeseekey.net/blog/3976

https://www.facebook.com/bs.uni.os

22. August 2011

Firefox Nummer 6 – der Speedtest ¶

Es ist soweit und der Feuerfuchs mit der Nummer 6 ist auch für Ubuntu Normal Updater zu haben. Ich habe mir den Feuerfuchs einmal genauer angeschaut und mich hat auch dieses mal wieder die Geschwindigkeit interessiert.

Beim Benchmark-Test vom Pacekeeper hat der Feuerfuchs 6 gegenüber dem Feuerfuchs 5 ein wenig zugelegt. Im Gesammt-Test hat der neue Feuerfuchs 5% an Leistung zugelegt. Na ja, das merkt man während dem Arbeiten nicht so gut und ich hätte da auch einiges mehr erwartet.

Beim Acid3 Test erreicht der Feuerfuchs nicht die volle Punktzahl. Es fehlen noch mickrige 3 Punkte.

Fazit

Auch wenn der Feuerfuchs jetzt in der 6. Version erschienen ist, überzeugt er mich nicht betreffend der Geschwindigkeit und dem Funktionsumfang. Ich bleibe weiterhin auf dem Chromium (momentan Version 12), da habe ich die Leistung die ich mir wünsche.

Ähnliche Artikel

Firefox: Erweiterung für Übersetzungen ¶

Von Zeit zu Zeit mache ich mein Profil für den Firefox mal neu, auch um Altlasten von getesteten aber nicht mehr verwendeten Erweiterungen loszuwerden. Dabei ist mir aufgefallen, dass eine Erweiterung, die ich schon seit Ewigkeiten verwende plötzlich nicht mehr existiert. Dabei handelt es sich um die Übersetzungshilfe Babelfish, mit der man einfach übers Kontextmenü Einzelwörter übersetzen kann. Gehe ich auf die Seite der Erweiterung erhalte ich dort folgende Meldung:

Dieses Add-on wurde durch seinen Autor entfernt.

Sicherlich hätte ich versuchen können, die Erweiterung aus dem alten Profilordner weiter zu nutzen. Über kurz oder lang hätte man bei der Versionsspringerei von Mozilla dennoch Probleme mit der Erweiterung. Deshalb habe ich mich nach einer Alternative umgesehen. Dabei bin ich auf gTranslate gestoßen, das recht ähnlich funktioniert wie Babelfish. Ein kleiner Nachteil ist jedoch, dass gTranslate bis auf Quell- und Zielsprache keine Einstellungsmöglichkeiten anbietet.

Schade, dass es die Chrome-Erweiterung Bubble Translate nicht für Firefox gibt. Die wäre mir natürlich am liebsten…

21. August 2011

Komplexität der Beteiligung an offenen Projekten ¶

Ein Teil von etwas sein, an etwas großen mitgearbeitet zu haben – das ist der Reiz an der Beteiligung.

Damit locken viele “offene” Projekte, damit auch der scheinbar kleine Mensch (Mann lasse ich aus emanzipatorischen Gründen mal weg) an etwas so großartigem Teil haben darf und sich als Miterstellen fühlen darf. Der Hauptgrund ist natürlich, das fast alle Menschen ehrenamtlich mitarbeiten und man somit auf viele Menschen angewiesen ist, denn nebenbei muss man ja auch irgendwie noch Geld verdienen. Die Problematik sehe ich darin, dass der als kinderleicht dargestellte Einstieg in die Beteiligung, eigentlich ein sehr steiniger Weg ist.

Ich selbst arbeite nun seit ein paar Monaten im »Ubuntu German Translators« – Team mit, welches für die Übersetzung der Sprachpakete für die Ubuntu-Distribution zuständig ist. Ich habe Spaß an der Arbeit und ich lerne dabei auch noch etwas (Vokabular, schnellere Sinnerfassung von meist englischen Sätzen uvm.) - eine gute Sache also. Aber was musste geschehen bis es dazu kam? :

- Interesse an der Mitarbeit, Programmierkenntnisse (PHP, JavaScript, HTML, CSS und wenig Python und C++)

- Umsehen nach Möglichkeiten der Beteiligung, Information auf OMG!Ubuntu über sogenannte Bytesize-Bugs (jedoch weit über meinen Fähigkeiten)

- Zufälliges Stoßen auf die Übersetzung in Launchpad

- Beitritt in der öffentlich zugänglichen Gruppe der Ubuntu German Translators auf Launchpad

- Gespräche im IRC über das KnowHow, welches für das Übersetzen und was damit zu tun hat wichtig ist

- anfängliche Versuche der Übersetzung, jedoch kläglich gescheitert, da wenn ich Hilfe brauchte niemand im IRC zu erreichen war; Probleme mit Launchpad -> 2 Monate Pause

- flüchtiges Mitlesen in der Mailingliste des Teams

- erneuter Versuch des Einstiegs, diesmal erfolgreicher; erste Übersetzungvorschläge gelangen in die offizielle Übersetzung von Ubuntu Natty

Ich habe an dieser Stelle noch viele frustrierende Abende ausgelassen, an denen mich entweder die Komplexität von Launchpad, nervige Fehler in der Software zur Übersetzung (Nightmonkey, Launchpad und OpenTrans) oder die schlichte Unattraktivität mich verzweifeln haben lassen.

Nunja, ich habe in der letzten Woche wieder einige Übersetzungen zum kommenden Oneiric beigesteuert, jedoch wieder nach ebenfalls ca. 2 Monaten Pause. Die Mailingliste erhalte ich nicht, obwohl ich mich für diese auf Launchpad eingetragen habe (das Thema Mailinglisten und deren korrekte Nutzung ist nochmal so ein Thema, welches ich an dieser Stelle aber nicht näher ansprechen möchte. Jedoch ist das alles andere als ein Kinderspiel!). Den einzigen “Kontakt” den ich derzeit zum Team habe ist ein Jabber-Kontakt, und dieser scheint momentan selbst nicht viel Zeit für die Übersetzungen zu haben.

Das heißt es ist eine Menge Engagement neben dem eigentlichen Übersetzen gefordert. Außerdem muss man beachten, dass die Arbeit vielen Normen und Vereinbarungen entsprechen muss an die man sich halten muss, da sonst wieder von Anderen nachgebessert werden muss, was wiederrum Arbeit für Andere bedeutet. Ich sehe das Problem hier schlichtweg am doch sehr holprigen Einstieg in die “Szene”, der durch diverse Texteinleitungen o.Ä. irgendwie nicht wirklich einfacher wird. Und ich sehe hier Ubuntu bzw. dessen Übersetzung als das noch geringste Problem an, da Launchpad und Nightmonkey einen guten Dienst leisten. Beispielsweise blicke ich durch die Upstream-Übersetzungen gar nicht durch, und stufe diese als aufwändiger ein.

Jedoch war dies nur ein Beispiel, welches ich aus meinen Alltag genommen habe. Ein weiteres Problem mit dem ich ebenfalls des öfteren in Kontakt gekommen bin ist das Bugreporting in Ubuntu. Ich teste häufig Vorabversionen von Ubuntu an, um mich über kommende Neuerungen zu informieren. Dabei bleibt es natürlich nicht aus, dass Fehler auftreten. Ubuntu bietet hierfür Tools an, mit denen man solche Fehler auf Launchpad berichten (Bugreport=Fehlerbericht) kann. Die Applikation »apport« sammelt hierzu Informationen über das System (Soft- als auch Hardware), sodass die Entwickler nicht die Nadel im Heuhaufen suchen müssen. Dafür benötigt man natürlich eine Internetverbindung, als auch einen Launchpad-Account. Die erste Barriere sehe ich hier in der ausschließlich englischen Sprachausgabe von Launchpad, denn lange nicht jeder ist sich des Englischen einigermaßen mächtig. Denn so ein Bugreport erfordert normalerweise eine zumindest kurze Beschreibung des Fehlerablaufs usw. Kommt man den Entwicklern hier mit Deutsch, so kann man nur auf Glück hoffen, dass dieser auch gerade Deutsch beherrscht. Ansonsten wird der Report entweder ignoriert, oder man wird gebeten auf Englisch zu schreiben. Auch wenn man eigentlich nur helfen möchte, so steht man doch vor einem fast unlösbaren Problem wenn man kein Englisch kann. Gut, es gibt Übersetzer im Internet, doch tun diese ihren Dienst meist mehr schlecht als recht. Problem Nr.1 also.

Ein weiteres Problem ist dann, die riesige Anzahl an berichteten Fehlern und eine Übersicht über diese. Die Suche gestaltet sich insofern schwierig, als das man einen Fehler doch ziemlich verschieden beschreiben kann. Ein Beispiel hierfür ist z.B. die für den nicht in die Entwicklung involvierten Benutzer Unterscheidung zwischen Designfehlern und “richtigen” Programmfehlern. Für den normalen Benutzer ist kein Unterschied darin, ob man auf einen Link nicht klicken kann, da dieser z.B. wegen veränderter DPI-Einstellung auf dem System verschoben wird, oder ob dieser Link wirklich vom Code aus defekt ist. Somit gestaltet sich die Suche nach eventuell schon berichteten Fehler als sehr schwer und vergrößert somit die Menge an Duplikaten, was die Sache wiederrum unübersichtlicher macht.

Dagegen steht jedoch die ausgezeichnete Launchpad-Software, die das ganze zum Großteil kompensieren kann, bzw. es zumindest versucht.

Für mich persönlich sind all diese Dinge mittlerweile kein großes Problem mehr, da ich mit verwendeten Werkzeugen vertraut bin und schon den ein oder anderen Bugreport hinter mir habe. Jedoch ist der schwere Einsteig für Neulinge ein ernsthaftes Problem, für das es derzeit noch nicht so richtig eine Lösung zu geben scheint.

Mal sehen was sich die Communities da in Zukunft einfallen lasssen werden.

Minecraft Server unter Ubuntu aufsetzen ¶

Um einen Minecraft Server aufzusetzen muss im ersten Schritt java mittels

apt-get install openjdk-6-jre-headless

installiert werden. Nun kann die Version des installierten Javas (java –version) bestimmt werden. Diese sollte 1.6 oder höher sein:

OpenJDK Runtime Environment (IcedTea6 1.9.9) (6b20-1.9.9-0ubuntu1~10.04.2) OpenJDK Server VM (build 19.0-b09, mixed mode)

Nachdem damit die Grundvoraussetzungen erfüllt sind wird mittels

adduser minecraft su minecraft

ein Nutzer für den Server angelegt und in diesen Nutzer gewechselt. Nun schreiben wir uns ein kleines Startskript mit dem Namen start-server.sh:

#!/bin/sh wget -N http://www.minecraft.net/download/minecraft_server.jar java -Xmx1024M -Xms1024M -jar minecraft_server.jar nogui &

Dieses Skript lädt die aktuelle Version herunter und führt sie im Hintergrund aus. Nun fehlt nur noch ein Stopskript, welches auf den Namen stop-server.sh hört:

#!/bin/bash pkill -SIGTERM java sleep 5 pkill -SIGKILL java

Nach dem ersten Start des Servers werden einige Konfigurationsdateien angelegt. In die Datei ops.txt tragen wir den oder die Operatoren für den Server ein. In der Datei server.properties sind die grundlegenden Einstellungen für den Server zu finden. In meinem Fall wird die Whitelist aktiviert indem die Eigenschaft white-list auf true gesetzt wird. in der whitelist.txt kann man dann die entsprechenden Nutzer eintragen welche sich in die Welt einloggen dürfen.

Weitere Informationen gibt es unter:

http://de.wikipedia.org/wiki/Minecraft

http://www.debianroot.de/server/minecraft-server-erstellen-auf-einem-debian-server-1297.html

20. August 2011

Nautilus-Kontextmenü um eigene Skripte erweitern ¶

Das Kontextmenü des Dateimanagers Nautilus lässt sich sehr einfach durch eigene Skripte erweitern. Obwohl das Thema sicher vielen nicht neu ist, möchte ich hier kurz beschreiben, wie das funktioniert und welche Möglichkeiten es bietet.

Zum einen ist dieser Artikel als Grundlage für einen kommenden Artikel, in dem ich eine weitere Skriptidee vorstellen möchte, gedacht. Zum anderen hat das hier gezeigte Beispiel auch seinen Charme: es geht darum, das Terminal aus Nautilus heraus “intelligent” öffnen zu können.

Als Beispiel möchte ich hier ein Skript zeigen, mit dem man das Nautilus-Kontextmenü um einen Menüpunkt Im Terminal öffnen erweitert. Das Terminal soll natürlich direkt im ausgewählten Verzeichnis geöffnet werden. Dazu erstellt man ein Bash-Skript mit folgendem Inhalt:

#!/bin/bash

uris=$NAUTILUS_SCRIPT_SELECTED_URIS

if [ -z "$uris" ]; then

uris=$NAUTILUS_SCRIPT_CURRENT_URI

fi

eval uris=\$\'${uris//%/\\x}\'

for uri in $uris; do

path=$(sed -e "s/^file:\/\///g" <<< $uri)

gnome-terminal --working-directory=$path

done

Das Skript sollte Im Terminal öffnen heißen und muss im Verzeichnis /usr/share/nautilus-scripts liegen. Beachtet dabei, dass ihr vor den Leerzeichen im Namens jeweils ein Backslash (\) angeben müsst – und, dass sudo für die Anlage im genannten Verzeichnis notwendig ist. Um das Skript also mit vi zu erzeugen/editieren gebt ihr folgendes ein:

sudo vi /usr/share/nautilus-scripts/Im\ Terminal\ öffnen

Installiert euch dann das Paket nautilus-script-manager, also:

sudo apt-get install nautilus-script-manager

Danach könnt ihr mit folgendem Befehl das Skript im Kontextmenü aktivieren:

nautilus-script-manager enable Im\ Terminal\ öffnen

Übrigens: den Script-Manager könnte man sich vermutlich auch sparen. Denn offenbar tut er nichts weiter, als einen symbolischen Link unterhalb von ~/.gnome2/nautilus-scripts auf die Skripte im o.g. Verzeichnis zu erstellen.

Schließlich muss Nautilus noch einmal neu gestartet werden, damit der neue Eintrag erscheint:

nautilus -q

Danach findet ihr euren Eintrag im Kontextmenü unterhalb des Untermenüs Skripte.

Welche Features das o.g. Beispiel-Skript im Detail bietet:

- Wenn der Kontext-Menüeintrag auf ein selektiertes Verzeichnis ausgeführt wird, wird dieses Verzeichnis im Terminal geöffnet.

- Wenn der Kontext-Menüeintrag auf den Hintergrund des aktuellen Verzeichnisses ausgeführt wird (also ohne etwas zu selektieren), dann wird das gerade aktive Verzeichnis im Terminal geöffnet.

- Wenn der Kontext-Menüeintrag auf mehrere selektierte Verzeichnisse ausgeführt wird, dann werden alle diese Verzeichnisse jeweils in einem Terminalfenster geöffnet.

Für eine umfangreiche Beschreibung des Themas sei euch natürlich die ubuntuusers.de-Wikiseite zum Thema ans Herz gelegt.

Wer noch weitere Skript-Ideen sucht, könnte sich z.B. NScripts anschauen. Dabei handelt es sich einfach um eine Sammlung von Nautilus-Scripts, die als Tarball heruntergeladen werden können. Auch die Webseite GScripts ist eine gute Quelle und einen Besuch wert.

Zum Schluss sei natürlich noch angemerkt, dass es für Nautilus eine Erweiterung gibt, die die “Im Terminal öffnen“-Funktionalität in Nautilus einbindet. Das Paket dazu heißt nautilus-open-terminal. Aber diese Variante hat doch auch was, oder?

Update:

Um ein Skript wieder zu entfernen, kann man wiederum den nautilus-script-manager, diesmal mit der Option disable verwenden. Für das hier beschriebene Beispiel sieht der Aufruf dann folgendermaßen aus:

nautilus-script-manager disable Im\ Terminal\ öffnen

Natürlich muss auch danach Nautilus noch einmal neu gestartet werden (s.o.).

pssst, weitersagen!19. August 2011

WebCam über VLC nutzen ¶

Mit VLC (VLC media player) lässt sich sehr Vieles anstellen. So zum Beispiel auch eine Webcam auszulesen, inklusive Mikrophon. Voraussetzung dazu ist natürlich, dass die Kamera vom Kernel erkannt wird. Sollten hierzu Probleme auftauchen, gibt es einen sehr guten Wiki-Eintrag auf ubuntuusers.de. Ich nutze schon seit vielen Jahren eine Uralt-Webcam aus dem Hause Microsoft. Damals war jenes Haus noch überaus düster und hinterhältig, heute gebart sich das Unternehmen deutlich zahmer und hat sogar Linux zu seinem 20. Geburtstag gratuliert. Es handelt sich dabei um eine LifeCam VX-7000, die es offenbar immer noch zu kaufen gibt, mindestens auf eBay.

Mit VLC (VLC media player) lässt sich sehr Vieles anstellen. So zum Beispiel auch eine Webcam auszulesen, inklusive Mikrophon. Voraussetzung dazu ist natürlich, dass die Kamera vom Kernel erkannt wird. Sollten hierzu Probleme auftauchen, gibt es einen sehr guten Wiki-Eintrag auf ubuntuusers.de. Ich nutze schon seit vielen Jahren eine Uralt-Webcam aus dem Hause Microsoft. Damals war jenes Haus noch überaus düster und hinterhältig, heute gebart sich das Unternehmen deutlich zahmer und hat sogar Linux zu seinem 20. Geburtstag gratuliert. Es handelt sich dabei um eine LifeCam VX-7000, die es offenbar immer noch zu kaufen gibt, mindestens auf eBay.

Um die Kamera mit VLC auslesen zu lassen muss im VLC Player mit dem Menü Medien der Unterpunkt Aufnahmegerät öffnen gewählt werden. Im neuen Fenster sollte oben rechts Video for Linux 2 ausgewählt sein. In der Regel ist die WebCam unter der Adresse /dev/video0 zu finden. Ist auch ein Mikrophon in der Kamera verbaut, muss man zunächst herausfinden, wie dieses ansprechbar ist. Das klappt in der Konsole mit dem Befehl

arecord -l

Die Ausgabe, die dem Befehl folgt, gibt Auskunft über den Namen des Mikrophons. Diesen kann man im VLC hinterlegen.

roman@R61:~$ arecord -l**** Liste der Hardware-Geräte (CAPTURE) ****Karte 0: Intel [HDA Intel], Gerät 0: AD198x Analog [AD198x Analog] Sub-Geräte: 2/2 Sub-Gerät #0: subdevice #0 Sub-Gerät #1: subdevice #1Karte 1: VX7000 [Microsoft® LifeCam VX-7000], Gerät 0: USB Audio [USB Audio] Sub-Geräte: 0/1 Sub-Gerät #0: subdevice #0

In meinem Fall heisst das Gerät VX7000 auf der Karte 1. Und so trage im VLC in der Zeile Audio-Gerätename den Namen ein und stelle plughw: voran:

plughw:VX7000

Damit erkennt VLC das Mikrophon und es lief auf Anhieb tadellos.

Es gibt noch eine ganze Menge anderer Anwendungen, mit denen eine WebCam zu steuern ist, auch solche, die aus der Konsole laufen und zeitgesteuert Bilder transferieren oder einen Stream aufbauen.

Üblicherweise nutze ich Cheese für die WebCam, weil es noch etwas verspielter ist und den einen oder andern Gag erlaubt. Aber auch mit VLC klappt das Ganze gut.

Ähnliche Artikel

Geocaching – mit dem Android Tablet ¶

Schon seit einiger Zeit interessiere ich mich für GPS und deren Verwendung. Bis jetzt habe ich GPS nur geschäftlich genutzt, im privaten Umfeld hatte mir die Zeit dazu gefehlt. Das hat sich geändert, nun bin ich zu einem Geocacher geworden. Darum hier ein Beitrag wie man mit einem Android Tablet geocachen kann.

Vorgeschichte

Angefangen hat alles mit einem Android Tablet das GPS fähig war. Leider ist der Nutzen des Tablets mit 10″ für das Cachen nicht gegeben, da es etwas zu gross geraten ist. Vor kurzer Zeit habe ich mir ein richtiges Outdoor GPS Gerät von Garmin gekauft. Damit ist es möglich seine eigene Position bis auf wenige Meter genau zu bestimmen. Als Anfänger im Geocaching habe ich mich dann auf den Seiten von www. geocaching.com umgesehen und mein ersten Caches entdeckt. Eine Karte des jeweiligen Gebietes habe ich mir zur Sicherheit ausgedruckt und auf der Suche immer dabei gehabt. So war ich in meinen Sommerferien voll damit beschäftigt, verschiedene Caches zu finden. Den höchste Cache habe ich dann auf 2598 m.ü.M. gefunden. Jetzt bin ich gepackt vom Cache-Virus.

Die Technik

Zu meiner Grundausstattung gehören:

- Navigationsgerät (Garmin etrex Vista)

- Tablet (Archos Internet Tablet 7″, Android 2.2)

- Handy (Samsung Galaxy Gio, mit GPS, Android 2.2)

- Benutzerkonto (opencaching.com, geocaching.com)

Diese Dinge sind leicht zu transportieren und können überall mitgenommen werden. Mein Tablet kann ich dann mit meinem Mobile-Phone verbinden und das Internet nutzen. Ist zwar ein wenig limitiert wegen der Übertragungsgeschwindigkeit, dafür bin ich damit unabhängig.

Die Vorbereitungen

Als grundsätzliche Vorbereitung muss man sicher auf einiges achten. Man ist sehr viel in der Natur draussen und muss sich entsprechend ausrüsten. Daneben hat man auch noch die Technik dabei und auf die muss man besonders aufpassen. In einem ersten Schritt sucht man sich sicherlich die gewünschten Caches aus. Hier definiert man ein Gebiet und sucht darin einmal die vorhandenen Caches. Das mache ich meistens am Tablet und merke mir dann die Caches. Wenn es dann los geht, dann sind sicherlich folgende Vorbereitungen zu beachten:

- Jemanden der dich begleitet

- Festes Schuhwerk

- Sonnencreme

- Taschenlampe

- Ersatzbatterien für das GPS

- Stift und Notizblock

- Kamera

- Ausreichend Trinkwasser

- Etwas zum Essen für zwischendurch

- Gegenstände für den Cache, falls Du etwas tauschen möchtest

- Einen Cache den man dann auch verstecken könnte

Das Caching beginnt

Wenn alle Vorbereitungen getroffen sind, die gewünschte Route steht, dann lauf oder fahr ich los. Ich nehme immer öffentliche Verkehrsmittel, mein Fahrrad oder gehe direkt zu Fuss. Meistens sind wir ja auch in einer Gruppe am Cachen. Dann müssen wir uns einig sein welche Reihenfolge wir angehen. Als erstes versichern wir uns, dass wir alle die richtigen Koordinaten haben. Das machen wir dann im Zug oder im Bus zusammen und schauen auf dem Tablet welcher Cache welche Informationen hat. Auf meinem GPS Tracker kann ich wunderbar einen Wegpunkt eingeben und diesen anpeilen. Mein Geräte hat auch noch einen guten Kompass der mir genau zeigt in welcher Richtung sich der Cache befindet. Durch die Navigation auf dem GPS Gerät und den Informationen auf dem Tablet finde ich sehr schnell zum gewünschten Cache. Ist der Cache erreicht, muss ich dann ohne Technik meinen Spürsinn walten lassen. Aber genau das macht ja wirklich Spass.

Die Geocache-Software

Neben der Technik ist natürlich auch die Geocache-Software ein Thema. Ohne diese würde ich ja nie wissen wo sich ein Cache befindet. Am Anfang habe ich micht mit www.geocaching.com informiert. Dort ist eine kostenlose Anmeldung möglich und diese genügt für das normale Cachen. Auf dieser Plattform hat es mir aber zu viele Cache’s (aktuell 1.5 Millionen), was natürlich sehr schön ist, aber entsprechenend auch viele Cacher mit sich bringt. Es kommt nicht selten vor, dass man einen Cacher am angepeilten Cache begegnet. Was mir als ubuntero auch nicht gefällt, ist die Tatsache, dass die Plattform nicht frei ist. Aus noch anderen Gründen habe ich mich entschieden, eine andere Plattform zu suchen.

opencaching.com als Plattform

Diese Plattform hat mir am besten zugesagt. Opencaching.com ist einfach, frei, schnell und nicht so überlaufen. Das macht diese Plattform für mich sympatisch. Desweiteren ist die Navigation auf das wesentliche gebracht. Da ich aber ein Tablet besitze und damit Cachen will, ist eine Android App eine gute Sache. Diese App gibt es für opencache.com und die nutze ich auch auf meinem Tablet.

Mit der App kann ich alle nötigen Informationen abrufen, darstellen und benutzen. Das ist für mich ein idealer Reisebegleiter für das Caching.

So ist es mir möglich mit dem Tablet und opencaching.com mich von unterwegs immer zu informieren. Man muss für unterwegs auch immer die Gebühren für die Kommunikation beachten. Mit einem Flate-Rate Abo dürfte dies für einen richtigen Cacher aber kein Problem sein. Hat man dann den Cache gefunden, kann man diesen auch gleich über das Tablet loggen. Und schon ist man bereit für das nächste Abenteuer.

Bemerkungen

Ich will in diesem Beitrag nicht weiter in das Thema Geocaching gehen, das würde den Beitrag sprengen. Wer aber einmal anfängt zu cachen, der sollte die Natur und die ganze geocaching Idee mit bedacht berücksichtigen. Einige gute Informatioen wie man sich verhält, bekommt man bei opencaching.com. Neben dem Leitfaden ist auch noch zu bemerken, dass sich beim Cachen unwissende befinden. Diese werden “Muggle” genannt. Ich nenne sie “Muggler” und diese sind wenn möglich von unserem Vorhaben fern zu halten.

Fazit

Geocaching selber macht schon Spass. Verbunden mit einigen technischen Geräten und der richtigen Software, macht das Cachen noch mehr Spass. Geocaching mit einem Android Tablet gibt mir ein Gefühl der Freiheit und Unabhängigkeit.

Ähnliche Artikel

Dropbox: neue Stable-Build 1.1.40 ¶

Die Entwickler des Onlinespeichers Dropbox konzentrieren sich in ihren derzeitigen Entwicklungsversionen auf OS X Lion, um den Client dort vernünftig zum laufen zu bekommen. Nun wurde allerdings mal wieder eine neue Stable Build veröffentlicht, die auch einen Bugfix für Linux enthält. Wer bereits eine 1.2.x Forum-Build nutzt hat diese Fehlerbereinigung schon bekommen:

Backport a fix from 1.2.x that caused the tray menu to become unresponsive on certain Linux machines.

Die Version 1.1.40 steht für Linux, Mac und Windows zum Download bereit:

Linux x86: http://dl-web.dropbox.com/u/17/dropbox-lnx.x86-1.1.40.tar.gz

Linux x86_64: http://dl-web.dropbox.com/u/17/dropbox-lnx.x86_64-1.1.40.tar.gz

Mac OS X: http://dl-web.dropbox.com/u/17/Dropbox%201.1.40.dmg

Windows: http://dl-web.dropbox.com/u/17/Dropbox%201.1.40.exe

Nutzt man die experimentelle Forum-Build sollte man lieber bei dieser bleiben, denn die Version 1.1.40 enthält nicht die verschlüsselte Datenbank, die in der 1.2.x-Reihe enthalten ist.

Um die neue Dropbox-Version unter Linux zu installieren sollte man die gewünschte Version herunterladen (am besten direkt ins Home-Verzeichnis des Nutzers). Anschließend muss Dropbox gestoppt und der Ordner .dropbox-dist im Home umbenannt oder gelöscht werden. Nach dem Entpacken des huntergeladenen Archives kann die Dropbox wieder gestartet werden.

Nach und nach wird Dropbox diese stabile Version sicherlich auch wieder per Autoupdate verteilen.

Xfce + AWN: Ein Traumpaar ¶

Der Avant-Window-Navigator lässt sich unter Xfce ohne installiertes Compiz nutzen.

Dazu muss man nur den in Xfce eingebauten Compositor aktivieren:

Anwendungsmenü -> Settings (Einstellungen)-> Feineinstellung des Fensterverhaltens -> Reiter Compositor

Anschließend kann man AWN über Anwendungsmenü -> Zubehör-> Avant-Window-Navigator starten. Nun erscheint er schon am unteren Bildschirmrand, man kann sich das Dock so konfigurieren, wie man es möchte.

Damit AWN beim einloggen automatisch startet, wird es unter:

Anwendungsmenü -> Settings (Einstellungen) -> Sitzung und Startverhalten -> Reiter Automatisch gestartete Anwendungen

eingetragen.

Schlussendlich kann man sich jetzt nach jedem Einloggen an seinem Dock erfreuen, denn unter Xfce ist nicht mal Compiz o. ä. notwendig. ![]()

Ubuntu 10.04 und die “Sandy Bridge”-Grafik ¶

Vor ein paar Tagen hat mich Hannes angeschrieben und mich gefragt ob ich wüsste, woran es liegt, dass auf seinem “Sandy Bridge”-basierten Rechner unter Ubuntu 10.04 Compiz nicht funktioniert. Die Lösung des Problems ist relativ einfach:

Ubuntu 10.04 ist zu alt um die integrierte Grafik der neuen Intel-Core-CPUs (Codename “Sandy Bridge”) benutzen zu können. Es geht zwar schon, nur wird dann der Framebuffer-Treiber anstatt des beschleunigten Intel-Grafiktreibers benutzt. Dadurch fällt dann die Hardware-beschleunigtes OpenGL komplett flach.

Eine aktualisierte Fassung des Grafiktreibers biete ich ja schon eine ganze Weile an und die Version 2.15 ist auch “Sandy Bridge”-tauglich. Aber das reicht leider nicht um Compiz zum Laufen zu bekommen. Für dieses (und auch alle anderen OpenGL-basierten Programme) wird Mesa in der Version 7.10 benötigt. Ubuntu 10.04 liefert aber nur die Version 7.7 aus. Auch die Kernelversion 2.6.32 reicht nicht aus. Hier kann man zum Glück den offiziellen Backport der Kernelversion 2.6.38 installieren, welche seit ein ca. vier Wochen in Ubuntu 10.04 vorhanden ist (Paketname “linux-image-generic-lts-backport-natty” in den “lucid-updates“-Quellen).

Alles was zum vollkommenen Glück jetzt noch fehlt, ist eine aktualisierte Fassung der Mesa-Bibliotheken. Leider hat uns Canonical uns diese bisher vorenthalten. Peinlicherweise bietet Debian diese per Backport für die Version 6.0 über die Backport-Quellen an (Zusammen mit dem Intel-Grafiktreiber 2.15 und den Kernelversionen 2.6.35, .38 und .39). RedHat Enterprise hat sich in der Version 6.1 ebenfalls diesem Problem angenommen und hat den Intel-Grafiktreiber und die Mesa-Bibliotheken aktualisiert. Nur eben Ubuntu 10.04 bietet keine offizielle Unterstützung für diese Onchip-Grafik an.

Um das Problem zu beseitigen, habe ich die Debian-Version von Mesa 7.10.3 aus deren Backport-Quellen genommen und an Ubuntu 10.04 angepasst. Zusammen mit dem aktualisierten Grafiktreiber und der zurückportierten Kernelversion 2.6.38 funktioniert die “Sandy Bridge”-Grafik dann völlig problemlos unter Ubuntu 10.04.

Alles was man machen muss, ist folgende Befehle auszuführen:

sudo add-apt-repository ppa:glasen/intel-driver (Falls noch nicht geschehen)

sudo apt-get update

sudo apt-get upgrade

sudo apt-get install linux-image-generic-lts-backport-natty linux-headers-generic-lts-backport-natty (Installiert Kernelversion 2.6.38)

Danach muss man nur einen Neustart durchführen.

Wer mein PPA schon benutzt, wird beim nächsten Update die aktualisierten Mesa-Bibliotheken automatisch eingespielt bekommen.

18. August 2011

Auf dem Desktop zieht “Revolution statt Evolution” nicht – auch nicht bei Apple ¶

Ich habe gelacht über Alex und seine Hasstirade auf Lion. Ich habe Tränen gelacht. Oder habe ich geweint vor Glück, dass Apple es sich mit seinen Fans verscherzt? Oder einfach nur so?

Fakt ist: Worüber sich die Mac-Jünger aufregen ist nichts anderes, vielleicht sogar weniger dramatisch als das, was gerade mit Gnome und Ubuntu passiert. Scrolling umgedreht, Lustige Maximize-Minimize-Geschichten (das ist aber auch verdammt beschissen gelöst da, sowas sollte das Window Management regeln, nicht das Programm selbst), aber nix dramatisches wie ein komplett anderes Verhalten und Bedienkonzept, wie bei Gnome 3 und Unity.

Somit sehe ich das ganze mit einem lachenden und einem weinenden Auge.

Thunderbird hat das meiner Meinung nach extrem gut gelöst, nach dem Update auf Version 3 (oder war’s 5) gab es eine hübsche Übersicht über die Änderungen und einen Hinweis, wie man die meisten Major-Changes relativieren oder rückgangig machen kann.

Gnome 3 zum Beispiel, bietet sowas nicht an. Ebensowenig wie Erklärungen (Manuals sind eh überbewertet). Und ich kann den Bürgermeister und Linus Torvalds nur bestätigen: Gnome 3 saugt. Mindestens in der Grundeinstellung. Hier wurde (viel zu) viel “Usability” von Apple integriert (exzessive Alt-Taste).

Womit wir bei Unity wären. Unity wird aufgrund genau dieser Thematik bei mir eher nicht Einzug finden. Und Gnome 3… Naja, mal schauen. Vielleicht schaffen die es ja schneller als KDE, zurück zu einem System zu finden, das man problemlos nutzen kann. Ansonsten bleibt mein Netbook erstmal bei Crunchbang Openbox und mein Rechner auf ner alten LTS mit per Hand/PPA aktualisierten Internet-Tools.

Es gibt übrigens einen zweiten Part zu dem Video. Weniger aggressiv, aber genauso verbittert.

Kurz verlinkt: Infografik zu 20 Jahren Linux ¶

Überall im Netz gibt es zu allem möglichen Infografiken. Auch zum 20. Geburtstag des Linux-Kernels gibt es eine solche Infografik von der Linux Foundation, die hier in voller Größe zu finden ist.

Bildupload zu Flickr mit Linux ¶

Wenn man halbwegs ernsthaft fotografiert und sich mit anderen Fotografen austauschen will, kommt man um Onlinecommunitys nicht herum. Bei Fotografen sehr beliebt ist die Seite Flickr.

Mittlerweile gibt es auf der Upload-Seite von Flickr im Brower ein ganz leistungsstarkes Tool, welches den Upload von Bildern stark vereinfacht. Leider basiert dieses Tool auf Flash und läuft darum nicht besonders stabil.

Das haben sich wohl auch ein paar Entwickler gedacht und darum gibt es einige mehr oder weniger gute Pakete für Linux, die einen Bildupload ermöglichen. Eines davon nennt sich Frogr.

Frogr ist zwar minimalistisch aufgebaut, die Bedienung dadurch aber sehr einfach und wirkungsvoll. Die Bilder kann man vor dem Hochladen ins das Interface laden, Titel und Tags („Markierungen“) vergeben, Privatsphäre und Sicherheitsstufe einstellen. Das einspielen in das Programm erfolgt dabei entweder über den +Button oder via Drag&Drop aus dem Dateimanager.

Seit der letzten Samstag erschienenen Version 0.6 ist eine kleine Anleitung in das Programm integriert, das einen Kurzüberblick über die Funktionen bietet.

Die Legitimation der Flickr-Konten (multiaccount-fähig!) erfolgt ganz modern mit einer Weiterleitung auf die Webseite, wo man sich die Legitimation von der Internetseite holt. Die lästige Passworteingabe entfällt also.

Was das Programm kann:

- Bilder bei Flickr hochladen

- Lizenzen, Tags, Beschreibungen, Sicherheitsstufen, Bildtypen der neuen Bilder bestimmen

- Remote Unterstützung (SSH/ FTP…)

- UI oder Terminal

- Mehrere Flickr Accounts verwalten

- und vieles mehr

- Videos hochladen

- bereits hochgeladene Bilder verwalten

- Bilder bearbeiten (Schnitt, Drehen…)

- zaubern

Was allerdings fehlt und mich tierisch nervt ist die fehlende Warnung, wenn ein Foto die maximale Dateigröße (von Flickr vorgegeben) überschreitet. Bei Version 0.5 war es dann so, dass der Upload scheiterte und alle folgenden Uploads abgebrochen wurden (bei 0.6 ist das ebenfalls so). Den Bug habe ich bereits gemeldet, laut Entwickler wird er in der nächsten Version behoben.

Installation

Für Benutzer von Ubuntu Oneiric ist Frogr schon in den Paketquellen vorhanden, hier reicht ein

sudo apt-get install frogr

aus. Gleiches gilt für Debian unstable und -testing, auch dort sind die Pakete schon enthalten.

Für Ubuntu Benutzer mit bereits stabilen Versionen gibt es eine zusätzliche Paketquelle.

sudo add-apt-repository ppa:mariospr/frogr sudo apt-get update sudo apt-get install frogr

Der Sourcecode und weitere komplierte Pakete (z.B. für Fedora) liegen ebenfalls vor.

Wie Firefox seine Reputation gefährdet ¶

Firefox entwickelt sich langsam aber sicher zum Google-Chrome-Kopierverein. Diesen Eindruck erhält man, wenn man die derzeitige Entwicklung und die künftigen Pläne verfolgt. Schnellere, feste Release-Zyklen, Abschaffung der sichtbaren Versionsnummern, ähnliches Design. Der interessante Unterschied ist: bei Googles Browser scheint es „cool“ zu sein, bei Firefox zu nerven.

Über den Verdacht, gegen seine eigenen Anwender zu entwickeln, war Firefox bislang erhaben, selbst wenn in der Vergangenheit und auch aktuell fragwürdige Dinge passierten und passieren. Doch so groß wie in diesen Tagen war der Aufschrei noch nie. „Unseriös“ oder „idiotisch“ sind noch die harmloseren Bezeichnungen, die hierbei fallen.

Worum geht es? Hauptkritikpunkt ist der neue Veröffentlichungsrythmus und die damit verbundene Abschaffung von Unterversionen. Jeder Firefox eine neue Hauptversion, so ist die aktuelle Situation. Obwohl seit Firefox 4 nun derart verfahren wird, sind die Medien bei der Veröffentlichung von Firefox 6 erneut regelrecht auf diesen „Trick“ hereingefallen. Die Mehrheit der Meldungen wunderte sich, dass es praktisch gar nichts Neues im neuen Firefox gebe. Kein Wunder, handelt es sich bei Firefox 6 nach traditioneller Zählweise doch eher um eine Art Firefox 4.0.3.

Exemplarisch sei hier „Bild Online“ genannt, die Mozilla mit gewohnt exzessiver Verwendung von Ausrufezeichen vorwirft, dass aufregende Neuerungen ausgeblieben wären, und sogar in die Irre führt, indem behauptet wird, Add-ons blieben bei einem Update erhalten. Das stimmt zwar – nur funktionieren sie nach einem Update eben meist nicht mehr. Genau hier liegt das Problem. Durch die neue rasante Versionierung und die damit einhergehende Abschaffung von „Service-Updates“, hat man jedes Mal nach nur 45 Tagen eine völlig neue Firefox-Version – mit jedes Mal wieder inkompatiblen Erweiterungen oder gar entfallenen Funktionen.

Die nunmehr aufgekommene Idee, künftig die Versionsnummern vor dem Nutzer zu verstecken, wird dabei als Versuch wahrgenommen, dieses Problem der Inkompatibilitäten durch zu häufige Major-Release-Veröffentlichungen zu kaschieren – und letztlich den Erstellern der Add-ons den Schwarzen Peter zuzuschieben. Doch vermeintlich unwichtige Informationen vor dem Benutzer zu verstecken, das kommt gar nicht gut an.

Vorbild Google-Browser: die Versionsnummer spielt hier keine Rolle, weder Downloadseite noch Installationsdatei verraten das Release

Bislang noch nicht versteckt: Versionsnummern bei Firefox sind erkennbar

Nun werden die Rufe insbesondere im Linuxlager nach einem Fork, nach Unabhängigkeit von Mozilla, nach einem „eigenen Linuxbrowser“ laut. Sicherlich wird Firefox als der Linuxbrowser wahrgenommen, doch „den“ Linuxbrowser kann es institutionell gesehen natürlich nicht geben, da es „das“ Linux nicht gibt. „Die“ Linuxbrowser hingegen existieren längst: Konqueror (KDE), Epiphany (Gnome) und Midori (XFCE). Die Situation ist damit lustigerweise fast dieselbe wie unter Windows: das System bringt einen Standardbrowser mit, aber niemand benutzt diesen freiwillig. Flugs werden entweder Firefox, Chrome/Chromium oder Opera nachinstalliert.

Und mit „Iceweasel“ gibt es zumindest bei Debian auch bereits einen Fork von Firefox, einen reinen „Linux-Firefox“, wenn man so will. Inzwischen muss man sagen, dass Debian damals in weiser Voraussicht gehandelt hat, denn nun ist man hier unabhängig von den Eskapaden Mozillas und kann für seine Anwender auch längere Supportzeiträume garantieren als lediglich lächerliche anderthalb Monate.

Ob sich Mozilla mit dem neuen Versionsschema viele neue Freunde macht, bleibt abzuwarten, derzeit sieht es eher so aus, als würde man die bereits gewonnene Anwenderschaft vergraulen.

PS. Auf Knetfeder.de verzichten wir auf eine spezifische Firefox-6-Rezension, da die Veränderungen tatsächlich nur minimal ausfallen; der bisherige Artikel zu Firefox 4 ist weiterhin aktuell. Stattdessen ist ein ausführlicher Bericht zu den Problemen mit der neuen Mozilla-Releasepolitik erschienen.

Disclosure: Der Autor ist Initiator des alternativen deutschen Sprachpakets für Firefox.

17. August 2011

FrOSCon: FrogLabs auch für Erwachsene offen ¶

Scheinbar ist die Mehrheit der Kinder aus der Gegend rund um Sankt Augustin in Italien oder liegt an einem Strand in Spanien oder befindet sich irgendwo anders in der Welt um Urlaub zu machen. Jedenfalls gab es Schwierigkeiten, die Workshops innerhalb des KidsTrack “FrogLabs” mit Teilnehmern zu füllen. Die Veranstalter der FrOSCon haben deshalb mit den Speakern für diese Workshops gesprochen und verschiedene Lösungen vorgeschlagen. Eine davon war, die Workshops auch für Erwachsene zu öffnen, für diese Lösung habe ich mich entschieden. Aber ich hatte ja bereits in der Ankündigung der Workshops geschrieben, dass ich nichts dagegen haben, wenn da der ein oder Erwachsene auftaucht. Das ist nun für die Masse der Workshops der FrogLabs der Fall. Da trotzdem nicht davon auszugehen ist, dass nun die Teilnehmerzahl ins unermessliche steigt, ist einfach mehr Zeit innerhalb der Workshops und ich werde wohl 2 weitere Themen mitnehmen. Also falls jemand Lust hat auf ein wenig Inkscape, einfach mal anmelden oder am Sonntag vorbeischauen.

Unbekannte Systeme in Nagios ¶

Die Nagios Status Map ist ja eine ganz feine Sache, um sich problemlos einen Überblick über das Netzwerk zu verschaffen. Ich sehe auf einen Blick wie welche Maschinen zusammenhängen, und welche Betriebssysteme darauf jeweils betrieben werden. Doch, irgendwie sagt mir das folgende Symbol nicht viel:

![]()

Leider ist jeder Server standardmässig mit diesem Symbol ausgerüstet, was alles andere als sauber aussieht.

Um das zu ändern, muss man sich die passenden Symbole nachladen. Eine passende Auswahl dafür findet man bei Nagios Exchange.

Die Symbole werden heruntergeladen und nach /usr/local/nagios/share/images/logos (unter Ubuntu) entpackt. Nun wird eine weitere Datei mit dem Namen “hostextinfo.cfg” unter /usr/local/nagios/etc/objects zugefügt und mit folgendem Inhalt gefüllt:

define hostextinfo{

hostgroup_name windows-servers

icon_image win40.png

icon_image_alt Windows

vrml_image win40.png

statusmap_image win40.gd2

}

define hostextinfo{

hostgroup_name linux-servers

icon_image linux40.png

icon_image_alt Linux

vrml_image linux40.png

statusmap_image linux40.gd2

}

define hostextinfo{

hostgroup_name esxi-servers

icon_image esxi.png

icon_image_alt ESXi

vrml_image esxi.png

statusmap_image esxi.gd2

}

Die Datei wird nun noch in Nagios verlinkt.

Dazu ergänzen wir die Datei /usr/local/nagios/etc/nagios.cfg mit folgender Zeile:

cfg_file=/usr/local/nagios/etc/objects/hostextinfo.cfg

Nun aber haben wir ein Problem! Es gibt kein Symbol für ESX(i), weshalb wir da noch etwas Handarbeit tätigen müssen. Zuerst suchen wir uns ein passendes Icon. Ich habe mich für das vSphere-Symbol entschieden.

Dieses kann nun mit einem beliebigen Tool auf die passende Grösse gebraucht werden. Zum Beispiel mit Imagemagick:

convert -geometry 40x40 vsphere_logo.png esxi.png

Nun müssen wir noch eine Version im Format gd2 erstellen. Dazu habe ich das Paket “libgd-tools” installiert, womit ich nun konvertieren kann:

pngtogd2 esxi.png esxi.gd2 0 1

Ist auch das geschehen, so kann Nagios neugestartet werden und das Ergebnis bewundert werden:

Das könnte dich auch interessieren:

- Notification von Nagios ans iPhone Auf der Suche nach einer Lösung, wie ich die Notifications...

XBMC - Audio auf Klinke-Anschluss (Audio Jack) und HDMI gleichzeitig ¶

Nun ist es also vollbracht. Nachdem etlichen Tassen Kaffee in meinen Magen gewandert sind und ich Google mit diversen Suchbegriffen gequält habe, ist einer meiner nächster Meilenstein in Sachen XBMC / HTPC geschafft: die gleichzeitige / parallele / simultane (für die Suchbegriffe ![]() ) Ton bzw. Audio Ausgabe über den HDMI- und Klinke-Anschluss (bei zwei Soundkarten...)

) Ton bzw. Audio Ausgabe über den HDMI- und Klinke-Anschluss (bei zwei Soundkarten...)

Bitte beachtet, dass ich zuvor die Alsa Version wie hier beschrieben auf die neueste Version gebracht habe.

Dank des Users "the_isz", welcher sich im ArchLinux Forum mit dem gleichen Problem auseinander gesetzt hat (Beitrag hier) und seiner ausgezeichneten Analyse und Kommentierung im Script bzw. der ".asoundrc" (im home Verzeichnis), konnte ich dieses große Problem lösen.

So sieht meine .asoundrc nun aus: .asoundrc

Die Karten-Namen und Device IDs habe ich dabei mittels

aplay -lausgelesen. Die ausgabe sieht folgendermaßen aus:

**** List of PLAYBACK Hardware Devices ****

card 0: Generic [HD-Audio Generic], device 3: HDMI 0 [HDMI 0]

Subdevices: 1/1

Subdevice #0: subdevice #0

card 1: SB [HDA ATI SB], device 0: ALC892 Analog [ALC892 Analog]

Subdevices: 1/1

Subdevice #0: subdevice #0

card 1: SB [HDA ATI SB], device 1: ALC892 Digital [ALC892 Digital]

Subdevices: 1/1

Subdevice #0: subdevice #0

Karte 0/3 = HDMI

Karte 1/0 = Klinke

Karte 1/1 = optisch

XBMC:

In den Audio-Einstellungen (Einstellungen - System - Audio Hardware) müssen noch folgende Optionen gesetzt werden (siehe Bild):

Audio Ausgabegerät: Benutzerdefiniert

Benutzerdefiniertes Audiogerät: both (klein geschrieben!)

Digitales Ausgabegerät für Passthrough: Benutzerdefiniert

Benutzerdefiniertes Audiogerät für Passthrough: both (auch klein geschrieben!)

Für alle Fälle habe ich die Arch-Linux Seite mit der Anleitung gespiegelt, da der Beitrag doch schon etwas älter ist: sicherung_1_alsa_files.tar.gz

Weitere Seiten zu diesem Thema:

https://bbs.archlinux.org/viewtopic.php?id=109370

http://www.alsa-project.org/alsa-doc/alsa-lib/pcm_plugins.html

http://wiki.ubuntuusers.de/.asoundrc

http://forum.xbmc.org/showpost.php?p=396178&postcount=141

Und hier bin ich w.g. letztendlich fündig geworden:

https://bbs.archlinux.org/viewtopic.php?id=109370

XBMC – Audio auf Klinke-Anschluss (Audio Jack) und HDMI gleichzeitig ¶

Nun ist es also vollbracht. Nachdem etlichen Tassen Kaffee in meinen Magen gewandert sind und ich Google mit diversen Suchbegriffen gequält habe, ist einer meiner nächster Meilenstein in Sachen XBMC / HTPC geschafft: die gleichzeitige / parallele / simultane (für die Suchbegriffe ![]() ) Ton bzw. Audio Ausgabe über den HDMI- und Klinke-Anschluss (bei zwei Soundkarten…)

) Ton bzw. Audio Ausgabe über den HDMI- und Klinke-Anschluss (bei zwei Soundkarten…)

Bitte beachtet, dass ich zuvor die Alsa Version wie hier beschrieben auf die neueste Version gebracht habe.

Dank des Users “the_isz”, welcher sich im ArchLinux Forum mit dem gleichen Problem auseinander gesetzt hat (Beitrag hier) und seiner ausgezeichneten Analyse und Kommentierung im Script bzw. der “.asoundrc” (im home Verzeichnis), konnte ich dieses große Problem lösen.

So sieht meine .asoundrc nun aus: .asoundrc

Die Karten-Namen und Device IDs habe ich dabei mittels

aplay -l

ausgelesen. Die ausgabe sieht folgendermaßen aus:

**** List of PLAYBACK Hardware Devices ****

card 0: Generic [HD-Audio Generic], device 3: HDMI 0 [HDMI 0]

Subdevices: 1/1

Subdevice #0: subdevice #0

card 1: SB [HDA ATI SB], device 0: ALC892 Analog [ALC892 Analog]

Subdevices: 1/1

Subdevice #0: subdevice #0

card 1: SB [HDA ATI SB], device 1: ALC892 Digital [ALC892 Digital]

Subdevices: 1/1

Subdevice #0: subdevice #0

Karte 0/3 = HDMI

Karte 1/0 = Klinke

Karte 1/1 = optisch

XBMC:

In den Audio-Einstellungen (Einstellungen – System – Audio Hardware) müssen noch folgende Optionen gesetzt werden (siehe Bild):

Audio Ausgabegerät: Benutzerdefiniert

Benutzerdefiniertes Audiogerät: both (klein geschrieben!)

Digitales Ausgabegerät für Passthrough: Benutzerdefiniert

Benutzerdefiniertes Audiogerät für Passthrough: both (auch klein geschrieben!)

Für alle Fälle habe ich die Arch-Linux Seite mit der Anleitung gespiegelt, da der Beitrag doch schon etwas älter ist: sicherung_1_alsa_files.tar.gz

Weitere Seiten zu diesem Thema:

https://bbs.archlinux.org/viewtopic.php?id=109370

http://www.alsa-project.org/alsa-doc/alsa-lib/pcm_plugins.html

http://wiki.ubuntuusers.de/.asoundrc

http://forum.xbmc.org/showpost.php?p=396178&postcount=141

Und hier bin ich w.g. letztendlich fündig geworden:

https://bbs.archlinux.org/viewtopic.php?id=109370

NAT konfigurieren unter ESX(i) ¶

NAT ist so eine Sache. Unter Vmware Workstation sehr einfach und sauber gelöst, unter ESX(i) leider gänzlich unbekannt. Eigentlich ist es auf einem Server ja auch gar nicht erwünscht, da jeder Server sowieso seine eigene, fixe IP bekommt, jedoch aber ist bei mir nur der undenkbare Fall eingetreten, dass ich zu Testzwecken eben doch NAT gebrauchen könnte.

Also gilt es, das manuell einzurichten, was Vmware Workstation mir sonst abnimmt: Mit einem weiteren virtuellen Switch und einer Installation von pfSense.

Rein logisch sollte das so funktionieren: Der Client bezieht von pfSense eine interne IP, da er am selben Switch hängt, wie der DHCP. Ein Paket geht nun vom Client über den Switch zum LAN-Interface von pfSense und dann über das WAN-Interface auf den öffentlichen Switch ins Internet. Ganz einfach oder?

Als erstes wird der virtuelle Switch zugefügt. Jedoch wird dieser nicht an ein virtuelles Interface gebunden, schliesslich soll da ja nichts nach draussen gehen.

Nun wir eine VM erstellt mit zwei Netzwerkkarten, eine ans “VM Network”, welches über das Netzwerk erreichbar ist, und eine an das eben erstellte Netzwerk, nennen wir es “NAT Network”. Darauf wird nun pfSense installiert. Die Konfiguration ist gänzlich normal, es muss nur darauf geachtet werden, dass das WAN Interface der Karte mit Anbindung an das “VM Network” und das LAN Interface der Karte mit Anbindung an das “NAT Network” entspricht.

In ESX(i) würde das nun etwa so aussehen:

Nun kann eine neue Maschine einfach dem “NAT Network” zugefügt werden, und bezieht via DHCP eine IP Adresse! So schwer ist das ja gar nicht ![]()

Das könnte dich auch interessieren:

- Installation von Moodle unter Debian Moodle ist eine Lernplattform auf Basis von Opensource, welche bereits...

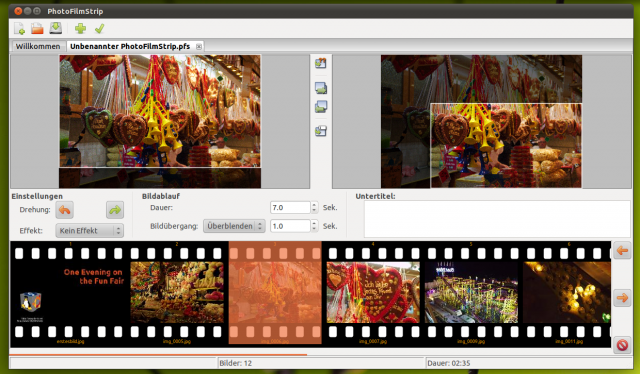

PhotoFilmStrip: Diashows mit Linux erstellen ¶

Kostenlos und einfach eine wirkungsvolle Slideshow von Bildern erstellen und anschließend auf CD oder DVD brennen oder ins Internet stellen? Das geht unter Linux sehr einfach, und zwar mit dem Programm Photofilmstrip.

Das Programm ist sehr einfach strukturiert, was die Bedienung wirklich sehr vereinfacht. Gleich der Programmstart erleichtert einem den Einstieg: Seitenverhältnis einstellen, Bilder importieren. Die importierten Fotos und Grafiken werden unten als Filmstreifen dargestellt. Hier kann die Reihenfolge beliebig per drag& drop oder die dafür vorgesehenen Button geändert werden.

Klickt man ein Bild an, kann man den Zoombereich für den Ken-Burns-Effekt einstellen. Auch die Bildübergänge kann man für jedes Bild festlegen. Auch Untertitel kann man für jedes Bild separat einfügen.

Über die Eigenschaften des Projektes kann man ein Audiostück für den Hintergrund wählen, welches während der Wiedergabe abgespielt wird.

Wenn man mit seinem Ergebnis zufrieden ist, kann man es in zahlreiche Videoformate umwandeln lassen, selbst Full-HD Videos kann man damit erstellen. Die Umwandlung in das Video erfolgt schließlich mit Mencoder. Dies kann je nach Leistung des PCs einige Minuten dauern. Leider kann Photofilmstrip bisher nur einen Kern verwenden, es nutzt also bei modernen Computern nicht die vollständige Leistung aus.

Das Programm liegt auf der Homepage des Projekts bzw. auf Sourceforge für Linux und Windows bereit.

Eine fertige Slideshow in Full-HD sieht dann etwa so aus:

One Evening on the Fun Fair from Benni Julia on Vimeo.

Mozilla veröffentlicht Thunderbird 6.0 ¶

Fast zeitgleich mit dem Browser Firefox hat Mozilla dessen Schwesterapplikation – den freien und plattformunabhängigen E-Mail-Client Thunderbird – in der Version 6.0 veröffentlicht.

Thunderbird 6.0 enthält zahlreiche Stabilitäts- und Geschwindigkeitsverbesserungen sowie Sicherheitskorrekturen.

Die Überprüfung, ob Thunderbird als standardmässiger Mail-Client eingerichtet ist, funktioniert nun auch mit neueren Linux-Distributionen.

Gemäss mozillaZine wurde ausserdem das Erscheinungsbild (“Theme”) des E-Mail-Programmes der Aero-Oberfläche unter Windows Vista/7 überarbeitet und der Client unterstützt nun sogenannte “Jump lists”. Desweiteren wurde die Outlook-to-Thunderbird Importfunktion verbessert.

Wie man den Release Notes ausserdem entnehmen kann, setzt Thunderbird nun – genauso wie die aktuelle Firefox-Version – auf die neueste Gecko-Rendering-Engine 6.0.

Thunderbird kann unter anderem für die Betriebssysteme GNU/Linux, Mac OS X sowie Windows von der Mozilla-Seite heruntergeladen werden.

Benutzer von Ubuntu 10.04 und 10.10 können sich Thunderbird 6.0 über das offizielle Mozilla PPA-Repository installieren:

sudo add-apt-repository ppa:mozillateam/thunderbird-stable

sudo apt-get update && sudo apt-get upgrade

sudo apt-get install thunderbird-locale-de

Alternativ dazu kann man sich anhand der Anleitung von UbuntuFlo eine portable Version des E-Mail- Programmes basteln. Der Vorteil der portablen Variante ist, dass man beim Testen die bereits bestehende Thunderbird-Version und deren Daten nicht gefährdet. Ein weiterer Vorteil ist, dass man Thunderbird portable – wie der Name bereits vermuten lässt – z.B. auf einem USB-Stick oder einer externen Festplatte mit sich tragen kann.

Es ist davon auszugehen, dass die meisten Linux-Distributoren die neue Thunderbird-Version in den nächsten Tagen in die Paketquellen laden werden. Zumindest Ubuntu 11.04-User sollten das Update schon bald automatisch über die Systemaktualisierung eingespielt bekommen.

Fazit: Optisch hat sich an Thunderbird unter Linux zwar nichts geändert, doch die Aktualisierung hat sich zumindest sicherheitstechnisch gelohnt. Die meisten meiner Erweiterungen (Lightning, Provider für Google Kalender, Google Contacts, Enigmail) funktionieren auch nach dem Update reibungslos.