News gibts ja genug rund um den neuen nativen Steam-Client für Linux und auch um die Pläne eine Steam-Spielekonsole basierend auf Linux herauszubringen. Persönlich finde ich diese Idee ungeheuer spannend, zumal mit Valve im Hintergrund tatsächlich eine reale Chance besteht, dass einige Games auf Linux portiert werden. Gerade vor kurzem “belauschte” ich das Gespräch einiger 14-jähriger Schüler auf ihrem Heimweg die sich ausführlich über Ubuntu unterhielten (!!!) und als einen der großen Nachteile die fehlenden coolen Spiele angaben. Zwar meinte einer von ihnen, “zocken tut man ja sowieso auf einer Konsole”, dennoch glaube ich, dass wenn es das Lieblingsspiel auch unter Linux gibt, der Umstieg für viele noch einfacher werden dürfte.

Bei so vielen tollen News gibt es natürlich auch den einen oder anderen Wehrmutstropfen. Dass durch das Portieren des Steam-Clients natürlich nicht gleich hunderte Spiele bereit stehen, sollte den meisten klar sein, doch die Anzahl wächst und falls Valve eine Chance auf dem hart umkämpften Konsolen-Markt haben möchte, sollten sie sich auch dringen darum bemühen diesen Trend zu fördern. Mit Klassikern wie Half-Life 1 und das originale Counter-Strike kann man vielleicht ein paar Veteranen glücklich machen, aber der große Wuuumbs ist dadurch natürlich nicht zu erwarten.

Das zweite Problem ist, dass die Verteilung von Software unter Linux gänzlich anders funktioniert wie im Windows und Mac-Universum. Anstatt dass Software-Erzeuger selbst Pakete erstellen, ist dies unter Linux die Aufgabe der Distributoren, die dazu allerdings am besten den Quelltext der Software zur Verfügung haben. Das ist aber weder beim Client selbst noch bei den Spielen der Fall und so ist der Support auf anderen Distributionen, als den vom Hersteller vorgesehenen, nur eingeschränkt möglich. Valve hat für Steam Ubuntu in der 32-bit Variante gewählt, wohl mit dem Hintergedanken, dass dieses (und alle direkten Ableger) den größten Marktanteil unter den Desktop-Linuxen hat. Momentan befindet sich der Client noch in der Beta-Phase insofern ist nicht sicher, ob es bei 32-bit und Ubuntu bleibt, fürs erste ist das aber anzunehmen. Ich verwende selbst aber bereits jahrelang Arch Linux als meine Hauptdistribution und bin damit auch sehr glücklich. In diesem Artikel möchte ich daher einen kurzen Statusbericht liefern, wie gut Steam mit einem 64-bit Arch Linux umzugehen weiß.

Installation

Die Installation an sich geht sehr einfach vonstatten, da sich der Steam Client bereits als Paket im Arch Linux User Repository (AUR) befindet. Wer wie ich (und wahrscheinlich mittlerweile ein Großteil der Arch Linux User) die x86_64-Variante verwendet, muss zusätzlich vorher noch das multilib-Repository in der Datei pacman.conf aktivieren um 32-bit Bibliotheken nachinstallieren zu können. Die Installation an sich geht recht flott von statten, der Steam-Client muss nicht mehr kompiliert werden, sondern wird aus dem Ubuntu-Paket extrahiert und für Arch Linux neu verpackt. Zusätzlich werden gleich einige Abhängigkeiten nachinstalliert. Ebenfalls nur für die 64-bit Version wird der Grafikkartentreiber noch einmal explizit als lib32-Paket benötigt. Unbedingt installieren muss man auch noch die Microsoft Schrift “Arial” (im AUR ttf-microsoft-arial oder gleich das ganze Paket ttf-ms-fonts), ansonsten sehen fast alle Texte schrecklich aus.

Erster Eindruck

Nach der Installation klinkt sich ein Icon in das Desktopmenü der jeweiligen Desktopumgebung (in meinem Fall Cinnamon) und beim ersten Start wird der Client upgedated. Danach wird man vom bekannten Steam Login-Screen begrüßt und fast alles sieht so aus wie im Windows-Pedant. Begrüßt wird man wie auch unter Windows mit Werbung, allerdings nicht angepasst auf Linux. Einen entsprechenden Reiter Linux gibt es aber, in dem sich unter den “Top-Linux-Spielen” allerdings nur eines befand, dass ich kannte (Team Fortress 2). Insgesamt gibt es momentan 63 für Linux tauglich gekennzeichnete Spiele. Zugegebenermaßen eine nicht sehr große Auswahl (Für Mac sind ganze 533 gelistet), aber wie gesagt, man kann hoffen, dass die Auswahl wachsen wird!

Die Sprache wurde bei mir nicht automatisch erkannt, aber gut, dass ist jetzt wirklich eine Kleinigkeit. Der erste Fehler trat beim Umstellen auf Deutsch auf. Steam forderte mich auf, den Client neu zu starten, die Meldung dazu war aber unleserlich (siehe Bildergalerie). Neustarten musste ich dann explizit über das Menü Steam -> Exit, da das “X” oben im Fensterrahmen den Client nur minimiert und nicht ganz beendet (so wie auch unter Windows). Einziger Unterschied (den ich glaub ich dem Cinnamon-Panel zuschieben kann) ist, dass sich das Steam-Programmicon auch nicht aus der Taskleiste wegblendet (und nur noch in der Application-Tray angezeigt wird), sondern auch dort verweilt. Nun gut, auch dass ist verkraftbar.

Als nächstes Verschlug es mich in die Spiele-Bibliothek und tatsächlich, obwohl ich nicht sehr viele Spiele für Steam besitze, fanden sich immerhin sechs Einträge die laut Steam auch unter Linux funktionieren sollten unter anderem X3: Reunion, eines meiner All-Time-Favorites. Interessant ist aber, dass der Vorgänger X2: The Threat, den ich ebenfalls für Steam besitze nicht in der List aufscheint, obwohl es dafür ebenfalls einen Linux-Port gibt. Auch das Addon X3: Terran Conflict scheint nicht für Linux verfügbar zu sein.

Anders als unter Windows lässt sich bei der Installation von Spielen eine Speicherort auswählen. Standardmäßige werden Games im home-Verzeichnis des aktuellen Benutzers installiert, es lässt sich aber auch ein anderer Ort auswählen (für den der Nutzer allerdings Schreibrechte benötigt, da Steam keine Root-Rechte nutzt).

Der neue Big-Picture Mode der wahrscheinlich das Interface für die kommende Steam Box werden wird, funktionierte bei mir ohne Probleme. Die Auflösung musste ich selbst noch Umstellen, und nach dem Beenden von World of Goo hatte sich Steam auch gleich selbst mitbeendet.

Spielen

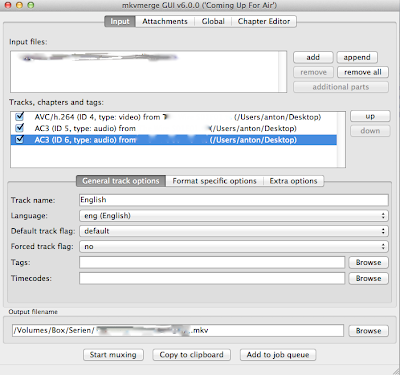

Zugegebenermaßen, mit etwas mehr Anstrengungen hätte ich wahrscheinlich alle Spiele zum Laufen gebracht, aber darum ging es mir auch nicht unbedingt. Der Linux Port von X3: Reunion scheint sich noch in der Beta-Phase zu befinden, eine Meldung beim Starten weißt darauf hin, und in meinem Fall auch darauf, dass meine Grafikkarte nicht geeignet sein würde und es wahrscheinlich zu einem Absturz kommen wird. Vermutlich hätte sich dieses Problem mit dem proprietären Grafikkartentreiber von AMD (fglrx) lösen lassen, eine Installation ist mir aber momentan zu aufwendig. Multiwania ließ sich mit dem Hinweis von fehlenden Programmdateien gar nicht starten und bei Uplink sowie DEFCON funktionierte die niedrige Standard-Auflösung mit meinem Monitor nicht. Einfache Kommandozeilen Switches um etwa den Fenstermodus zu erzwingen funktionierten leider ebenfalls nicht. Einzig Darwinia und World Of Goo funktionerten anstandslos und auch mit entsprechend hoher Performance. Team Fortress 2 wollte ich ebenfalls ausprobieren, dass ließ sich allerdings nur ins Home-Verzeichnis installieren, wo ich nicht genügend Platz zur Verfügung habe. Eine Möglichkeit den Standard-Speicherplatz zu verändern konnte ich nicht finden, der einzige Dialog zu diesem Thema funktionierte nicht richtig, da ich weder die Aufschrift der Buttons, noch den Dialog, der nach dem Klick eines Buttons kam lesen konnte.

Update:

Falls noch jemand Probleme mit X3 und der fehlenden Texture Compression hat, der User jug hat mich auf das Paket libtxc_dxtn bzw lib32-libtxc_dxtn hingewiesen (dass sich in den Arch Repositories findet). Danach startet X3 auch mit den quelloffenen Treibern ohne Probleme. Danke für den Tipp!

Fazit

Nach dem Test ist vor dem Test: Ob Steam unter Linux ein Erfolg wird bin ich mir noch immer nicht sicher. Positiv muss man das Engagement von Valve hervorheben (obwohl dahinter natürlich zum Großteil finanzielle Hintergedanken stecken werden) und den Fakt, dass es sich um Beta-Software handelt und somit zur finalen Version sicher noch ein paar Probleme aus der Welt geschafft werden. Grundsätzlich hinderte mich Arch Linux nicht daran Steam auszuprobieren was gut ist, da es darauf hoffen lässt, dass Steam auch gut mit anderen Distributionen zusammenarbeiten wird. Die meisten Spiele liefern scheinbar alle nötigen Bibliotheken selbst mit, somit sollten auch hier nicht all zu viele Probleme auftreten. Momentan muss man aber eindeutig sagen, bringt Steam auf Linux noch keine nennenswerten Vorteile. Viele der Linux Spiele die momentan verfügbar sind, kann man auch ohne Steam kaufen und spielen, wodurch man kaum nutzen hat. Bleibt zu hoffen, dass die Auswahl stetig steigt und spätestens mit dem Erscheinen der Steam Box genügend Material zum zocken vorhanden sein wird.